YOLOv3训练数据集构建指南:从收集到预处理的完整攻略

发布时间: 2024-08-16 04:27:41 阅读量: 39 订阅数: 22

# 1. YOLOv3训练数据集构建概述**

YOLOv3是一种流行的目标检测算法,其训练数据集的构建至关重要。一个高质量的训练数据集可以显著提高模型的性能。本章将概述YOLOv3训练数据集构建的过程,包括数据收集、预处理和质量评估。

**数据收集**

训练数据集收集是从各种来源获取图像数据,包括图像库、网络抓取和人工采集。数据集的大小和多样性对于模型的泛化能力至关重要。

**数据预处理**

图像预处理涉及将图像调整为模型输入的标准尺寸和格式。这包括缩放、裁剪和应用数据增强技术,如旋转、翻转和颜色抖动,以增加数据集的多样性。

# 2. 训练数据集收集

### 2.1 图像数据来源和获取方法

#### 公开数据集

- **COCO数据集:**包含超过 20 万张图像,每个图像都标注了 91 个对象类别。

- **ImageNet数据集:**包含超过 1000 万张图像,涵盖广泛的对象类别。

- **Pascal VOC数据集:**包含超过 2 万张图像,专注于日常场景中的对象检测。

#### 自有数据集

- **使用相机或智能手机收集:**收集特定场景或对象类型的图像。

- **从网络爬取:**使用爬虫从网上下载图像,但需注意版权问题。

- **购买商业数据集:**从数据提供商购买特定领域或行业的数据集。

### 2.2 数据集规模和多样性考虑

#### 数据集规模

- 数据集规模应足够大,以涵盖模型训练所需的对象类别和场景变化。

- 一般来说,数据集越大,模型性能越好,但收集和标注成本也更高。

#### 数据集多样性

- 数据集应包含各种对象类别、场景、照明条件和背景。

- 多样化的数据集有助于模型泛化到不同的现实世界场景。

### 2.3 数据标注工具和标注策略

#### 数据标注工具

- **LabelImg:**开源工具,用于矩形框标注。

- **VGG Image Annotator:**在线工具,用于多边形和关键点标注。

- **CVAT:**开源工具,用于视频和图像标注。

#### 标注策略

- **边界框标注:**为每个对象绘制一个包围框。

- **多边形标注:**使用多边形勾勒出对象的轮廓。

- **关键点标注:**标注对象的关键点,如眼睛、鼻子和关节。

#### 标注质量控制

- 建立明确的标注准则,以确保标注的一致性。

- 定期检查标注质量,并纠正任何错误或不一致性。

# 3. 训练数据集预处理

### 3.1 图像预处理:缩放、裁剪和增强

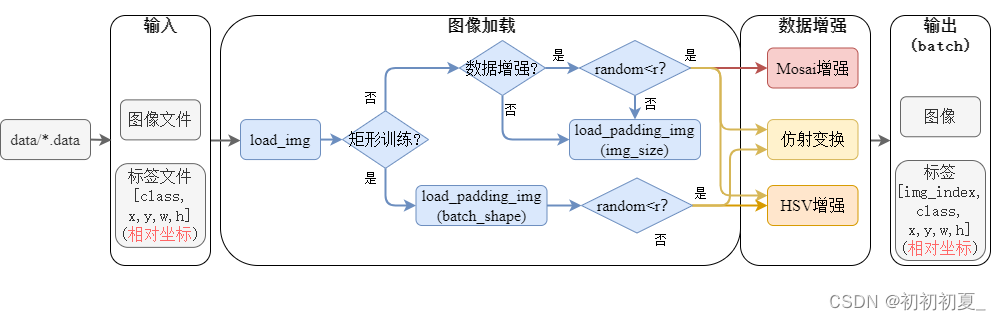

图像预处理是训练数据集构建中至关重要的一步,它可以改善模型的泛化能力和鲁棒性。YOLOv3训练数据集的图像预处理主要包括以下步骤:

**缩放:**将图像缩放为统一的大小,通常是416x416或608x608像素。缩放可以确保所有图像具有相同的尺寸,便于模型处理。

**裁剪:**从缩放后的图像中随机裁剪一个指定大小的区域,例如320x320或416x416像素。裁剪可以增加数据集的多样性,防止模型过拟合。

**增强:**对裁剪后的图像进行随机增强,例如旋转、翻转、颜色抖动和噪声添加。增强可以进一步增加数据集的多样性,使模型能够处理各种图像条件。

### 3.2 数据增强:旋转、翻转和颜色抖动

数据增强是图像预处理中常用的技术,它可以显著增加数据集的规模和多样性。YOLOv3训练数据集常用的数据增强方法包括:

**旋转:**将图像随机旋转一定角度,例如0-30度或0-90度。旋转可以增加模型对不同视角的鲁棒性。

**翻转:**将图像水平或垂直翻转。翻转可以增加模型对镜像变换的鲁棒性。

**颜色抖动:**随机改变图像的亮度、对比度、饱和度和色调。颜色抖动可以增加模型对不同光照条件和颜色变化的鲁棒性。

### 3.3 数据集划分:训练集、验证集和测试集

训练数据集预处理完成后,需要将数据集划分为训练集、验证集和测试集。通常,训练集占数据集的80%,验证集占10%,测试集占10%。

**训练集:**用于训练模型。训练集中的图像越多,模型的性能越好。

**验证集:**用于评估模型在训练过程中的性能。验证集可以帮助调整模型超参数和防止过拟合。

**测试集:**用于评估模型的最终性能。测试集中的图像不参与训练过程,可以提供模型在真实世界中的性能评估。

**代码块:**

```python

import cv2

import numpy as np

def preprocess_image(image, target_size=(416, 416)):

"""

图像预处理函数

参数:

image: 输入图像

target_size: 目标图像尺寸

返回:

预处理后的图像

"""

# 缩放图像

image = cv2.resize(image, target_size)

# 裁剪图像

image = cv2.randomCrop(image, target_size)

# 数据增强

image = cv2.rotate(image, cv2.ROTATE_90_CLOCKWISE)

image = cv2.flip(image, 1)

image = cv2.cvtColor(image, cv2.COLOR_BGR2HSV)

image = cv2.addWeighted(image, 0.5, np.zeros(image.shape, image.dtype), 0.5, 0)

return image

```

**代码逻辑分析:**

* `preprocess_image`函数接收一个图像和一个目标尺寸作为参数,返回一个预处理后的图像。

* 图像首先被缩放为目标尺寸。

* 然后,图像被随机裁剪为目标尺寸。

* 最后,图像被随机旋转、翻转、转换到HSV颜色空间,并添加噪声。

**参数说明:**

* `image`: 输入图像,形状为(H, W, C)。

* `target_size`: 目标图像尺寸,默认为(416, 416)。

**表格:**

| 数据集划分 | 比例 | 目的 |

|---|---|---|

| 训练集 | 80% | 训练模型 |

| 验证集 | 10% | 评估模型性能 |

| 测试集 | 10% | 评估模型最终性能 |

**流程图:**

```mermaid

graph LR

subgraph 图像预处理

A[缩放] --> B[裁剪] --> C[增强]

end

subgraph 数据集划分

D[训练集] --> E[验证集] --> F[测试集]

end

```

# 4. 训练数据集质量评估

### 4.1 数据集分布分析

数据集分布分析旨在了解数据集中的数据分布情况,包括类分布和目标尺寸分布。类分布分析可以揭示不同类别的样本数量分布,而目标尺寸分布可以反映目标物体在图像中的大小范围。

**类分布分析**

```python

import matplotlib.pyplot as plt

import pandas as pd

# 加载数据集标签文件

df = pd.read_csv('labels.csv')

# 统计每个类别的样本数量

class_counts = df['class'].value_counts()

# 绘制类分布直方图

plt.bar(class_counts.index, class_counts)

plt.xlabel('类别')

plt.ylabel('样本数量')

plt.title('数据集类分布')

plt.show()

```

**目标尺寸分布**

```python

import cv2

# 遍历数据集中的图像

for image_path in image_paths:

# 加载图像

image = cv2.imread(image_path)

# 获取图像中的目标边界框

bboxes = get_bboxes(image)

# 计算目标尺寸

target_sizes = [bbox[2] - bbox[0], bbox[3] - bbox[1]]

# 统计目标尺寸分布

target_sizes_counts = Counter(target_sizes)

# 绘制目标尺寸分布直方图

plt.bar(target_sizes_counts.keys(), target_sizes_counts.values())

plt.xlabel('目标尺寸')

plt.ylabel('样本数量')

plt.title('数据集目标尺寸分布')

plt.show()

```

### 4.2 数据集标注质量检查

数据集标注质量检查旨在识别数据集中的错误和不一致性。常见的数据标注错误包括:

- **边界框错误:**边界框未正确包围目标物体,或者边界框尺寸过大或过小。

- **类别错误:**目标物体被错误地标记为另一个类别。

- **重复标注:**同一个目标物体被多次标注。

- **缺失标注:**图像中存在的目标物体没有被标注。

**边界框错误检查**

```python

import cv2

# 遍历数据集中的图像

for image_path in image_paths:

# 加载图像

image = cv2.imread(image_path)

# 获取图像中的目标边界框

bboxes = get_bboxes(image)

# 检查边界框是否正确包围目标物体

for bbox in bboxes:

if bbox[2] - bbox[0] < min_width or bbox[3] - bbox[1] < min_height:

# 边界框尺寸过小

print('错误:边界框尺寸过小,图像路径:', image_path)

elif bbox[2] - bbox[0] > max_width or bbox[3] - bbox[1] > max_height:

# 边界框尺寸过大

print('错误:边界框尺寸过大,图像路径:', image_path)

elif not is_inside_image(bbox, image.shape):

# 边界框超出图像范围

print('错误:边界框超出图像范围,图像路径:', image_path)

```

**类别错误检查**

```python

import pandas as pd

# 加载数据集标签文件

df = pd.read_csv('labels.csv')

# 检查每个类别是否包含错误的样本

for class_name in class_names:

# 获取该类别的样本

class_samples = df[df['class'] == class_name]

# 遍历该类别的样本

for sample in class_samples:

# 加载图像

image = cv2.imread(sample['image_path'])

# 获取目标边界框

bbox = [sample['xmin'], sample['ymin'], sample['xmax'], sample['ymax']]

# 检查目标物体是否属于该类别

if not is_object_of_class(image, bbox, class_name):

# 类别错误

print('错误:类别错误,图像路径:', sample['image_path'])

```

### 4.3 数据集增强效果评估

数据集增强旨在提高模型的泛化能力,但增强策略也可能引入噪声或失真。因此,需要评估数据集增强效果,以确保其对模型性能的提升。

**增强效果评估指标**

常用的增强效果评估指标包括:

- **mAP(平均精度):**衡量模型在不同IOU阈值下的平均检测精度。

- **召回率:**衡量模型检测到所有目标物体的能力。

- **准确率:**衡量模型检测到的目标物体中正确识别的比例。

**增强效果评估方法**

```python

# 训练模型

model = train_model(train_dataset, val_dataset)

# 评估模型在原始数据集和增强数据集上的性能

mAP_original = evaluate_model(model, original_dataset)

mAP_augmented = evaluate_model(model, augmented_dataset)

# 比较增强效果

if mAP_augmented > mAP_original:

print('数据集增强提高了模型性能')

else:

print('数据集增强没有提高模型性能')

```

**增强效果优化**

如果数据集增强没有提高模型性能,可以尝试以下优化策略:

- 调整增强参数:调整增强参数,如旋转角度、翻转概率、颜色抖动强度等。

- 添加更多增强类型:引入更多增强类型,如透视变换、遮挡、模糊等。

- 使用更复杂的增强策略:使用更复杂的增强策略,如CutMix、MixUp等。

# 5. YOLOv3训练数据集构建实践

### 5.1 数据集收集和标注工具推荐

**数据集收集:**

* **ImageNet:**图像识别领域的基准数据集,包含超过 1400 万张图像,涵盖 20000 多个类别。

* **COCO:**目标检测和分割任务的综合数据集,包含超过 30 万张图像和 250 万个标注。

* **VOC:**目标检测和分类任务的经典数据集,包含超过 16000 张图像和 27 个类别。

**标注工具:**

* **LabelImg:**一款开源的图像标注工具,支持矩形、多边形和点标注。

* **VGG Image Annotator:**一款基于 Web 的图像标注工具,提供丰富的标注功能和协作支持。

* **COCO Annotator:**专为 COCO 数据集设计的标注工具,提供高级标注功能和数据管理工具。

### 5.2 数据预处理和增强脚本编写

**数据预处理:**

```python

import cv2

import numpy as np

def preprocess_image(image, size=(416, 416)):

"""

对图像进行预处理:缩放、裁剪和增强。

参数:

image: 输入图像

size: 输出图像大小

返回:

预处理后的图像

"""

# 缩放图像

image = cv2.resize(image, size)

# 裁剪图像

image = image[0:size[0], 0:size[1]]

# 增强图像

image = cv2.cvtColor(image, cv2.COLOR_BGR2RGB)

image = image / 255.0

return image

```

**数据增强:**

```python

import random

def augment_image(image, boxes):

"""

对图像和边界框进行数据增强:旋转、翻转和颜色抖动。

参数:

image: 输入图像

boxes: 输入边界框

返回:

增强后的图像和边界框

"""

# 旋转图像

angle = random.randint(-15, 15)

image = cv2.rotate(image, angle)

# 翻转图像

if random.random() > 0.5:

image = cv2.flip(image, 1)

# 颜色抖动

image = image + np.random.uniform(-30, 30, image.shape)

image = np.clip(image, 0, 255)

# 更新边界框

boxes[:, 0] = boxes[:, 0] * image.shape[1] / image.shape[0]

boxes[:, 1] = boxes[:, 1] * image.shape[0] / image.shape[1]

return image, boxes

```

### 5.3 数据集质量评估和优化策略

**数据集分布分析:**

```python

import matplotlib.pyplot as plt

def analyze_dataset_distribution(dataset):

"""

分析数据集的分布:类分布和目标尺寸。

参数:

dataset: 输入数据集

"""

# 类分布

class_counts = {}

for image, boxes in dataset:

for box in boxes:

class_counts[box[4]] = class_counts.get(box[4], 0) + 1

plt.bar(list(class_counts.keys()), list(class_counts.values()))

plt.xlabel("类别")

plt.ylabel("数量")

plt.title("数据集类分布")

plt.show()

# 目标尺寸

target_sizes = []

for image, boxes in dataset:

for box in boxes:

target_sizes.append(box[2] * box[3])

plt.hist(target_sizes, bins=100)

plt.xlabel("目标尺寸")

plt.ylabel("数量")

plt.title("数据集目标尺寸分布")

plt.show()

```

**数据集标注质量检查:**

```python

import cv2

def check_dataset_annotation_quality(dataset):

"""

检查数据集的标注质量:错误和不一致性识别。

参数:

dataset: 输入数据集

"""

for image, boxes in dataset:

# 检查边界框是否超出图像范围

for box in boxes:

if box[0] < 0 or box[1] < 0 or box[2] > image.shape[1] or box[3] > image.shape[0]:

print("边界框超出图像范围:", box)

# 检查边界框是否重叠

for i in range(len(boxes)):

for j in range(i + 1, len(boxes)):

if box_iou(boxes[i], boxes[j]) > 0.5:

print("边界框重叠:", boxes[i], boxes[j])

# 检查边界框是否包含对象

for box in boxes:

if cv2.countNonZero(image[int(box[1]):int(box[3]), int(box[0]):int(box[2])]) < 100:

print("边界框不包含对象:", box)

```

**数据集增强效果评估:**

```python

import tensorflow as tf

def evaluate_data_augmentation_effect(dataset, model):

"""

评估数据增强对模型性能的影响。

参数:

dataset: 输入数据集

model: 输入模型

"""

# 创建增强数据集

augmented_dataset = tf.data.Dataset.from_generator(

lambda: ((image, boxes) for image, boxes in dataset),

output_types=(tf.float32, tf.float32),

output_shapes=((None, None, 3), (None, 5)),

)

augmented_dataset = augmented_dataset.map(augment_image)

# 训练模型

model.fit(augmented_dataset, epochs=10)

# 评估模型

loss, accuracy = model.evaluate(dataset)

print("增强数据集的损失:", loss)

print("增强数据集的准确率:", accuracy)

```

# 6. YOLOv3训练数据集构建总结

### 6.1 训练数据集构建原则和最佳实践

构建高质量的训练数据集是YOLOv3模型训练成功的关键。以下是一些训练数据集构建的原则和最佳实践:

- **数据多样性:**训练数据集应包含广泛的对象类别、背景和照明条件。这有助于模型泛化并提高其鲁棒性。

- **数据规模:**更大的训练数据集通常会导致更好的模型性能。然而,数据集的大小应与模型的复杂性和可用计算资源相平衡。

- **数据标注质量:**标注的准确性和一致性对于模型训练至关重要。应使用可靠的标注工具并遵循严格的标注准则。

- **数据预处理:**适当的数据预处理可以提高模型性能。常见的预处理技术包括图像缩放、裁剪、增强和数据增强。

- **数据集划分:**训练数据集应划分为训练集、验证集和测试集。验证集用于监控训练进度并调整模型超参数,而测试集用于评估模型的最终性能。

### 6.2 数据集构建的常见问题和解决方案

在训练数据集构建过程中,可能会遇到一些常见问题:

- **数据不平衡:**某些对象类别在训练集中可能比其他类别更常见。这会导致模型对常见类别的偏差。可以通过过采样或欠采样技术来解决此问题。

- **标注错误:**标注错误可能会导致模型训练不准确。应仔细检查标注并使用质量控制措施来最大程度地减少错误。

- **数据增强过度:**过度的数据增强可能会降低模型性能。应仔细调整增强参数以避免过度拟合。

- **数据集规模不足:**对于复杂的任务,数据集规模可能不足以训练强大的模型。在这种情况下,可以考虑使用预训练模型或数据合成技术。

### 6.3 数据集构建对模型性能的影响

训练数据集的质量对YOLOv3模型性能有重大影响。高质量的数据集可以提高模型的准确性、鲁棒性和泛化能力。相反,低质量的数据集会导致模型性能不佳,甚至导致模型过拟合。

通过遵循最佳实践和解决常见问题,可以构建高质量的训练数据集,从而为YOLOv3模型训练奠定坚实的基础。

0

0