MapReduce MapTask数量决定因素:专家解析数据分布与处理效率

发布时间: 2024-10-31 20:05:20 阅读量: 4 订阅数: 6

# 1. MapReduce框架概述

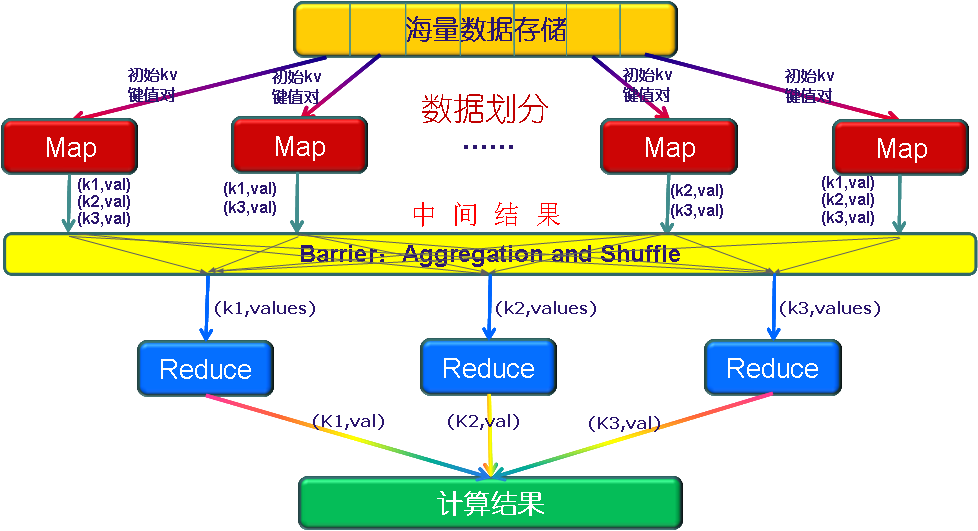

## 1.1 MapReduce的基本概念

MapReduce是一种编程模型,用于大规模数据集(大数据)的并行运算。其设计理念是将任务拆分为两个阶段:Map和Reduce。Map阶段负责处理输入数据,产生中间键值对;Reduce阶段则对这些中间数据进行合并处理。

## 1.2 MapReduce的工作原理

MapReduce框架在幕后处理任务的分配、调度和监控,用户只需关注Map函数和Reduce函数的实现。当输入数据到达,Map函数被调用处理每个数据块,随后框架将具有相同键的数据归并在一起,传递给Reduce函数进行处理。整个过程强调的是“分而治之”的策略。

## 1.3 MapReduce的应用场景

MapReduce适用于需要处理海量数据集的场景,如日志文件分析、大规模数据排序、数据库合并等。通过并行处理,MapReduce能够有效缩短大数据处理时间,提高数据处理效率。

```mermaid

graph LR

A[开始] --> B[数据输入]

B --> C[Map阶段]

C --> D[中间数据排序与分组]

D --> E[Reduce阶段]

E --> F[输出结果]

F --> G[结束]

```

### 代码示例(Map阶段)

```java

// Java代码示例,描述Map阶段的基本实现

public class MyMapper extends Mapper<LongWritable, Text, Text, IntWritable> {

private final static IntWritable one = new IntWritable(1);

private Text word = new Text();

public void map(LongWritable key, Text value, Context context) throws IOException, InterruptedException {

String[] words = value.toString().split("\\s+");

for (String str : words) {

word.set(str);

context.write(word, one);

}

}

}

```

此代码段展示了如何使用Java实现一个简单的Map函数,将输入的文本数据拆分为单词,并以单词为键,计数为值输出。

# 2. MapTask数量的影响因素

MapReduce框架中的MapTask数量对整体处理效率有着直接的影响。理解并掌握影响MapTask数量的因素是至关重要的。本章将从数据分布、输入数据的规模和特性以及集群配置等方面进行深入探讨。

## 2.1 数据分布的不均匀性

数据在Hadoop集群中的分布情况会直接影响MapTask的执行效率。数据分布不均匀会导致MapTask处理时间差异较大,进而影响整个作业的执行效率。

### 2.1.1 数据倾斜问题的识别与分析

数据倾斜是MapReduce作业中常见的性能瓶颈。当大部分数据集中在少数几个MapTask上时,这些任务会显著拖慢作业的处理速度。识别数据倾斜问题需要监控MapTask的执行时间和输出记录数量。

#### 数据倾斜识别方法

- **执行时间监控**:通过JobHistoryServer监控各个MapTask的执行时间,如果发现大部分MapTask完成很快,但少数几个耗时较长,则可能存在数据倾斜。

- **输出记录统计**:通过MapReduce的计数器,可以查看各个MapTask的输出记录数。如果记录数差距很大,那么数据倾斜的问题就很明显了。

#### 代码块示例

下面的代码块是一个监控MapTask执行时间的简单脚本示例:

```bash

#!/bin/bash

# 获取当前正在执行的作业ID

JOB_ID=$(yarn application -list | grep RUNNING | awk '{print $1}' | tail -n 1)

# 获取该作业的所有Map任务的运行时间(以秒为单位)

MAP_TASK_RUNNING_TIME=$(yarn logs -applicationId $JOB_ID | grep 'Map task executor' | awk '{print $8, $11}' | cut -d. -f1 | awk '{sum += $2} END {print sum}')

# 输出任务运行时间

echo "Total Map Task Running Time: $MAP_TASK_RUNNING_TIME seconds"

```

参数说明:

- `JOB_ID`:当前正在执行的作业ID,通过YARN获取。

- `MAP_TASK_RUNNING_TIME`:通过解析YARN日志获取所有Map任务的运行时间,并求和。

### 2.1.2 处理数据倾斜的策略与方法

解决数据倾斜的方法有很多,以下是一些常见的策略:

- **增加Map阶段的并行度**:增加Map任务数量可以在一定程度上缓解数据倾斜的问题。

- **使用Combiner**:在Map阶段使用Combiner可以减少数据传输量,但使用时需要注意数据的可组合性。

- **数据预处理**:通过数据预处理,将倾斜的数据进行重分布,比如使用自定义的Partitioner来改变数据的分发逻辑。

- **采样分析**:对数据进行采样分析,了解数据分布特性,设计合理的分组键,减少倾斜的可能性。

#### 代码块示例

下面的代码块展示了如何在MapReduce作业中添加Combiner的逻辑:

```java

public static class MyCombiner extends Reducer<Text, IntWritable, Text, IntWritable> {

private IntWritable result = new IntWritable();

public void reduce(Text key, Iterable<IntWritable> values, Context context)

throws IOException, InterruptedException {

int sum = 0;

for (IntWritable val : values) {

sum += val.get();

}

result.set(sum);

context.write(key, result);

}

}

public static void main(String[] args) throws Exception {

// ... 作业配置代码 ...

job.setCombinerClass(MyCombiner.class);

job.setMapperClass(MyMapper.class);

job.setReducerClass(MyReducer.class);

}

```

参数说明:

- `MyCombiner`:定义了一个Combiner类,用于在Map阶段进行数据合并。

- `MyMapper`:自定义Mapper类。

- `MyReducer`:自定义Reducer类。

## 2.2 输入数据的规模与特性

输入数据的规模和特性也是决定MapTask数量的关键因素。

### 2.2.1 小文件问题及其对MapTask数量的影响

小文件问题在Hadoop中是一个众所周知的性能瓶颈。每个小文件都会占用一个MapTask,导致Map任务数量增加,而资源利用率却很低。

##

0

0