MapReduce MapTask数量与内存使用的关系:深入分析与优化指南

发布时间: 2024-10-31 20:47:06 阅读量: 20 订阅数: 24

# 1. MapReduce框架的基本原理

MapReduce是一个分布式计算框架,允许开发者以一种简化的方式处理大数据。它是如何工作的呢?

## 1.1 分布式处理的核心概念

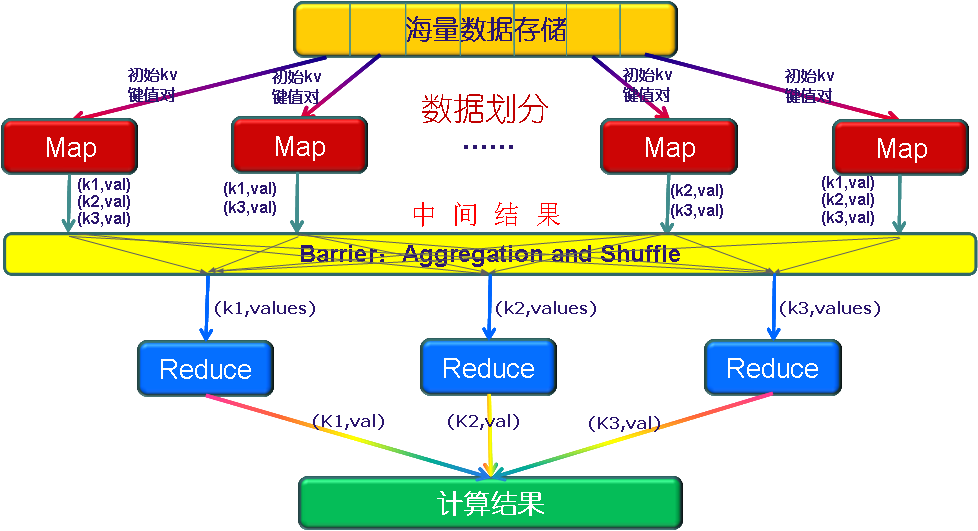

MapReduce通过将任务分布到多个节点上,实现对大数据集的并行处理。它主要包含两个阶段:Map阶段和Reduce阶段。

- **Map阶段**:数据被切分成小块,然后在各个节点上执行Map函数,转换成键值对(key-value pairs)。

- **Reduce阶段**:通过 Shuffle 过程将具有相同键的数据聚集起来,然后在Reduce函数中对这些数据进行合并。

## 1.2 MapReduce的优势

- **可扩展性**:MapReduce可以在多台计算机组成的集群上运行,自动处理数据分片和任务调度。

- **容错性**:如果某个节点失败,系统可以重新安排任务到其它节点执行。

## 1.3 理解MapReduce的实际应用

MapReduce框架已经广泛应用于多种场景,例如搜索引擎的索引构建、日志分析、数据挖掘等。核心优势在于其能够处理大量数据且易于编程。

```python

# 示例代码:MapReduce处理过程的简单模拟

def map(data):

for record in data:

key, value = process(record)

emit(key, value)

def reduce(key, values):

result = summary(values)

emit(key, result)

```

在本章中,我们了解到MapReduce框架的基本概念和优势。接下来,我们将深入探讨MapTask的具体工作机制与配置,以进一步理解如何优化和调整MapReduce任务以适应不同的计算需求。

# 2. MapTask的工作机制与内存配置

### 2.1 MapTask的数据处理流程

#### 2.1.1 输入数据的切片与分派

在MapReduce框架中,MapTask首先会从HDFS等存储系统中读取输入数据。数据在读取之前会被切分成多个“切片”(Splits),每个切片会由一个单独的MapTask处理。切片的生成是根据输入文件的大小、位置以及定义的输入格式来决定的,这保证了数据处理的并行性和高效性。

切片的分派是MapReduce作业调度的一部分。在作业提交后,作业调度器会根据集群的资源情况和任务的依赖关系,决定任务的分派。每个MapTask负责处理一个或者多个切片,具体取决于切片大小和集群的配置。

在实际应用中,可以通过以下代码块来检查生成的输入切片信息:

```java

// 示例代码展示如何获取Hadoop文件系统的输入切片信息

Configuration conf = getConf();

FileSystem fs = FileSystem.get(conf);

Path inputPath = new Path("hdfs://namenode/path/to/input/");

InputFormat<?, ?> inputFormat = JobBuilderUtil.getInputFormat(conf);

List<InputSplit> splits = inputFormat.getSplits(JobContext.get());

for (InputSplit split : splits) {

System.out.println(split.toString());

}

```

**代码解释及参数说明**:

- `Configuration conf`:获取当前作业的配置信息。

- `FileSystem fs`:连接到Hadoop文件系统。

- `Path inputPath`:定义输入数据的HDFS路径。

- `InputFormat<?, ?> inputFormat`:获取输入格式类,决定如何分割数据。

- `List<InputSplit> splits`:获取输入切片的列表。

- `split.toString()`:打印每个切片的详细信息。

#### 2.1.2 Map阶段的任务执行与内存消耗

在Map阶段,每个MapTask将读取输入切片的数据,并执行用户编写的Mapper类。Map阶段的主要工作是读取数据、执行用户定义的map函数,以及将map输出的键值对进行排序和缓存,最终将数据写入本地磁盘或传递给Reducer。

内存消耗在这个阶段主要发生在两个部分:内存中存储未排序的map输出数据,以及用户定义的Mapper对象。未排序的输出数据需要占用大量内存,特别是在处理大数据集时。如果内存不足,会触发磁盘交换,影响任务执行效率。

下面是一个简单的Mapper实现的代码示例:

```java

public class MyMapper extends Mapper<LongWritable, Text, Text, IntWritable> {

@Override

protected void map(LongWritable key, Text value, Context context) throws IOException, InterruptedException {

// 处理每行数据的逻辑

context.write(new Text(value.toString()), new IntWritable(1));

}

}

```

在这个例子中,`map`函数被定义为处理输入文本行,并将每行作为一个新的`Text`对象输出。该对象和其他键值对一起会被存储在内存中,直到内存被填满,然后再溢写到磁盘上。

### 2.2 MapTask内存管理策略

#### 2.2.1 JVM内存模型与MapReduce

MapReduce在执行MapTask时,使用JVM来管理内存。JVM内存模型包括几个主要部分:堆内存、栈内存、方法区等。在MapReduce中,尤其是堆内存的使用至关重要,因为它用来存储对象实例和数组。

对于MapReduce任务而言,堆内存又可以进一步细分为Young Generation(年轻代)和Old Generation(老年代)。年轻代用于存储新创建的对象,而老年代存储长期存活的对象。垃圾回收机制会频繁地清理年轻代,而老年代的垃圾回收会较少但清理的范围更广。

#### 2.2.2 配置参数对Map内存的影响

在MapReduce框架中,可以通过多种参数来配置和调整内存使用。这些参数包括:

- `mapreduce.map.java.opts`:设置Map任务Java虚拟机参数。

- `mapreduce.map.memory.mb`:设置Map任务可用的最大堆内存。

例如,如果你有一个大数据集并且经常遇到内存溢出问题,你可以尝试增加`mapreduce.map.memory.mb`参数的值,以提供更多的内存给Map任务。

```xml

<property>

<name>mapreduce.map.memory.mb</name>

<value>4096</value>

</property>

```

这个参数的调整对内存管理至关重要,尤其当Map阶段的计算非常复杂或数据量巨大时。

### 2.3 MapTask数量与性能的关联

#### 2.3.1 影响MapTask数量的因素分析

MapTask的数量直接影响到MapReduce作业的并行度,进而影响作业的总体执行时间。确定最优的MapTask数量是一个复杂的问题,因为它涉及到集群的资源分配、数据的大小、任务的复杂度等多个因素。

影响MapTask数量的因素包括:

- 输入数据的大小:数据量越大,通常需要更多的MapTask并行处理。

- 集群的资源:可用的CPU核心数、内存大小,以及磁盘I/O都会影响MapTask的数量。

- 数据分布:数据是否均匀分布也会影响MapTask的设置,因为理想情况下,所有MapTask应

0

0