深入gzip模块:Python开发者必知的5个压缩技术细节

发布时间: 2024-10-10 09:49:14 阅读量: 131 订阅数: 40

# 1. gzip模块的基础知识

在现代的网络传输和数据存储中,gzip模块扮演了至关重要的角色。作为一个广泛使用的数据压缩工具,gzip通过高效的压缩算法减少了数据大小,从而加快了文件的传输速度并节省了存储空间。本章将介绍gzip模块的基础知识,为后续章节关于压缩原理、性能优化及实际应用的深入探讨奠定基础。

为了更好地理解gzip模块,我们将首先探讨它的核心作用,即数据压缩。随后,我们将概括gzip模块在软件开发和网络优化中的重要性,并提供一个简单的gzip模块使用示例,展示如何在Python中压缩和解压缩文件。

```python

import gzip

import shutil

# 压缩文件

with open('example.txt', 'rb') as f_in:

with gzip.open('example.txt.gz', 'wb') as f_out:

shutil.copyfileobj(f_in, f_out)

# 解压缩文件

with gzip.open('example.txt.gz', 'rb') as f_in:

with open('example.txt', 'wb') as f_out:

shutil.copyfileobj(f_in, f_out)

```

以上代码展示了如何在Python中使用gzip模块压缩和解压缩文件。需要注意的是,gzip模块只支持`.gz`扩展名的压缩文件。随着内容的深入,我们将探索更多gzip模块的高级应用和优化技巧。

# 2. 深入gzip压缩原理

### 2.1 压缩算法的理论基础

#### 2.1.1 数据压缩的重要性

数据压缩是信息技术领域中的一项重要技术,它能够减少数据的存储空间和传输时间,从而提高数据处理效率和节约存储资源。在现代计算机系统中,无论是操作系统、数据库管理系统还是网络传输,都离不开高效的数据压缩技术。例如,网络浏览器在传输网页内容时,使用压缩算法可以显著减少带宽消耗和提升页面加载速度。在存储方面,压缩技术可以使得相同容量的硬盘存储更多的数据。

#### 2.1.2 常见的压缩算法概述

目前存在多种压缩算法,它们可以分为无损压缩和有损压缩两大类。无损压缩算法保证数据在压缩前后的完全一致性,适用于文本、程序代码和数据库文件等场景。常见的无损压缩算法包括但不限于:

- Run-Length Encoding(RLE)

- Huffman Coding

- Lempel-Ziv-Welch(LZW)

- DEFLATE(gzip和PNG文件使用的压缩算法)

有损压缩算法通常用于图像、音频和视频文件,如JPEG、MP3和MP4格式,通过牺牲一定的信息精确度来获得更高的压缩比。

### 2.2 gzip压缩技术的工作机制

#### 2.2.1 DEFLATE算法解析

gzip压缩技术使用的是DEFLATE算法,这是一种结合了LZ77压缩(一种基于字典的压缩技术)和Huffman编码的无损压缩算法。DEFLATE算法首先会利用滑动窗口和LZ77算法对输入数据进行压缩,从而移除数据中的冗余部分。接着,通过Huffman编码对LZ77算法输出的压缩数据进行进一步压缩。Huffman编码是一种基于字符出现频率的变长编码方法,它通过为更频繁出现的字符分配更短的码字,为不那么频繁出现的字符分配更长的码字来实现数据的压缩。

#### 2.2.2 gzip文件格式细节

gzip文件格式是一个用于压缩文件的文件格式,它支持数据压缩以及校验和。一个gzip文件主要包含以下几个部分:

- 头部信息(Header)

- 压缩数据(Compressed data)

- CRC校验码(CRC)

- 头部信息的结束标志(Footer)

头部信息记录了用于压缩文件的元数据,例如原始文件的大小、压缩方法、时间戳等。压缩数据是实际压缩后的内容。CRC校验码用于检测在压缩或传输过程中文件是否发生变化。头部信息的结束标志用于确定gzip文件的结束位置。

### 2.3 Python中的gzip模块与文件处理

#### 2.3.1 Python gzip模块的使用方法

Python的gzip模块是一个高级接口,用于处理gzip格式的压缩文件。它提供了简单的API来读取、写入和处理gzip文件。使用Python的gzip模块可以轻松地在Python脚本中实现数据的压缩和解压缩。以下是使用Python gzip模块压缩文件的基本步骤:

```python

import gzip

import shutil

# 打开一个gzip压缩文件,返回一个类文件对象

with gzip.open('example.txt.gz', 'wt', encoding='utf-8') as f:

f.write('这是压缩后的文本内容。')

# 将非gzip文件压缩为gzip格式,并写入新文件

with open('example.txt', 'rt', encoding='utf-8') as f_in, \

gzip.open('example.txt.gz', 'wt', encoding='utf-8') as f_out:

shutil.copyfileobj(f_in, f_out)

# 读取gzip压缩文件中的内容

with gzip.open('example.txt.gz', 'rt', encoding='utf-8') as f:

content = f.read()

```

#### 2.3.2 文件压缩和解压缩的示例代码

为了展示文件压缩和解压缩的过程,下面提供了一个简单的Python脚本,它展示了如何压缩一个文本文件,并随后将其解压缩。此外,该脚本还包含了一个检查压缩前后文件大小的步骤,以便于评估压缩效率。

```python

import os

import gzip

# 定义一个压缩函数

def compress_file(file_path):

# 获取原始文件大小

original_size = os.path.getsize(file_path)

# 压缩文件

with open(file_path, 'rb') as f_in, gzip.open(file_path + '.gz', 'wb') as f_out:

shutil.copyfileobj(f_in, f_out)

# 获取压缩后文件大小

compressed_size = os.path.getsize(file_path + '.gz')

# 打印压缩前后的文件大小

print(f"Original file size: {original_size} bytes.")

print(f"Compressed file size: {compressed_size} bytes.")

# 定义一个解压缩函数

def decompress_file(gz_file_path):

# 解压缩文件

with gzip.open(gz_file_path, 'rb') as f_in, open(gz_file_path[:-3], 'wb') as f_out:

shutil.copyfileobj(f_in, f_out)

# 删除原压缩文件

os.remove(gz_file_path)

# 打印解压缩结果

print(f"Decompressed file saved as {gz_file_path[:-3]}.")

# 假设有一个名为'example.txt'的文本文件

compress_file('example.txt')

# 假设压缩后的文件名为'example.txt.gz'

decompress_file('example.txt.gz')

```

这段脚本首先定义了两个函数,`compress_file`用于压缩文件,并打印出原始文件和压缩文件的大小,`decompress_file`用于解压缩文件,并将解压缩后的文件保存在同一目录下。执行完毕后,脚本会显示压缩前后文件大小的对比,从而评估压缩的效果。

# 3. 优化gzip压缩效率

gzip作为一个广泛应用的压缩工具,其效率直接影响到系统的性能和用户体验。在追求更快的压缩和解压缩速度的同时,还需要考虑到内存和I/O资源的合理利用,以及对性能的实时监控。本章节将深入探讨如何优化gzip压缩效率,以便实现更好的性能表现。

## 3.1 压缩级别与性能权衡

gzip的压缩级别是影响压缩效率的重要因素。一个合适的压缩级别可以平衡文件压缩率和压缩时间,这对于资源有限的环境尤其重要。

### 3.1.1 不同压缩级别的比较

gzip提供从1到9的压缩级别,数字越大,压缩率越高,但所需时间也越长。以下为不同级别下的压缩率和速度的对比:

- 压缩级别1:非常快速,但压缩率低。

- 压缩级别5:平衡压缩速度和压缩率。

- 压缩级别9:最慢,但提供了最佳的压缩率。

### 3.1.2 选择合适的压缩级别

选择合适的压缩级别需要依据实际应用场景。例如,对于需要快速响应的应用,应选择级别较低的压缩。反之,对于带宽有限或存储成本高昂的应用,可以选用级别较高的压缩。可以通过以下Python代码来测试不同压缩级别的效率:

```python

import gzip

import shutil

import time

def test_gzip_compression_level(level):

input_data = b'...' # 假设这是需要压缩的数据

start_time = time.time()

with gzip.open('output.gz', 'wt', encoding='utf-8', compresslevel=level) as ***

***'utf-8'))

end_time = time.time()

return (end_time - start_time)

for level in range(1, 10):

compression_time = test_gzip_compression_level(level)

print(f"压缩级别 {level}: 耗时 {compression_time} 秒")

```

通过运行此脚本,可以观察不同压缩级别的耗时,从而选择最合适的级别。

## 3.2 内存使用与I/O优化

在处理大文件或需要频繁压缩/解压缩的场景中,合理使用内存和优化I/O操作是提升性能的关键。

### 3.2.1 内存管理技巧

由于gzip在压缩过程中会使用到一定量的内存,因此应该避免一次性压缩过大的文件,以防止内存溢出。可以将大文件分割成多个小块,分别进行压缩。代码示例如下:

```python

import gzip

def compress_large_file(file_path, output_path):

with open(file_path, 'rb') as f_input, gzip.open(output_path, 'wb') as f_output:

block_size = 1024 * 1024 # 例如,每次处理1MB

while True:

block = f_input.read(block_size)

if not block:

break

f_output.write(block)

compress_large_file('large_file.dat', 'large_file.dat.gz')

```

### 3.2.2 高效I/O操作策略

优化I/O操作的关键在于减少磁盘读写次数,并合理利用缓冲。在读写操作时,应尽量使用大块数据进行传输,减少对磁盘的频繁访问。

## 3.3 压缩/解压缩过程中的性能监控

为了持续改进gzip的性能,我们需要对压缩和解压缩过程进行性能监控。

### 3.3.1 性能监控工具和方法

可以使用性能分析工具如`htop`, `iotop`, `time`等,来监控CPU和I/O使用情况。此外,Python的`cProfile`模块可用于分析代码的性能瓶颈。

```python

import cProfile

import pstats

def profile_gzip_compression():

cProfile.runctx('compress_large_file("large_file.dat", "large_file.dat.gz")', globals(), locals(), 'compress.log')

profile_gzip_compression()

p = pstats.Stats('compress.log')

p.sort_stats('cumulative').print_stats(10)

```

### 3.3.2 性能问题的诊断与解决

性能问题可能由多种原因引起,比如磁盘IO瓶颈、不合理的内存分配、CPU负载过高等。诊断性能问题时,应根据监控数据来分析瓶颈所在,并针对性地优化。

- 如果磁盘I/O是瓶颈,考虑使用更快的存储设备,比如SSD。

- 如果内存分配不合理,优化内存管理策略,例如调整Python的内存分配器。

- 如果CPU负载过高,检查是否有优化算法的空间,或分散计算负载到多核处理器上。

通过合理的性能监控和问题诊断,我们可以持续优化gzip的压缩效率,确保系统的高性能运行。

# 4. gzip在现代应用中的实践

随着互联网应用的发展,数据传输效率逐渐成为性能优化的关键点。gzip作为一种高效的压缩技术,已经被广泛应用于静态资源的压缩、动态内容的实时压缩和网络传输优化等多个场景。本章将探讨gzip在现代应用中的具体实践方法,以及这些实践带来的性能提升。

## 4.1 静态资源的压缩和部署

### 4.1.1 静态资源压缩的必要性

静态资源如图片、CSS、JavaScript文件等在网站中占比很大,它们往往占据了网站响应时间的主要部分。通过gzip压缩这些静态资源,可以显著减少传输文件的大小,从而加快用户的加载速度。这不仅提高了用户体验,还有助于网站搜索引擎优化(SEO)。

### 4.1.2 利用gzip压缩静态文件的实践

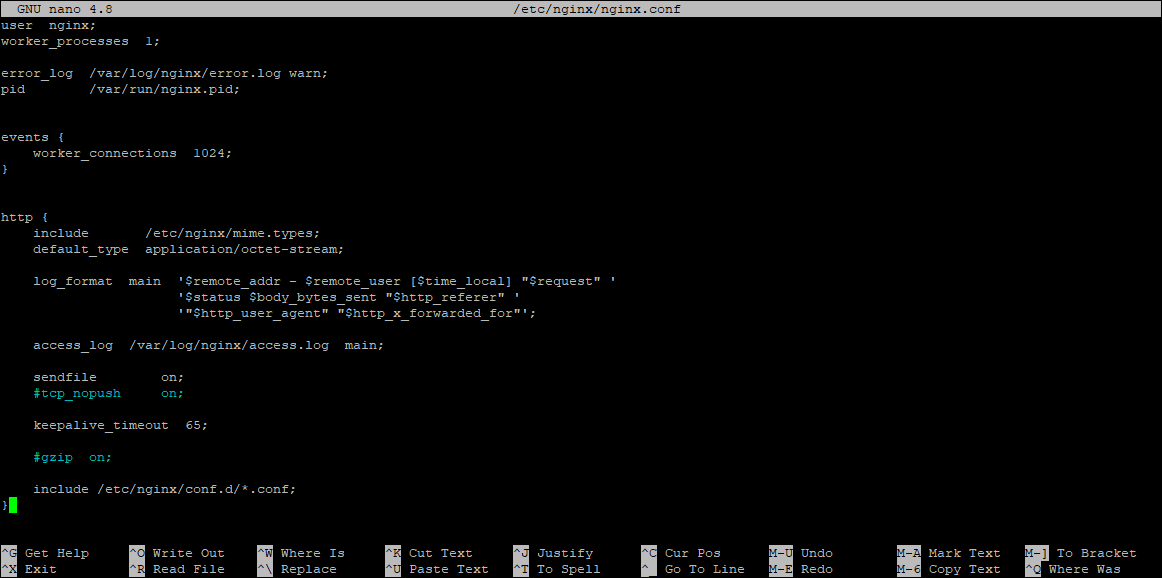

服务器端通常使用Web服务器软件如Apache或Nginx来实现对静态资源的gzip压缩。以Nginx为例,开启gzip压缩的配置代码如下:

```nginx

http {

gzip on;

gzip_disable "msie6";

gzip_vary on;

gzip_proxied any;

gzip_comp_level 6;

gzip_buffers 16 8k;

gzip_http_version 1.1;

gzip_types text/plain text/css application/json application/javascript text/xml application/xml application/xml+rss text/javascript;

}

```

解释:

- `gzip on;` 启用gzip压缩。

- `gzip_disable "msie6";` 禁止对IE 6的压缩,因为该浏览器存在一些已知问题。

- `gzip_vary on;` 向客户端添加Vary头,使代理服务器能够知道响应内容经过了压缩。

- `gzip_proxied any;` 对代理服务器连接也启用压缩。

- `gzip_comp_level 6;` 设置压缩级别为6(范围从1到9)。

- `gzip_buffers 16 8k;` 分配用于压缩的缓冲区大小。

- `gzip_http_version 1.1;` 设置HTTP版本,对于HTTP/1.0连接,不启用压缩。

- `gzip_types` 指定哪些类型的响应体进行压缩。

通过这些设置,Nginx将自动压缩静态文件并发送给客户端。客户端浏览器接收到响应后会自动解压,并使用压缩后的资源。

## 4.2 动态内容的实时压缩

### 4.2.1 动态内容压缩的技术挑战

动态内容,例如由PHP、Python、Ruby等后端语言生成的页面,在生成时往往无法知道最终输出的大小,这给实时压缩带来了挑战。要实现动态内容的压缩,需要在应用层完成压缩逻辑。

### 4.2.2 Python框架中的gzip应用实例

在Python应用中,可以在WSGI(Web Server Gateway Interface)层面上实现gzip压缩。一个简单的Flask应用使用gzip压缩的示例代码如下:

```python

from flask import Flask, Response

import gzip

app = Flask(__name__)

@app.after_request

def compress(response):

accept_encoding = request.headers.get('Accept-Encoding')

if (response.status_code < 200 or

response.status_code >= 300 or

'gzip' not in accept_encoding.lower() or

len(response.get_data()) < 1024):

return response

response.direct_passthrough = False

if (response.headers.get('Content-Encoding') is not None):

return response

content = ***press(response.get_data(), compresslevel=5)

response.set_data(content)

response.headers['Content-Encoding'] = 'gzip'

response.headers['Content-Length'] = len(content)

response.headers['Vary'] = 'Accept-Encoding'

response.headers['X-Compressed'] = 'gzip'

return response

```

解释:

- `@app.after_request` 修饰器用于在响应返回客户端之前执行函数。

- 通过检查`Accept-Encoding`头部来判断客户端是否支持gzip。

- 使用`***press`方法对响应数据进行压缩。

- 设置`Content-Encoding`为gzip,指明响应已经被压缩。

- 指示客户端内容长度发生变化,并通过Vary头部通知客户端内容可能因接受编码不同而不同。

## 4.3 网络传输优化

### 4.3.1 压缩与HTTP协议的协同

HTTP协议提供了多种方法来优化网络传输,gzip压缩与HTTP协议的协同工作能够进一步提升性能。例如,HTTP 2.0中的多路复用可以与压缩技术结合,有效减少了由于HTTP请求延迟和网络拥堵带来的性能损耗。

### 4.3.2 提升网络传输效率的实际案例

一个实际案例是使用HTTPS协议和gzip压缩来减少网页加载时间。首先,通过HTTPS加密数据传输,提高了数据传输的安全性。然后,通过gzip压缩动态生成的HTML页面,减少了数据包的大小,加快了网络传输速度。最终结果是提升了网页的加载性能,改善了用户的浏览体验。

通过以上实践,可以看出gzip作为一种压缩工具,在静态资源压缩、动态内容压缩以及网络传输优化中发挥着至关重要的作用。这不仅提升了网站性能,也使得网页在不同网络环境下更加稳定和快速。

在本章中,我们详细探讨了gzip在现代网络应用中的多种实践方法。通过实际案例和代码分析,我们了解了如何在服务器配置和应用程序中实现gzip压缩,以及如何通过这一技术提高网络传输效率。在下一章中,我们将进一步探索gzip模块的高级功能,并对未来的压缩技术趋势进行展望。

# 5. gzip模块的高级功能与未来展望

随着技术的发展,gzip模块不仅在现代应用中扮演着重要角色,而且其高级功能也开始受到关注。本章节将探讨gzip的高级压缩技术细节,并与其他压缩模块进行比较,最后预测其未来发展趋势。

## 5.1 高级压缩技术细节

在深入了解gzip模块的高级功能之前,我们需要了解它的一些高级压缩技术。

### 5.1.1 多文件压缩与归档

gzip可以用来压缩单个文件,也可以用来创建压缩的归档文件。使用归档文件可以同时压缩多个文件和目录,这在备份和存储大型文件集合时非常有用。

```bash

# 通过命令行压缩多个文件和目录

tar -czvf archive.tar.gz directory_to_compress file1.txt file2.txt

```

上述命令创建了一个名为`archive.tar.gz`的压缩归档,其中包含了一个目录和两个文件。

### 5.1.2 自定义字典的使用

自定义字典是一种优化技术,允许用户指定一个预定义的字符串列表,以提高特定数据的压缩效率。这在压缩具有重复数据或已知模式的数据集时特别有用。

在Python中,你可以使用以下代码来应用自定义字典:

```python

import gzip

# 自定义字典数据

custom_dict = [b"some common phrase", b"another common string"]

# 写入压缩数据,同时指定自定义字典

with gzip.open('compressed_file.gz', 'wt', custom_dict=custom_dict) as ***

***"some common phrase repeated多次")

```

在实际应用中,你可能需要根据数据集来生成或选择合适的字典。

## 5.2 gzip与其他压缩模块的比较

不同压缩模块在效率、压缩比、速度等方面各有优劣。让我们探讨一些流行的压缩模块,并比较它们与gzip的不同之处。

### 5.2.1 对比bzip2, lzma等模块

- **bzip2**: 使用Burrows-Wheeler变换的压缩算法,通常比gzip提供更高的压缩比,但压缩和解压缩速度较慢。

- **lzma**: 提供极高的压缩比,压缩速度较慢,但解压缩速度相对较快。

以下是一个简单的对比表:

| 模块 | 压缩比 | 压缩速度 | 解压缩速度 |

|---------|--------------|-------------|---------------|

| gzip | 中 | 中 | 快 |

| bzip2 | 高 | 慢 | 较快 |

| lzma | 非常高 | 慢 | 快 |

### 5.2.2 选择最佳压缩工具的依据

选择合适的压缩工具,需要考虑以下因素:

- **压缩效率**: 如果存储空间有限,可能更倾向于选择具有高压缩比的工具。

- **速度**: 如果数据处理需要实时性,压缩和解压缩的速度就变得尤为重要。

- **资源占用**: 如果系统资源有限,可能需要选择对内存和CPU占用较小的压缩工具。

- **兼容性**: 压缩工具在不同的操作系统和软件环境中的兼容性也是一个考虑因素。

## 5.3 预见gzip模块的发展趋势

随着计算技术的发展,gzip模块也在不断进化。接下来将讨论gzip模块可能的发展方向。

### 5.3.1 硬件加速压缩技术的探索

现代处理器提供了专用指令集来加速压缩和解压缩过程。例如,Intel的AES-NI指令集可以加速数据加密和压缩任务。未来gzip可能进一步利用这些指令集,以提高性能。

### 5.3.2 新兴压缩算法的潜在影响

新的压缩算法如Zstandard (zstd) 和Zlibng,它们提供了比传统gzip更好的压缩效率和速度。虽然这些算法目前还没有完全取代gzip,但它们已经开始被集成到一些新的应用中。未来,随着这些算法的成熟和普及,gzip模块可能需要进行适配和整合,以保持其相关性。

本章节深入探讨了gzip模块的高级功能,并预测了未来发展趋势。随着技术的进步,gzip模块也在不断地进化,以适应不断增长的性能需求和新兴的应用场景。

0

0