gzip模块高级技巧:如何优化压缩性能和处理大型文件

发布时间: 2024-10-10 09:52:27 阅读量: 144 订阅数: 42

geek-fepo-course:前端性能优化(前端全互连性能优化实战)视频课程PPT和实例

# 1. gzip模块概述与基础压缩技术

## 概述

gzip是一种广泛应用于网络传输和文件存储的压缩工具。它的主要功能是通过压缩算法减小文件的大小,以减少存储空间占用和加快网络传输速度。作为一个强大的压缩模块,gzip在减少数据冗余和优化资源使用方面发挥了重要作用,是现代IT架构中不可或缺的组件之一。

## 压缩技术简介

基础压缩技术主要涉及算法和数据结构。其中,常见的压缩技术包括无损压缩和有损压缩。无损压缩算法能够在解压时完整恢复原始数据,而有损压缩则允许一定程度的信息丢失以换取更高的压缩率。gzip采用的是DEFLATE算法,它结合了LZ77算法和Huffman编码的特性,是一种无损压缩算法。这种算法适合文本、文档等对数据完整性有要求的场景。

## 压缩原理

gzip压缩的原理可以简单分为以下几个步骤:

1. 输入数据首先被分成一系列大小固定的块(默认大小为8KB)。

2. 每个数据块使用LZ77算法寻找重复的字符串序列,并以短编码替换。

3. 接着利用Huffman编码对替换后生成的字符串进行进一步编码,优化存储。

4. 最后,整个压缩数据通过一个24位的校验头进行封装,形成一个gzip文件。

理解了gzip的基础压缩技术,我们可以开始探讨如何提升其性能,以及在不同类型文件、系统级别上的优化策略。

# 2. 提升gzip压缩性能的策略

在第一章中,我们已经探讨了gzip模块的基础知识和基础压缩技术。本章将深入挖掘如何提升gzip压缩性能,探索压缩算法的内部机制,不同类型文件的压缩技巧,以及如何从系统级别进行性能调整。

## 2.1 gzip压缩算法深度解析

gzip使用的是DEFLATE压缩算法,它结合了LZ77算法和哈夫曼编码这两种技术。LZ77是一种无损数据压缩算法,通过查找并替换重复出现的字符串,有效减少文件大小。哈夫曼编码则是一种用于无损数据压缩的广泛使用的字符编码方法。了解这些机制有助于我们选择合适的压缩级别和字典大小来优化压缩性能。

### 2.1.1 压缩级别的选择与影响

gzip允许用户指定压缩级别,范围从1(最快的压缩速度,最差的压缩比率)到9(最慢的压缩速度,最佳的压缩比率)。压缩级别越高,压缩过程消耗的CPU资源越多,但是可以得到更小的压缩文件。

```bash

# 指定压缩级别为9进行压缩

gzip -9 filename.txt

```

在选择压缩级别时,需要平衡压缩时间和CPU资源消耗。对于CPU资源充足的环境,较高压缩级别可以显著减小文件体积。对于需要频繁读写的场景,可能需要选择较低的压缩级别以减少延迟。

### 2.1.2 字典大小与压缩效率的关系

DEFLATE算法使用字典来存储字符串,以备后续引用。字典大小的选择对压缩效率有重要影响。如果字典太小,可能会错失压缩机会;如果字典太大,内存消耗和查找效率会受到影响。

在多数情况下,gzip默认的字典大小已经足够应对大多数情况。但如果你压缩的数据集包含非常大且重复的数据块,增加字典大小可能会进一步提高压缩比率。

```c

// 示例代码:使用zlib库动态设置gzip字典大小

#include <zlib.h>

z_stream stream;

int dictSize = 32768; // 设置字典大小为32KB

// 初始化流

deflateInit2(&stream, Z_BEST_COMPRESSION, Z_DEFLATED, MAX_WBITS + 16, 8, Z_DEFAULT_STRATEGY);

// 设置自定义字典

stream.adler = adler32(0L, Z_NULL, 0);

stream.next_in = (Bytef *)dictionary;

stream.avail_in = dictSize;

stream.next_out = (Bytef *)outputBuffer;

stream.avail_out = outputBufferSize;

// 复位字典和流,以便于后续使用

stream.total_in = stream.total_out = 0;

stream.avail_in = stream.avail_out = 0;

// 进行压缩

int result = deflateSetDictionary(&stream, dictionary, dictSize);

if (result != Z_OK) {

// 处理错误

}

// 继续压缩数据...

// 清理资源

deflateEnd(&stream);

```

在实际应用中,除非遇到特定的需求,否则不建议轻易调整字典大小,因为这可能会导致额外的复杂性和资源消耗。

## 2.2 针对不同类型文件的优化

不同类型的文件具有不同的数据特征,因此在压缩时需要采取不同的策略。

### 2.2.1 文本文件的压缩技巧

文本文件通常具有较高的冗余性,特别是代码文件和配置文件,因此使用gzip压缩可以获得很好的压缩率。在处理文本文件时,可以通过优化LZ77压缩的窗口大小来进一步提高性能。

```c

// 示例代码:使用zlib库优化LZ77窗口大小

#include <zlib.h>

z_stream stream;

int windowBits = 13; // 设置LZ77窗口大小为32KB

// 初始化流

int result = inflateInit2(&stream, windowBits);

if (result != Z_OK) {

// 处理错误

}

// 设置压缩参数...

// 进行压缩...

// 清理资源

inflateEnd(&stream);

```

### 2.2.2 二进制文件的压缩策略

对于二进制文件,由于其数据特征差异较大,可能需要特别注意压缩级别和字典大小的选择。某些二进制文件可能包含随机数据,这类文件对压缩不太敏感,因此选择较低的压缩级别和默认字典大小通常是个好主意。

## 2.3 系统级别的gzip性能调整

系统级别的性能调整是优化gzip性能的关键,特别是对于高并发和大数据量的环境。

### 2.3.1 硬件加速与压缩性能

现代硬件设备,如SSD和专用压缩加速器,可以显著提升gzip性能。这些硬件可以加速数据读写过程,从而减少IO瓶颈。

### 2.3.2 内存和CPU资源的合理配置

压缩过程对内存和CPU资源有较高的要求。在系统级别,需要合理配置内存和CPU资源,确保在高负载时系统仍然能够提供稳定的压缩性能。在Linux系统中,可以使用cgroups和NUMA策略等工具来优化资源分配。

```bash

# 使用cgconfig配置cgroups以优化资源分配

group gzip_opt {

cpu {

cpu.shares = "1024";

}

memory {

memory.limit_in_bytes = 1024 * 1024 * 1024; # 1GB

}

}

```

通过合理配置,我们可以确保gzip压缩不会因为资源竞争而受到太大影响,同时还能保障其他应用的性能需求。

本章深入分析了gzip压缩性能的提升策略。下一章,我们将探讨如何在处理大型文件时,应用分块压缩技术、流式压缩方法以及扩展工具,以实现高效的数据处理。

# 3. 高效处理大型文件的gzip应用

随着信息技术的飞速发展,大数据已成为各行业不可或缺的一部分。大型文件的压缩与传输是现代IT环境中常见的需求,gzip作为应用广泛的压缩工具,其在处理大型文件时的性能优化尤为重要。本章将深入探讨如何高效处理大型文件,以提高 gzip 压缩与解压缩的效率和可靠性。

## 3.1 分块压缩技术的实践

### 3.1.1 大文件分块压缩的原理

在处理超大文件时,传统的一次性压缩方法会导致内存消耗巨大,甚至可能造成内存溢出。分块压缩技术通过将大文件切分成多个小块,分别进行压缩,可以有效减少内存消耗,并提高处理速度。此外,这种技术还能增强错误恢复能力,因为单独处理每个压缩块,一旦某块压缩失败,只需重新压缩该块而非整个文件。

### 3.1.2 分块压缩中的错误处理和恢复

在实现分块压缩的过程中,错误处理是必须要考虑的一个方面。例如,如果某个块在压缩过程中发生错误,理想的操作是仅重新压缩出现问题的块。在错误恢复上,需要一个良好的机制来记录哪些块已经成功压缩,哪些没有,并在发生错误时能够迅速定位到失败点,实现精确的错误恢复。

## 3.2 流式压缩与解压缩

### 3.2.1 流式压缩的实现方法

流式压缩是一种连续处理数据流的方法,它不需要在内存中保存完整的数据。这种技术特别适合于管道和流式数据处理系统,如处理网络上传输的数据或处理连续产生的日志文件。实现流式压缩,通常需要编写支持数据流的代码,这样即使在数据不断产生的同时也能进行压缩。

### 3.2.2 流式处理在大数据环境下的优势

流式处理在大数据环境下的主要优势在于其低延迟和高吞吐量。它允许数据在产生的同时就进行压缩,这样可以减少存储需求,提高数据传输效率。此外,流式处理还可以用于实时分析场景,例如,在数据到达的同时进行处理和分析,这对于需要实时反应的业务场景至关重要。

## 3.3 大型文件处理的扩展工具和技巧

### 3.3.1 使用pigz等工具提升多核CPU利用

为了进一步提升压缩和解压缩大型文件的性能,可以采用支持多线程处理的工具,如pigz(parallel implementation of gzip)。这种工具利用多核CPU并行处理数据,从而大幅度提高压缩速度。使用这种工具时,需要合理配置线程数以匹配CPU核心数,以获得最佳性能。

### 3.3.2 结合后台任务调度工具进行文件压缩

后台任务调度工具(如cron)可以帮助自动化压缩任务,安排在系统负载较低的时候进行大型文件的压缩处理,从而减少对系统正常运行的影响。此外,通过调度工具,可以设置文件压缩任务的优先级和执行条件,确保在适当的时间和资源下完成压缩工作。

本章通过深入讨论分块压缩技术、流式压缩的实现方法、以及如何利用扩展工具和技巧来提升大型文件的处理能力,展示了gzip在处理大型文件方面的高效应用。下一章节将着重于gzip在现代IT架构中的应用案例。

# 4. gzip在现代IT架构中的应用案例

## 4.1 分布式文件系统的gzip应用

### 4.1.1 Hadoop与gzip压缩的结合

在现代IT架构中,Hadoop作为分布式计算的代表框架,广泛应用于大数据处理。在这样的背景下,文件压缩和解压缩是数据传输、存储与处理的关键组成部分。通过将gzip与Hadoop结合使用,可以显著提升数据处理的效率。

Hadoop的MapReduce模型对输入数据进行分片处理,每个分片由不同的Map任务来处理。在Hadoop中,文件通常被存储在HDFS(Hadoop Distributed File System)中。通过使用gzip压缩技术,数据在存储到HDFS之前可以被压缩,从而减少磁盘I/O,节省存储空间,同时加快网络传输速度。

在Hadoop集群中集成gzip压缩,需要对Hadoop的配置文件进行修改,指定需要使用gzip格式的文件。例如,可以修改`hadoop-site.xml`配置文件,设置`***pression.codecs`属性来包含gzip压缩的编解码器。

```xml

<property>

<name>***pression.codecs</name>

<value>

***press.DefaultCodec,

***press.GzipCodec,

***press.BZip2Codec,

***press.DeflateCodec,

***press.SnappyCodec

</value>

</property>

```

### 4.1.2 分布式压缩在大数据处理中的角色

分布式压缩技术在大数据处理中扮演着重要的角色。不仅是为了节省存储空间,更重要的是提高数据处理的速度和效率。以Hadoop为例,集群中的节点可以并行处理数据,如果这些数据是以压缩格式存储的,那么读取和写入操作也会变得更快。

此外,在MapReduce作业中,Map任务和Reduce任务之间可以通过压缩的数据进行数据交换,减少了网络带宽的使用,同时减轻了对网络和磁盘I/O的压力。Hadoop的压缩功能支持在数据读取和写入过程中自动进行压缩和解压缩,这样就隐藏了压缩技术的复杂性,并提高了开发人员的生产效率。

然而,在分布式环境下,使用压缩技术也引入了一些挑战,例如,压缩和解压缩需要消耗更多的CPU资源。因此,在Hadoop集群上部署gzip压缩时,需要仔细考虑集群的CPU能力,并进行适当的性能测试和调整。

## 4.2 云计算环境中的gzip优化

### 4.2.1 云存储服务中的压缩策略

云存储服务如Amazon S3、Google Cloud Storage等,允许用户存储和检索数据。由于云存储服务通常按使用量收费,因此优化存储成本是用户关注的焦点之一。使用gzip压缩数据可以减少存储空间的使用,从而降低存储成本。

云存储服务的压缩策略通常由用户或服务提供商的后台进程来管理。用户可以设置在数据上传时自动进行压缩,或者在数据上传后由服务端自动压缩存储。为了达到最佳的压缩效果,用户需要对数据类型、大小以及访问模式有充分的了解。

云存储服务提供商有时也会提供不同的压缩算法选项,比如gzip、bzip2、Zstandard(zstd)等。用户可以根据具体需求选择不同的压缩算法。通常,zstd提供了比gzip更高的压缩率和速度,是云服务压缩领域的新选择。

### 4.2.2 云函数与压缩文件处理的最佳实践

云函数(如AWS Lambda、Azure Functions、Google Cloud Functions)允许用户在无服务器环境中运行代码。在云函数中处理压缩文件时,最佳实践通常包括:

- **上传压缩文件**:上传大文件之前进行压缩,可以减少上传时间和成本。

- **自动解压**:在云函数中处理压缩文件时,通常会在函数执行时自动解压。

- **优化内存使用**:云函数的内存限制可能限制大文件的处理,因此需要优化代码逻辑,以便在内存允许的范围内处理文件。

- **考虑执行时间限制**:云函数有执行时间限制,处理大文件时需要考虑时间和内存的平衡。

- **使用事件驱动**:处理文件上传等事件时,可以使用事件驱动架构,结合云函数进行高效的数据处理。

为了在云函数中处理gzip压缩文件,可以编写如下的示例代码,该代码使用Node.js编写,用于读取上传的gzip压缩文件,然后进行解压缩并处理数据:

```javascript

const fs = require('fs');

const util = require('util');

const gunzip = util.promisify(require('zlib').gunzip);

const readStream = fs.createReadStream('compressed-file.gz');

async function decompressAndProcess() {

try {

const unzipped = await gunzip(readStream);

const data = await util.promisify(unzipped.toArrayBuffer.bind(unzipped))();

// Process the decompressed data

console.log(data);

} catch (error) {

console.error('Error occurred during decompression:', error);

}

}

decompressAndProcess();

```

## 4.3 容器化环境下的gzip应用

### 4.3.1 容器技术对压缩性能的影响

容器化技术如Docker在现代IT架构中的应用越来越广泛。容器化环境提供了一种轻量级的虚拟化方式,可以将应用程序及其依赖打包到一个可移植的容器镜像中。由于容器镜像可以被压缩以节省存储空间和传输时间,因此,gzip等压缩技术在容器化环境中发挥着重要作用。

容器镜像在构建时可以使用gzip进行压缩,从而减小了镜像的大小。当镜像需要被分发到各个节点时,较小的镜像意味着更快的传输速度和部署效率。在Kubernetes等容器编排平台中,可以配置镜像的压缩和解压缩过程。

然而,容器技术也引入了新的挑战。由于容器运行时环境需要在运行容器之前解压缩镜像,因此,使用过高的压缩级别可能会增加启动时间。在Dockerfile中,可以通过设置`--compress`标志来启用gzip压缩:

```Dockerfile

FROM ubuntu:latest

# 其他指令

RUN docker build --compress -t my-image .

```

### 4.3.2 在Docker和Kubernetes中优化gzip压缩

在Docker和Kubernetes环境中优化gzip压缩,需要考虑容器镜像的构建、分发以及部署。优化策略通常包括:

- **选择合适的压缩级别**:通常,压缩级别在5到7之间可以提供较好的压缩率和解压缩速度的平衡。

- **使用镜像层缓存**:合理设计Dockerfile,利用镜像层缓存可以加快构建速度,并减小镜像大小。

- **分阶段构建**:Docker支持分阶段构建,可以将构建过程分为多个阶段,每个阶段都可以使用不同的基础镜像和压缩策略。

- **利用Kubernetes资源限制**:在Kubernetes中,可以通过设置CPU和内存资源限制来优化gzip压缩过程对资源的使用。

在Kubernetes集群中,可以通过配置Init Containers来在主容器启动之前执行解压缩操作。这种方式可以在主容器启动之前将镜像解压缩到指定路径,然后由主容器进行使用,这样可以避免在主容器运行时进行解压缩操作,从而减少启动时间。

```yaml

apiVersion: v1

kind: Pod

metadata:

name: my-app

spec:

initContainers:

- name: extract-files

image: alpine:latest

command: ['gunzip', '-c', '/path/in/image/file.gz']

volumeMounts:

- name: files-from-image

mountPath: '/path/in/pod'

containers:

- name: my-app-container

image: my-app:latest

volumeMounts:

- name: files-from-image

mountPath: '/path/in/container'

```

以上配置定义了一个Pod,其中包含一个Init Container用于解压缩文件,然后主容器可以使用解压后的文件。

# 5. gzip模块高级功能与编程技巧

## 5.1 编写自定义的gzip压缩过滤器

### 5.1.1 过滤器的工作原理

自定义的gzip压缩过滤器允许用户在压缩过程中修改数据流。过滤器是在数据到达压缩引擎之前和从压缩引擎出来之后进行处理的地方。这样的机制提供了极大的灵活性,让开发者可以处理特定的数据模式,或者应用定制的逻辑,比如数据清洗或数据转换。

过滤器的一个关键特性是它们能够串联使用,这样可以创建更复杂的数据处理流程。一个过滤器可以将数据传递给下一个过滤器,这样就能够在压缩之前和之后进行多阶段处理。过滤器的输出可以是一个简单的字节流,也可以是压缩引擎可以理解的更复杂的结构。

### 5.1.2 实现自定义过滤器的步骤

以下是如何创建一个简单的自定义gzip压缩过滤器的步骤:

1. 定义过滤器逻辑:首先确定过滤器需要完成的任务,比如数据转换、预处理或后处理。

2. 编写过滤器代码:基于确定的逻辑编写过滤器代码。

3. 注册过滤器:将其注册为gzip模块的一部分,以便在压缩过程中使用。

4. 测试过滤器:确保过滤器按照预期工作,并在各种输入下进行测试。

```python

import gzip

class CustomFilter:

def compress(self, data):

# 在数据压缩前处理数据

processed_data = self.preprocess_data(data)

return processed_data

def decompress(self, data):

# 在数据解压后处理数据

processed_data = self.postprocess_data(data)

return processed_data

def preprocess_data(self, data):

# 自定义数据预处理逻辑

return data

def postprocess_data(self, data):

# 自定义数据后处理逻辑

return data

# 注册过滤器

gzip_filter = CustomFilter()

gzip.register_compressor(gzip_filter)

```

在上述代码中,我们创建了一个`CustomFilter`类,其中包含了`compress`和`decompress`方法。这个类可以被注册到gzip模块中,以便在实际的数据压缩和解压过程中使用。需要注意的是,过滤器的具体实现需要根据实际需求编写,例如在`preprocess_data`和`postprocess_data`方法中可以加入任何必要的数据处理逻辑。

## 5.2 集成第三方压缩库扩展功能

### 5.2.1 常见的压缩库及其特点

在IT领域,存在着多种压缩库可供选择,它们各有其特点和使用场景。例如,zlib是gzip压缩技术的基础库,它提供了较为通用的压缩和解压功能,适用于多种编程语言和平台。除此之外,还有其他的库例如:

- libzip: 提供了对ZIP格式文件的读写功能。

- LZMA SDK: 提供高压缩比的LZMA算法实现。

- bzip2: 提供bzip2算法的压缩和解压功能,压缩效率高。

这些库通常会提供更强大的功能,如支持更多的压缩算法、更优的压缩率或更快的处理速度。根据应用场景的不同,选择合适的压缩库来集成,可以极大地增强应用的性能和功能。

### 5.2.2 集成第三方库到gzip模块的方法

集成第三方压缩库通常包括以下步骤:

1. 选择合适的库:根据需求和应用场景选择合适的压缩库。

2. 阅读文档:了解库的API和使用方法。

3. 集成库:将库的代码集成到项目中,并与gzip模块对接。

4. 测试:确保集成的库能够在项目中正常工作,并进行性能和稳定性测试。

```python

import my_custom_library

def integrate_third_party_library():

# 配置第三方库参数

library_config = my_custom_library.Config()

# 初始化第三方库

third_party压库实例 = my_custom_library.Library(library_config)

# 注册第三方库到gzip模块

gzip.register_compressor(third_party压库实例)

```

在上述代码中,我们假设`my_custom_library`是一个第三方压缩库,通过调用它的`Config`类来设置参数,然后通过它的`Library`类来创建一个库实例,并最终将这个实例注册到gzip模块。注意,实际代码将依赖于所选择的具体第三方库的API和设计。

## 5.3 高级错误处理与日志记录

### 5.3.1 错误处理的最佳实践

在处理数据压缩时,良好的错误处理机制是必不可少的。这能保证在遇到问题时能够及时响应并采取适当的措施。以下是一些最佳实践:

- 使用异常捕获:确保能够捕获到所有可能的异常,并提供有用的错误信息。

- 避免隐藏异常:不要在错误处理代码中隐藏异常信息,而是要让异常浮出水面,或者至少记录足够的信息供后续分析。

- 自定义错误:根据具体的应用场景,创建自定义的错误代码和消息,以提供更精确的错误信息。

### 5.3.2 日志记录在故障排查中的应用

日志记录是故障排查的关键工具之一。在压缩和解压的过程中,应该记录关键的信息,例如:

- 压缩前后的文件大小。

- 压缩所用的时间。

- 发生的任何错误和异常。

下面是一个简单的日志记录示例:

```python

import logging

def configure_logging():

logging.basicConfig(level=***, format='%(asctime)s - %(levelname)s - %(message)s')

***("Log system initialized.")

def log_compression_process(input_file, output_file):

***(f"Compressing file {input_file} to {output_file}")

try:

# 压缩文件的代码

except Exception as e:

logging.error(f"Error occurred during compression: {str(e)}")

raise

configure_logging()

log_compression_process("large_file.txt", "large_file.gz")

```

在上述代码中,我们配置了日志系统,定义了日志的级别和格式。然后我们定义了一个函数来记录压缩过程中的关键信息。在实际应用中,应该根据需要增加更多的日志记录点,特别是在处理大型文件或需要详细错误信息的时候。

通过这些高级功能和编程技巧,开发者可以极大地提升gzip模块的灵活性和功能性,满足特定的应用需求和优化场景。

# 6. gzip的未来趋势与挑战

随着信息技术的快速发展和数据量的爆炸式增长,数据压缩技术正面临着前所未有的挑战和机遇。gzip作为互联网上广泛使用的数据压缩工具之一,其未来的发展趋势和面临的挑战自然成为了业界关注的焦点。

## 6.1 新兴压缩技术的比较与分析

在互联网的长期发展中,多种新兴压缩技术应运而生,如zstandard(zstd)和Brotli。它们在某些场景中提供了比gzip更好的压缩率和速度。

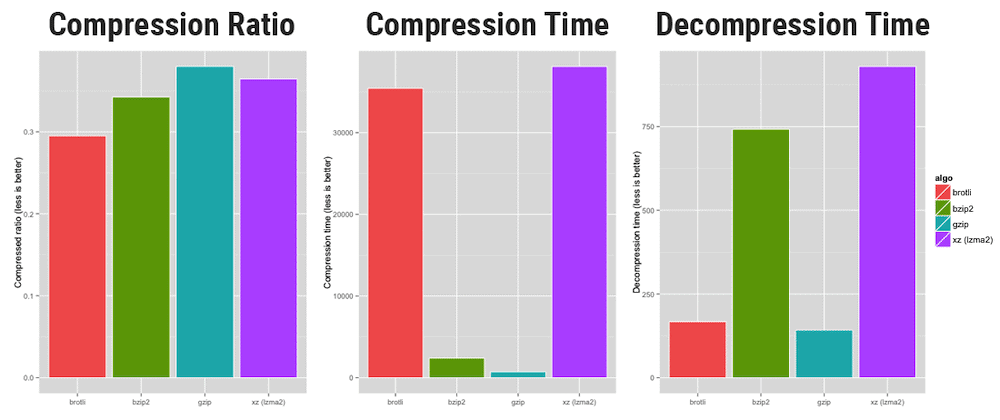

### 6.1.1 gzip与新压缩格式(如zstd, brotli)的对比

- **压缩率**: 通常情况下,zstd和Brotli能够提供比gzip更好的压缩率,尤其是在相同压缩级别下。这使得它们在存储和网络传输方面更为高效。

- **速度**: 在解压缩速度上,Brotli和zstd也表现优异,部分是因为它们采用了更为先进的压缩算法和优化技术。

### 6.1.2 新技术在不同应用场景下的优劣分析

- **Web传输**: 对于Web内容的压缩传输,Brotli已经成为许多浏览器和服务器支持的首选压缩方法。其较高的压缩效率对改善用户浏览体验尤为重要。

- **文件存储**: 对于文件存储压缩,zstd提供了非常灵活的压缩级别,允许用户在压缩率和速度之间做出更细致的选择。

## 6.2 面向未来的大数据压缩挑战

大数据时代对压缩技术提出了更高的要求。面对TB级别甚至PB级别的数据集,传统的压缩方法已经显得力不从心。

### 6.2.1 随着数据量增大面临的问题

- **存储成本**: 巨大的数据量导致存储成本直线上升,压缩技术可以有效降低存储空间的需求,从而节约成本。

- **处理速度**: 数据量增大还会影响数据处理速度,包括压缩和解压缩的过程。传统压缩算法往往难以满足实时或近实时处理的需求。

### 6.2.2 应对大数据趋势的压缩技术展望

- **分而治之**: 采用分块压缩技术能够应对大数据压缩需求,通过将大数据集分成多个块,分别进行压缩处理。

- **并行处理**: 通过并行压缩算法,利用多核CPU进行数据压缩处理,大大加快压缩速度。

## 6.3 安全性考量与隐私保护

随着压缩技术的应用越来越广泛,数据在压缩过程中的安全性和隐私保护也变得尤为重要。

### 6.3.1 压缩过程中的数据安全问题

- **信息泄露**: 不当的压缩策略可能会导致敏感信息无意中被暴露,比如通过压缩日志文件时。

- **完整性**: 在压缩和传输数据时,确保数据的完整性和一致性,防止数据被篡改。

### 6.3.2 加密压缩技术的发展与应用前景

- **加密压缩**: 结合加密技术的压缩方法能够同时保护数据安全和节省存储空间,例如使用SSL/TLS加密的同时进行gzip压缩。

- **隐私保护**: 使用零知识加密等高级加密技术,确保数据在压缩传输过程中不暴露给不信任的第三方。

随着技术的不断进步,未来gzip与其他新兴压缩技术之间的竞争将持续加剧。而数据安全和隐私保护的需求增加,也必将推动压缩技术向着更加安全、高效的方向发展。

0

0