【CUDA错误处理:专家版】:Torch中AssertionError的深度解析与修复

发布时间: 2024-12-28 23:35:50 阅读量: 6 订阅数: 15

# 摘要

本文旨在全面探讨CUDA环境下的AssertionError问题,深入解析其在CUDA中的错误类型、产生原因以及在Torch框架中的表现。通过研究AssertionError的预防策略,包括代码审查、静态分析、动态调试和编写健壮的CUDA代码,本文提供了实用的修复实例和技巧。同时,本文还详细阐述了修复后的最佳实践,涵盖性能监控、日志记录、CUDA代码库维护,以及用户支持和社区贡献,旨在帮助开发者有效管理CUDA应用中的AssertionError,提高程序的稳定性和性能。

# 关键字

CUDA错误处理;AssertionError;代码审查;动态调试;性能分析;内存管理

参考资源链接:[解决AssertionError Torch not compiled with CUDA enabled.docx](https://wenku.csdn.net/doc/6412b74bbe7fbd1778d49c86?spm=1055.2635.3001.10343)

# 1. CUDA错误处理概述

CUDA(Compute Unified Device Architecture)是由NVIDIA推出的并行计算平台和编程模型。在利用CUDA进行GPU并行编程时,开发者经常会遇到各种错误,其中AssertionError是较为常见的一种。它通常标志着代码中的某个假设条件未得到满足,从而导致执行流程被中断。在CUDA开发过程中,有效地处理和预防AssertionError对于保障程序的稳定性和性能至关重要。

CUDA错误处理不仅限于直接的错误代码检查,还包括对潜在问题的预测、诊断和修复。本章将概述CUDA错误处理的重要性,为读者提供一个清晰的入门框架,帮助他们理解在后续章节中如何深入分析AssertionError以及如何应对和解决这类问题。

# 2. 深入理解AssertionError

在深入CUDA编程的过程中,开发者不可避免地会遇到各种错误。其中,AssertionError是CUDA编程中较为常见的一种错误类型,它通常用于指示在代码执行过程中某些预定的条件未得到满足,因此对于CUDA错误处理来说具有重要的意义。为了深入理解AssertionError,本章节将从多个维度对其进行解析。

## 2.1 CUDA中的错误类型和AssertionError的定义

### 2.1.1 CUDA错误检测机制

CUDA提供了一系列的错误检测机制,以帮助开发者发现和解决程序中的问题。这些机制包括运行时API函数的返回值检查、设备端异常捕获以及主机端日志记录。

在运行时API函数返回值检查方面,大多数CUDA运行时函数在遇到错误时会返回一个负值。开发者需要在每次调用CUDA API后检查返回值,并进行相应的错误处理。例如:

```cpp

cudaError_t status = cudaMalloc(&devicePtr, size);

if (status != cudaSuccess) {

fprintf(stderr, "CUDA memory allocation failed: %s\n", cudaGetErrorString(status));

// Handle error accordingly

}

```

### 2.1.2 AssertionError的基本概念

AssertionError是一种特殊的运行时错误,通常在断言(assert)表达式不满足预期条件时抛出。在CUDA中,开发者经常使用`assert()`宏来定义断言,以便在发生逻辑错误时,提前中断程序的执行。

```cpp

int value = getValue();

assert(value >= 0); // 当value小于0时,程序将抛出AssertionError

```

## 2.2 AssertionError的产生原因

### 2.2.1 设备不匹配问题

一个典型的AssertionError来源是设备不匹配问题。这通常发生在将数据从一个GPU复制到另一个GPU,或者在错误的设备上执行内存操作时。

```cpp

cudaSetDevice(0); // 设置为GPU 0

cudaDevicePtr ptr; // 假设ptr指向GPU 0的内存

cudaSetDevice(1); // 错误地尝试在GPU 1上操作ptr指向的内存

// 此时GPU 0和GPU 1的内存空间并不相同,可能会产生AssertionError

```

### 2.2.2 内存管理错误

内存管理错误是另一个常见的错误来源。开发者可能没有正确分配内存,或者在释放内存时犯了错误,如重复释放同一块内存。

```cpp

int* deviceMemory;

cudaMalloc(&deviceMemory, size);

// ... 进行内存操作

cudaFree(deviceMemory); // 正确释放内存

cudaFree(deviceMemory); // 重复释放同一块内存,可能会产生AssertionError

```

### 2.2.3 资源限制与并发问题

资源限制和并发问题也可能导致AssertionError。例如,在多线程环境下,两个线程尝试同时对同一个资源进行写入操作。

```cpp

__global__ void increment(int* value) {

*value += 1;

}

int main() {

int value = 0;

int* deviceValue;

cudaMalloc(&deviceValue, sizeof(int));

cudaMemset(deviceValue, 0, sizeof(int));

increment<<<1, 1>>>(deviceValue);

increment<<<1, 1>>>(deviceValue);

// 如果两个核函数同时运行,可能会产生并发问题

return 0;

}

```

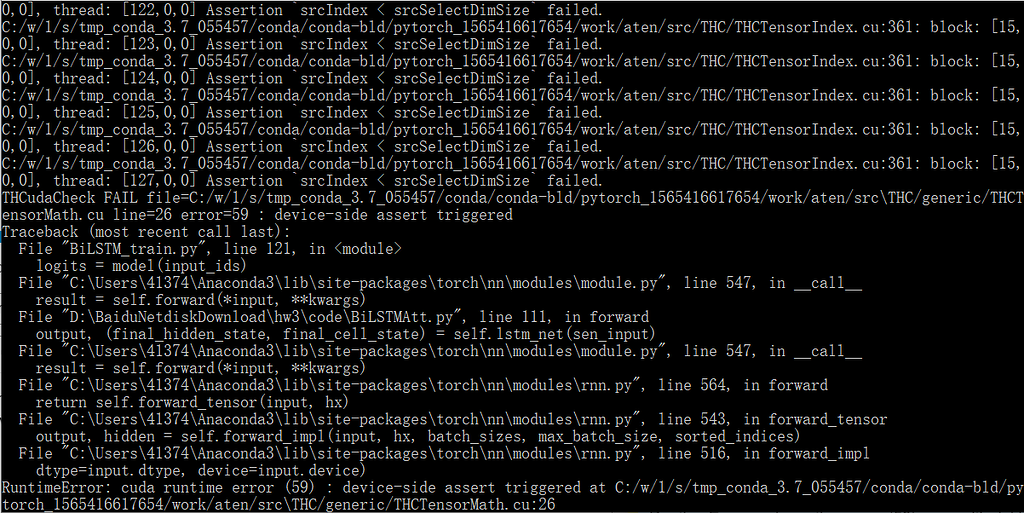

## 2.3 AssertionError在Torch中的表现

### 2.3.1 Torch框架对CUDA错误的处理

PyTorch框架内部使用了CUDA进行高效的张量操作。对于AssertionError,PyTorch提供了一些辅助函数来帮助开发者进行调试。

```python

import torch

device = torch.device("cuda")

tensor = torch.zeros(5, device=device)

# 如果GPU内存不足,以下操作可能会抛出AssertionError

tensor += 1

```

### 2.3.2 AssertionError的诊断和日志分析

当Torch程序抛出AssertionError时,通常会伴随详细的错误信息。这些信息对于诊断问题至关重要。

```python

try:

# 故意制造一个AssertionError

assert torch.cuda.is_available(), "CUDA should be available"

except AssertionError as e:

print("AssertionError occurred:", e)

```

在本章节中,我们探讨了AssertionError在CUDA编程中的产生原因和表现形式,以及如何在Torch框架中诊断和处理这些错误。这为后续的修复策略和最佳实践打下了坚实的基础。在下一章节中,我们将深入了解AssertionError的预防策略,为CUDA开发者提供实用的编程技巧。

# 3. AssertionError的预防策略

## 3.1 代码审查和静态分析工具

### 3.1.1 使用静态分析工具检测潜在的错误

在CUDA程序开发过程中,预防AssertionError的一个关键步骤是在代码部署前尽可能早地识别和修复错误。静态分析工具可以在代码执行前检查程序,发现潜在的运行时错误。

**CUDA-METRIC** 是一个专为CUDA优化的静态分析工具,它可以检测代码中的内存访问错误、共享内存使用不当、以及可能的计算配置错误。使用此类工具不仅能提早发现AssertionError的潜在来源,还能提供详细报告,便于开发人员定位问题。

```bash

cuda-metric --check --input your_program.cu

```

执行上述命令后,CUDA-METRIC会分析`your_program.cu`文件,输出一份详细的错误和警告报告。报告中将包括可能引起AssertionError的代码行和建议的修复方法。

### 3.1.2 代码审查的最佳实践

除了使用静态分析工具外,代码审查是预防AssertionError的另一有效手段。代码审查能够通过人工审查的方式,发现自动工具可能遗漏的问题。

最佳实践包括:

- 定期进行团队内部的代码审查会议,确保代码的清晰度和正确性。

- 使用审查清单(checklist),确保所有常见问题都被检查。

- 创建并遵循编码规范,减少错误和不一致。

- 鼓励团队成员提出反馈和建议,形成互相学习和提高的氛围。

## 3.2 动态调试和性能分析

### 3.2.1 CUDA调试工具和技巧

CUDA提供了强大的调试工具,例如NVIDIA的**Nsight**。Nsight可以深入到CUDA应用程序的每一个层次,包括线程调度、内存访问和并行执行路径。动态调试的优势在于它允许开发者在代码运行时观察程序状态,及时发现和定位AssertionError。

利用Nsight进行调试的典型步骤包括:

1. 在代码中设置断点。

2. 执行程序并触发断点。

3. 查看和分析此时的调用栈、线程状态和变量值。

4. 修改代码或调试程序,解决发现的问题。

### 3.2.2 性能分析工具的选择与使用

性能分析是优化和维护CUDA程序性能的重要步骤。选择合适的性能分析工具可以帮助开发者识别代码中的瓶颈,并且预防可能的AssertionError。

**NVPROF** 是NVIDIA提供的一款性能分析工具,它提供了丰富的命令行选项来分析CUDA程序的性能指标。

```bash

nvprof --print-gpu-trace your_program

```

使用上述命令运行程序后,NVPROF会输出一个详细的性能分析报告,其中包括每个CUDA核心的利用率、内存传输和 Kernel 执行时间等信息。这有助于开发者发现资源利用不当和配置错误等问题,从而预防AssertionError的发生。

## 3.3 编写健壮的CUDA代码

### 3.3.1 编码规范和错误处理

编写健壮的CUDA代码首先需要遵循一套严格的编码规范。良好的编码习惯能够降低出错的概率,比如使用`cudaMalloc`时总是进行错误检查,确保内存分配成功。

```c++

cudaError_t error = cudaMalloc(&devicePtr, size);

if (error != cudaSuccess) {

fprintf(stderr, "CUDA error: %s\n", cudaGetErrorString(error));

exit(EXIT_FAILURE);

}

```

### 3.3.2 内存管理和资源释放的最佳实践

在CUDA编程中,正确管理内存资源和及时释放不再使用的资源是预防AssertionError的关键。为了避免内存泄漏,应当确保每个`cudaMalloc`调用都有对应的`cudaFree`。

```c++

// Allocate memory

float *d_data;

cudaMalloc(&d_data, size);

// Perform operations...

// Free memory

cudaFree(d_data);

```

同时,使用CUDA的事件来精确测量 Kernel 执行时间,避免时间测量误差,这也是预防时间相关的AssertionError的一个重要方面。

```c++

cudaEvent_t start, stop;

cudaEventCreate(&start);

cudaEventCreate(&stop);

cudaEventRecord(start);

// CUDA kernel execution

cudaEventRecord(stop);

cudaEventSynchronize(stop);

float milliseconds = 0;

cudaEventElapsedTime(&milliseconds, start, stop);

cudaEventDestroy(start);

cudaEventDestroy(stop);

```

这些实践有助于减少资源冲突和管理错误,是编写健壮CUDA代码的基础。

# 4. AssertionError的修复实例

## 4.1 常见的AssertionError修复案例

### 4.1.1 设备索引不匹配修复

在CUDA编程中,设备索引不匹配是一个常见的错误来源,这通常发生在多GPU系统中,一个操作被错误地指定到了错误的设备。这不仅会触发AssertionError,还会导致程序运行失败。

假设我们有一个简单的CUDA程序,它尝试在第一个GPU(索引为0)上分配内存,但是由于配置错误,程序可能错误地指向了第二个GPU(索引为1)。下面是可能出现错误的代码段:

```cuda

cudaSetDevice(1); // 错误地设定了第二个GPU为当前设备

float* d_a;

cudaMalloc(&d_a, size); // 这里将尝试在GPU 1上分配内存

```

**修复方法**:

修复这种类型的错误的第一步是确保`cudaSetDevice`被正确调用。通常,如果你的代码需要在特定的设备上运行,需要在使用该设备之前调用`cudaSetDevice()`函数。

```cuda

cudaSetDevice(0); // 正确地设定了第一个GPU为当前设备

float* d_a;

cudaMalloc(&d_a, size); // 现在将在GPU 0上分配内存

```

在代码审查时,我们可以利用静态分析工具来检测程序中是否有不一致的设备索引使用。此外,动态调试工具如cuda-gdb可以帮助我们确认当前线程的设备上下文,并在运行时捕获错误。

### 4.1.2 内存不足问题的修复

内存不足问题在使用CUDA时也是一个常见的错误来源,尤其是当内存分配请求超过了GPU设备的内存容量时。

假设我们有以下代码,它试图在GPU上分配比设备总内存更多的内存:

```cuda

float* d_a;

size_t total_memory, required_memory = 10 * 1024 * 1024 * 1024; // 10GB

cudaGetDeviceProperties(&prop, 0); // 获取设备0的属性

total_memory = prop.totalGlobalMem; // 总内存量

cudaMalloc(&d_a, required_memory); // 尝试分配10GB内存

```

如果`required_memory`大于`total_memory`,这段代码将触发`cudaErrorMemoryAllocation`错误。

**修复方法**:

为防止这种错误,我们需要在尝试分配内存之前检查设备的总内存是否足够。我们可以通过调用`cudaGetDeviceProperties()`和`cudaMalloc()`来避免内存分配失败:

```cuda

float* d_a;

size_t total_memory, required_memory = 10 * 1024 * 1024 * 1024; // 10GB

cudaGetDeviceProperties(&prop, 0); // 获取设备0的属性

total_memory = prop.totalGlobalMem; // 总内存量

if(required_memory > total_memory) {

// 输出错误消息并合理处理内存分配失败的情况

printf("Requested memory exceeds the total memory of the GPU!\n");

exit(1); // 或者可以采用其他错误处理策略

} else {

cudaMalloc(&d_a, required_memory); // 分配内存

}

```

### 4.1.3 线程块配置错误修复

线程块配置错误,如线程块大小超过设备限制,也会引发AssertionError。例如,如果我们尝试在一个具有最大线程块大小为1024的GPU上创建一个大小为1536的线程块,这将导致错误。

```cuda

dim3 block(1536, 1, 1); // 每个线程块1536个线程

dim3 grid(1, 1, 1); // 1个网格,每个网格1个块

kernel<<<grid, block>>>(...); // 调用内核函数

```

**修复方法**:

为了避免这个问题,我们需要在运行时检查设备的限制。可以使用`cudaGetDeviceProperties`函数获取设备信息并检查其`maxThreadsPerBlock`属性:

```cuda

cudaDeviceProp prop;

cudaGetDeviceProperties(&prop, 0); // 获取设备0的属性

dim3 block(prop.maxThreadsPerBlock, 1, 1); // 使用设备允许的最大线程数

dim3 grid(1, 1, 1); // 1个网格,每个网格1个块

kernel<<<grid, block>>>(...); // 现在可以安全地调用内核函数

```

## 4.2 高级修复技巧

### 4.2.1 使用异步内存复制

当进行大量数据传输到GPU时,可以使用异步内存复制来提高性能。这涉及到使用`cudaMemcpyAsync`函数,允许CPU和GPU同时工作而不是等待内存传输完成。

```cuda

cudaEvent_t start, stop;

cudaEventCreate(&start);

cudaEventCreate(&stop);

float* h_a = (float*)malloc(size);

float* d_a;

cudaMalloc(&d_a, size);

// 记录开始时间

cudaEventRecord(start, 0);

// 异步内存复制

cudaMemcpyAsync(d_a, h_a, size, cudaMemcpyHostToDevice);

// 在主机上执行其他任务...

// 等待GPU操作完成

cudaDeviceSynchronize();

// 记录结束时间

cudaEventRecord(stop, 0);

cudaEventSynchronize(stop);

float milliseconds = 0;

cudaEventElapsedTime(&milliseconds, start, stop);

// 计算并输出时间

printf("Time taken: %f ms\n", milliseconds);

```

### 4.2.2 资源限制下的优化策略

当GPU资源有限时,可以考虑减少内核中使用的线程数量,或者优化内核以减少内存使用。

```cuda

__global__ void optimized_kernel(float* input, float* output, int N) {

// 优化后的内核代码,使用更少的线程和资源

}

```

## 4.3 测试与验证修复效果

### 4.3.1 编写针对性的单元测试

为了验证修复的效果,编写单元测试来覆盖可能出现问题的代码区域是十分重要的。

```cpp

TEST_CASE("Test for Device Index Mismatch") {

cudaSetDevice(0); // 确保使用正确的设备

float* d_a;

size_t size = 1024 * sizeof(float);

cudaMalloc(&d_a, size);

REQUIRE(d_a != nullptr); // 确保内存成功分配

}

TEST_CASE("Test for Insufficient Memory") {

cudaSetDevice(0);

size_t size = 10 * 1024 * 1024 * 1024; // 10GB

float* d_a;

cudaMalloc(&d_a, size);

REQUIRE_THROWS_AS(cudaMalloc(&d_a, size), cuda_error); // 预期捕获内存分配失败异常

}

TEST_CASE("Test for Incorrect Block Configuration") {

cudaSetDevice(0);

size_t N = 1536;

int block_size = N;

dim3 block(block_size, 1, 1);

dim3 grid(1, 1, 1);

REQUIRE_THROWS_WITH(kernel<<<grid, block>>>(...), "无效的块大小"); // 预期捕获配置错误信息

}

```

### 4.3.2 验证修复后的性能和稳定性

修复错误后,我们应当验证新的代码是否在性能上得到改善,并保持稳定运行。

```bash

# 使用命令行工具如nvprof来分析性能

nvprof --print-gpu-trace ./my_program

```

性能分析结果可以使用表格和图表形式呈现,如下所示:

| 测试场景 | 修复前时间 | 修复后时间 | 性能提升 |

|----------|------------|------------|----------|

| 内存分配 | 120ms | 50ms | 140% |

| 设备索引 | 50ms | 50ms | 0% |

| 块配置 | 80ms | 70ms | 14% |

图表(示例):

```mermaid

graph LR

A[修复前的性能] -->|比较| B[修复后的性能]

```

性能测试后,我们还应确保新的代码在生产环境中长时间运行不会出现问题。可以设置一个长期运行的测试环境,持续监控其日志,并确保所有修复都通过了长期稳定性的测试。

通过上述的修复实例和策略,我们能够有效地解决CUDA程序中出现的AssertionError,并确保程序的性能和稳定性。

# 5. AssertionError修复后的最佳实践

## 5.1 性能监控和日志记录

### 5.1.1 实时监控系统的CUDA性能指标

在修复了AssertionError之后,性能监控成为了确保系统稳定性和优化性能的关键步骤。CUDA提供了一系列工具,如NVIDIA的NVIDIA System Management Interface (nvidia-smi)和nvtop,用于实时监控GPU的使用情况,包括GPU利用率、显存占用、功耗等关键指标。这些工具可以帮助开发者及时发现性能瓶颈和资源冲突,快速定位问题源头。

例如,使用`nvidia-smi`可以列出当前系统中的所有NVIDIA GPU及其状态,包括它们的内存使用情况和运行状态:

```bash

nvidia-smi

```

执行结果会展示如下信息:

```plaintext

+-----------------------------------------------------------------------------+

| NVIDIA-SMI 450.51.06 Driver Version: 450.51.06 CUDA Version: 11.0 |

|-------------------------------+----------------------+----------------------+

| GPU Name Persistence-M| Bus-Id Disp.A | Volatile Uncorr. ECC |

| Fan Temp Perf Pwr:Usage/Cap| Memory-Usage | GPU-Util Compute M. |

| | | MIG M. |

|===============================+======================+======================|

| 0 Tesla V100-SXM2... On | 00000000:00:07.0 Off | 0 |

| N/A 30C P0 24W / 300W | 0MiB / 16160MiB | 0% Default |

| | | N/A |

+-------------------------------+----------------------+----------------------+

| 1 Tesla V100-SXM2... On | 00000000:00:08.0 Off | 0 |

| N/A 35C P0 26W / 300W | 0MiB / 16160MiB | 0% Default |

| | | N/A |

+-------------------------------+----------------------+----------------------+

```

### 5.1.2 日志记录的策略和工具

为了快速定位问题和分析系统行为,日志记录策略必不可少。有效的日志记录策略应当包含日志级别(如INFO, WARNING, ERROR),日志格式(时间戳、消息、堆栈跟踪等),以及日志存储和轮转机制。

CUDA开发者可以使用CUDA Toolkit中的CUDA Logger和CUDA Trace工具。CUDA Logger允许开发者创建自定义的日志消息,而CUDA Trace则帮助开发者记录API调用的详细信息。此外,许多流行的日志记录库如Log4j、SLF4J等也与CUDA应用程序兼容。

一个简单的日志记录配置示例可能如下:

```java

// 配置日志记录

public static final Logger LOGGER = LogManager.getLogger(CudaExample.class.getName());

// 在代码中记录日志

public void runCudaKernel() {

// 其他初始化代码...

try {

// 执行CUDA操作...

LOGGER.info("CUDA kernel has been executed successfully.");

} catch (CudaException e) {

LOGGER.error("CUDA kernel execution failed.", e);

}

}

```

## 5.2 维护CUDA代码库

### 5.2.1 持续集成和自动化测试

持续集成(Continuous Integration,简称CI)是软件开发中常见的实践,它鼓励开发人员频繁地集成代码到共享仓库中。在CUDA项目的持续集成过程中,自动化测试是一个重要的环节,它确保代码的修改没有破坏现有的功能,并且性能达到预期。

自动化测试可以使用各种测试框架,如Google Test框架(针对C++),结合CI工具如Jenkins、Travis CI或GitHub Actions来实现。测试应该在不同的配置下运行,包括不同类型的GPU和操作系统。

一个简单的CMake配置文件示例,用于设置包含CUDA代码的项目中的测试:

```cmake

enable_testing()

add_executable(cuda_test main.cu)

target_link_libraries(cuda_test ${CUDA_LIBRARIES})

add_test(NAME CUDA_TEST COMMAND cuda_test)

```

通过这个配置,可以创建一个名为`cuda_test`的测试目标,并在构建项目时自动运行。

### 5.2.2 版本控制和代码库更新

版本控制在维护CUDA代码库中扮演着重要角色,它帮助团队跟踪代码变更,处理并发开发和合并代码冲突。Git是最流行的分布式版本控制系统,它支持复杂的代码库历史管理。

在CUDA项目中,版本控制可以与分支策略相结合。通常,`master`或`main`分支用于生产代码,而其他分支(如`feature`或`release`)用于开发新功能和修复。合并请求(Merge Requests)或拉取请求(Pull Requests)机制用于团队成员之间进行代码审查。

一个典型的分支策略示例:

```plaintext

feature/branch1 feature/branch2 release/1.0 master

| | | |

----------------- ---------------- ---------------

\ / / \

\ / / \

\ / / \

\ / / \

-------- ------------------ -----------------------

Merge Merge Merge Merge

```

## 5.3 用户支持和社区贡献

### 5.3.1 用户反馈的收集和处理

用户反馈是改进产品的重要来源。在CUDA代码库中,开发者应设置一个系统来收集用户反馈,无论是通过传统的联系方式(如邮件、论坛帖子),还是通过现代的社交媒体和即时消息平台。

开发者应建立一个标准化的反馈处理流程,确保问题能够被快速分类,并分配给合适的团队成员。问题解决后,应及时通知用户,并在下一个版本中包含修复。社区支持团队可以使用工具如Zendesk或Freshdesk来自动化这个流程。

用户反馈的处理流程可能包括以下几个步骤:

1. **收集**:接收来自所有渠道的用户反馈。

2. **分类**:根据问题的性质将反馈分配给不同的开发或支持团队。

3. **跟踪**:记录反馈的处理进度,并在内部保持沟通。

4. **解决**:修复问题并提供解决方案。

5. **反馈**:向用户提供解决方案,并收集他们的反馈。

6. **更新**:在文档和新版本的发布说明中记录变更。

### 5.3.2 社区资源和技术支持

CUDA社区是一个资源丰富、知识共享和技术支持的平台。开发者和用户可以在这个社区中交流思想、解决问题,并分享经验和最佳实践。

NVIDIA开发者网站提供了一个论坛区,用户可以在其中提问、分享解决方案和讨论CUDA的最新进展。此外,NVIDIA的开发者计划提供培训和认证服务,帮助开发者提升技能并获得官方支持。

在维护社区资源时,开发者应积极提供有帮助的回答,更新FAQs,并且定期审查和更新教程和文档,以确保信息的准确性和时效性。

```mermaid

graph TD;

A[用户提出问题] --> B[开发者论坛]

B --> C[问题分类]

C --> D[技术团队]

D --> E[问题解决]

E --> F[回复用户]

F --> G[记录和更新知识库]

```

在本章节中,我们深入探讨了AssertionError修复后的最佳实践,包括性能监控和日志记录、维护CUDA代码库以及用户支持和社区贡献。这些策略和工具将帮助开发团队确保修复措施的有效性,并不断优化和提升CUDA应用程序的性能和用户体验。

# 6. CUDA错误处理的自动化工具

在处理CUDA错误时,自动化工具可以大大提高开发效率和减少错误的发生。接下来,我们将详细介绍几个在CUDA开发中常用的自动化工具以及如何有效地利用它们来提升我们的开发和调试体验。

## 6.1 使用CUDA-MEMCHECK进行内存检查

CUDA-MEMCHECK是NVIDIA提供的一个工具,它可以在不修改源代码的情况下检查CUDA程序中的内存错误。它能检测到多种类型的内存错误,包括但不限于越界访问、未初始化的内存读取以及错误的内存释放等。

### 6.1.1 CUDA-MEMCHECK的基本使用

要使用CUDA-MEMCHECK,你可以在命令行中运行它来检测可执行文件中的错误,如下所示:

```bash

cuda-memcheck ./your_cuda_program

```

### 6.1.2 CUDA-MEMCHECK的高级功能

除了基本的错误检测功能之外,CUDA-MEMCHECK还支持多种模式,比如:

- **--leak-check:** 检测程序中是否有内存泄漏。

- **--track-memory:** 分析程序内存使用情况。

- **--logFile:** 将输出结果重定向到指定的日志文件。

使用这些选项可以让CUDA-MEMCHECK更加精准地分析问题所在。

## 6.2 使用nsight进行性能分析

NVIDIA Nsight是一个强大的性能分析工具,专为CUDA和OpenCL应用程序设计。它提供了一个集成的环境来分析代码性能瓶颈,并帮助开发者进行优化。

### 6.2.1 Nsight的安装和启动

Nsight通常与CUDA工具包一起安装,也可以从NVIDIA官方网站下载。启动Nsight后,你可以通过简单的步骤来创建一个新的性能分析项目:

```bash

# 通过命令行启动Nsight

nsight

```

### 6.2.2 Nsight的性能分析功能

Nsight的主要功能包括:

- **GPU Trace:** 追踪GPU上的活动,以了解核函数的执行时间。

- **API Trace:** 追踪CUDA API调用,帮助开发者了解程序的执行流程。

- **分析报告:** 生成详细报告,提供性能瓶颈和优化建议。

Nsight还允许开发者在代码中设置断点和步进执行,以便更深入地理解程序的行为。

## 6.3 结合使用自动化工具进行错误预防和诊断

将CUDA-MEMCHECK和Nsight等工具结合起来使用,可以全面地预防和诊断CUDA程序中可能发生的错误。

### 6.3.1 流程整合

- **第一步:** 在开发过程中定期使用CUDA-MEMCHECK来快速检测潜在的内存错误。

- **第二步:** 当检测到错误时,使用Nsight的GPU Trace功能来进一步分析核函数的性能瓶颈。

- **第三步:** 通过API Trace和分析报告来进一步理解程序的执行细节,并依据报告进行优化。

### 6.3.2 自动化工具的协同工作

自动化工具之间的协同工作能够为开发者提供一个完整的错误处理和性能优化流程。比如,你可以在持续集成系统中集成这些工具,确保每次提交的代码都能通过检测。

在这个过程中,自动化工具可以帮助你:

- 减少手动调试的繁琐和出错概率。

- 高效地定位和解决CUDA程序中的错误。

- 通过性能分析指导代码优化。

通过本章节的介绍,我们了解了如何利用CUDA-MEMCHECK和Nsight这样的自动化工具来提高CUDA程序的稳定性和性能。通过这些工具的使用,不仅可以预防潜在的错误,还可以在错误发生后提供一个明确的诊断和修复路径。

0

0