【CUDA错误排查秘籍】:Torch中的AssertionError,一网打尽

发布时间: 2024-12-29 00:30:11 阅读量: 7 订阅数: 15

解决AssertionError Torch not compiled with CUDA enabled.docx

# 摘要

随着并行计算和深度学习技术的发展,CUDA编程在高性能计算领域变得日益重要。然而,CUDA程序在开发和运行过程中可能遇到各种错误,其中AssertionError是开发者经常面临的挑战之一。本文旨在提供一个系统的CUDA错误排查知识体系,涵盖基础知识、错误分析、预防措施、实践技巧以及高级排查技术。通过对AssertionError的定义、错误信息解读和常见的错误场景进行深入探讨,本文旨在帮助开发者提高CUDA程序的稳定性和性能,同时提供实际案例分析,以实践指导理论,并探讨如何将社区资源和开源工具应用于错误排查中。

# 关键字

CUDA错误排查;AssertionError;内存管理;性能优化;自动化测试;并行计算

参考资源链接:[解决AssertionError Torch not compiled with CUDA enabled.docx](https://wenku.csdn.net/doc/6412b74bbe7fbd1778d49c86?spm=1055.2635.3001.10343)

# 1. CUDA错误排查基础知识

## CUDA错误排查的重要性

在深度学习和科学计算领域,CUDA(Compute Unified Device Architecture)的应用变得越来越广泛。然而,在CUDA编程中遇到错误几乎是每个开发者都会经历的问题。这些错误可能会导致程序崩溃、性能下降,甚至对硬件造成损害。因此,掌握CUDA错误排查的基础知识,对于确保程序的稳定性和效率至关重要。

## CUDA错误的分类

CUDA错误可以从几个不同的层面进行分类。从错误发生的上下文来看,可以分为环境配置错误、运行时错误和内核执行错误等。环境配置错误通常涉及到硬件兼容性、驱动安装、CUDA Toolkit版本不匹配等问题。运行时错误则包括内存管理错误、资源限制问题等。内核执行错误则更多与计算逻辑和GPU架构相关。

## 排查CUDA错误的基本步骤

排查CUDA错误通常遵循以下基本步骤:

1. **确认CUDA环境配置**:检查CUDA Toolkit、驱动版本,确保与GPU硬件兼容。

2. **仔细阅读错误信息**:CUDA错误信息通常会提供问题的线索,例如是内存不足、无效参数还是内核执行失败。

3. **利用CUDA工具和调试器**:使用如`cuda-memcheck`和`cuda-gdb`等工具进行内存泄漏检测和执行时错误的定位。

掌握以上基础知识,可以在面临CUDA错误时更有针对性地进行排查和解决,为开发高性能的应用打下坚实的基础。

# 2. Torch中的AssertionError分析

## 2.1 AssertionError的定义与出现场景

### 2.1.1 CUDA与Torch基础知识回顾

在深入分析AssertionError之前,我们需要回顾一下CUDA和Torch的基础知识。CUDA(Compute Unified Device Architecture)是由NVIDIA推出的一种通用并行计算架构,它允许开发者利用NVIDIA的GPU进行高性能计算。Torch是一个开源的机器学习库,它为GPU计算提供了广泛的支持,使得开发者可以高效地处理大规模的数据和模型。

CUDA的核心优势在于其并行计算能力,通过GPU的大量核心来加速计算任务。然而,它也带来了编程模型和硬件架构的复杂性,开发者需要处理内存分配、数据传输、线程管理等一系列问题,这些都可能导致程序中出现AssertionError。

### 2.1.2 AssertionError的常见原因

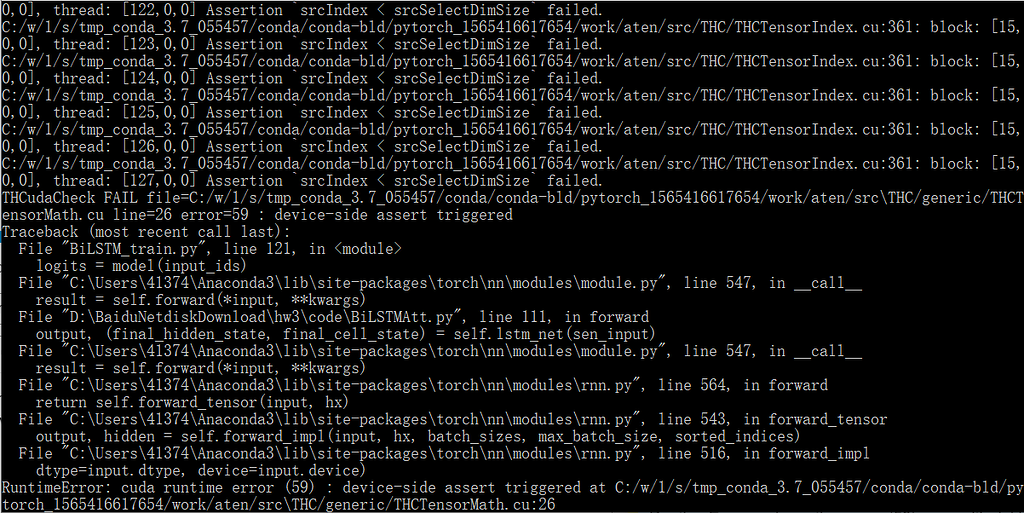

AssertionError在Torch中通常是由于程序运行时某些条件未能满足预期而触发。例如,当对张量的操作不符合预期时,比如维度不匹配、数据类型不正确、索引超出范围等,Torch会抛出AssertionError来指出错误。此外,CUDA内存分配失败、计算资源耗尽或者版本兼容性问题也有可能导致AssertionError的出现。

## 2.2 AssertionError的错误信息解读

### 2.2.1 错误信息的组成与含义

当AssertionError发生时,通常会伴随着详细的错误信息,这些信息是理解问题关键和寻找解决方案的重要线索。一个典型的AssertionError错误信息通常包含以下几个部分:

- 错误类型(AssertionError):明确指出发生了什么类型的错误。

- 错误位置:指出错误发生的源代码文件和行号,这有助于定位问题源头。

- 错误条件:具体说明了哪些条件未被满足,导致了错误的发生。

- 附加信息:可能包括引发错误的张量的具体信息,如形状、数据类型等。

### 2.2.2 根据错误信息定位问题

定位AssertionError问题的关键在于理解错误信息并逐步缩小范围。首先,应该查看错误位置,这是最直接的问题线索。接着,根据错误条件检查相关的代码逻辑,看是否确实存在逻辑错误或配置不当。最后,检查附加信息中的张量信息,确认数据是否符合预期。

## 2.3 AssertionError的预防措施

### 2.3.1 环境配置的正确性检查

预防AssertionError的一个关键步骤是确保环境配置的正确性。这包括但不限于:

- 确保安装了正确版本的CUDA和NVIDIA驱动。

- 验证CUDA Toolkit是否安装完整,并且环境变量是否设置正确。

- 检查Torch是否安装了与CUDA版本兼容的GPU支持版本。

### 2.3.2 代码编写中的最佳实践

在编写代码时,采取最佳实践可以有效预防AssertionError的出现:

- 使用Torch提供的API进行内存管理,确保及时释放不再使用的内存。

- 在进行张量操作时,先验证张量的维度和数据类型是否匹配预期。

- 利用Torch的异常处理机制,在可能抛出AssertionError的地方添加try-except语句,捕获并处理异常。

- 编写单元测试来验证代码的正确性,特别是对数据敏感的操作和复杂逻辑部分。

在下一节中,我们将深入探讨CUDA错误排查实践技巧,这将帮助我们在实际操作中更有效地处理和预防AssertionError。

# 3. CUDA错误排查实践技巧

## 3.1 CUDA环境与工具的检查

### 3.1.1 NVIDIA驱动与CUDA版本的验证

在CUDA开发中,确认NVIDIA驱动和CUDA工具包版本的一致性是至关重要的。一个有效的做法是使用`nvidia-smi`和`nvcc --version`命令来检查GPU驱动的版本和CUDA编译器的版本是否匹配。

```bash

nvidia-smi

nvcc --version

```

以上命令将输出当前系统中NVIDIA驱动程序的版本以及CUDA编译器的版本。如果两者不匹配,可能会导致编译时错误或运行时错误。

### 3.1.2 CUDA Toolkit与环境变量的检查

CUDA Toolkit的安装路径需要被正确地设置为环境变量,以便编译和运行时使用。环境变量`CUDA_HOME`和`PATH`应该指向CUDA Toolkit的安装目录,而`LD_LIBRARY_PATH`应该包含CUDA库文件的路径。这些可以通过以下命令来设置:

```bash

export CUDA_HOME=/usr/local/cuda

export PATH=$CUDA_HOME/bin:$PATH

export LD_LIBRARY_PATH=$CUDA_HOME/lib64:$LD_LIBRARY_PATH

```

## 3.2 内存管理与资源限制

### 3.2.1 内存泄漏的检测方法

内存泄漏是GPU开发中常见的问题。CUDA提

0

0