【CUDA错误处理艺术】:Torch中AssertionError的预防与修复

发布时间: 2024-12-29 00:39:01 阅读量: 11 订阅数: 11

解决AssertionError Torch not compiled with CUDA enabled.docx

# 摘要

本文系统地探讨了CUDA编程中的错误处理重要性、常见的错误类型及其预防策略。首先介绍了CUDA的基本概念、架构和工作原理,接着详细阐述了AssertionError的预防措施和诊断修复方法。文章还提供了CUDA错误处理的最佳实践,包括代码优化、测试验证流程以及如何利用社区资源和技术支持。最后,文章展望了CUDA技术未来的发展趋势和所面临的挑战,如新一代GPU架构适应性及编程模型演进。通过本文的探讨,期望能为CUDA开发者提供一套完整的错误处理方法论,提高并行计算应用的可靠性和效率。

# 关键字

CUDA;错误处理;AssertionError;代码优化;测试与验证;未来发展趋势

参考资源链接:[解决AssertionError Torch not compiled with CUDA enabled.docx](https://wenku.csdn.net/doc/6412b74bbe7fbd1778d49c86?spm=1055.2635.3001.10343)

# 1. CUDA错误处理的必要性

在当今的高性能计算领域中,NVIDIA的CUDA(Compute Unified Device Architecture)技术为开发人员提供了一个强大的并行计算平台。然而,随着CUDA编程的复杂性增加,错误处理成为了开发者不可回避的一个重要环节。正确处理CUDA错误不仅能够保证程序的健壮性和稳定性,还能提高开发效率,减少调试和优化过程中所需的时间和资源。

CUDA错误处理通常包含对API调用返回的错误代码进行检查,以及使用断言(assertions)来捕获预期之外的情况。错误代码检查和断言可以帮助开发者在开发和测试阶段识别和定位问题源头,从而在产品推向市场之前提前修复潜在的bug。

此外,有效的错误处理策略能够确保资源的正确管理,避免资源泄露导致的性能下降或程序崩溃。因此,本章将探讨CUDA错误处理的必要性,并为后续章节中更详细地讨论错误类型和预防、诊断及修复错误方法打下基础。

# 2. CUDA基本概念与错误类型

## 2.1 CUDA架构和工作原理

### 2.1.1 CUDA编程模型概述

CUDA(Compute Unified Device Architecture)是由NVIDIA推出的一种并行计算平台和编程模型,它允许开发者使用NVIDIA的GPU(图形处理单元)进行通用计算,以解决复杂的并行计算问题。CUDA编程模型的核心是其提供了一种方式,通过扩展C语言让开发者可以编写能够在GPU上运行的并行程序。

CUDA编程模型主要包含以下几个关键概念:

- **线程(Thread)**: CUDA程序在GPU上的最小执行单元,每个线程可以执行独立的指令序列。

- **线程块(Block)**: 线程块是由多个线程组成的集合,线程块内的线程可以实现协作执行和快速共享信息。

- **线程格(Grid)**: 线程格是包含多个线程块的结构,整个Grid可以在GPU上分配执行。

在CUDA中,开发者需要编写内核(Kernel)函数,这是一种特殊的函数,它将在GPU上的成千上万个线程中执行。内核函数的编写与C语言函数相似,但需要加`__global__`修饰符来表明它在GPU上运行。此外,CUDA编程模型提供了一套内存层次结构,包括全局内存、共享内存、常量内存和纹理内存等,以供不同类型的内存访问需求。

### 2.1.2 CUDA内存架构

在CUDA内存架构中,不同的内存空间设计用于优化不同层次的性能和共享需求:

- **全局内存**: 是线程之间共享的大型内存区域。尽管全局内存容量大,但是访问速度较慢,并且需要保持内存访问模式的对齐。

- **共享内存**: 每个线程块内部的线程可以访问的较小内存区域。共享内存的访问速度比全局内存快得多,但容量有限,且生命周期短暂,仅在线程块执行期间可用。

- **常量和纹理内存**: 这些是只读内存区域,被所有线程共享,并且通常被缓存以优化访问速度。

了解和合理使用这些内存类型是编写高效CUDA程序的关键。合理的内存访问模式和内存优化策略可以显著提高程序性能。

## 2.2 CUDA常见的错误类型

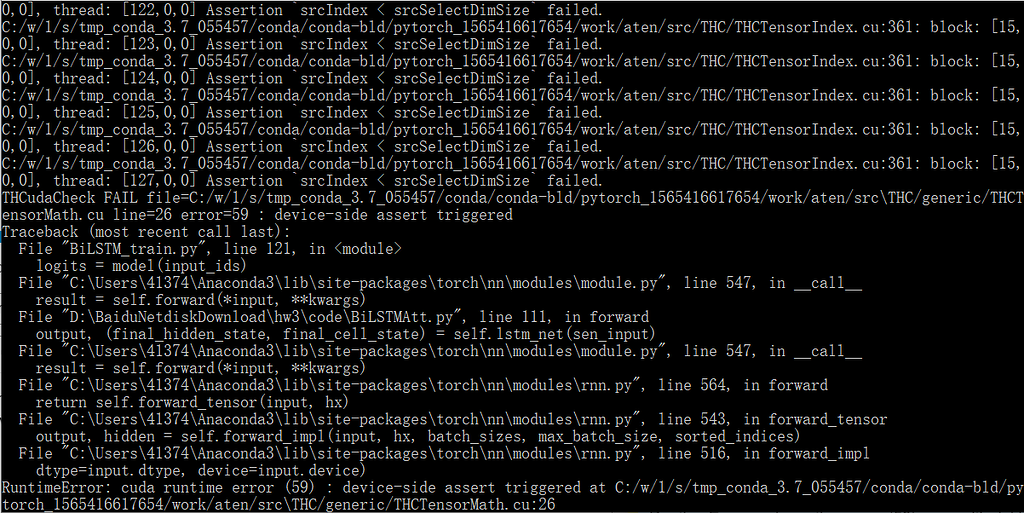

### 2.2.1 设备端错误

设备端错误发生在CUDA代码在GPU上执行过程中,这可能包括:

- **执行错误**: 当内核函数执行时出现错误,例如索引越界,访问违规等问题。

- **硬件错误**: 比如由于硬件损坏或不兼容导致的错误。

这些错误通常需要开发者利用CUDA提供的工具和函数进行调试。

### 2.2.2 资源管理错误

资源管理错误是指因资源分配不当或资源生命周期管理不善导致的问题:

- **内存分配失败**: 比如无法为变量分配足够的GPU内存。

- **资源泄露**: 如未正确释放分配的资源。

资源管理错误需要仔细管理CUDA中的内存分配和释放,确保所有资源在不再需要时被正确释放。

### 2.2.3 运行时错误

运行时错误是程序执行过程中出现的其他类型错误,例如:

- **调用错误**: 比如内核函数调用时指定的线程格大小不正确。

- **上下文错误**: 运行多个CUDA程序时可能发生的上下文冲突。

了解和预防运行时错误需要对CUDA的运行时环境和API有深刻的理解。

以上章节介绍了CUDA架构的基本概念,以及设备端错误、资源管理错误和运行时错误等常见的错误类型。接下来章节将深入探讨如何预防AssertionError,并介绍一些诊断与修复的策略。

# 3. AssertionError的预防策略

AssertionError在CUDA编程中是一种常见但严重的错误,它通常表示程序在运行时遇到了预期之外的条件或不一致的情况。有效的预防策略可以在很大程度上减少AssertionError的发生,从而提升程序的稳定性和可靠性。在设计、编译、运行三个阶段,都可以采取相应的措施来预防这类错误。

## 3.1 设计阶段的预防措施

### 3.1.1 代码静态分析工具

在设计阶段,使用代码静态分析工具是非常有效的预防措施之一。静态分析工具能够在不运行程序的情况下检查源代码,识别可能的逻辑错误、内存泄漏、性能瓶颈等问题。

**代码块示例:**

```sh

$ cuda-metrics analyze source.cu --output report.json

```

**逻辑分析与参数说明:**

`cuda-metrics`是一个假想的命令行工具,用于执行CUDA代码的静态分析。在这里,`source.cu`是要分析的CUDA源文件,`--output report.json`参数指定输出报告的文件路径。执行后会生成一个包含分析结果的JSON文件,开发者可以利用这个报告来识别潜在的代码问题。

### 3.1.2 单元测试和边界条件检查

单元测试是确保代码质量和减少错误的有效手段,特别是在并发和并行计算环境中。在编写CUDA代码时,对每个核心函数和计算核进行单元测试是预防AssertionError的关键。

**代码块示例:**

```python

import pycuda.driver as drv

import pycuda.autoinit

def test_kernel.kernel():

# CUDA kernel code to test

pass

# Initialize and run a simple test kernel

kernel = drv.SourceModule(test_kernel.kernel)

func = kernel.get_function('test_kernel')

func(drv.InOut(data), block=(1,1,1), grid=(1,1))

```

**逻辑分析与参数说明:**

此段Python代码使用PyCUDA库来编译和运行一个简单的CUDA核函数作为测试。这个过程包括初始化GPU驱动、编译源代码,并创建一个可执行的函数对象。这个函数对象被调用以运行在GPU上,以此来验证核心函数的正确性。

## 3.2 编译阶段的预防措施

### 3.2.1 编译器警告的处理

编译器的警告往往指出了潜在的问题,这些警告如果不被重视,可能会在运行时引发错误。因此,开发者应当对编译器的所有警告保持敏感,并尽可能地解决它们。

**代码块示例:**

```sh

$ nvcc -Xcompiler -Wall -o my_program my_program.cu

```

**逻辑分析与参数说明:**

`nvcc`是NVIDIA CUDA编译器的命令行工具,`-Xcompiler -Wall`标志将所有警告视为错误,强制开发者处理这些警告。`-o my_program`指定输出文件的名称,`my_program.cu`是被编译的源文件。这个命令能够确保编译阶段的错误和警告都被识别并处理。

### 3.2.2 CUDA代码优化实践

代码优化不仅是为了提升性能,也有助于提高代码的稳定性。在编译阶段,使用适当的优化标志可以减少运行时错误。

**代码块示例:**

```sh

$ nvcc -O3 -arch=sm_70 -o optimized_program optimized_program.cu

```

**逻辑分析与参数说明:**

这个例子中`-O3`标志启用最高级别的优化,`-arch=sm_70`指定目标GPU架构,这有助于确保编译出的代码能够充分利用目标GPU的特性。优化级别的选择需要平衡性能和稳定性的需求,有些情况下过度优化可能会引入新的问题。

## 3.3 运行时的预防措施

### 3.3.1 错误检查机制的实现

CUDA提供了一套丰富的API来进行错误检查,确保每次API调用都能验证其成功执行。

**代码块示例:**

```c

cudaError_t result;

result = cudaMalloc((void**)&d_array, size);

if (result != cudaSuccess) {

fprintf(stderr, "CUDA Error: %s\n", cudaGetErrorString(result));

exit(EXIT_FAILURE);

}

```

**逻辑分析与参数说明:**

此段C代码演示了如何检查`cudaMalloc`调用的返回值以确认操作是否成功。如果返回值不是`cudaSuccess`,则从`cudaGetErrorString`函数获取错误信息并打印出来,然后程序会立即退出。这是一个防止程序在发生错误时继续运行的良好实践。

### 3.3.2 运行时的资源管理

资源管理是预防运行时错误的关键。在CUDA中,正确地分配和释放设备内存、管理流和事件是避免内存泄漏和资源竞争的重要步骤。

**代码块示例:**

```c

void fre

```

0

0