R语言pam数据包:文本分析与挖掘,入门到精通

发布时间: 2024-11-03 07:32:10 阅读量: 30 订阅数: 32

# 1. R语言与文本分析概述

在信息时代,文本分析成为了数据科学领域中不可或缺的一部分。R语言,作为一种广泛使用的统计编程语言,提供了强大的工具和库来处理和分析文本数据。文本分析允许我们从非结构化的文本信息中提取有价值的信息,例如在社交媒体上分析公众情绪,或在市场调研中识别消费者偏好。

文本分析涉及处理语言学上的各种复杂性,包括词性标注、句法分析、语义理解等。利用R语言的文本分析能力,数据分析人员可以迅速地从大量文本中提炼出这些复杂信息。R语言中特定的数据包,如`tm`(文本挖掘)和`pam`(并行分析方法),提供了专门用于文本分析和处理的功能。

本章将概述R语言在文本分析中的应用,包括其基本原理、文本分析的重要性以及R语言特有的文本分析工具和方法。掌握这些基础知识,为深入学习R语言文本分析奠定坚实的基础。

# 2. R语言pam数据包基础

## 2.1 pam数据包的安装与加载

### 2.1.1 安装pam包的步骤

在R语言中安装pam包是一个简单的过程,可以通过R的包管理器进行。以下是安装pam包的步骤:

1. 打开R控制台或RStudio。

2. 输入以下命令:

```R

install.packages("pam")

```

3. 执行命令后,R会自动从CRAN(综合R档案网络)下载并安装pam包。

这个命令利用了R的内置函数`install.packages`,该函数会检查CRAN中是否有相应的包,然后下载并安装到本地的R环境中。在安装过程中,可能会出现提示,要求选择镜像站点,通常选择离用户地理位置最近的站点以加快下载速度。

### 2.1.2 加载pam包的方法

安装好pam包后,需要在每个R会话中加载它,才能使用其中的功能。加载pam包的命令如下:

```R

library(pam)

```

通过执行`library`函数,R会将安装好的pam包载入到当前的工作环境中,这样就可以开始调用包内的函数了。需要注意的是,加载包时不会有任何输出,除非包中有执行代码,例如,添加了`print`函数的启动脚本。

## 2.2 文本数据的导入与预处理

### 2.2.1 读取不同格式的文本数据

在R语言中,文本数据可能以多种格式存在,如.txt、.csv、.pdf等。每种格式需要使用特定的函数进行读取。以下是读取不同格式文本数据的方法:

1. 对于.txt或.csv文件,可以使用`read.table`或`read.csv`函数:

```R

text_data <- read.csv("data.csv", stringsAsFactors = FALSE)

```

在这里,`read.csv`函数会读取一个CSV文件,并将每行数据转换为数据框(data.frame)中的一个观测。参数`stringsAsFactors`用于设置字符向量是否自动转换为因子,通常在文本分析时,我们希望保持字符格式,因此将其设置为`FALSE`。

2. 对于PDF格式的文件,可以使用`pdftools`包中的`pdf_text`函数:

```R

library(pdftools)

pdf_text <- pdf_text("document.pdf")

```

`pdf_text`函数会从PDF文件中提取文本内容,并将每个页面的文本作为字符串返回。

### 2.2.2 文本清洗和格式转换

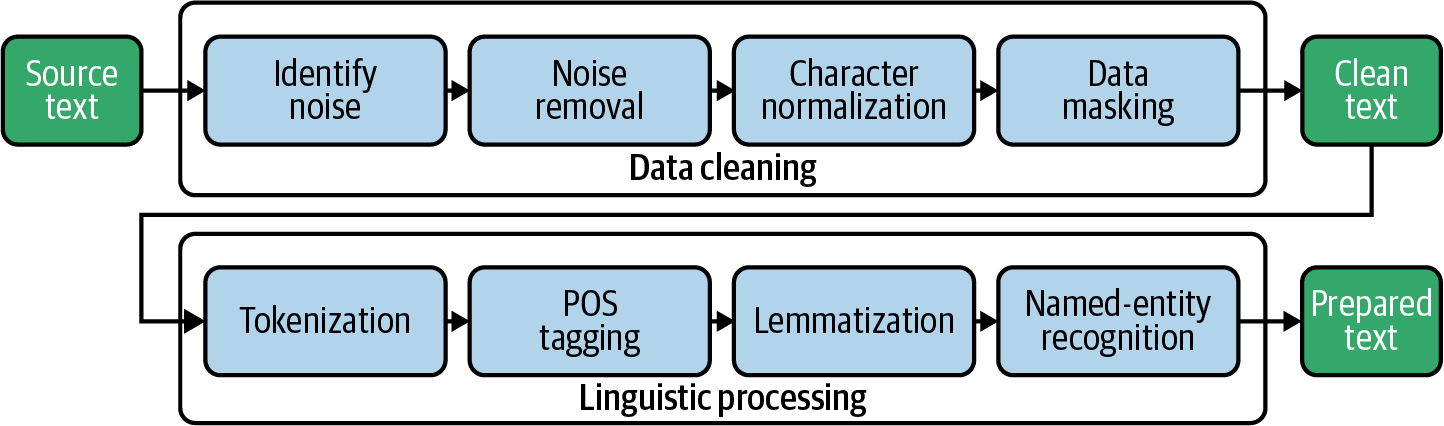

读取文本数据后,接下来是进行文本清洗和格式转换,以便于后续分析。常见的文本清洗步骤包括:

- 移除不必要的字符(如标点符号、数字)

- 将所有文本转换为同一种格式(如全部小写)

- 移除停用词(例如"the", "is", "at"等在语言中频繁出现但很少携带实际意义的词)

- 分词(Tokenization),将句子或段落拆分为单个的词汇单元

在R中,可以结合使用`stringr`包进行字符串操作,以及使用`tm`(Text Mining)包进行文本清洗。以下是一个简单的例子:

```R

library(stringr)

library(tm)

# 创建一个文本语料库对象

corpus <- VCorpus(VectorSource(pdf_text))

# 文本清洗步骤

corpus <- tm_map(corpus, content_transformer(tolower))

corpus <- tm_map(corpus, removePunctuation)

corpus <- tm_map(corpus, removeNumbers)

corpus <- tm_map(corpus, removeWords, stopwords("en"))

corpus <- tm_map(corpus, stripWhitespace)

# 其他清洗步骤...

```

## 2.3 文本数据的探索性分析

### 2.3.1 频率分析

频率分析是文本挖掘中最基础且关键的步骤之一,它涉及计算词汇在文档集合中出现的频率。在R中,可以使用`tm`包的`DocumentTermMatrix`函数来创建一个文档-词项矩阵(DTM),此矩阵可用来进行频率分析:

```R

# 将语料库转换为文档-词项矩阵

dtm <- DocumentTermMatrix(corpus)

# 转换为矩阵格式,便于操作

dtm_matrix <- as.matrix(dtm)

# 计算词项频率

term_frequency <- colSums(dtm_matrix)

# 按频率降序排序

term_frequency <- sort(term_frequency, decreasing = TRUE)

```

在此例中,`DocumentTermMatrix`函数用于生成一个DTM对象,该对象可以用于进一步的分析。`colSums`函数用于计算每列(即每个词项)的总和,即该词项在所有文档中出现的总次数。`sort`函数则用于按频率对词项进行排序。

### 2.3.2 关键词提取

除了频率分析,文本数据的探索性分析还常涉及关键词提取。关键词提取可以用来理解文本的主要内容和主题。一个简单的方法是基于词频,选择频率最高的几个词汇。更复杂的方法可能涉及TF-IDF(词频-逆文档频率)分析,它尝试找出在特定文档中出现频率高,但整体文档集合中出现频率低的词汇。以下是使用TF-IDF进行关键词提取的一个例子:

```R

# 计算TF-IDF矩阵

tfidf_matrix <- as.matrix(TFIDF(dtm))

# 提取关键词

tfidf_terms <- sort(rowSums(tfidf_matrix), decreasing = TRUE)

```

在这里,我们首先使用`TFIDF`函数来计算TF-IDF矩阵,然后对矩阵中的每一行(即每个词项)求和,最后按和的大小进行降序排序,以提取关键词。

以上就是R语言pam数据包基础应用的详尽章节内容,涵盖了从安装和加载数据包、到导入与预处理文本数据,再到探索性分析的各个方面。后续章节将深入探讨文本挖掘技术与实践、高级应用及性能优化等话题。

# 3. 文本挖掘技术与实践

在第二章中,我们已经熟悉了`pam`数据包的安装和加载,以及文本数据的导入与预处理

0

0