深入Jsoup:解析和操作DOM的高级技巧

发布时间: 2024-09-28 16:51:32 阅读量: 125 订阅数: 43

# 1. Jsoup基础介绍

## 1.1 Jsoup简介

Jsoup是一个用于解析HTML的Java库,可以处理各种复杂HTML文档,并能够抽取和操作数据。它支持使用CSS选择器以及其他强大的查询和操作API,十分适用于Web爬虫程序。Jsoup的使用门槛较低,它简化了HTML的解析和数据提取过程,同时提供了强大的API进行DOM操作。

## 1.2 Jsoup与其它库的比较

相较于其他流行的HTML解析库,如HtmlCleaner、JDom等,Jsoup更胜一筹之处在于其轻量级、易用性和高效的解析能力。它不仅能够解析HTML文档,还可以解析通过网络获取的HTML页面,这使得Jsoup成为Web爬虫开发者的首选工具。

## 1.3 Jsoup的应用场景

Jsoup广泛应用于网络爬虫、数据抓取、网页内容的抽取、Web数据处理、网站重构等场景。无论是在Web开发还是数据分析领域,Jsoup都能提供快速而有效的解决方案。它独特的灵活性和易于集成的特性,使其成为处理HTML文档不可或缺的工具。

在接下来的章节中,我们将深入探讨Jsoup的核心API以及它在Web爬虫中的应用和数据解析实战案例。

# 2. Jsoup的核心API解析

## 2.1 文档结构解析

### 2.1.1 解析HTML文档的结构

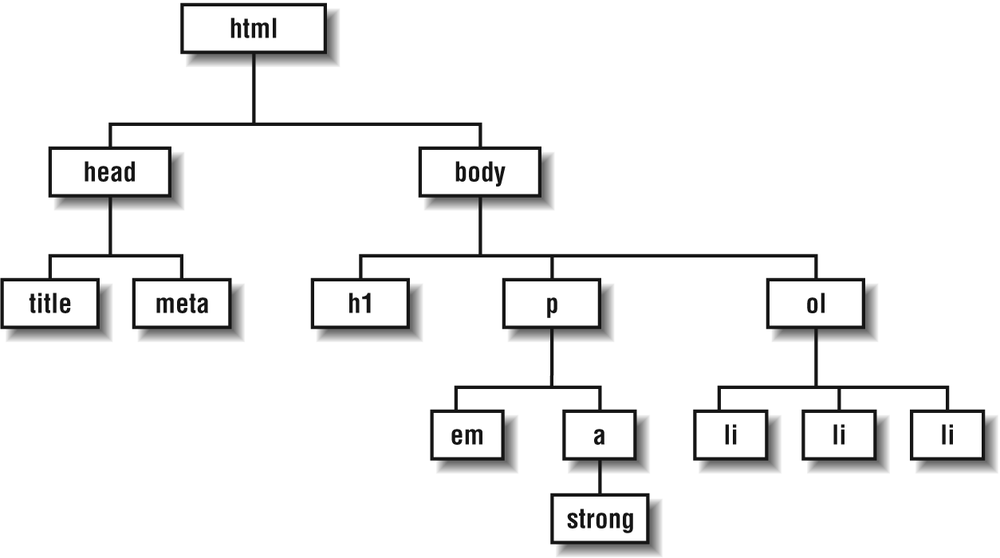

解析HTML文档是Jsoup的核心功能之一。它能够将HTML文档解析为一个树状的结构,这个结构是通过一系列的节点来表示的,包括文档节点、元素节点和文本节点。在解析过程中,Jsoup使用其文档对象模型(DOM)来构建这个树状结构。这个结构使得对HTML文档的查询和操作变得更加容易和直观。

解析过程从一个`Document`对象开始,`Document`对象代表了整个HTML文档。文档中的每一个标签和文本都被解析为一个`Element`对象,而这些`Element`对象构成了`Document`对象的子节点。通过这种方式,Jsoup能够提供方法来查询和操作HTML文档中的各种元素。

解析一个HTML文档的基本代码如下:

```java

String html = "<html><head><title>First parse</title></head>"

+ "<body><p class='myclass'>Hello <b>world!</b></p></body></html>";

Document doc = Jsoup.parse(html);

```

在这段代码中,`Jsoup.parse`方法接受一个字符串类型的HTML内容,返回一个`Document`对象。这个对象现在包含了对应的DOM结构,可以通过各种方法来查询和操作这个结构。

### 2.1.2 选择器的使用和原理

在Jsoup中,选择器是一种强大的工具,它允许用户快速定位到特定的HTML元素。选择器的使用基于CSS选择器的语法,这是一种已经被广泛接受和使用的标准,因此熟悉CSS选择器的开发人员可以轻松上手Jsoup。

选择器主要有以下几种类型:

- **元素选择器**:根据元素名称选择元素,如`p`会选取所有的`<p>`元素。

- **类选择器**:根据元素的class属性选择元素,如`.myclass`会选取class为`myclass`的元素。

- **ID选择器**:根据元素的ID属性选择元素,如`#myid`会选取ID为`myid`的元素。

- **属性选择器**:根据元素的任意属性选择元素,如`[href]`会选取所有含有href属性的元素。

- **组合选择器**:将上述选择器进行组合,以精确地选取特定的元素。

例如,如果我们想要选取所有的`<p>`元素,并获取它们的文本内容,我们可以使用以下代码:

```java

Elements ps = doc.select("p");

for (Element p : ps) {

System.out.println(p.text()); // 输出每个<p>元素的文本内容

}

```

在这段代码中,`select`方法返回了一个`Elements`集合,其中包含了所有匹配到的元素。通过`text()`方法,我们可以获取到这些元素的文本内容。

选择器的原理是基于解析HTML文档树的结构,然后递归地遍历这些节点来匹配选择器的规则。当发现一个节点匹配到选择器规则时,这个节点就会被添加到结果集中。这个过程在内部是高度优化的,以确保性能最优化。

## 2.2 元素与属性操作

### 2.2.1 元素的提取和创建

在Jsoup中,元素的操作是数据解析和操作的关键部分。元素的提取和创建是实现这一功能的基本步骤。我们可以使用Jsoup提供的API来提取HTML文档中的元素,也可以创建新的元素并将其添加到文档中。

- **元素的提取**

为了从文档中提取特定的元素,我们可以使用选择器。以下代码展示了如何提取所有的`<p>`元素,并打印它们的文本内容:

```java

Elements ps = doc.select("p");

for (Element p : ps) {

System.out.println(p.text());

}

```

这段代码使用`doc.select("p")`获取所有`<p>`标签的`Element`对象,并遍历打印其文本内容。

- **元素的创建**

如果我们想要在已有的文档中添加新的元素,可以使用`Element`类来创建新的元素,并且使用`Document`类中的方法将其添加到文档树中。以下是一个创建新`<p>`元素并将其添加到文档的例子:

```java

Element newParagraph = new Element("p");

newParagraph.append("This is a newly created paragraph.");

doc.body().appendChild(newParagraph);

```

这段代码首先创建了一个新的`<p>`元素,并向其中添加了文本内容。随后,将这个新元素添加到了文档的`<body>`标签中。

### 2.2.2 属性的获取和修改

Jsoup提供了一系列方法来获取和修改元素的属性。这些操作对于解析和处理HTML文档是至关重要的。

- **属性的获取**

获取元素的属性非常直接,使用`attr`方法即可。例如,获取`<a>`标签的`href`属性的代码如下:

```java

Element link = doc.select("a").first();

String href = link.attr("href"); // 获取href属性值

```

在这段代码中,`select`方法首先选择第一个`<a>`标签,然后`attr`方法用来获取该元素的`href`属性。

- **属性的修改**

修改元素的属性也很简单,使用`attr`方法并传入新的属性值即可。例如,修改上述`<a>`标签的`href`属性:

```java

link.attr("href", "***"); // 修改href属性值

```

在这段代码中,`attr`方法的第二个参数用来设置新的属性值。

表格形式总结属性获取和修改的常用方法:

| 方法 | 描述 | 示例 |

| --- | --- | --- |

| attr(String key) | 获取指定key的属性值 | `String value = element.attr("href");` |

| attr(String key, String value) | 设置指定key的属性值,并返回修改后的元素 | `element.attr("href", "***");` |

| hasAttr(String key) | 检查元素是否含有指定key的属性 | `boolean hasClass = element.hasAttr("class");` |

在实际应用中,属性的获取和修改是动态地修改和处理HTML文档的核心操作。它们广泛应用于数据提取、内容重构以及动态内容生成等多种场景。

## 2.3 链式调用与高级操作

### 2.3.1 链式调用的技巧

Jsoup的API设计支持链式调用模式,这意味着开发者可以非常连贯地执行一系列操作,而不需要在每次操作后重新赋值给变量。这一特性极大地提高了代码的可读性和简洁性。

- **链式调用的基本用法**

假设我们想要从一个HTML文档中找到所有的段落元素,并提取出它们的文本内容,然后打印出来,我们可以这样写:

```java

String html = "<html><body><p class='first'>Hello</p><p>World</p></body></html>";

Document doc = Jsoup.parse(html);

doc.body().getElementsByClass("first").each(p -> System.out.println(p.text()));

```

在这个例子中,`body().getElementsByClass("first")`直接链式调用`each`方法,`each`方法中接收一个lambda表达式来处理每个元素。

- **链式调用中常见陷阱**

尽管链式调用非常方便,但是也要注意避免一些常见陷阱。比如,使用`first()`方法返回第一个匹配的元素,但后续的操作只会影响这个元素,而不会影响整个集合。如果不慎使用,可能会导致未预期的结果。例如:

```java

doc.body().getElementsByClass("first").first().attr("class", "second");

```

以上代码只会修改第一个匹配的`<p>`元素的class属性,而不会影响其他的`first` class的元素。

### 2.3.2 文档的高级查询和修改

Jsoup提供了非常丰富的API来进行高级查询和修改HTML文档。这些API使得开发者可以很灵活地进行数据提取和内容更新操作。

- **高级查询**

除了基础的选择器之外,Jsoup还提供了一些高级查询方法,比如`selectFirst()`用于选取第一个匹配元素,`selectEll()`返回所有匹配元素的列表。

```java

Element firstPara = doc.selectFirst("p");

List<Element> allP = doc.select("p");

```

- **高级修改**

在修改文档时,除了修改元素的属性外,我们还可以使用`replaceWith()`方法来替换指定的元素:

```java

Element toBeReplaced = doc.selectFirst("p");

toBeReplaced.replaceWith(new Element("p").text("A new text"));

```

在上面的例子中,文档中第一个`<p>`元素被替换成了新创建的`<p>`元素,并且包含了新的文本内容。

- **批处理修改**

当我们需要对多个元素执行相同的操作时,可以使用`each`方法来遍历元素集合:

```java

doc.body().getElementsByTag("a").each(a -> a.attr("rel", "nofollow"));

```

这段代码遍历了文档中所有的`<a>`标签,并将它们的`rel`属性设置为`nofollow`。

通过使用Jsoup的这些高级查询和修改方法,开发者可以实现复杂的数据提取和页面内容更新任务。这些API通常都是以链式调用的方式组合使用,进一步增强了代码的流畅性和可读性。

# 3. Jsoup在Web爬虫中的应用

## 3.1 爬虫的基础设置

### 3.1.1 连接管理与响应处理

在进行Web爬虫开发时,连接管理和响应处理是至关重要的基础。Jsoup提供了简单而强大的接口来管理HTTP连接,包括请求的发送、超时设置、代理配置等。

```java

// 使用Jsoup进行HTTP请求的示例代码

Document doc = null;

try {

// 发起连接

doc = Jsoup.connect("***").get();

} catch (IOException e) {

// 异常处理

e.printStackTrace();

}

// 使用文档对象...

```

在这段代码中,首先通过`Jsoup.connect()`方法创建了一个连接对象,并指定了目标URL。随后调用`.get()`方法发送GET请求,并获取响应对象。需要注意的是,如果请求过程中出现异常(例如网络问题、无法访问目标服务器等),会抛出`IOException`。因此,在实际应用中应当添加异常处理逻辑,以便捕获和处理这些潜在问题。

此外,`Jsoup`还允许开发者在请求中添加用户代理、设置连接超时时间等,以满足特定的爬虫需求:

```java

// 设置用户代理

Document doc = Jsoup.connect("***")

.userAgent("Mozilla/5.0 (compatible; MyCrawler/1.0; +***")

.timeout(3000) // 设置连接超时时间为3000毫秒

.get();

```

### 3.1.2 遵循robots.txt的规则

为了维护良好的爬虫生态,尊重网站的爬虫协议(robots.txt文件)是非常重要的。Jsoup支持解析robots.txt文件,并可按照其规定过滤掉不应该爬取的页面。

```java

// 从网站获取robots.txt文件并检查是否允许爬取指定路径

RobotsTxt robots = new RobotsTxt(new URL("***"), null);

boolean canFetch = robots.isAllowed("***", "*");

```

在以上代码中,首先通过`RobotsTxt`构造函数读取并解析robots.txt文件。然后,使用`isAllowed`方法检查指定的URL和用户代理是否被允许爬取。如果没有允许,爬虫则应遵守规则不爬取该页面。

## 3.2 动态内容的抓取

### 3.2.1 处理JavaScript渲染的页面

现代Web页面大量使用JavaScript动态渲染内容,而传统的HTTP请求无法获取JavaScript执行后生成的内容。因此,需要借助其他工具与Jsoup结合来抓取这类页面。

#### Jsoup与Selenium整合

Selenium是一个用于Web应用程序测试的工具,能够模拟浏览器行为,这使得它成为处理JavaScript渲染页面的理想选择。

```java

// 使用Jsoup和Selenium抓取动态内容的示例

// 注意:此处代码需要结合Selenium WebDriver API,此处仅为逻辑示意

WebDriver driver = new ChromeDriver();

driver.get("***");

// 获取渲染后的页面源码

String pageSource = driver.getPageSource();

Document doc = Jsoup.parse(pageSource);

// 此时,doc对象包含了JavaScript执行后生成的页面结构

// 使用Jsoup进行后续的解析和数据提取...

driver.quit(); // 关闭WebDriver

```

上述代码块首先启动了一个WebDriver实例(此处以Chrome为例),然后打开目标页面。页面加载完成后,通过WebDriver的`getPageSource()`方法获取渲染后的页面源代码,之后使用Jsoup解析这些源代码。最后,不要忘记关闭WebDriver实例,释放资源。

### 3.2.2 利用Jsoup与Selenium整合

为了完成对动态内容的抓取,Jsoup与Selenium的整合使用成为了一种流行的方式。整合过程中,Jsoup主要负责解析静态内容和提取数据,而Selenium负责处理那些依赖JavaScript动态加载的内容。

整合步骤一般包括以下几个:

1. **安装和配置Selenium WebDriver**:确保安装了正确的WebDriver,如ChromeDriver、GeckoDriver等,并配置环境变量以供使用。

2. **加载页面**:利用Selenium的WebDriver加载目标页面,并等待页面完全加载。

3. **获取页面源码**:通过WebDriver的`getPageSource()`方法获取页面的最终HTML代码。

4. **使用Jsoup解析页面**:将获取到的页面源码作为字符串传递给Jsoup的`parse()`方法,从而获得一个`Document`对象。

5. **数据提取**:使用Jsoup的API进行元素选择和数据提取,完成爬虫所需的数据抓取。

通过这种方式,可以有效地绕过JavaScript渲染的限制,抓取到动态生成的网页内容。此外,还可以利用Selenium进行模拟点击、填充表单等操作,从而与页面进行更深入的交云。

## 3.3 爬虫的反反爬策略

### 3.3.1 模拟浏览器行为

为了应对反爬机制,爬虫需要模拟正常的用户行为。这包括设置请求头中的用户代理(User-Agent)、保持合理的请求间隔等。

```java

// 设置请求头以模拟浏览器请求

Headers headers = new Headers();

headers.put("User-Agent", "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/81.0.4044.138 Safari/537.36");

// 创建连接并设置请求头

Jsoup.connect("***")

.headers(headers)

.timeout(10000) // 设置请求超时为10000毫秒

.method(Connection.Method.GET)

.execute();

```

在这段示例代码中,通过`headers`对象添加了用户代理。此外,还设置了请求的超时时间,以避免连接超时导致的请求失败。

### 3.3.2 Cookie处理与用户代理设置

为了更深层次地模拟浏览器行为,有时需要在请求中携带特定的Cookie信息。通过分析浏览器生成的请求,可以获取这些Cookie,并在爬虫请求中使用它们。

```java

// 添加Cookie信息

Connection connection = Jsoup.connect("***");

connection.cookie("session_id", "123456");

connection.cookie("user_id", "abcdef");

// 执行请求并获取响应

Response response = connection.execute();

```

这里通过`cookie`方法为连接添加了两个Cookie信息。执行请求后,该连接会携带这些Cookie信息,从而可能绕过一些基于Cookie的简单反爬策略。

此外,使用不同的用户代理(User-Agent)可以模拟不同的设备和浏览器,增加爬虫的隐蔽性。在爬虫中设置随机的User-Agent字符串是一个常见的反反爬策略。

总的来说,Jsoup在Web爬虫中提供了许多基础性工具和方法,通过合理地使用这些工具和方法,可以构建出高效的爬虫程序。然而,应对反爬机制和动态内容的抓取是爬虫开发者必须面对的挑战,利用Jsoup与Selenium等工具的整合使用,可以有效地应对这些挑战。

# 4. Jsoup数据解析实战

## 4.1 解析结构化数据

### 4.1.1 从HTML中提取表格数据

数据提取是爬虫和数据处理过程中的重要环节。Jsoup 提供了一套简单易用的 API 来实现从 HTML 文档中提取数据,尤其是表格数据。在本小节中,我们将介绍如何使用 Jsoup 解析 HTML 表格,并提取所需的信息。

表格数据的解析通常涉及以下步骤:

1. 定位到表格元素。

2. 选择合适的标签来提取行或列数据。

3. 逐行逐列读取单元格中的内容。

下面是一个简单的例子,展示了如何使用 Jsoup 从一个包含新闻数据的 HTML 表格中提取信息。

```java

// 假设 html 是包含新闻表格的字符串

String html = "<table id='newsTable'>...</table>";

// 解析 HTML 字符串获取文档对象

Document doc = Jsoup.parse(html);

// 定位到 id 为 'newsTable' 的表格

Elements table = doc.select("#newsTable");

// 遍历表格的每一行

for (Element row : table.select("tr")) {

// 提取每行中的第一个单元格数据(通常是新闻标题)

String title = row.select("td").first().text();

// 输出新闻标题

System.out.println(title);

}

```

此代码段展示了一个基本的表格数据提取流程。`Jsoup.parse(html)` 将 HTML 字符串转换成一个文档对象,随后使用 CSS 选择器定位到表格元素。`table.select("tr")` 遍历每一行,然后对每一行使用 `select("td")` 提取单元格数据。如果需要进一步处理和存储这些数据,可以将解析得到的字符串存储到数组、列表或数据库中。

解析表格数据时,需要注意数据的结构可能会有所不同,有些表格可能包含标题行、摘要或其他结构元素。因此,提取逻辑可能需要根据实际情况进行调整,以准确地获取所需的数据字段。

### 4.1.2 解析JSON格式数据

虽然 Jsoup 主要用于解析和操作 HTML 文档,但在某些场景中,你可能会遇到嵌入在 HTML 中的 JSON 数据。这些 JSON 数据可能是由 JavaScript 动态生成的,或者在某些情况下用于配置信息。Jsoup 本身并不直接解析 JSON,但可以配合其他库如 Gson 或 Jackson 来实现 JSON 数据的提取和处理。

以下是一个使用 Jsoup 提取 HTML 中的 JSON 字符串,然后使用 Gson 将其转换为 Java 对象的例子。

```java

// 假设 html 包含一个嵌入的 JSON 字符串

String html = "<div id='jsonData'>{\"title\":\"Example Title\",\"content\":\"Example Content\"}</div>";

// 解析 HTML 字符串获取文档对象

Document doc = Jsoup.parse(html);

// 使用 CSS 选择器定位到包含 JSON 的 div

Element jsonDataElement = doc.getElementById("jsonData");

// 获取 JSON 字符串

String json = jsonDataElement.text();

// 使用 Gson 库将 JSON 字符串转换为 Java 对象

Gson gson = new Gson();

MyDataObject obj = gson.fromJson(json, MyDataObject.class);

// 输出提取的数据

System.out.println(obj.title + " " + obj.content);

```

在上述代码中,我们首先使用 Jsoup 定位到包含 JSON 数据的 HTML 元素,然后提取其文本内容,之后通过 Gson 的 `fromJson` 方法将 JSON 字符串转换成 Java 对象。为了使得转换顺利进行,需要确保 JSON 数据格式正确,且 Java 类 `MyDataObject` 包含与 JSON 结构相对应的属性和 getter/setter 方法。

需要注意的是,当处理嵌入 HTML 的 JSON 数据时,应确保数据的安全性。JSON 字符串可能来自不可靠的源,使用适当的数据处理库(如 Gson 或 Jackson)可以防止潜在的安全风险,例如 JSON 注入攻击。

## 4.2 网页数据的清洗与重构

### 4.2.1 清洗HTML中的噪音数据

在从网页提取数据时,通常会遇到各种无关信息(噪音数据),例如广告、脚本代码、样式定义等。为了提高数据质量,需要对这些噪音数据进行清洗。使用 Jsoup 可以帮助我们过滤掉不相关的 HTML 元素和属性,从而提取出干净、结构化的数据。

以下是使用 Jsoup 清洗 HTML 数据的一个示例:

```java

String html = "<div><p>Some text... <script>alert('Noise!');</script></p></div>";

// 解析 HTML 字符串获取文档对象

Document doc = Jsoup.parse(html);

// 清理页面中的脚本和样式标签

doc.select("script, style").remove();

// 输出清洗后的 HTML

System.out.println(doc.body().html());

```

在该代码段中,`doc.select("script, style").remove();` 选择所有的 `<script>` 和 `<style>` 标签,并将它们从文档中移除。执行该操作后,`doc.body().html()` 输出的 HTML 内容仅包含干净的文本内容。

此外,还可以根据需要进行更详细的清洗操作,比如去除属性(`attr()` 方法)、删除文本节点(`text()` 方法),或者使用正则表达式清理不规范的标签和属性。

### 4.2.2 构建定制化的数据模型

在数据清洗之后,为了更好地管理和使用数据,我们可以创建定制化的数据模型。这些模型是根据数据的具体需求和使用场景设计的类,它们应该包含与数据相关的属性以及相应的逻辑来处理这些数据。

使用数据模型的优势在于:

- 程序逻辑与数据结构解耦,便于维护。

- 数据模型通常支持更复杂的业务逻辑。

- 可以方便地与数据库、文件或其他数据源进行交互。

以新闻文章的数据模型为例,下面是一个简单 Java 类的定义:

```java

public class NewsArticle {

private String title;

private String content;

private String author;

private Date publishDate;

// 构造函数、getter 和 setter 省略

}

```

在解析 HTML 后,我们可以创建 `NewsArticle` 对象并填充数据:

```java

Elements articles = doc.select(".article"); // 假设文章包裹在带有 'article' 类的 div 中

for (Element article : articles) {

NewsArticle newsArticle = new NewsArticle();

newsArticle.setTitle(article.select(".title").text());

newsArticle.setContent(article.select(".content").text());

// ... 填充其他属性

// 存储或进一步处理 newsArticle 对象

}

```

在这个例子中,我们将 HTML 中提取的文本数据填充到 `NewsArticle` 对象中,并根据需要进行进一步的处理或存储。

## 4.3 实战案例分析

### 4.3.1 实现一个简单新闻聚合器

下面我们将通过一个简单的新闻聚合器案例,来展示如何利用 Jsoup 实现数据的解析、清洗和重构。该聚合器将会从多个新闻网站中抓取新闻标题和摘要,并将它们展示给用户。

以下是一个简单的新闻聚合器实现步骤:

1. 指定要抓取新闻的网页列表。

2. 对每个网页使用 Jsoup 进行 HTML 解析。

3. 提取每个网页中的新闻标题和摘要。

4. 清洗提取的数据,移除噪音信息。

5. 构建新闻模型,并填充数据。

6. 将解析后的新闻数据展示给用户。

示例代码:

```java

public class NewsAggregator {

public static void main(String[] args) {

// 新闻网站列表

String[] newsSites = {"***", "***"};

List<NewsArticle> articles = new ArrayList<>();

for (String site : newsSites) {

try {

// 使用Jsoup获取网页文档对象

Document doc = Jsoup.connect(site).get();

// 解析每个网站的新闻列表

Elements newsList = doc.select("div.news-list div.news-item");

for (Element newsItem : newsList) {

// 清洗并提取数据

NewsArticle article = new NewsArticle();

article.setTitle(newsItem.select(".title").text());

article.setContent(newsItem.select(".content").text());

// ... 其他字段的提取

articles.add(article);

}

} catch (IOException e) {

// 处理异常

e.printStackTrace();

}

}

// 输出聚合的新闻数据

for (NewsArticle article : articles) {

System.out.println(article.getTitle() + ": " + article.getContent());

}

}

}

```

### 4.3.2 数据抓取与内容发布系统集成

将抓取的数据集成到内容发布系统中,需要确保抓取的数据能够以正确的格式提供给内容管理系统。这通常涉及到对数据结构的再处理,以及使用特定的 API 或服务与内容发布系统进行交互。

假设我们有一个基于 REST API 的内容管理系统(CMS),可以使用以下步骤将抓取的数据集成到该系统中:

1. 使用 Jsoup 解析并提取目标网页的数据。

2. 清洗和重构数据,确保数据符合 CMS 的输入要求。

3. 使用 HTTP 客户端(如 OkHttp 或 Apache HttpClient)构建 POST 请求,并将数据以 JSON 格式发送到 CMS 的 API 端点。

4. 根据响应结果处理成功或错误情况。

示例代码:

```java

// 假设抓取的新闻数据存储在新闻列表中

List<NewsArticle> newsList = ...; // 获取新闻列表

// 使用 HTTP 客户端构建 POST 请求

OkHttpClient client = new OkHttpClient();

MediaType JSON = MediaType.parse("application/json; charset=utf-8");

RequestBody body = RequestBody.create(JSON, new Gson().toJson(newsList));

// 发送请求到 CMS 的 API 端点

String cmsApiEndpoint = "***";

Request request = new Request.Builder()

.url(cmsApiEndpoint)

.post(body)

.build();

Response response = client.newCall(request).execute();

if (response.isSuccessful()) {

System.out.println("新闻数据成功发布");

} else {

System.err.println("发布失败: " + response.message());

}

```

在此示例中,我们假设 `newsList` 是一个包含新闻数据的 `List<NewsArticle>` 对象。通过 GSON 将 Java 对象转换为 JSON 字符串,然后构建一个 HTTP POST 请求,将数据发送到 CMS 系统的 API 端点。根据 CMS 系统的响应,我们可以处理成功或失败的情况。

# 5. Jsoup错误处理与性能优化

## 5.1 错误处理机制

### 5.1.1 理解Jsoup的异常类型

在使用Jsoup进行HTML文档解析和Web爬虫开发的过程中,我们可能会遇到各种异常情况。Jsoup抛出的异常主要分为两类:解析异常和运行时异常。

解析异常:这类异常发生在文档解析阶段,比如输入的HTML内容不符合标准格式,或者选择器指定的元素在文档中不存在。`DocumentException`是这类异常的基类。

运行时异常:这类异常通常与文档操作相关,例如使用了已释放的元素或文档对象。`IllegalArgumentException`、`NullPointerException`是常见的运行时异常。

在开发中,正确处理这些异常是保证程序稳定运行的关键。

### 5.1.2 异常处理的最佳实践

为了有效处理异常,我们可以遵循以下最佳实践:

- 使用try-catch块合理捕获异常,并提供清晰的错误信息。

- 检查输入数据的有效性,比如在进行解析前验证URL和HTML字符串。

- 使用日志记录错误和异常信息,便于后续问题定位。

- 考虑异常重试机制,对于可能因为网络波动导致的异常,可以设计重试逻辑。

- 给用户提供友好的错误提示,避免暴露程序内部的细节信息。

下面是一个简单的异常处理示例代码:

```java

try {

Document doc = Jsoup.parse(html, "UTF-8");

Element titleElement = doc.select("title").first();

String title = titleElement.text();

} catch (DocumentException e) {

System.err.println("解析文档时发生错误:" + e.getMessage());

} catch (Exception e) {

System.err.println("未知错误:" + e.getMessage());

}

```

在此代码中,我们尝试解析HTML文档并提取`title`元素。任何解析过程中的异常都会被捕获并打印出相应的错误信息。

## 5.2 性能优化技巧

### 5.2.1 缓存机制的实现

缓存可以显著提高应用程序的性能,特别是在处理重复的请求时。Jsoup本身不提供缓存机制,但我们可以通过自定义的缓存策略来优化性能。

一种简单有效的缓存策略是使用Java的`ConcurrentHashMap`,它可以存储解析后的`Document`对象和对应的URL。在实际应用中,我们可以在解析HTML之前检查缓存中是否存在该URL对应的文档。如果存在,则直接使用缓存中的文档;如果不存在,则进行解析并存入缓存。

```java

ConcurrentMap<String, Document> cache = new ConcurrentHashMap<>();

public Document getDocument(String url) {

if (cache.containsKey(url)) {

return cache.get(url);

} else {

Document doc = Jsoup.connect(url).get();

cache.put(url, doc);

return doc;

}

}

```

### 5.2.2 代码层面的性能优化

在代码层面,性能优化包括多个方面,如减少不必要的数据操作,使用高效的算法和数据结构,以及并行处理数据。

在使用Jsoup进行数据处理时,我们应该避免在循环中进行解析操作,因为解析是一个相对耗时的过程。此外,对于重复的查询操作,我们应该尽量减少其执行频率。

```java

// 优化前

for (String url : urls) {

Document doc = Jsoup.connect(url).get();

// 执行数据处理...

}

// 优化后

Document doc = Jsoup.connect(url).get();

for (String url : urls) {

// 使用doc进行数据处理...

}

```

在这个例子中,我们将文档解析过程移出了循环,这样只需要解析一次,然后在循环中重复使用解析后的文档进行数据处理。这样的改动虽然简单,但能显著提升性能。

在并行处理方面,可以使用Java 8引入的Stream API或并行流(parallel streams)来实现对大量URL的高效处理。

```java

List<String> urls = // ... 获取URL列表

urls.parallelStream()

.map(url -> {

try {

return Jsoup.connect(url).get();

} catch (IOException e) {

System.err.println("无法连接到:" + url);

return null;

}

})

.filter(Objects::nonNull)

.forEach(doc -> {

// 处理文档...

});

```

使用并行流可以在多核处理器上分配任务,提高处理大量数据时的效率。但需要注意,对于I/O密集型的任务,可能需要调整并行度以获得最佳性能。

通过上述章节的介绍,我们了解了Jsoup错误处理机制和性能优化的技巧。通过合理地处理异常和优化代码,我们可以构建更加健壮和高效的Web爬虫应用。在后续章节,我们将继续探讨Jsoup在安全性方面的考虑以及代码维护和重构的方法。

# 6. Jsoup的安全性与维护

## 6.1 安全性考量

在使用Jsoup进行数据解析和Web爬虫的开发时,安全性是一个不容忽视的话题。它涉及到避免常见的安全风险和确保数据处理的安全性。

### 6.1.1 避免常见的安全风险

Jsoup的解析功能虽然强大,但是如果处理不当,它也可能成为安全漏洞的源头。开发者在使用Jsoup时需要特别注意以下几点:

- **防止XSS攻击:** Jsoup通过内置的白名单系统来防止XSS攻击。在解析用户输入的HTML内容时,开发者应始终使用白名单,限制哪些HTML标签和属性是允许的。

- **防止脚本注入:** 在解析文本内容时,应避免直接将用户输入内容渲染到HTML中,以防恶意脚本注入。

- **确保URL安全:** 当解析URL或构建新的URL时,应使用Jsoup的`.isValid()`方法来确保URL是合法的,避免重定向到钓鱼网站或恶意网站。

### 6.1.2 输入验证和清理

为了增强安全性,开发者应该始终对输入进行严格的验证和清理:

- **使用Jsoup的`.text()`和`.html()`方法:** 这些方法能够从解析的元素中提取纯文本或HTML,而自动忽略或转义潜在的恶意内容。

- **限制数据的大小和类型:** 在处理输入数据时,应该限制数据的大小,并检查数据类型,确保输入与预期格式一致。

- **使用白名单进行数据清理:** 通过Jsoup的`.clean()`方法结合白名单,能够清理输入内容中的不安全标签和属性。

```java

import org.jsoup.Jsoup;

import org.jsoup.nodes.Document;

import org.jsoup.safety.Safelist;

public class JsoupSecurityExample {

public static void main(String[] args) {

String dirtyHTML = "<p><a href='javascript:alert(1)'>Link</a></p>";

Document cleanDoc = Jsoup.clean(dirtyHTML, Safelist.none());

System.out.println(cleanDoc.body().html()); // 输出为安全的HTML

}

}

```

## 6.2 代码维护与重构

随着项目的增长和代码的迭代,代码的可读性和可维护性变得至关重要。因此,进行代码维护和重构是保证项目长期稳定运行的关键。

### 6.2.1 代码的可读性和可维护性

- **编写清晰的文档注释:** 在代码中添加必要的注释来解释代码的目的和使用方式。

- **遵守编码标准:** 保持一致的编码风格和标准,有助于其他开发者理解和维护代码。

- **重构复杂代码:** 定期审查和重构过于复杂的代码逻辑,减少代码的冗余和提高代码的可读性。

### 6.2.2 重构Jsoup代码以提升质量

在使用Jsoup的过程中,开发者可能会发现一些重复的代码模式或者性能瓶颈。以下是重构Jsoup代码的几个实践:

- **避免重复的解析操作:** 由于Jsoup的解析是CPU密集型的操作,应尽量缓存解析结果,以避免重复解析相同的字符串。

- **代码优化:** 优化关键代码段的执行效率,比如减少不必要的DOM遍历,使用更高效的选择器。

- **使用连接池和连接缓存:** 对于网络请求,使用HTTP连接池和缓存可以大大减少网络延迟和提高性能。

```java

// 示例:避免重复解析和使用连接池

import org.jsoup.Jsoup;

import org.jsoup.nodes.Document;

import java.util.concurrent.ConcurrentHashMap;

public class JsoupOptimizationExample {

private static ConcurrentHashMap<String, Document> cache = new ConcurrentHashMap<>();

public static Document parseDocument(String html) {

if (cache.containsKey(html)) {

return cache.get(html); // 从缓存中获取已解析的文档

}

Document doc = Jsoup.parse(html);

cache.put(html, doc); // 存储解析后的文档到缓存

return doc;

}

}

```

在本章中,我们讨论了使用Jsoup时的安全性考虑和代码维护的策略。开发者应积极采取措施确保应用的安全性,并通过持续的代码重构和优化来提高代码质量。这些实践将有助于构建稳定和可扩展的项目。

0

0