深度学习框架中的交叉验证:TensorFlow与PyTorch的比较分析

发布时间: 2024-11-21 02:56:07 阅读量: 17 订阅数: 29

基于不同深度学习框架实现中文文本分类.zip

# 1. 深度学习与交叉验证基础

## 1.1 交叉验证简介

交叉验证是一种统计学方法,用于评估和比较预测模型的泛化能力。在深度学习中,交叉验证有助于减少过拟合,提高模型的稳定性和可靠性。

## 1.2 交叉验证的种类和选择

根据验证过程的不同,交叉验证可以分为多种类型,如留一法(Leave-one-out, LOO)、K-Fold交叉验证等。选择合适的交叉验证方法,要考虑数据集的大小、模型复杂度以及计算资源等因素。

## 1.3 交叉验证在深度学习中的重要性

在深度学习领域,过拟合是一个常见问题。通过交叉验证,可以更加准确地估计模型在独立数据集上的性能,从而指导模型选择和超参数调优,保证模型在未知数据上的表现。

```python

# 示例代码:使用scikit-learn实现K-Fold交叉验证

from sklearn.model_selection import KFold

from sklearn.datasets import make_classification

from sklearn.linear_model import LogisticRegression

from sklearn.model_selection import cross_val_score

X, y = make_classification(n_samples=100, n_features=20, n_informative=2, n_redundant=10, random_state=42)

kf = KFold(n_splits=5, random_state=42, shuffle=True)

model = LogisticRegression()

scores = cross_val_score(model, X, y, cv=kf)

print(f"Cross-validation scores: {scores}")

```

以上代码展示了如何利用scikit-learn库进行K-Fold交叉验证的基本操作,输出展示了模型在不同训练集/验证集组合上的得分。

# 2. TensorFlow框架中的交叉验证

## 2.1 TensorFlow基础与核心概念

### 2.1.1 TensorFlow安装与运行环境配置

安装TensorFlow是进行深度学习研究和开发的前提。用户可以根据自己的系统环境选择适合的安装方式。目前,TensorFlow支持多种安装选项,包括使用`pip`安装包管理器,利用`conda`环境管理器,或者是通过Docker容器运行。下面将介绍使用`pip`和`conda`进行TensorFlow的安装步骤。

1. **使用pip安装**

首先,确认系统中已经安装了Python环境。然后打开终端或者命令提示符,并输入以下命令:

```bash

pip install tensorflow

```

如果需要安装特定版本,比如1.x版本,可以指定版本号:

```bash

pip install tensorflow==1.15

```

安装完成后,可以通过执行Python并导入TensorFlow来验证安装是否成功:

```python

import tensorflow as tf

hello = tf.constant('Hello, TensorFlow!')

tf.print(hello)

```

2. **使用conda安装**

如果你是在Anaconda环境中工作,可以使用`conda`来安装TensorFlow。在终端或命令提示符中执行以下命令:

```bash

conda install -c anaconda tensorflow

```

同样,要安装特定版本的TensorFlow,可以使用:

```bash

conda install -c anaconda tensorflow=1.15

```

安装完成后,验证安装:

```python

import tensorflow as tf

hello = tf.constant('Hello, TensorFlow!')

tf.print(hello)

```

### 2.1.2 TensorFlow的数据流图与计算模型

TensorFlow的核心是其强大的数据流图(data flow graphs)计算模型。数据流图是一个有向图,它描述了计算过程中的各种操作,其中节点表示计算单元(如数学运算),而边表示节点间流动的数据(即张量Tensor)。这种设计允许用户有效地将复杂算法分解为可并行执行的操作。

一个基本的数据流图包含以下元素:

- **张量(Tensor)**: 张量是多维数组的数据结构,是所有数据的载体。在TensorFlow中,张量可能包含任意类型的数据和任意维度的数组。

- **操作(Operation)**: 操作定义了计算的节点,它对输入张量执行运算,并产生输出张量。操作可以是数学运算、数据聚合、矩阵运算等。

- **计算图(Graph)**: 计算图是由上述操作组成的网络,它描述了节点间的依赖关系和执行顺序。计算图可以是静态的,也可以是动态定义的。

- **会话(Session)**: 会话是一个运行计算图的环境。在会话中,图的所有节点被实例化并执行。会话负责管理图执行的资源。

下面是一个简单的TensorFlow计算图的例子:

```python

import tensorflow as tf

# 创建两个常量节点

a = tf.constant(2, name='a')

b = tf.constant(3, name='b')

# 创建一个加法操作节点

addition = tf.add(a, b, name='addition')

# 创建会话,运行计算图

with tf.Session() as sess:

result = sess.run(addition)

print("计算结果:", result)

```

在上述代码中,我们首先创建了两个常量张量`a`和`b`,然后定义了一个加法操作`addition`。在会话中执行`sess.run(addition)`时,TensorFlow将执行计算图中的加法操作,并输出结果。

### 2.2 TensorFlow的交叉验证实现

交叉验证是评估机器学习模型性能的重要方法。它通过将数据集分成多个子集,并在不同子集上进行训练和验证,来减少模型评估时的方差。在TensorFlow中实现交叉验证可以采用多种策略,最常见的是K-Fold交叉验证。

#### 2.2.1 K-Fold交叉验证的TensorFlow实现

K-Fold交叉验证把数据集分成K个子集,然后轮流将K-1个子集用于训练,剩下的1个子集用于验证。整个过程重复K次,每次使用不同的验证集。以下是一个使用TensorFlow实现K-Fold交叉验证的基本步骤:

1. **划分数据集**:首先将数据集分为K个等大小的子集。

2. **迭代训练与验证**:对于每个子集,将其作为验证集,其余K-1个子集作为训练集。

3. **平均性能**:记录下每次迭代的验证性能,最后计算平均性能以评估模型。

下面是一个简单的K-Fold交叉验证实现示例:

```python

import tensorflow as tf

from sklearn.model_selection import KFold

import numpy as np

# 假设有一个模型函数定义

def build_model():

return tf.keras.Sequential([

tf.keras.layers.Dense(128, activation='relu'),

tf.keras.layers.Dense(10, activation='softmax')

])

# 准备数据集

X = np.random.random((1000, 10))

y = np.random.randint(0, 10, (1000,))

# K-Fold配置

k = 5

kfold = KFold(n_splits=k, shuffle=True)

# K-Fold交叉验证循环

for train, val in kfold.split(X):

model = build_model()

# 模型编译

model.compile(optimizer='adam',

loss='sparse_categorical_crossentropy',

metrics=['accuracy'])

# 训练模型

model.fit(X[train], y[train], epochs=5, batch_size=32)

# 验证模型

eval_result = model.evaluate(X[val], y[val], verbose=0)

print(f"在验证集上的性能: {eval_result}")

# 计算平均性能

validation_performances = np.array(validation_performances)

print(f"平均性能: {np.mean(validation_performances, axis=0)}")

```

在这个例子中,我们首先定义了一个模型构建函数`build_model`,它创建了一个简单的深度学习模型。然后,我们使用`sklearn.model_selection.KFold`来进行数据集的分割。在每次迭代中,我们使用`model.fit`方法训练模型,并使用`model.evaluate`方法评估模型。最后,我们计算所有验证集上的性能平均值来评估模型的整体性能。

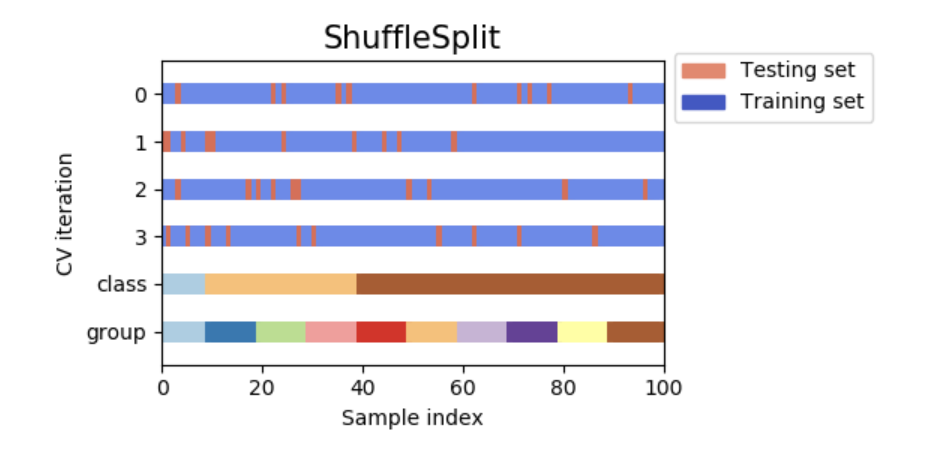

#### 2.2.2 随机子集划分的高级交叉验证技术

除了K-Fold交叉验证之外,还可以根据不同的需求实现更复杂的交叉验证策略。例如,可以随机分配数据到K个子集中,这种策略称为随机子集划分。它的主要目的是减少每次验证集的方差,从而得到更为稳定的模型性能估计。

随机子集划分不像K-Fold那样有固定的数据划分策略,因此需要额外编写逻辑来实现随机的子集划分。这通常涉及到对数据集的随机打乱和分割,然后将数据集分成K个部分。代码示例如下:

```python

import tensorflow as tf

from sklearn.model_selection import ShuffleSplit

import numpy as np

# 假设有一个模型函数定义

def build_model():

return tf.keras.Sequential([

tf.keras.layers.Dense(128, activation='relu'),

tf.keras.layers.Dense(10, activation='softmax')

])

# 准备数据集

X = np.random.random((1000, 10))

y = np.random.randint(0, 10, (1000,))

# 随机子集划分配置

n_splits = 5

shuffle_split = ShuffleSplit(n_splits=n_splits, test_size=0.2, random_state=0)

# 随机子集划分交叉验证循环

for train_index, val_index in shuffle_split.split(X):

X_train, X_val = X[train_index], X[val_index]

y_train, y_val = y[train_index], y[val_index]

model = build_model()

# 模型编译

model.compile(optimizer='adam',

loss='sparse_categorical_crossentropy',

metrics=['accuracy'])

# 训练模型

m

```

0

0