交叉验证进阶指南:6种技巧有效避免数据划分偏差

发布时间: 2024-11-21 02:08:12 阅读量: 7 订阅数: 12

# 1. 交叉验证的基本概念和重要性

交叉验证是一种统计学方法,用于评估并比较学习算法在独立数据集上的性能。在模型选择和超参数优化中,交叉验证扮演着至关重要的角色,可以防止过拟合并提高模型的泛化能力。通过对数据集进行分组,交叉验证可以在有限的数据样本条件下,提供对模型性能更加准确的估计。接下来的章节将详细解读不同类型交叉验证的原理及其选择策略,旨在帮助读者深入理解并有效地应用这一技术。

# 2. 交叉验证的类型和选择

## 理解不同类型的交叉验证

### 留出法(Holdout)

留出法是最直观的交叉验证技术,通常用于初步的模型评估。在这个方法中,数据集被分为两个不重叠的部分:训练集和测试集。大部分数据(通常是70%-80%)作为训练集,用于模型的训练;剩下的部分作为测试集,用于评估模型性能。留出法的简单性和易于实现使得它成为快速原型设计的首选。

```python

from sklearn.model_selection import train_test_split

# 假设 X 是特征数据,y 是标签数据

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

# 使用训练集训练模型

model = SomeModel()

model.fit(X_train, y_train)

# 使用测试集评估模型

score = model.evaluate(X_test, y_test)

```

留出法的一个重要参数是`test_size`,这个参数决定了测试集占总数据集的比例。此外,`random_state`参数保证了数据划分的一致性,便于实验的可重复性。

### K折交叉验证

K折交叉验证是对留出法的改进,它将全部数据分为K个大小相似的互斥子集,即折。每次一个子集被用作测试集,其余的K-1个子集用作训练集。这样可以得到K个模型的性能估计,并用它们的平均值作为评估结果,减少了留出法中由于数据划分不同而产生的评估误差。

```python

from sklearn.model_selection import cross_val_score

# 假设 X 是特征数据,y 是标签数据

scores = cross_val_score(SomeModel(), X, y, cv=5)

# 输出每次交叉验证的评分

print(scores)

# 输出平均评分

print("Mean score: {}".format(scores.mean()))

```

在这里,`cv`参数定义了折的数目。值得注意的是,K的选择通常是5或10,但没有绝对的标准。选择K时需要在计算成本和评估准确度之间做出权衡。

### 留一法(Leave-one-out)

留一法可以视为K折交叉验证的特例,其中K等于样本数。换言之,每次只留下一个样本作为测试集,其余的作为训练集。虽然留一法在样本较少时可以达到很好的评估效果,但其计算成本非常高,不适合样本量大的情况。

```python

from sklearn.model_selection import LeaveOneOut

loo = LeaveOneOut()

scores = cross_val_score(SomeModel(), X, y, cv=loo)

print("Leave-one-out scores: {}".format(scores))

```

留一法能够最大程度上利用有限的数据进行模型的评估,但也因为计算量大而使得其实际应用受到限制。这通常被看作是一种理想的交叉验证方法。

## 选择最适合的交叉验证方法

### 数据集特性分析

在选择交叉验证方法时,首要考虑的是数据集本身的特性。比如,样本量的大小直接影响到选择哪种K折交叉验证。小样本数据集可能更倾向于使用留出法或留一法以获得更多的模型评估机会。

| 数据集特征 | 推荐的交叉验证方法 |

| --- | --- |

| 小样本 | 留出法、留一法 |

| 较大样本 | K折交叉验证 |

### 模型复杂度的考量

除了数据集大小,模型的复杂度也是重要的考量因素。对于复杂的模型,如深度学习模型,通常需要大量的数据来训练。此时,K折交叉验证往往是一个好的选择,因为这种方法可以保证模型在不同数据子集上进行多次训练和验证。

### 计算资源的权衡

最后,计算资源的可用性也是选择交叉验证方法时不可忽视的因素。留一法虽然提供了评估的精度,但也显著增加了计算成本。对于计算资源受限的环境,选择K折交叉验证可能更为合适,K的值取一个较小的数字以节约计算时间。

| 资源限制 | 推荐的交叉验证方法 |

| --- | --- |

| 低 | K折交叉验证(K较小) |

| 中 | K折交叉验证(K适中) |

| 高 | 留一法或多次K折交叉验证 |

选择交叉验证的方法涉及权衡和决策,根据不同的情况灵活选择,才能得到最合理的结果。

# 3. 避免数据划分偏差的策略

在机器学习和统计建模中,数据集的划分对于模型的训练和评估具有决定性意义。偏差的数据划分可能会导致模型在实际应用中的泛化能力变差。因此,本章节将探讨如何避免在交叉验证过程中出现的数据划分偏差,并提出相应的策略。

## 3.1 预处理数据集

### 3.1.1 数据清洗

数据清洗是模型训练之前的重要步骤,它可以显著减少数据划分过程中出现偏差的风险。数据清洗包括处理缺失值、异常值、数据一致性校验等。例如,对于缺失值,可以使用均值填充、中位数填充、使用基于模型的估算,甚至删除含有缺失值的记录等策略。

```python

import pandas as pd

from sklearn.impute import SimpleImputer

# 创建一个含有缺失值的数据框

df = pd.DataFrame({

'A': [1, 2, np.nan, 4, 5],

'B': [5, np.nan, np.nan, 8, 10],

'C': [10, 20, 30, np.nan, 50]

})

# 使用均值填充缺失值

imputer = SimpleImputer(missing_values=np.nan, strategy='mean')

df_imputed = pd.DataFrame(imputer.fit_transform(df), columns=df.columns)

print(df_imputed)

```

在上述Python代码中,我们使用了`SimpleImputer`从`sklearn.impute`库来填充缺失值。数据清洗后,数据集会更加干净、整洁,从而帮助我们避免在后续的数据划分中产生偏差。

### 3.1.2 特征工程

特征工程旨在通过构建新的特征或转换现有特征来提高模型的性能。正确的特征选择和转换能够减少模型过拟合的风险,提高模型的泛化能力。举例来说,对于分类问题,独热编码(One-Hot Encoding)可以将类别型特征转换为数值型特征,从而避免由于特征类型不匹配导致的模型性能下降。

```python

import pandas as pd

from sklearn.preprocessing import OneHotEncoder

# 假设有一个包含类别型特征的数据框

df = pd.DataFrame({

'Color': ['Red', 'Blue', 'Green', 'Blue', 'Red'],

'Size': ['S', 'M', 'L', 'XL', 'L']

})

# 将类别型特征转换为独热编码

encoder = OneHotEncoder(sparse=False)

encoded_features = encoder.fit_transform(df[['Color', 'Size']])

# 将独热编码转换为数据框形式方便观察

encoded_df = pd.DataFrame(encoded_features, columns=encoder.get_feature_names(['Color', 'Size']))

print(encoded_df)

```

在上述代码中,`OneHotEncoder`被用来将颜色和尺寸两个类别型特征转换为独热编码,这一过程对于提高模型的准确性和减少偏差至关重要。

## 3.2 优化交叉验证流程

### 3.2.1 随机划分与分层划分

随机划分是将数据集随机地划分为训练集和测试集,这种划分方式简单快速,但在一些情况下可能会引入偏差。特别是在样本量较小或者类别分布不均匀的情况下,随机划分可能会导致训练集和测试集的类别比例与原始数据集有较大偏差,从而影响模型的泛化能力。

分层划分(Stratified Split)在这种情况下更为适用。它能够保证训练集和测试集中的类别比例与原始数据集中的比例相同。对于二分类问题,即使原始数据集中正负样本的比例是1:9,分层划分也会保证在每个划分的子集中正负样本比例也是1:9。

```python

from sklearn.model_selection import StratifiedKFold

# 假设有一个标签向量

labels = np.array([1, 0, 0, 1, 1, 1, 0, 0, 0])

# 使用分层划分

skf = StratifiedKFold(n_splits=5)

for train_index, test_index in skf.split(X, labels):

X_train, X_test = X[train_index], X[test_index]

y_train, y_test = y[train_index], y[test_index]

# 在此处构建并评估模型

```

在上述代码片段中,`StratifiedKFold`类被用来进行分层划分。由于我们没有提供`X`和`y`的具体值,代码段主要是为了展示分层划分的过程。

### 3.2.2 确保随机性的策略

交叉验证中随机性的一个重要方面是确定如何随机分割数据集。为了确保每次分割的随机性,需要设置随机种子(Random Seed)。这样,每次运行代码时都能获得相同的结果,便于复现实验。

```python

from sklearn.model_selection import KFold

import numpy as np

# 设置随机种子确保结果可复现

random_state = 42

# 创建KFold实例

kf = KFold(n_splits=5, random_state=random_state, shuffle=True)

for train_index, test_index in kf.split(X):

X_train, X_test = X[train_index], X[test_index]

y_train, y_test = y[train_index], y[test_index]

# 在此处构建并评估模型

```

在上述代码中,我们设置了`random_state`参数为42,并在`KFold`中使用它。通过设置`shuffle=True`,数据在划分之前会被随机打乱,进一步确保了交叉验证过程的随机性。

## 3.3 模型评估与比较

### 3.3.1 度量指标的选择

在模型评估阶段,选择合适的度量指标对于准确反映模型性能至关重要。对于回归问题,常用的评价指标包括均方误差(MSE)、均方根误差(RMSE)和决定系数(R²)。对于分类问题,常用的指标有准确率(Accuracy)、精确率(Precision)、召回率(Recall)和F1分数。

```python

from sklearn.metrics import accuracy_score, precision_score, recall_score, f1_score

# 假设y_true为真实标签,y_pred为预测标签

y_true = np.array([1, 0, 0, 1, 1])

y_pred = np.array([1, 1, 0, 0, 1])

print("Accuracy:", accuracy_score(y_true, y_pred))

print("Precision:", precision_score(y_true, y_pred))

print("Recall:", recall_score(y_true, y_pred))

print("F1 Score:", f1_score(y_true, y_pred))

```

上述代码中,使用`sklearn.metrics`中的`accuracy_score`、`precision_score`、`recall_score`和`f1_score`函数计算了四个常用的分类指标。

### 3.3.2 模型性能的统计检验

统计检验可以用来评估模型性能是否显著不同。在交叉验证中,我们可以使用t检验或ANOVA(方差分析)来比较不同模型的性能。如果模型A显著优于模型B,那么我们可以更有信心地选择模型A。

```python

from scipy import stats

import numpy as np

# 假设有两个模型的性能评估结果(例如准确率)

model_A_scores = np.array([0.8, 0.85, 0.83, 0.84, 0.86])

model_B_scores = np.array([0.78, 0.79, 0.77, 0.80, 0.81])

# 使用t检验比较两个模型的性能

t_statistic, p_value = stats.ttest_rel(model_A_scores, model_B_scores)

print("t统计量:", t_statistic)

print("p值:", p_value)

```

在上述代码中,我们使用了`scipy.stats`库的`ttest_rel`函数来执行成对样本t检验。根据p值,我们可以判断两个模型的性能是否具有显著差异。

综上所述,通过上述预处理数据集、优化交叉验证流程和采用适当的模型评估指标,我们可以显著降低数据划分的偏差,并在多个模型之间做出更加明智的选择。这些策略将为构建稳健的机器学习模型打下坚实的基础。

# 4. 进阶技巧提升模型的鲁棒性

## 4.1 集成学习方法

### 4.1.1 Bootstrap抽样与Bagging

在机器学习中,集成学习是一种通过构建并结合多个学习器来解决单一学习器可能遇到的过拟合问题的技术。Bootstrap抽样和Bagging是两种常见的集成学习方法,它们的目的是通过引入数据的随机性来降低模型的方差,从而提高模型的预测性能。

Bootstrap抽样是一种重采样技术,它从原始训练集中有放回地随机抽取样本,形成新的训练样本集。这样做的结果是,新的训练集与原始数据集具有相同的大小,但其中包含的样本可能会重复出现,而某些样本则可能不会被抽到。因此,每个重采样得到的训练集都略有不同,从这些训练集中训练出的模型也会有所差异。

Bagging(Bootstrap Aggregating)是一种利用Bootstrap抽样来增加模型多样性的方法。它首先使用Bootstrap抽样从原始数据集中生成多个不同的训练子集,然后独立地训练出多个模型(通常是同类型的模型)。最终的预测结果是通过聚合这些模型的预测来得出的,通常是取平均值。

在Python中,我们可以使用`sklearn`库中的`BaggingClassifier`或`BaggingRegressor`来实现Bagging集成。下面的代码展示了如何使用Bagging集成学习方法:

```python

from sklearn.ensemble import BaggingClassifier

from sklearn.tree import DecisionTreeClassifier

# 定义基学习器

base_estimator = DecisionTreeClassifier()

# 实例化Bagging集成模型

bagging_clf = BaggingClassifier(base_estimator=base_estimator, n_estimators=10, random_state=42)

# 训练模型

bagging_clf.fit(X_train, y_train)

# 预测

predictions = bagging_clf.predict(X_test)

```

在这段代码中,`BaggingClassifier`被用来创建一个集成模型,它使用10个决策树作为基学习器。`n_estimators`参数指定了基学习器的数量。通过训练多个独立的决策树并聚合它们的预测结果,Bagging集成能够有效地降低模型的方差,提高整体模型的鲁棒性和预测性能。

### 4.1.2 Boosting方法

Boosting方法是一类集成学习算法,其核心思想是通过串行地训练一系列弱学习器来构建强学习器。在每一轮迭代中,Boosting算法会根据之前模型的表现来调整样本权重,使得之前预测错误的样本在后续模型中得到更多的关注。

Boosting算法的代表有AdaBoost、Gradient Boosting等。以AdaBoost为例,其主要步骤如下:

1. 初始化训练样本的权重。

2. 对于每一个基学习器(通常是决策树),根据当前权重训练模型并进行预测。

3. 计算该模型的预测误差,更新样本权重,给予预测错误的样本更大的权重。

4. 重复以上步骤,直到达到预设的模型数量或误差阈值。

AdaBoost的关键在于它能够通过增加被错误分类样本的权重来“关注”那些难以分类的样本,同时减少那些被正确分类样本的权重,从而逐步提高整体集成模型的性能。

在Python中,我们同样可以利用`sklearn`库来实现AdaBoost算法:

```python

from sklearn.ensemble import AdaBoostClassifier

from sklearn.tree import DecisionTreeClassifier

# 定义基学习器

base_estimator = DecisionTreeClassifier(max_depth=1)

# 实例化AdaBoost集成模型

ada_clf = AdaBoostClassifier(base_estimator=base_estimator, n_estimators=500, random_state=42)

# 训练模型

ada_clf.fit(X_train, y_train)

# 预测

predictions = ada_clf.predict(X_test)

```

在这段代码中,`AdaBoostClassifier`被用来创建一个集成模型,它使用500个决策树作为基学习器,并设置树的最大深度为1。通过逐渐增加权重的方式,AdaBoost算法使得模型对难以分类的样本更加敏感,提高了模型的准确度和鲁棒性。

## 4.2 混淆交叉验证(Stratified Cross-Validation)

### 4.2.1 分层划分的原理

混淆交叉验证(Stratified Cross-Validation)是K折交叉验证的一种变体,它特别适用于分类问题。在传统的K折交叉验证中,数据被随机划分到K个子集中,但这样的随机划分可能会导致某些类别在划分过程中分布不均匀。分层划分能够确保每个子集中的类别比例与整个数据集的类别比例大致相同,从而使得评估结果更加稳定和可靠。

分层划分的原理是将数据集中的每个类别按照大致相等的比例划分为K组。在进行交叉验证时,每组数据都会被用作一次测试集,而剩下的数据则用作训练集。这种方法特别适合处理不平衡数据集的情况,因为即使数据集被划分为更小的子集,每个子集中的类别分布也能够反映出整个数据集的类别分布。

### 4.2.2 案例分析:分类问题中的应用

以二分类问题为例,假设我们有一个包含1000个样本的数据集,其中800个样本属于类别A,200个样本属于类别B。在进行K折交叉验证时,如果数据被随机划分,那么可能会发生一些子集中没有类别B的样本。这会导致训练和测试的不公平性,因为模型从未学习如何对类别B的样本进行分类。

为了解决这个问题,分层K折交叉验证会保证每个子集都包含大约80%的类别A样本和20%的类别B样本。这样,无论哪一个子集被用作测试集,模型都会在与整个数据集相似的类别分布下进行测试。

在Python中,可以使用`StratifiedKFold`类来实现分层划分的K折交叉验证:

```python

from sklearn.model_selection import StratifiedKFold

from sklearn.ensemble import RandomForestClassifier

from sklearn.datasets import make_classification

# 生成一个不平衡的数据集

X, y = make_classification(n_samples=1000, n_features=20, n_informative=15, n_redundant=5,

n_classes=2, weights=[0.1, 0.9], random_state=42)

# 实例化分层K折交叉验证

stratified_k_fold = StratifiedKFold(n_splits=5)

# 使用RandomForestClassifier作为基学习器

model = RandomForestClassifier(random_state=42)

# 进行分层K折交叉验证

for train_index, test_index in stratified_k_fold.split(X, y):

X_train, X_test = X[train_index], X[test_index]

y_train, y_test = y[train_index], y[test_index]

model.fit(X_train, y_train)

predictions = model.predict(X_test)

# 进一步可以计算并输出模型的性能指标

```

在这段代码中,`StratifiedKFold`被用来创建分层划分的交叉验证迭代器。通过指定`n_splits=5`,我们将数据集分为5个子集进行交叉验证。使用`RandomForestClassifier`作为基学习器,在每次交叉验证中训练并测试模型。由于采用了分层划分,我们可以确保每个子集都保持了与原始数据集相同的类别比例,从而在评估模型性能时得到更公平、更稳定的结果。

## 4.3 调整模型参数

### 4.3.1 网格搜索(Grid Search)

在机器学习中,模型训练完毕后,往往需要对模型的超参数进行调整,以达到最优的性能。超参数是指那些不是通过训练数据学习得到的参数,而是需要我们在模型训练之前手动设定的参数。调整超参数是一个重要的步骤,因为超参数的选择会显著影响模型的性能。

网格搜索(Grid Search)是一种穷举式搜索方法,它通过遍历用户指定的参数值组合来寻找最优的超参数组合。用户首先定义一个参数的列表,然后Grid Search会尝试所有可能的参数组合,最后返回能够使模型性能最优的参数组合。

在Python中,`GridSearchCV`是`sklearn`库提供的一个工具,它将交叉验证与网格搜索结合在一起,对指定的参数范围进行穷举搜索。下面是一个使用`GridSearchCV`进行参数优化的示例:

```python

from sklearn.model_selection import GridSearchCV

from sklearn.svm import SVC

# 定义一个SVM分类器

svc = SVC()

# 定义参数网格

param_grid = {

'C': [0.1, 1, 10, 100],

'gamma': [1, 0.1, 0.01, 0.001],

'kernel': ['rbf']

}

# 实例化GridSearchCV对象

grid_search = GridSearchCV(svc, param_grid, refit=True, verbose=2)

# 执行网格搜索

grid_search.fit(X_train, y_train)

# 输出最优参数组合

print("Best parameters found: ", grid_search.best_params_)

# 使用最佳参数重新训练模型

best_model = grid_search.best_estimator_

```

在这段代码中,`GridSearchCV`被用来对支持向量机(SVM)分类器的参数`C`、`gamma`和`kernel`进行优化。`param_grid`字典指定了要搜索的参数范围。`GridSearchCV`会遍历所有可能的参数组合,使用交叉验证来评估每一组参数的性能,并最终输出最佳参数组合。通过`grid_search.best_estimator_`,我们可以获取到经过最佳参数调优的模型。

### 4.3.2 随机搜索(Random Search)

尽管网格搜索能够穷举所有可能的参数组合,但在实际应用中,网格搜索可能非常耗时,特别是当参数空间很大时。随机搜索(Random Search)提供了一个更为高效的替代方案,它随机选择参数值进行搜索,可以更快地找到较好的参数组合。

随机搜索的主要思想是在预定义的参数分布中随机抽取一定数量的参数组合,并使用交叉验证来评估它们。随机搜索的一个优点是,它允许在参数空间中进行更广泛的搜索,而不是仅仅局限于预先定义的网格。这可以减少搜索时间,并且有时也能找到比网格搜索更好的参数组合。

在Python中,`RandomizedSearchCV`是`sklearn`库提供的随机搜索工具,它允许用户指定参数的分布而不是固定的值列表。下面是一个使用`RandomizedSearchCV`进行随机搜索的示例:

```python

from sklearn.model_selection import RandomizedSearchCV

from sklearn.svm import SVC

import scipy.stats as stats

# 定义一个SVM分类器

svc = SVC()

# 定义参数分布

param_distributions = {

'C': stats.expon(scale=100),

'gamma': stats.expon(scale=.1),

'kernel': ['rbf']

}

# 实例化RandomizedSearchCV对象

random_search = RandomizedSearchCV(svc, param_distributions, n_iter=10, refit=True, verbose=2, random_state=42)

# 执行随机搜索

random_search.fit(X_train, y_train)

# 输出最优参数组合

print("Best parameters found: ", random_search.best_params_)

# 使用最佳参数重新训练模型

best_model = random_search.best_estimator_

```

在这段代码中,`RandomizedSearchCV`被用来随机搜索SVM分类器的参数。参数分布使用`scipy.stats`中的分布对象来定义,其中`C`和`gamma`分别使用指数分布来表示可能的值范围。`n_iter`参数指定了要尝试的参数组合数量,这使得搜索过程可以根据时间和计算资源来调整。最终,`RandomizedSearchCV`将输出最佳的参数组合,我们可以使用`best_estimator_`属性来获取经过最优参数调整的模型。

# 5. 实践案例分析

在前几章中,我们深入探讨了交叉验证的理论基础、类型选择、避免偏差的策略以及提升模型鲁棒性的进阶技巧。在本章中,我们将结合实际案例来分析交叉验证在不同领域中的应用,并通过一个真实的交叉验证演练来加深理解。同时,我们还会讨论在应用交叉验证时可能遇到的一些常见问题,并提供相应的解决方案和建议。

## 5.1 交叉验证在不同领域的应用

交叉验证作为一种强大的模型评估方法,在多个领域中都有着广泛的应用。下面我们将探讨其在生物信息学和金融建模中的应用。

### 5.1.1 生物信息学

在生物信息学领域,数据集往往含有复杂的生物标志物,且样本数量相对较少。例如,基因表达数据通常具有成千上万的特征和少量的样本。在此情况下,交叉验证能够有效评估分类模型,如癌症分类,其性能受到高维度和小样本数量的影响。

在应用交叉验证时,重要的是选择合适的交叉验证类型,以确保结果的有效性。生物信息学中的常见做法是采用K折交叉验证,特别是对于数据集中的样本数量不是很小时。同时,由于特征维度非常高,可能需要进行特征选择或降维来减少过拟合的风险。

### 5.1.2 金融建模

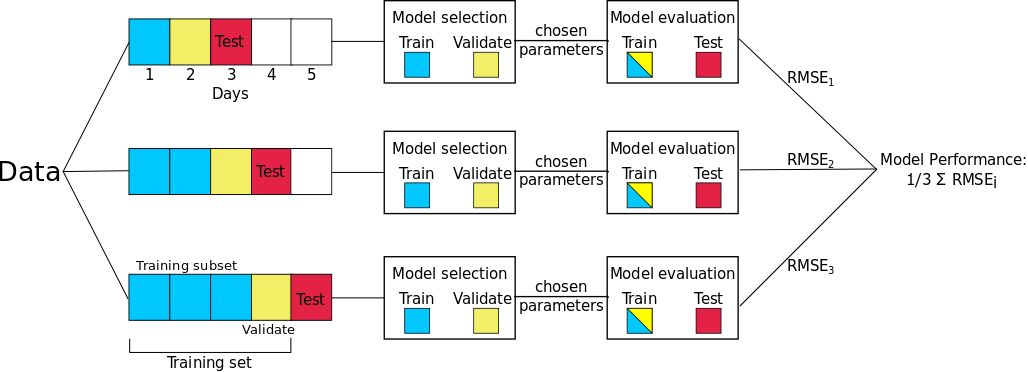

在金融建模中,如预测股票价格或信用评分,交叉验证同样扮演着重要的角色。由于金融数据具有时间序列的特性,传统的交叉验证方法可能需要进行适当的调整来避免时间泄露。

例如,可以采用时间序列交叉验证(Time Series Cross-Validation),在这种方法中,模型的训练和验证是根据时间顺序来进行的,以保持时间依赖性。此外,为了评估模型对未来数据的预测能力,可以使用滚动预测(Rolling Forecast)的方法。

## 5.2 真实数据集的交叉验证演练

为了进一步加深对交叉验证方法的理解,我们将通过一个真实的交叉验证演练来展示其应用过程。本演练中,我们使用一个公开的金融数据集,并进行以下步骤:

### 5.2.1 数据集概述与预处理

首先,我们对选定的数据集进行概述和必要的预处理工作。预处理步骤可能包括:

- 数据清洗:检查并处理缺失值、异常值和重复记录。

- 特征工程:基于领域知识创建新的特征,如计算移动平均数。

- 特征选择:使用诸如主成分分析(PCA)等技术来减少特征维度。

### 5.2.2 实现交叉验证与结果分析

接下来,我们将执行交叉验证。以K折交叉验证为例,我们将数据集分割成K个子集,并用K-1个子集来训练模型,剩下1个子集用于验证模型。这个过程重复K次,每次使用不同的子集作为验证集。最后,我们计算K次验证的平均性能指标,如准确率、召回率和F1分数,以评估模型的整体性能。

以下是使用Python的scikit-learn库实现K折交叉验证的一个简单示例:

```python

from sklearn.model_selection import cross_val_score

from sklearn.linear_model import LogisticRegression

from sklearn.datasets import make_classification

# 创建一个分类数据集

X, y = make_classification(n_samples=1000, n_features=20, random_state=42)

# 初始化逻辑回归模型

model = LogisticRegression()

# 应用5折交叉验证

scores = cross_val_score(model, X, y, cv=5)

print(f"Cross-validation scores: {scores}")

print(f"Average cross-validation score: {scores.mean()}")

```

通过上述代码,我们不仅可以评估模型的平均性能,还可以观察每次交叉验证的性能,从而更全面地了解模型的稳定性和泛化能力。

## 5.3 常见问题解答与建议

在应用交叉验证时,我们可能会遇到一些问题。以下是一些常见问题及其解决建议:

### 5.3.1 遇到数据集过小的情况

当数据集非常小,不足以支撑交叉验证时,可以考虑使用留一法(Leave-one-out cross-validation),因为每个样本都单独作为验证集,最大限度地使用了可用数据。但是,这种方法计算量大,且容易受到异常值的影响。

另一种方法是数据增强,通过合成新样本来扩大数据集。对于分类问题,可以通过过采样少数类别或欠采样多数类别来平衡类别分布。对于回归问题,可以应用旋转、缩放或其他变换来生成新的样本。

### 5.3.2 高维数据下的交叉验证技巧

在高维数据下,传统交叉验证方法可能会由于维度诅咒而导致过拟合。混淆交叉验证(Stratified Cross-Validation)在这种情况下尤其有用,因为它保证了训练集和测试集中各类别的比例与整个数据集中的比例相同。

此外,还可以应用正则化方法,如L1或L2惩罚项,以减少模型复杂度。特征选择技术如递归特征消除(RFE)和基于模型的选择方法也有助于缓解高维问题。

通过这些实践案例分析和问题解答,我们不仅加深了对交叉验证理论的理解,而且掌握了在实际应用中处理复杂情况的能力。在下一章节中,我们将总结交叉验证的最佳实践和未来发展趋势。

0

0