揭秘MATLAB中的BP神经网络:从小白到大师的进阶指南

发布时间: 2024-06-14 08:31:11 阅读量: 98 订阅数: 45

# 1. BP神经网络基础**

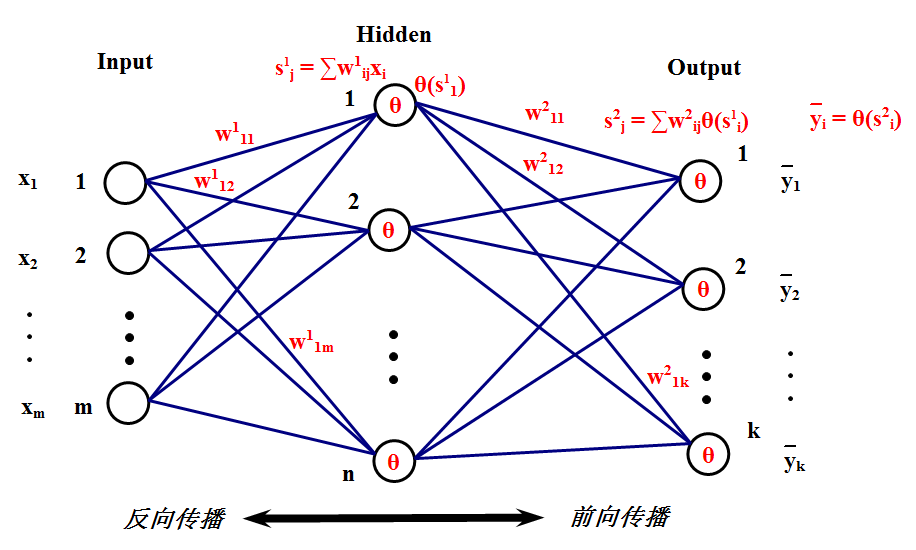

BP神经网络是一种监督学习算法,广泛应用于模式识别、预测建模和优化等领域。它由多层神经元组成,通过反向传播算法不断调整权重,以最小化误差函数。

**神经元的结构和功能:**

神经元是BP神经网络的基本单元,由输入、权重、偏置、激活函数和输出组成。输入是来自上一层神经元的输出,权重和偏置决定了输入对输出的影响,激活函数将加权和转换为非线性输出。

**神经网络的类型和拓扑结构:**

BP神经网络通常采用多层前馈结构,包括输入层、隐含层和输出层。输入层接收输入数据,隐含层提取特征,输出层产生最终输出。不同类型的BP神经网络具有不同的层数和神经元数量,以适应不同的任务复杂度。

# 2. BP神经网络的理论基础

### 2.1 神经网络的基本原理

**2.1.1 神经元的结构和功能**

神经元是神经网络的基本单元,它模拟了生物神经元的结构和功能。一个神经元由以下部分组成:

- **输入端(Dendrites):**接收来自其他神经元的输入信号。

- **细胞体(Soma):**处理输入信号并产生输出。

- **输出端(Axon):**将输出信号传递给其他神经元。

神经元的输出信号由以下公式计算:

```

output = activation_function(∑(weights * inputs) + bias)

```

其中:

- `weights`:连接到神经元的输入信号的权重。

- `inputs`:输入信号。

- `bias`:神经元的偏置项。

- `activation_function`:激活函数,它确定神经元的输出值。

### 2.1.2 神经网络的类型和拓扑结构

神经网络可以根据其结构和连接方式进行分类。常见的类型包括:

- **前馈神经网络:**信息从输入层单向传播到输出层,没有反馈环路。

- **反馈神经网络:**信息可以在网络中循环,允许网络学习时序模式。

- **卷积神经网络(CNN):**专门用于处理具有网格结构的数据,如图像。

神经网络的拓扑结构是指神经元如何组织成层。常见的拓扑结构包括:

- **全连接层:**每个神经元与前一层的所有神经元相连。

- **卷积层:**神经元只与前一层局部区域的神经元相连。

- **池化层:**对前一层的神经元输出进行降采样,减少特征图的大小。

# 3. BP神经网络的MATLAB实现

### 3.1 MATLAB神经网络工具箱概述

MATLAB神经网络工具箱是一个功能强大的工具集,用于在MATLAB环境中创建、训练和部署神经网络。它提供了各种函数和类,可以简化神经网络开发过程。

#### 3.1.1 常用函数和类

* **newff**:创建前馈神经网络

* **newrb**:创建径向基神经网络

* **train**:训练神经网络

* **sim**:模拟神经网络

* **perf**:计算神经网络的性能指标

* **net**:神经网络对象

#### 3.1.2 数据预处理和特征提取

在训练神经网络之前,通常需要对数据进行预处理和特征提取。MATLAB提供了各种函数来执行这些任务,包括:

* **normalize**:归一化数据

* **pca**:执行主成分分析

* **kmeans**:执行k均值聚类

### 3.2 BP神经网络的训练和评估

#### 3.2.1 网络的创建和初始化

使用MATLAB创建BP神经网络的步骤如下:

1. 使用**newff**函数创建网络对象

2. 设置网络的层数、节点数和激活函数

3. 初始化网络的权重和偏差

```

% 创建一个三层BP神经网络

net = newff([2 5 1], {'tansig' 'purelin'}, 'trainlm');

% 设置网络的训练参数

net.trainParam.epochs = 1000;

net.trainParam.goal = 0.001;

% 初始化网络的权重和偏差

net = init(net);

```

#### 3.2.2 训练过程和参数设置

训练BP神经网络是一个迭代过程,其中网络的权重和偏差被调整以最小化误差函数。MATLAB提供了各种训练算法,包括:

* **trainlm**:Levenberg-Marquardt算法

* **traingd**:梯度下降算法

* **traingdx**:扩展的梯度下降算法

训练参数包括:

* **epochs**:训练的迭代次数

* **goal**:训练误差的目标值

* **lr**:学习率

```

% 训练网络

net = train(net, inputs, targets);

```

#### 3.2.3 模型评估和性能指标

训练后,需要评估神经网络的性能。MATLAB提供了各种性能指标,包括:

* **mse**:均方误差

* **rmse**:均方根误差

* **mae**:平均绝对误差

* **r**:相关系数

```

% 计算网络的性能指标

mse = mse(net, inputs, targets);

rmse = sqrt(mse);

mae = mae(net, inputs, targets);

r = corrcoef(net(inputs), targets);

```

# 4. BP神经网络的应用实践**

**4.1 图像识别和分类**

**4.1.1 图像预处理和特征提取**

图像识别和分类是BP神经网络的经典应用之一。在使用BP神经网络进行图像识别之前,需要对图像进行预处理和特征提取。

* **图像预处理**:图像预处理包括图像大小调整、灰度化、归一化等操作,目的是将图像转换为神经网络可以处理的格式。

* **特征提取**:特征提取是将图像中包含的信息提取出来,形成神经网络的输入。常见的特征提取方法包括直方图、边缘检测、尺度不变特征变换(SIFT)等。

**4.1.2 BP神经网络的训练和测试**

图像识别和分类的BP神经网络通常采用卷积神经网络(CNN)结构。CNN通过卷积层、池化层等操作提取图像特征,并通过全连接层进行分类。

```

% 导入图像数据

data = load('image_data.mat');

X = data.images; % 图像数据

y = data.labels; % 标签

% 创建CNN模型

layers = [

imageInputLayer([28, 28, 1])

convolution2dLayer(3, 16, 'Stride', 1, 'Padding', 'same')

reluLayer

maxPooling2dLayer(2, 'Stride', 2)

convolution2dLayer(3, 32, 'Stride', 1, 'Padding', 'same')

reluLayer

maxPooling2dLayer(2, 'Stride', 2)

fullyConnectedLayer(10)

softmaxLayer

classificationLayer

];

options = trainingOptions('sgdm', 'MaxEpochs', 10, 'InitialLearnRate', 0.01);

% 训练模型

net = trainNetwork(X, y, layers, options);

% 测试模型

[YPred, scores] = classify(net, X);

accuracy = mean(YPred == y);

```

**逻辑分析:**

* `imageInputLayer`:输入层,指定图像尺寸和通道数。

* `convolution2dLayer`:卷积层,提取图像特征。

* `reluLayer`:激活函数,引入非线性。

* `maxPooling2dLayer`:池化层,减少特征图尺寸。

* `fullyConnectedLayer`:全连接层,进行分类。

* `softmaxLayer`:激活函数,输出概率分布。

* `classificationLayer`:分类层,输出预测标签。

**参数说明:**

* `Stride`:卷积步长。

* `Padding`:填充方式。

* `MaxEpochs`:最大训练轮数。

* `InitialLearnRate`:初始学习率。

**4.2 自然语言处理**

**4.2.1 文本预处理和词嵌入**

自然语言处理是BP神经网络的另一个重要应用领域。在使用BP神经网络进行自然语言处理之前,需要对文本进行预处理和词嵌入。

* **文本预处理**:文本预处理包括分词、去停用词、词干化等操作,目的是将文本转换为神经网络可以处理的格式。

* **词嵌入**:词嵌入是一种将单词表示为向量的方法,可以捕获单词之间的语义关系。

**4.2.2 BP神经网络的文本分类和情感分析**

文本分类和情感分析是自然语言处理的常见任务。BP神经网络可以通过卷积神经网络(CNN)或循环神经网络(RNN)结构来实现这些任务。

```

% 导入文本数据

data = load('text_data.mat');

X = data.texts; % 文本数据

y = data.labels; % 标签

% 创建文本分类模型

layers = [

textinputlayer

tokenizationLayer

wordEmbeddingLayer(100)

convolution2dLayer(3, 100, 'Stride', 1, 'Padding', 'same')

maxPooling2dLayer(2, 'Stride', 2)

fullyConnectedLayer(2)

softmaxLayer

classificationLayer

];

options = trainingOptions('sgdm', 'MaxEpochs', 10, 'InitialLearnRate', 0.01);

% 训练模型

net = trainNetwork(X, y, layers, options);

% 测试模型

[YPred, scores] = classify(net, X);

accuracy = mean(YPred == y);

```

**逻辑分析:**

* `textinputlayer`:输入层,接收文本数据。

* `tokenizationLayer`:分词层,将文本拆分为单词。

* `wordEmbeddingLayer`:词嵌入层,将单词转换为向量。

* `convolution2dLayer`:卷积层,提取文本特征。

* `maxPooling2dLayer`:池化层,减少特征图尺寸。

* `fullyConnectedLayer`:全连接层,进行分类。

* `softmaxLayer`:激活函数,输出概率分布。

* `classificationLayer`:分类层,输出预测标签。

**参数说明:**

* `Stride`:卷积步长。

* `Padding`:填充方式。

* `MaxEpochs`:最大训练轮数。

* `InitialLearnRate`:初始学习率。

**4.3 预测建模和回归**

**4.3.1 数据预处理和特征选择**

预测建模和回归是BP神经网络的又一个重要应用领域。在使用BP神经网络进行预测建模和回归之前,需要对数据进行预处理和特征选择。

* **数据预处理**:数据预处理包括数据清洗、缺失值处理、标准化等操作,目的是将数据转换为神经网络可以处理的格式。

* **特征选择**:特征选择是选择与目标变量相关性高的特征,可以提高模型的性能。

**4.3.2 BP神经网络的回归模型和预测性能**

预测建模和回归可以使用BP神经网络的简单全连接网络结构来实现。

```

% 导入数据

data = load('regression_data.mat');

X = data.features; % 特征数据

y = data.target; % 目标变量

% 创建回归模型

layers = [

inputLayer(size(X, 2))

fullyConnectedLayer(10)

reluLayer

fullyConnectedLayer(1)

regressionLayer

];

options = trainingOptions('sgdm', 'MaxEpochs', 100, 'InitialLearnRate', 0.01);

% 训练模型

net = trainNetwork(X, y, layers, options);

% 测试模型

YPred = predict(net, X);

rmse = sqrt(mean((YPred - y).^2));

```

**逻辑分析:**

* `inputLayer`:输入层,接收特征数据。

* `fullyConnectedLayer`:全连接层,提取特征并进行预测。

* `reluLayer`:激活函数,引入非线性。

* `regressionLayer`:回归层,输出预测值。

**参数说明:**

* `MaxEpochs`:最大训练轮数。

* `InitialLearnRate`:初始学习率。

* `rmse`:均方根误差,衡量模型的预测性能。

# 5. BP神经网络的优化和调优**

**5.1 过拟合和欠拟合的解决方法**

过拟合和欠拟合是神经网络训练中常见的两个问题。过拟合是指模型在训练集上表现良好,但在新数据上表现不佳,而欠拟合是指模型在训练集和新数据上都表现不佳。

解决过拟合和欠拟合的方法包括:

**5.1.1 正则化技术**

正则化技术通过在损失函数中添加惩罚项来防止模型过拟合。常用的正则化技术包括:

* **L1正则化(Lasso回归):**惩罚权重向量的绝对值,导致稀疏解。

* **L2正则化(岭回归):**惩罚权重向量的平方值,导致更平滑的解。

**代码块:**

```matlab

% L1正则化

net = trainNetwork(data, layers, options, 'L1Regularization', 0.01);

% L2正则化

net = trainNetwork(data, layers, options, 'L2Regularization', 0.01);

```

**逻辑分析:**

`L1Regularization`和`L2Regularization`参数指定正则化项的权重。较大的权重导致更强的正则化,从而减少过拟合的风险。

**5.1.2 交叉验证和超参数优化**

交叉验证是一种评估模型泛化性能的方法,它将数据集分成多个子集,依次使用一个子集作为测试集,其余子集作为训练集。超参数优化是通过调整模型的超参数(如学习率、正则化权重)来找到最佳模型。

**代码块:**

```matlab

% 交叉验证

cv = cvpartition(data.Labels, 'KFold', 10);

% 超参数优化

options = trainingOptions('adam', ...

'MaxEpochs', 100, ...

'MiniBatchSize', 128, ...

'ValidationData', {data.TestData, data.TestLabels}, ...

'ValidationFrequency', 10, ...

'Plots', 'training-progress');

```

**逻辑分析:**

`cvpartition`函数将数据集划分为10个折,用于10折交叉验证。`trainingOptions`函数设置训练选项,包括最大训练次数、迷你批大小、验证数据和验证频率。

**5.2 训练过程的加速和并行化**

对于大型数据集或复杂模型,训练过程可能非常耗时。以下方法可以加速训练:

**5.2.1 GPU和分布式计算**

图形处理器(GPU)具有大量并行处理单元,可以显著加速神经网络训练。分布式计算将训练任务分配给多个节点,进一步提高训练速度。

**代码块:**

```matlab

% 使用GPU训练

net = trainNetwork(data, layers, options, 'useParallel', 'gpu');

% 分布式计算

distcomp = parallel.cluster.Local;

parpool(distcomp, 4); % 使用4个工作节点

```

**逻辑分析:**

`useParallel`参数指定是否使用GPU进行训练。`parpool`函数创建并行池,指定工作节点的数量。

**5.2.2 模型压缩和剪枝**

模型压缩和剪枝技术可以减少模型的大小和计算复杂度,从而加速训练和部署。

**代码块:**

```matlab

% 模型压缩

compressedNet = compressNetwork(net);

% 模型剪枝

prunedNet = pruneNetwork(net);

```

**逻辑分析:**

`compressNetwork`函数使用量化和二值化技术压缩模型。`pruneNetwork`函数移除不重要的连接和神经元,从而剪枝模型。

# 6. BP神经网络的未来发展和应用**

**6.1 深度神经网络和卷积神经网络**

深度神经网络(DNN)是一种具有多层隐藏层的神经网络。卷积神经网络(CNN)是DNN的一种特殊类型,专门设计用于处理网格状数据,如图像。

**6.1.1 CNN的结构和原理**

CNN由以下层组成:

- **卷积层:**提取输入数据的局部特征。

- **池化层:**减少卷积层的输出大小,提高鲁棒性。

- **全连接层:**将卷积层的输出映射到最终输出。

**6.1.2 CNN在图像识别和计算机视觉中的应用**

CNN在图像识别和计算机视觉领域取得了巨大的成功,应用包括:

- **目标检测:**识别图像中的对象。

- **图像分类:**将图像分类到预定义的类别中。

- **语义分割:**将图像中的每个像素分配到一个语义类别。

**6.2 强化学习和神经网络的结合**

强化学习是一种机器学习方法,它通过与环境交互并获得奖励来学习。神经网络可以用于近似强化学习中的价值函数和策略。

**6.2.1 强化学习的基本概念**

强化学习涉及以下概念:

- **状态:**环境的当前状态。

- **动作:**代理可以采取的可能动作。

- **奖励:**代理采取动作后收到的奖励。

- **价值函数:**状态的长期奖励的估计值。

**6.2.2 神经网络在强化学习中的应用**

神经网络用于强化学习中,用于:

- **值函数逼近:**使用神经网络近似状态的价值函数。

- **策略梯度:**使用神经网络估计策略的梯度,从而优化策略。

- **深度强化学习:**将DNN与强化学习相结合,解决更复杂的任务。

0

0