K折交叉验证之外:深入理解分层交叉验证的3大优势

发布时间: 2024-11-21 02:34:05 阅读量: 19 订阅数: 29

# 1. 分层交叉验证的基础概念

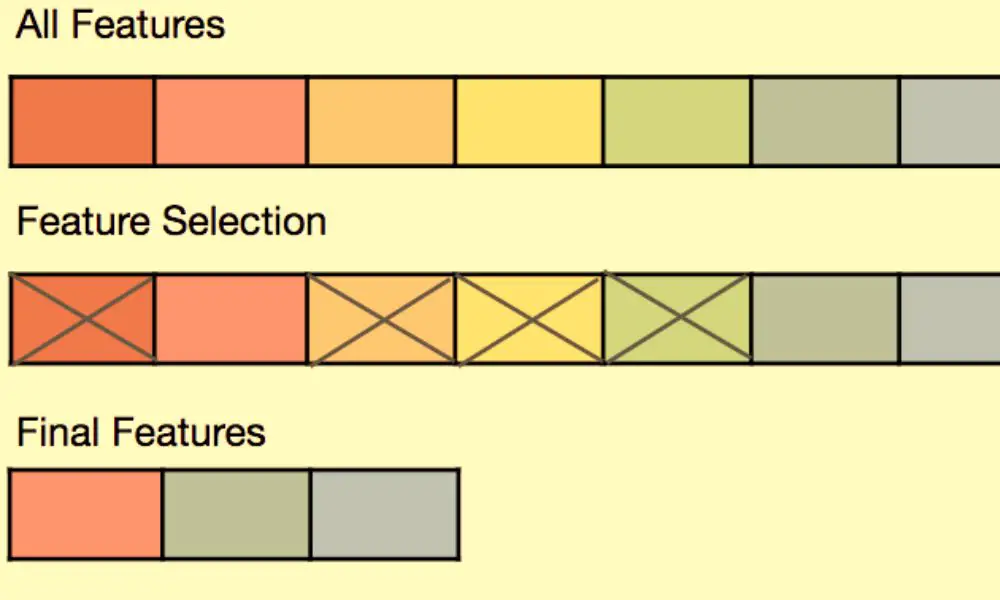

在机器学习和统计建模中,交叉验证是一种评估模型泛化能力的技术。分层交叉验证是其中的一种改进形式,特别适用于分类问题中类别不平衡的情况。它通过保证每个折叠数据集中的类别比例与原始数据集保持一致,从而避免了传统K折交叉验证可能引入的偏见。

## 1.1 分层交叉验证的目的

分层交叉验证的目的是确保模型评估过程的公正性和一致性。当数据集中的某些类别样本较少时,简单地随机划分数据可能会导致某些折叠中缺少这些类别,从而影响模型的泛化性能评估。通过分层抽样,每个子集都保留了数据的整体分布特性,使得评估结果更加可靠。

## 1.2 分层交叉验证的基本原理

与传统K折交叉验证相比,分层交叉验证在数据划分时引入了一个额外的约束条件:确保每个类别的样本在所有子集中均匀分布。这一步骤通常需要先按照类别的标签对数据进行排序,然后按照比例分配到各个折叠中。通过这种方式,模型在每一个训练和验证的组合上都能得到接近真实情况的表现。

# 2. ```

# 第二章:传统K折交叉验证的局限性

## 2.1 K折交叉验证的原理

### 2.1.1 折叠的创建和数据划分

K折交叉验证是一种广泛使用的模型评估技术,其核心思想是将原始数据集分为K个不相交的子集,每个子集轮流作为验证集,其余的K-1个子集合并后作为训练集。这种划分方法试图确保每个数据点都有机会出现在训练集和验证集中,从而提供对模型性能的稳定估计。

在这一过程中,数据划分的随机性可能导致某些类别在特定的折被过分或不足地表示。例如,在信用评分模型中,高风险借款人的样本数量可能远少于低风险借款人,K折交叉验证可能在某次划分中未能包含足够的高风险样本,导致评估结果偏向乐观。

### 2.1.2 模型的训练与评估

模型训练与评估的过程涉及以下步骤:

1. 将数据集分成K个相等大小的子集。

2. 选择K-1个子集作为训练集,将剩余的1个子集作为验证集。

3. 训练模型,并在验证集上评估模型性能,记录评估指标(如准确率)。

4. 重复步骤2和3,每次选择不同的验证集,总共进行K次训练和评估。

5. 将K次评估的结果平均,得到模型的最终性能估计。

在每一轮迭代中,模型根据训练集进行训练,并使用验证集进行性能评估。因此,K折交叉验证能够为模型的泛化能力提供更全面的视角。

## 2.2 K折交叉验证存在的问题

### 2.2.1 数据不平衡的影响

K折交叉验证的一个主要问题是它可能对数据不平衡敏感。在数据不平衡的情况下,某些类别的样本数远少于其他类别的样本数,这可能会导致在K次划分中,一些类别在训练集或验证集中被低频率地表示。这种数据分布的不均匀性可能会在模型训练中产生偏差,导致模型在某些类别上的性能被高估或低估。

### 2.2.2 随机性的波动问题

由于K折交叉验证涉及随机数据划分,它可能会受到数据划分随机性的影响。不同的划分可能会导致模型性能的显著波动,特别是当模型复杂度较高或数据集较小时。这种波动使得评估结果的解释和模型选择变得更加困难。

### 2.2.3 K值选择的主观性

K值的选择在K折交叉验证中具有一定的主观性。虽然常用的K值为5或10,但没有统一的规则来指导如何选择K值。较小的K值可能导致交叉验证的方差较大,而较大的K值可能导致计算成本更高。K值的选取需要在计算效率和评估精度之间找到适当的平衡点。

为了更深入了解K折交叉验证的局限性,下一章节将详细探讨这些问题,并引出分层交叉验证作为解决这些问题的替代方案。

```

# 3. 分层交叉验证的优势分析

#### 3.1 保持类别比例的重要性

##### 3.1.1 类别不平衡数据集的挑战

在机器学习和数据挖掘中,类别不平衡是常见的数据集问题。当一个分类问题中各类别的样本数量相差悬殊时,就出现了类别不平衡。例如,在垃圾邮件检测问题中,非垃圾邮件通常远多于垃圾邮件。类别不平衡对模型的性能产生负面影响,尤其是对那些基于统计方法的模型。

类别不平衡导致的最直接的问题是,多数类样本将对模型的训练过程产生更大的影响,而少数类样本可能被忽略,从而导致模型在预测时偏向多数类。在极端情况下,模型甚至可能会“学会”忽略少数类,只对多数类进行预测。

##### 3.1.2 分层方法确保类别平衡

为了应对类别不平衡问题,分层交叉验证成为了一种有效的技术。通过分层方法,数据集被分成具有相似类别比例的子集,确保了在每次训练和验证过程中,类别比例得到保持。这意味着,每个折叠都包含了大致相同数量的正样本和负样本,从而使模型对少数类更加敏感。

#### 3.2 分层交叉验证的实施步骤

##### 3.2.1 分层抽样的方法

分层抽样是分层交叉验证的第一步,目的是创建出具有相似类别比例的训练集和验证集。实施分层抽样时,首先需要对数据集按照目标变量进行分层。然后从每一层中随机抽取样本,以确保在训练和验证集中保持原有比例。

这种抽样方式与简单的随机抽样不同,后者不考虑类别分布,可能会在某些折叠中产生类别严重不平衡的情况。分层抽样使得每一折的样本更加代表整个数据集的分布,从而提高了交叉验证的准确性和稳定性。

##### 3.2.2 模型评估的稳定性提高

分层交叉验证的核心优势之一是提升了模型评估的稳定性。由于每一折的验证集都保持了类别平衡,模型的性能评估不再受到某一类别样本数量波动的影响。这使得评估结果更加可靠,因为它们反映了模型在各种不同类别分布下的真实表现。

在传统的K折交叉验证中,如果某一折的类别比例发生较大偏移,那么评估结果可能会高估或低估模型的实际能力。通过分层保持比例,评估的方差得到减少,评估结果对数据划分的变化不再那么敏感。

#### 3.3 分层交叉验证的理论基础

##### 3.3.1 统计学中的代表性抽样

分层交叉验证基于统计学中的代表性抽样理论。代表性抽样要求样本能够反映总体的特征,这样基于样本得到的结论才能推广到总体。通过确保每个折叠都保持数据集的类别比例,分层交叉验证增强了抽样的代表性。

这一点在处理少数类问题时尤为重要。在没有分层的情况下,少数类可能在某些折叠中完全缺失,导致模型无法学习到这些类别的重要性。而分层抽样确保了每个类别在训练和验证过程中都被考虑到,从而提高了模型对少数类的识别能力。

##### 3.3.2 预测准确性的改善

分层交叉验证不仅提高了模型评估的稳定性,还能够在很多情况下改善模型的预测准确性。尤其是当原始数据集的类别分布不均匀时,分层交叉验证通过确保每一折的类别平衡,使得模型在学习时能够更好地识别少数类的特征。

这种改善在处理具有高度不平衡分布的数据集时尤为明显,如欺诈检测或罕见疾病预测等。通过分层交叉验证,模型对少数类的预测能力得到了提升,这直接反映在了整体的预测准确率上。

分层交叉验证的理

0

0