【Python文件处理优化】:提升批量操作速度的5大策略

发布时间: 2024-12-12 01:30:07 阅读量: 17 订阅数: 12

Python批量重命名文件

# 1. Python文件处理优化概述

Python作为一门功能强大的编程语言,文件处理是其基本且重要的应用领域之一。本章旨在为读者提供一个关于Python文件处理优化的全面概览,从基础文件操作到高级处理技术,以及优化内存和磁盘I/O的策略,每个部分都将结合实际案例进行深入探讨。

## 1.1 Python文件处理的重要性

在数据密集型应用中,文件读写操作频繁,高效的文件处理可以极大提升程序性能和用户体验。Python提供了一系列的内置函数和模块来简化文件的处理流程,但优化的空间仍然很大。开发者需要对I/O操作有深刻的理解,才能有效地减少执行时间和资源消耗。

## 1.2 文件处理优化的目标

优化文件处理流程的目标在于提高数据处理速度、减少内存使用、增强程序的稳定性和可扩展性。这些目标涉及到了解不同的读写模式、使用高效的数据处理函数、合理分配系统资源等多个方面。通过本章的学习,读者将掌握一系列实用的文件处理技巧和优化方法,为处理大规模数据打下坚实的基础。

# 2. 基础文件处理技巧

### 2.1 文件读写模式的优化

#### 2.1.1 选择合适的文件读写模式

在Python中,文件可以以不同的模式打开,这包括读模式 ('r')、写模式 ('w')、追加模式 ('a') 和二进制模式 ('b')。正确选择读写模式对于优化文件操作至关重要。使用不当的模式可能会导致数据丢失或者不必要地重写文件。

以写模式 ('w') 打开文件时,如果文件已存在,它的内容将被清空。而以追加模式 ('a') 打开文件时,写入的数据将被添加到文件末尾,而不是覆盖原有内容。这对于日志文件等场景非常有用。二进制模式 ('b') 用于处理非文本数据,比如图片或视频文件。

选择模式的示例代码:

```python

# 读取文件内容

with open('example.txt', 'r') as file:

content = file.read()

# 向文件末尾追加内容

with open('example.txt', 'a') as file:

file.write('\nNew line appended.')

# 以二进制模式打开并写入数据

with open('image.png', 'wb') as file:

file.write(binary_data)

```

#### 2.1.2 使用with语句管理文件资源

使用`with`语句来管理文件是一种好的编程实践,它可以确保文件在使用完毕后正确关闭,即使在文件操作过程中发生异常也能保证文件资源被正确释放。`with`语句是一种上下文管理器的用法,它减少了代码量,并提高了代码的健壮性。

上下文管理器的示例代码:

```python

# 使用with语句读取文件确保文件正确关闭

with open('example.txt', 'r') as file:

for line in file:

print(line, end='')

# 没有使用with语句的情况

file = open('example.txt', 'r')

try:

for line in file:

print(line, end='')

finally:

file.close()

```

### 2.2 利用内建函数提高效率

#### 2.2.1 使用map和filter减少循环开销

`map`函数可以将一个函数应用于一个可迭代对象中的每个元素,返回一个新的迭代器,这样可以省去手动循环的开销。`filter`函数则返回一个迭代器,它会遍历输入的可迭代对象,只有满足条件的元素会被包含在返回的迭代器中。

使用`map`和`filter`的示例代码:

```python

# 使用map函数应用数学操作

squared_numbers = map(lambda x: x * x, range(10))

# 使用filter函数筛选出偶数

even_numbers = filter(lambda x: x % 2 == 0, range(10))

```

逻辑分析:

上述代码展示了如何使用`map`和`filter`替代传统的循环结构。在第一行代码中,使用了一个匿名函数(lambda),将每个数字进行平方运算。在第二行代码中,使用了另一个匿名函数来检查数字是否为偶数。

#### 2.2.2 利用生成器表达式优化内存使用

生成器表达式提供了一种内存高效的方式来创建迭代器。生成器表达式的形式与列表推导式相似,但它们不会一次性生成所有元素,而是生成一个元素后就会暂停,直到需要下一个元素时才继续计算。

使用生成器表达式的示例代码:

```python

# 列表推导式创建一个包含1百万个元素的列表

big_list = [x * 2 for x in range(1000000)]

# 生成器表达式创建一个迭代器,不会占用过多内存

big_gen = (x * 2 for x in range(1000000))

```

逻辑分析:

生成器表达式与列表推导式的区别在于,列表推导式会创建一个完整的列表对象并存放在内存中,而生成器表达式则按需生成元素,不需要占用大量内存。对于处理大量数据时,这是提高内存效率的重要方法。

### 2.3 字符串处理优化

#### 2.3.1 使用字符串的join方法合并数据

使用字符串的`join`方法可以有效地合并多个字符串片段,特别是当需要将一个可迭代对象中的字符串元素合并为一个单一字符串时。与使用`+`运算符进行字符串连接相比,`join`方法通常更快,因为它避免了创建多个中间字符串对象。

使用`join`方法的示例代码:

```python

# 使用+运算符合并字符串列表

strings = ['Hello', 'world', '!']

result = ''.join(strings) # 'Helloworld!'

# 使用join方法合并字符串列表

result = ''.join(strings) # 'Helloworld!'

```

逻辑分析:

在第一行代码中,我们使用了`+`运算符,Python会创建新的字符串对象并合并。而在第二行中,`join`方法被调用时,Python会创建一个足够大的缓冲区来存放最终的字符串,并逐个将元素添加到该缓冲区。由于`join`方法在合并时只需要创建一个字符串对象,所以在处理大量数据时,可以显著减少内存分配。

#### 2.3.2 利用字符串格式化提高输出效率

Python提供了多种字符串格式化的方法,包括`%`操作符、`str.format`方法和f-string(Python 3.6+)。这些方法提供了灵活的格式化选项,但在不同的场合下,选择合适的格式化方法可以提高代码的执行效率和可读性。

使用不同格式化的示例代码:

```python

# 使用%操作符格式化字符串

name = "Alice"

message = "Hello, %s!" % name

# 使用str.format方法格式化字符串

message = "Hello, {}!".format(name)

# 使用f-string进行字符串格式化

message = f"Hello, {name}!"

```

逻辑分析:

`%`操作符和`str.format`方法都能提供丰富的格式化选项,但在较新版本的Python中,f-string以其简洁和执行速度快的优势而受到推崇。f-string背后的操作是直接将表达式的结果内嵌到字符串字面量中,避免了额外的函数调用和字符串拼接开销。

### 2.4 文件读写技巧总结

在处理文件时,选择正确的读写模式、合理使用`with`语句管理资源、利用内建函数减少循环开销、优化内存使用,以及使用字符串格式化提高输出效率,这些都是提高Python文件处理效率的关键因素。

在本小节中,我们了解了如何通过选择适当的文件读写模式来保护数据完整性,明白了`with`语句如何简化代码并保证资源的正确释放,学习了`map`和`filter`函数如何减少代码中的循环开销,以及如何利用生成器表达式优化内存使用。此外,我们还探讨了`join`方法和字符串格式化的不同应用,以及如何通过这些方法提高字符串处理的效率。

在下一小节中,我们将继续深入探讨文件处理的高级技巧,包括如何利用并行处理来加快文件处理速度,如何使用外部工具辅助文件操作,以及如何有效地处理大文件。

# 3. 高级文件处理技术

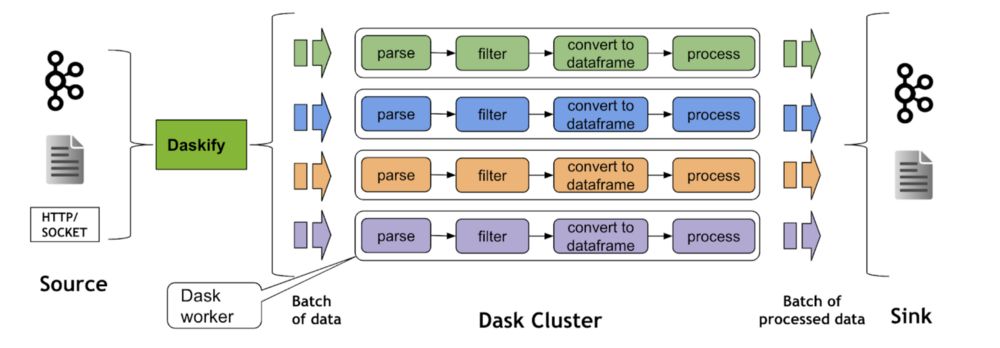

## 3.1 并行处理文件

### 3.1.1 理解并行处理的优势与局限

并行处理是指同时使用多个计算资源来解决一个任务,以缩短完成时间。在处理大量文件时,采用并行处理技术能够显著提高处理速度,尤其是在多核心CPU的现代计算机上。

优势方面,通过并行处理,可以同时执行多个操作,将原本需要逐个完成的任务分散到不同的CPU核心上,减少了总体的执行时间。在处理大规模数据集时,这能够大幅提升效率。

然而,并行处理也有局限性。首先,必须考虑到并行化带来的额外开销。线程或进程的创建和管理需要时间和资源,如果任务过小,这些开销可能会抵消并行带来的好处。其次,由于线程或进程间的资源竞争和同步问题,复杂性可能会增加。特别是在涉及共享资源时,需要谨慎地设计并行代码,避免竞争条件和死锁。

在设计并行文件处理程序时,选择合适的粒度非常关键。过于粗糙的并行任务划分可能导致资源分配不均,而过于细小的任务划分则会带来过多的调度开销。并行任务的大小需要根据处理任务的类型和系统环境进行适当调整。

### 3.1.2 使用多进程或多线程进行文件处理

多进程和多线程是实现并行文件处理的两种主要方式。它们各有优势,适用于不同场景。

多进程模型中,进程是独立的执行单元,拥有自己的内存空间。这种方式的好处是稳定性和安全性,由于进程间的内存是隔离的,因此一个进程崩溃通常不会影响到其他进程。Python中可以使用`multiprocessing`模块来实现多进程文件处理。

多线程模型则允许不同的线程共享同一进程的内存空间,这可以减少内存的使用,但也带来了线程同步和竞争条件的复杂性。Python的`threading`模块允许我们创建和管理线程。

以下是一个简单的多线程文件处理示例代码:

```python

import threading

import os

```

0

0