【数据流分析】:MapReduce小文件问题——内存与磁盘的实战抉择

发布时间: 2024-11-01 03:53:12 阅读量: 20 订阅数: 26

基于MapReduce+Pandas的电影排名与推荐以及数据分析与可视化展示

# 1. MapReduce小文件问题概述

随着大数据时代的到来,MapReduce作为大数据处理的重要模型,在实际应用中面临着诸多挑战,其中小文件问题尤为突出。所谓小文件,指的是那些文件尺寸小于HDFS(Hadoop Distributed File System)块大小的文件。它们在大规模数据分析中会带来显著的性能问题,比如资源浪费、I/O瓶颈和处理效率低下等。

本章节旨在为读者提供MapReduce小文件问题的概览,简要介绍其成因、影响以及在实际工作中的表现形式。接下来的章节会深入探讨小文件问题的理论基础、实践挑战、优化实践,最终展望小文件处理的未来趋势和解决方案。

## 1.1 小文件问题的普遍性

小文件问题在许多应用场景中普遍存在,特别是在日志分析、网络爬虫数据处理以及图像和视频数据存储等场景中尤为显著。这类问题不仅影响了数据处理的效率,还可能引起系统资源的过度消耗。

## 1.2 小文件对性能的影响

小文件会使得Map任务的数量急剧增加,从而导致大量的启动开销和任务调度开销,极大地影响了系统的整体性能。在MapReduce模型中,大量小文件会导致Map阶段的输入输出量远大于实际处理的数据量,这种不均衡的状态会对处理速度造成严重的影响。

在下一章中,我们将详细讨论MapReduce模型的核心原理,以及它是如何与小文件问题相互作用,并进一步分析小文件对性能造成负面影响的原因。

# 2. MapReduce小文件问题的理论基础

## 2.1 MapReduce模型的核心原理

MapReduce模型是处理大数据的一种编程模型,被广泛应用于Hadoop分布式计算框架中。其核心思想在于将复杂的、大规模数据集的处理工作分解为Map(映射)和Reduce(归约)两个阶段。理解这两阶段的工作机制对于了解小文件问题至关重要。

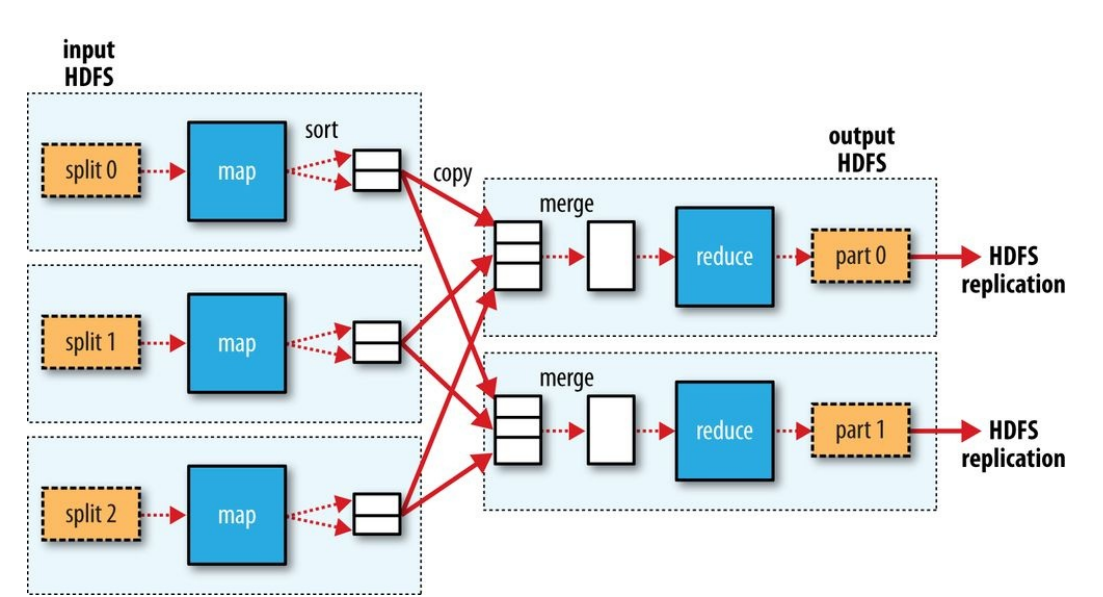

### 2.1.1 MapReduce的工作流程解析

MapReduce的工作流程可以分为以下几个步骤:

1. 输入数据处理:首先,将输入数据分割成等长的数据块(split),为Map任务准备输入。

2. Map阶段:每个Map任务处理一个数据块,读取输入数据,并通过用户提供的Map函数处理,生成中间键值对(key-value pairs)。

3. Shuffle阶段:Map任务完成后,中间输出的键值对需要进行排序和分组,将具有相同key的键值对分配到同一个Reduce任务上。

4. Reduce阶段:Reduce任务接收到所有相同key的键值对后,对它们应用Reduce函数,得到最终结果。

5. 输出:最后,所有Reduce任务的输出结果会被合并成最终结果,进行存储或者后续处理。

MapReduce框架隐藏了大多数底层的并行处理和容错细节,使得开发人员可以专注于编写Map和Reduce函数。

### 2.1.2 Map和Reduce阶段的数据流分析

在Map阶段,数据流从输入数据到中间输出的键值对,每个Map任务根据Map函数处理分给它的数据块。Map函数输出的结果必须能够被排序和分组,这一步是Shuffle阶段的基础。

在Shuffle阶段,系统会根据键值对的key进行排序,确保所有具有相同key的键值对都在同一Reduce任务上。这一步是MapReduce模型中的关键,因为大量的数据传输和网络开销都发生在这个阶段。

最后,在Reduce阶段,每个Reduce任务接收到所有的键值对后,将具有相同key的值聚合成一个结果。这个阶段是数据合并的过程,也是数据处理逻辑的集大成者。

## 2.2 小文件问题的成因和影响

小文件问题是指在MapReduce处理过程中遇到的性能瓶颈,这一问题主要是由于文件数量过多、文件体积过小导致的。由于MapReduce对输入文件的处理方式,小文件问题会造成显著的性能下降。

### 2.2.1 小文件对性能的负面影响

小文件对性能的影响主要体现在以下几个方面:

- **文件系统负载增加**:由于MapReduce框架通常使用HDFS(Hadoop Distributed File System)作为存储层,大量小文件会导致NameNode的内存使用增加,影响整个集群的稳定性。

- **Map任务启动过多**:每一个小文件或小文件块通常对应一个Map任务,过多的Map任务会导致任务调度和上下文切换的开销增加。

- **I/O瓶颈**:小文件数量的增多,会导致磁盘I/O操作的频繁,增加了磁盘的磨损,降低数据处理效率。

### 2.2.2 小文件问题的场景与案例分析

在许多实际的业务场景中,如日志分析、数据挖掘等,都可能产生小文件问题。以日志分析为例,每个日志文件可能只记录了少部分日志数据,但是当处理成千上万个这样的日志文件时,就很容易造成小文件问题。

#### 案例分析:日志文件处理

假设一家公司有数以百万计的用户访问记录,这些记录存储在多个日志文件中,每个日志文件平均只有几十KB大小。当使用MapReduce模型处理这些日志时,由于文件数量庞大,HDFS中会创建许多对应的元数据,导致NameNode内存压力增大。同时,由于每个Map任务处理一个小文件,会导致Map任务数量过多,增大了资源调度的难度,进而影响了整个作业的性能。

## 2.3 本章节总结

MapReduce模型是处理大数据的重要工具,但其核心原理在面对大量小文件时会遇到性能挑战。了解MapReduce的工作流程和数据流能够帮助我们更好地认识到小文件问题的成因。在接下来的章节中,我们将深入探讨具体的解决方案,包括传统策略和优化实践,以及深入的案例分析。

# 3. 小文件问题的实践挑战

随着数据量的爆炸性增长,处理小文件的问题日益凸显,这在分布式计算的实践中尤为突出。小文件问题不仅仅是数据量的问题,更是一个涉及到计算资源、存储效率和系统性能等多方面因素的复杂问题。在本章中,我们将深入探讨小文件问题带来的实践挑战,并提供一些解决策略。

## 3.1 传统处理小文件的策略

在讨论如何处理小文件之前,我们先回顾一下在传统环境中,已经采取的一些策略。

### 3.1.1 Hadoop生态中的Combiner使用

在Hadoop的MapReduce框架中,Combiner是一种优化工具,它可以局部地合并Map任务的输出结果,从而减少数据传输量和降低Reducer阶段的负担。尽管它并不能解决小文件问题,但在一定程度上可以缓解由小文件造成的性能下降。

```java

// 示例:在Hadoop MapReduce作业中配置Combiner

Job job = Job.getInstance(getConf(), "Combiner Example");

job.setJarByClass(YourClass.class);

job.setMapperClass(YourMapper.class);

job.setCombinerClass(YourCombiner.class); // 设置Combiner

job.setReducerClass(YourReducer.class);

job.setOutputKeyClass(Text.class);

job.setOutputValueClass(IntWritable.class);

```

Combiner的使用在一定程度上减少了网络传输的数据量,它通常与自定义的Reducer逻辑结合使用,以执行局部的聚合操作。如果Map的输出key-value对数量庞大,而这些key-value对又具有自然的合并特性,那么使用Combiner是有效的。

### 3.1.2 自定义InputFormat和RecordReader

当面对大量的小文件时,使用默认的InputFormat可能并不合适,因为这会为每个小文件创建一个Map任务,导致Map任务的数量激增。自定义InputFormat允许我们将多个小文件组织到一个InputSplit中,然后由一个Map任务来处理,这可以减少Map任务的数量,从而减少管理开销。

```java

// 示例:自定义InputFormat的继承关系

public class CustomInputFormat extends FileInputFormat<LongWritable, Text> {

@Override

public RecordReader<LongWritable, Text> createRecordReader(InputSplit split, TaskAtt

```

0

0