【强化学习】让机器学会智能决策:原理与应用的全面解读

发布时间: 2024-11-29 03:40:05 阅读量: 74 订阅数: 47

机器学习算法概述、原理及应用.pdf

参考资源链接:[《机器学习(周志华)》学习笔记.pdf](https://wenku.csdn.net/doc/6412b753be7fbd1778d49e56?spm=1055.2635.3001.10343)

# 1. 强化学习的基本概念与框架

## 引言:强化学习的崛起

强化学习是机器学习领域中一种先进的技术,它通过从环境反馈中学习,使得智能体能够在没有明确指导的情况下,作出最优决策。与监督学习和非监督学习不同,强化学习强调的是通过奖励机制和探索-利用权衡来实现目标。

## 1.1 强化学习的定义

强化学习是研究如何构建智能体(Agent)在给定环境(Environment)中学习决策策略,以最大化累积奖励的科学。通过与环境的互动,智能体能逐渐改进其行为策略,从而达到长期收益的最大化。

## 1.2 强化学习的关键组成部分

智能体在强化学习中与环境进行互动,关键组成部分包括:

- **状态(State)**:智能体所处环境的描述。

- **动作(Action)**:智能体可以执行的操作。

- **奖励(Reward)**:智能体执行动作后环境给予的反馈。

- **策略(Policy)**:智能体决定动作的规则。

## 1.3 强化学习的框架

强化学习的框架主要由马尔可夫决策过程(MDP)构成,其中包含状态转移概率、奖励函数、折扣因子等关键元素。其核心在于智能体通过不断试错,以获得最优策略,实现对环境的有效控制。

## 1.4 强化学习的应用场景

强化学习的应用非常广泛,从简单的游戏到复杂的机器人控制、自动驾驶、资源管理等。通过强化学习技术,能够使得系统在不确定性环境下做出更加精确和高效的决策。

## 1.5 强化学习与深度学习的结合

深度强化学习(DRL)是将深度学习与强化学习相结合的产物。深度学习在处理高维数据(如图像、声音)方面的优势,为强化学习解决复杂环境下的决策问题提供了新途径。

# 2. 强化学习的算法基础

强化学习算法是理解和实现强化学习的关键,它们根据智能体在环境中的交互经验来学习最优策略。本章我们将深入探讨强化学习中的核心算法,以及它们如何通过马尔可夫决策过程(MDP)来驱动智能体采取行动并从结果中学习。

## 2.1 马尔可夫决策过程(MDP)

### 2.1.1 MDP的数学定义

MDP提供了一个数学框架,用于描述在给定当前状态和选择的行为下,智能体如何做出决策以及如何到达下一个状态和获得相应奖励的过程。一个MDP通常由以下元素组成:

- 状态空间 \( S \)

- 行动空间 \( A \)

- 转移概率 \( P(s'|s,a) \),即从状态 \( s \) 采取行为 \( a \) 后,转移到状态 \( s' \) 的概率。

- 奖励函数 \( R(s,a,s') \),即从状态 \( s \) 采取行为 \( a \) 并转移到状态 \( s' \) 所获得的即时奖励。

- 折扣因子 \( \gamma \),用于平衡即时奖励和未来奖励之间的权重。

为了数学上描述MDP,可以使用六元组 \( M = (S, A, P, R, \gamma) \)。

### 2.1.2 MDP中的策略与价值函数

策略 \( \pi \) 是指在任何状态下智能体选择行为的规则。价值函数是评估策略好坏的关键,它决定了在某个状态下采取某个行为所期望的累积回报。存在两种主要的价值函数:

- 状态价值函数 \( V^\pi(s) \):给定策略 \( \pi \),在状态 \( s \) 期望获得的累积回报。

- 动作价值函数 \( Q^\pi(s,a) \):给定策略 \( \pi \),从状态 \( s \) 出发,采取行为 \( a \) 后期望获得的累积回报。

策略可以通过最大化价值函数来进行改进,从而实现学习过程中的优化。

## 2.2 强化学习中的策略和价值迭代

### 2.2.1 策略迭代算法

策略迭代是一种强化学习算法,通过迭代过程交替进行策略评估和策略改进。具体步骤如下:

1. **策略评估**:给定当前策略 \( \pi \),计算状态价值函数 \( V^\pi \)。

2. **策略改进**:利用状态价值函数,对于每个状态,更新策略以选择当前状态下价值最高的动作。

策略迭代可以保证收敛到最优策略,但其计算复杂度较高,特别是在状态空间和行为空间较大时。

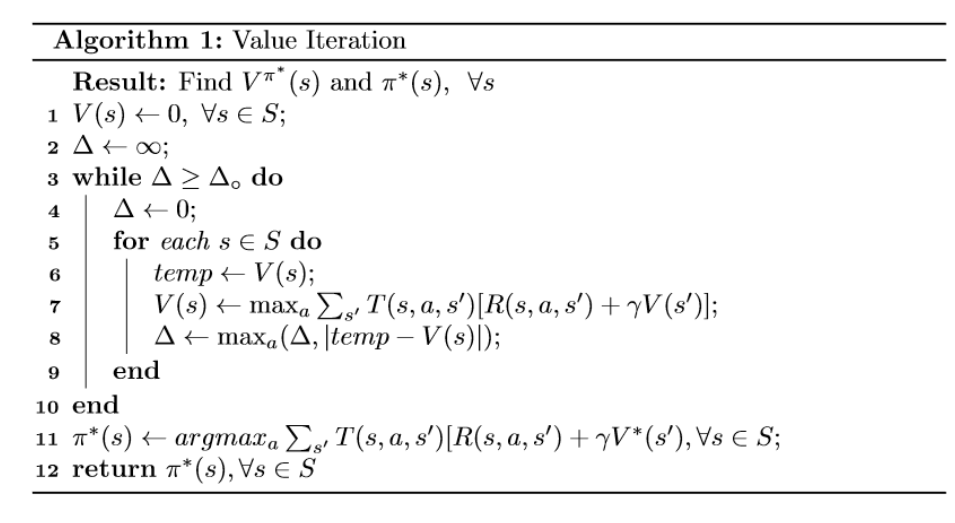

### 2.2.2 价值迭代算法

价值迭代是另一种有效的强化学习算法,它通过迭代过程直接改进价值函数来实现策略的改进。算法流程如下:

1. **初始化价值函数**:对于所有状态 \( s \) 初始化 \( V(s) \)。

2. **迭代更新**:对于每次迭代,更新所有状态的价值 \( V(s) \):

\[ V(s) \leftarrow \max_a \sum_{s'} P(s'|s,a) [ R(s,a,s') + \gamma V(s') ] \]

3. **策略提取**:根据更新的价值函数 \( V \),重新定义策略 \( \pi(s) \) 为对应最大动作。

价值迭代在每次迭代过程中都会尝试获得最大的价值改善,因而比策略迭代更快收敛,但在收敛到最优策略之前,它的策略可能比策略迭代的策略要差。

### 2.2.3 策略评估方法

策略评估是确定给定策略的期望回报的过程。评估方法中最重要的是线性方程组的求解,涉及使用动态规划技术。具体操作如下:

- 状态价值函数 \( V^\pi(s) \) 可以通过以下贝尔曼方程来评估:

\[ V^\pi(s) = \sum_a \pi(a|s) \sum_{s'} P(s'|s,a) [ R(s,a,s') + \gamma V^\pi(s') ] \]

- 利用迭代方法求解这个线性方程组,如高斯-赛德尔迭代或雅可比迭代。

- 在实际应用中,状态空间往往过大,无法直接求解,因此引入近似方法或函数逼近技术。

以下是动态规划中的策略评估的伪代码:

```python

# 策略评估伪代码示例

def policy_evaluation(env, policy, theta=1e-10, discount_factor=1.0):

V = np.zeros(env.observation_space.n)

while True:

delta = 0

for s in range(env.observation_space.n):

v = V[s]

# 计算状态s在策略下的价值

V[s] = sum([policy[s, a] * sum([env转移概率矩阵[s, a, s2] * (env奖励矩阵[s, a, s2] + discount_factor * V[s2])

for s2 in range(env.observation_space.n)]) for a in range(env.action_space.n)])

delta = max(delta, np.abs(v - V[s]))

if delta < theta:

break

return V

```

上述代码中,`policy` 是一个包含每个状态下行为概率的矩阵,`env` 包含了环境相关的转移概率矩阵和奖励矩阵等参数,`theta` 是收敛的阈值,`discount_factor` 是折扣因子。

## 2.3 模型与模型无关的强化学习算法

### 2.3.1 时序差分学习(TD Learning)

时序差分学习是模型无关的强化学习方法,它结合了蒙特卡罗方法和动态规划的优点。TD学习直接使用经验数据来更新价值函数,避免了环境模型的需求。其基本形式如

0

0