BERT模型精髓:深度剖析并应用预训练语言模型

发布时间: 2024-09-03 13:46:58 阅读量: 97 订阅数: 59

自然语言处理领域的深度双向变压器预训练模型BERT及其应用

# 1. BERT模型的基础理论

## 1.1 深度学习与自然语言处理的发展

深度学习技术的兴起为自然语言处理(NLP)领域带来了革命性的变化,特别是预训练语言模型的出现,极大地提升了文本理解的能力。BERT(Bidirectional Encoder Representations from Transformers)作为这一领域的佼佼者,其基础理论和技术影响深远。

## 1.2 BERT模型的创新之处

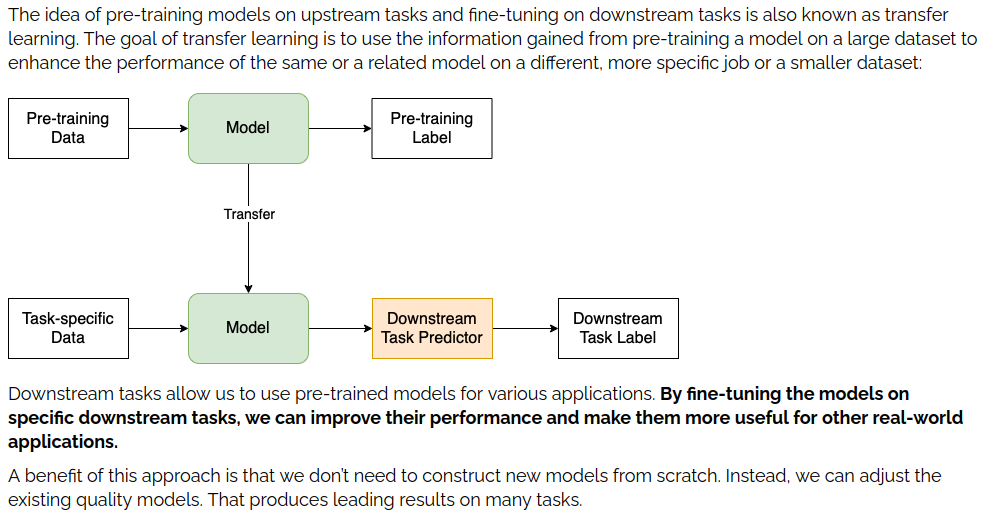

BERT模型的创新在于它采用的双向Transformer编码器架构,它能够充分捕捉到文本中的双向上下文信息。这种预训练+微调的模式,不仅简化了模型的训练过程,而且提高了模型在各种NLP任务中的表现。

## 1.3 BERT的应用前景

BERT的出现不仅改变了机器阅读理解、问答系统等NLP任务的处理方式,也为未来的深度学习和自然语言处理技术提供了新的研究方向和应用可能性,对IT行业和相关领域产生了深远的影响。

# 2. BERT模型的内部机制深入解析

## 2.1 BERT的模型架构

### 2.1.1 Transformer的结构和工作原理

Transformer模型是BERT的基础,它完全基于自注意力机制(self-attention),以及多头注意力机制(multi-head attention),这种结构允许模型在处理序列数据时考虑位置之间的依赖关系,而不需要递归神经网络(RNN)和卷积网络(CNN)的顺序处理方式。

Transformer的编码器(Encoder)由多层重复的单元组成,每*单元包含一个多头自注意力层和一个前馈神经网络,同时引入了残差连接和层归一化技术。解码器(Decoder)除了包含编码器中的层外,还加入了编码器-解码器注意力机制,使得在解码时能够关注输入序列的不同部分。

Transformer模型的核心在于自注意力机制。对于序列中的每一个元素,自注意力机制都会生成一个加权表示,权重由元素间的相似度决定。例如,对于文本序列,如果两个单词经常一起出现,它们将获得较高的相似度分数,从而在计算加权表示时获得更高的权重。

```mermaid

graph LR

A[输入序列] -->|词嵌入| B[位置编码]

B -->|输入| C[编码器层]

C -->|输出| D[解码器层]

D -->|输出| E[最终输出]

```

### 2.1.2 BERT中的关键改进点

BERT引入了双向Transformer结构,并通过掩码语言模型(Masked Language Model, MLM)和下一个句子预测(Next Sentence Prediction, NSP)两种预训练任务来对模型进行训练。

MLM任务随机遮蔽一部分输入序列中的单词,并让模型预测这些被遮蔽的单词。与传统的语言模型不同,MLM不仅可以学习到从左到右的文本表示,还可以学习从右到左的信息,这使得模型能够获取双向上下文信息。

NSP任务则是通过预测两个句子是否在原文中是连续的来帮助模型更好地理解句子间的逻辑关系,使得BERT能够生成更加准确的句子嵌入表示。

## 2.2 BERT的预训练过程

### 2.2.1 预训练的目标和任务

BERT模型的预训练分为两个主要任务:MLM和NSP。在MLM任务中,输入序列的一部分单词被随机遮蔽,模型需要预测这些单词。这个过程允许BERT捕捉到丰富的双向上下文信息,从而更好地理解语言的细微含义。

在NSP任务中,模型接收一对句子作为输入,并被训练来预测这两个句子是否在原文中相邻。这个任务促使模型学习句子间的关联性,这对于理解对话和复杂文本至关重要。

```mermaid

graph LR

A[输入序列] -->|MLM任务| B[预测遮蔽单词]

A -->|NSP任务| C[预测句子关联性]

```

### 2.2.2 上下文理解的实现方式

BERT通过Transformer层实现双向上下文理解,这是其关键创新之一。自注意力机制使模型能够为每个单词生成一个基于所有输入单词的表示,而不仅仅是依赖于单向的上下文信息。

这种能力是通过为输入序列中的每个单词分配一个唯一的token来实现的,例如,对于特殊词[CLS]和[SEP],以及对于输入序列中的每个单词。然后,这些token通过自注意力层进行处理,使得每个token的输出表示都融合了输入序列中所有其他token的信息。

### 2.2.3 预训练数据的选择和处理

BERT预训练需要大量的无标注文本。为训练出一个通用的模型,通常会使用多种类型的文本数据,包括书籍、维基百科和其他网页内容。这些数据会被预处理,比如转换成小写、去除特殊字符等。

预处理还包括将文本分割成标记(tokens),并为每个句子添加特殊的标记[CLS]和[SEP]。这些特殊标记为模型提供了必要的上下文信息,并且[CLS]标记的输出被用来表示整个句子,这对于分类等下游任务非常有用。

## 2.3 BERT的微调策略

### 2.3.1 微调的原理和方法

微调是将BERT应用于特定下游任务的关键步骤。这涉及到将预训练好的BERT模型作为基础,并在其上添加一些额外的层,通常是几个全连接层。然后,整个网络会在特定任务的数据集上进行训练,学习任务特定的特征。

微调过程中,BERT的权重会根据下游任务进行调整,这通常只需要较少的训练步骤。与从头开始训练相比,微调能够利用预训练模型已有的丰富语言表示,从而在很多任务上取得更快的收敛速度和更好的性能。

### 2.3.2 微调对性能的影响

微调可以显著提升BERT在特定任务上的性能,因为它允许模型在微调数据集上进行更细粒度的学习。这意味着模型能够适应特定任务的细节,而不仅仅是依赖于预训练阶段学习到的一般语言特征。

微调带来的性能提升取决于多个因素,包括预训练模型的质量、微调数据的数量和质量,以及微调过程中使用的超参数。由于BERT的参数数量巨大,微调也要求有足够的数据来避免过拟合。

### 2.3.3 微调的最佳实践

为了有效地微调BERT模型,需要遵循一些最佳实践。首先,应当根据下游任务的性质来设计微调的架构,例如,对于文本分类任务,会在BERT的输出上添加一个或多个全连接层。

其次,选择合适的训练策略和超参数设置至关重要。通常需要进行多次实验来找到最佳的学习率、批次大小、微调的轮数以及正则化技术。

最后,监控和分析微调过程中的性能指标,如验证集上的准确度和损失值,可以帮助诊断问题并及时调整训练策略。此外,对于计算资源有限的情况,可以采用知识蒸馏等技术减小模型大小,以降低微调所需的计算成本。

# 3. BERT模型的实践应用

BERT模型的理论基础和内部机制的了解是实践应用的前提。在本章中,我们将深入了解如何将BERT模型应用于不同的NLP任务中,并通过具体案例分析其实际效果和可能的优化策略。

## 3.1 B

0

0