【HDFS数据同步的容错机制】:打造高可用同步方案的策略与技巧

发布时间: 2024-10-29 11:55:20 阅读量: 30 订阅数: 41

hdfs资料整理

# 1. HDFS数据同步的背景与重要性

在当今数据驱动的时代,数据同步已经成为IT行业中的一个核心概念,尤其是在构建大规模分布式系统时,如Hadoop分布式文件系统(HDFS)。数据同步对于保证数据的一致性、完整性和高可用性至关重要,它确保了数据在多个节点或多个数据中心间能够安全、高效地共享和复制。

数据一致性是分布式系统设计的关键要素之一。在HDFS环境中,数据同步不仅是为了防止数据丢失,更是为了在节点故障或网络分区时,保持系统的整体运行和数据的可用性。同步机制还帮助实施数据备份和灾难恢复策略,这对于维护企业级应用的连续性和业务的可持续性至关重要。

除了这些基础需求,数据同步在优化查询性能、支持实时数据处理和分析方面也发挥着关键作用。接下来的章节将探讨HDFS数据同步的基础理论、容错机制实践、高可用同步方案的构建以及未来的技术应用和挑战。

# 2. HDFS数据同步的基础理论

## 2.1 Hadoop分布式文件系统(HDFS)概述

### 2.1.1 HDFS的基本架构

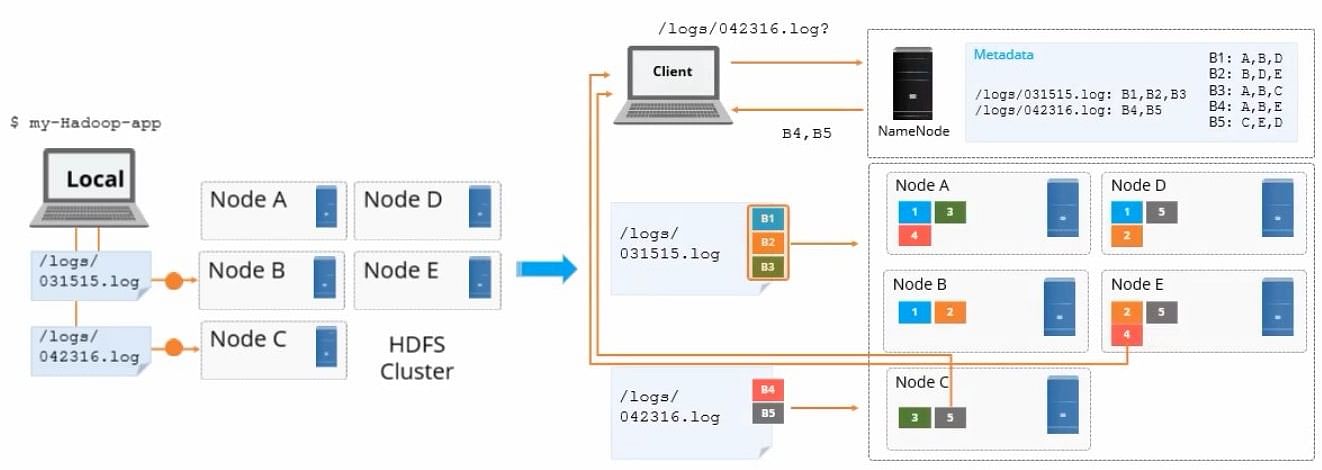

Hadoop分布式文件系统(HDFS)是Hadoop核心组件之一,设计用于存储大量的数据集。它采用了主/从(Master/Slave)架构,主要由两个关键组件构成:NameNode(名称节点)和DataNode(数据节点)。

**NameNode**:

- 负责管理文件系统命名空间;

- 维护文件系统树及整个树内所有文件的元数据;

- 记录每个文件中各个块所在的DataNode节点,并不存储实际数据。

**DataNode**:

- 在集群中各节点上运行;

- 负责处理文件系统客户端的读/写请求;

- 在本地文件系统中存储数据块,并处理块的创建、删除和复制等操作。

HDFS架构设计为高容错性,并假定硬件故障是常态。这种设计通过数据的多副本存储来实现,通常每个数据块会有三个副本分别存储在不同的DataNode上。

### 2.1.2 HDFS的关键组件和功能

- **NameNode**:HDFS的主节点,是整个文件系统的管理核心。

- 管理文件系统的命名空间;

- 控制用户对文件的访问;

- 配置副本策略,如副本数;

- 接收客户端的请求,管理文件的打开、关闭、重命名等操作;

- 维护整个文件系统的健康状态。

- **DataNode**:实际存储数据的节点,负责数据块的读写操作。

- 负责数据的存储和检索;

- 负责数据块的创建、删除和复制;

- 定期向NameNode发送心跳信号,并发送块报告,以让NameNode了解哪些数据块可用。

- **Secondary NameNode**:辅助NameNode的组件。

- 合并文件系统的命名空间镜像与编辑日志,定期生成新的命名空间镜像;

- 减轻NameNode的内存压力;

- 但不用于热备份NameNode,因为不支持故障恢复。

### 代码块展示与解析

以下是一个简单的Java代码段,用于与HDFS进行交互,创建一个HDFS文件并写入数据。为了简洁,这里省略了异常处理代码。

```java

Configuration conf = new Configuration();

FileSystem fs = FileSystem.get(conf); // 连接到NameNode

Path path = new Path("/hdfs-path/file.txt");

// 检查父目录是否存在,不存在则创建

RemoteIterator<LocatedFileStatus> iterator = fs.listFiles(new Path("/hdfs-path"), true);

if (!iterator.hasNext()) {

fs.mkdirs(new Path("/hdfs-path"));

}

FSDataOutputStream fos = fs.create(path, true);

// 将字符串转换为字节流并写入HDFS文件

String data = "Example data";

fos.write(data.getBytes());

fos.close();

```

此代码段首先配置HDFS的连接参数,然后通过`FileSystem`类创建一个连接。使用`FSDataOutputStream`对数据进行写操作。需要注意的是,在使用`create`方法时,第二个参数`true`表示如果文件已存在,则在原有文件基础上追加数据。

## 2.2 数据同步的必要性

### 2.2.1 数据一致性与可用性的平衡

在分布式系统中,数据一致性和高可用性往往存在冲突。在HDFS中,这种冲突通常通过设置不同级别的数据同步策略来解决。数据一致性要求所有节点上的数据在任何时刻都是一致的,而高可用性则要求系统能够持续提供服务,即使在某些节点出现故障时。

HDFS默认采用的是最终一致性模型,这意味着数据在某一时间点可能在不同的节点上有所不同,但随着时间的推移,数据最终会达到一致状态。HDFS采用的是写入前复制(Write-Anywhere)策略,在写入文件时会将数据块先写入一个节点,然后复制到其他节点。这一过程中,对数据的读取可以在数据同步完成之前进行,提高了系统的可用性,但牺牲了一定程度的数据一致性。

### 2.2.2 同步机制在分布式系统中的作用

同步机制在分布式系统中扮演着至关重要的角色。由于分布式系统可能包含多个物理位置的数据存储节点,数据同步机制可以确保所有节点上的数据在内容和状态上保持一致。

在HDFS中,同步机制还起到另一个重要作用:它确保了数据的高可用性。通过在多个DataNode之间同步数据副本,HDFS能够在单点故障发生时,通过故障转移来维持服务的连续性。这降低了由于硬件故障或网络问题导致的数据丢失风险。

同步机制通常需要考虑以下因素:

- **数据一致性**:如何在多个副本之间保持数据的同步和一致性。

- **性能开销**:同步操作本身会有一定的计算和网络开销,需要优化以减少对系统性能的影响。

- **恢复策略**:在数据不一致或发生故障时,如何快速有效地进行数据恢复。

- **资源使用**:在有限的资源下,如何合理分配同步任务,避免资源瓶颈。

### 代码块展示与解析

HDFS提供了一个命令行工具`hdfs dfsadmin`用于管理和监控HDFS。下面是一个使用`hdfs dfsadmin`命令来平衡HDFS上的数据块分布的示例:

```shell

hdfs fsck /hdfs-path/ -files -blocks -locations

```

这个命令对指定路径进行检查,列出所有文件和数据块以及它们的位置信息。通过这种方式,管理员可以监控数据的分布情况,以确保数据块被均匀地分布在不同的DataNode上。这有助于负载均衡,减少因单个节点过载而产生的同步延迟。

## 2.3 同步策略的理论基础

### 2.3.1 事务与日志机制

在HDFS中,事务与日志机制是保证数据一致性的基础。HDFS通过日志记录每一个对文件系统的操作,称为编辑日志。NameNode在内存中维护当前的文件系统状态,编辑日志记录所有对文件系统状态的更改。一旦这些更改被应用到内存状态中,它们就被认为是持久的。

由于NameNode是单点故障的潜在瓶颈,HDFS采用了JournalNode集群来维护一个共享编辑日志。多个JournalNode节点保证即使NameNode宕机,另一个备用NameNode也可以读取日志来恢复文件系统状态。这种方式提高了系统的可靠性和容错性。

事务和日志机制保证了即使发生系统故障,也可以通过日志进行恢复,确保数据的一致性。

### 2.3.2 分布式锁和一致性协议

分布式系统中的同步机制往往需要协调多个进程或节点之间的操作。实现这一目的的技术之一是使用分布式锁。分布式锁是一种同步机制,用于在多个进程之间协调共享资源的访问。

HDFS使用了一致性协议(例如Quorum协议)来管理分布式锁,确保在任何时刻,只有一个NameNode可以修改文件系统的状态。这种方法可以减少多个副本之间发生冲突的可能性。

在HDFS中,一致性协议确保了即使在出现故障后,系统也能通过选举机制选出新的主节点(NameNode),并利用共享日志来达成数据一致性。

### 表格展示

以下表格展示了常见的分布式锁策略的对比:

| 特性 | 乐观锁 | 悲观锁 | 分布式锁 |

| ---- | ------ | ------ | -------- |

| 实现原理 | 通过版本号或时间戳检查数据一致性 | 操作数据前,首先锁定资源 | 集群中的多个节点共同协调锁定资源 |

| 使用场景 | 对冲突概率低的场景较为适合 | 高冲突环境下可以避免数据不一致

0

0