【Python difflib秘籍】:深度解析文本差异比较的艺术

发布时间: 2024-09-30 17:25:15 阅读量: 59 订阅数: 31

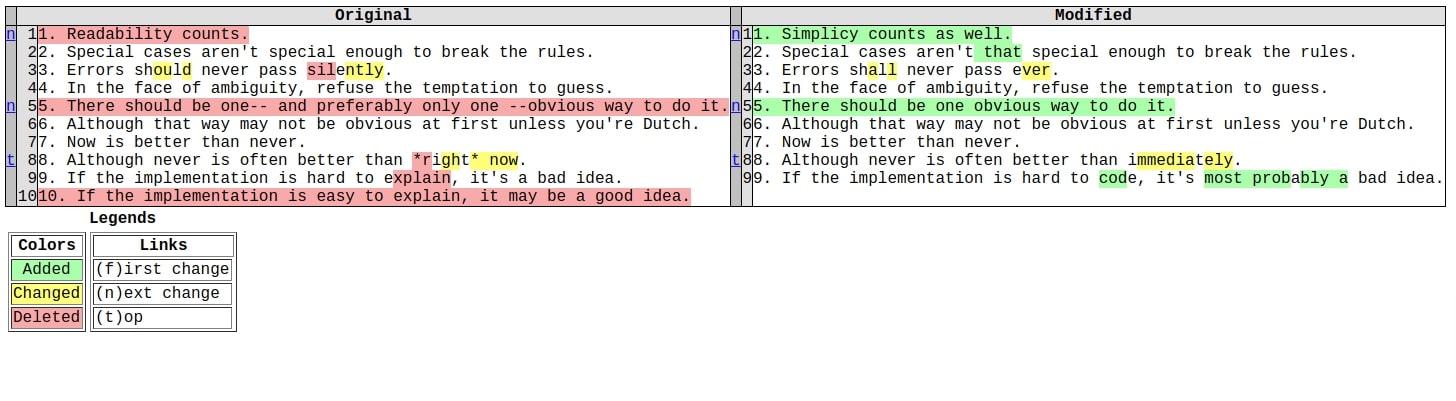

# 1. 文本差异比较的艺术与Python difflib库简介

在软件开发、文档管理、版本控制以及数据同步等多个领域,文本差异比较是一项至关重要的功能。比较文本间的差异不仅帮助开发者发现代码变更、审阅文档编辑,而且还能在自动化脚本中检查配置文件或日志的更改情况。Python 作为一个功能强大的编程语言,其标准库中的 difflib 库就是为比较文本差异提供了一系列工具。

difflib 库提供了丰富的类和函数,使得文本比较变得简单高效。开发者可以利用该库比较序列、文件,甚至自定义比较逻辑。它的设计目标是提供灵活而强大的工具,以应对多种应用场景下的文本差异比较需求。

本章节将概述 difflib 库的基本用法,为后续章节深入探讨difflib 的理论基础、实践技巧、性能优化和与其他库的结合打下基础。在阅读本章节之后,读者将对 difflib 的用途有一个基本的认识,并能够掌握其初步的使用方法。

```python

import difflib

# 示例代码展示使用difflib比较两个字符串

a = "this is a sample"

b = "this is a simple example"

diff = difflib.ndiff(a.split(), b.split())

print(''.join(diff))

```

以上代码展示了如何使用 difflib 的 ndiff 函数来比较两个字符串。通过 split() 方法将字符串转换为列表,然后传递给 ndiff() 函数,最后将结果打印出来。这个例子虽然简单,却体现了 difflib 在文本比较中的基础应用。

# 2. difflib库核心原理与理论基础

### 2.1 difflib库概述

#### 2.1.1 库的设计目标与应用场景

Python的difflib库是一个用于比较序列的库,特别是用于比较文本文件。其设计目标是为开发者提供一套简单的API,实现序列之间的比较和差异分析功能,包括生成差异报告和合并文本文件。该库广泛应用于文本编辑器、版本控制系统和任何需要比较和分析数据差异的场景。

difflib的设计理念是方便开发者快速实现以下功能:

- 比较两个序列的元素并找出它们的差异。

- 以人类可读的形式展示差异(例如,差异报告)。

- 合并由差异操作产生的修改。

在具体应用中,difflib可以用于:

- 文本文件的比较与合并。

- 数据库记录的差异分析。

- 动态网页内容的快速更新。

### 2.2 文本比较的算法原理

#### 2.2.1 字符串相似度算法

字符串相似度算法的核心在于评估两个字符串之间的相似程度。最直观的相似度算法之一是基于字符的匹配,例如通过计算两个字符串共同拥有的字符数来评估相似度。

在更高级的算法中,一个常用的方法是编辑距离(Levenshtein距离),该方法定义了将一个字符串转换成另一个字符串所需的最少编辑操作次数(插入、删除或替换)。difflib库使用Levenshtein距离作为衡量字符串相似度的一种方法,并通过优化此算法实现快速比较。

#### 2.2.2 动态规划与最长公共子序列

动态规划是一种算法设计技术,用于解决具有重叠子问题和最优子结构特性的问题。最长公共子序列(LCS)问题是一个经典的动态规划问题,它是比较两个序列时的有力工具。

LCS算法通过比较两个序列并找出其中最长的一系列不连续元素来工作,这些元素在两个序列中都存在且顺序相同。difflib库中的SequenceMatcher类就是基于LCS算法实现的,它用于找出两个序列的相似部分,并能够给出序列之间的差异。

#### 2.2.3 算法的时间复杂度分析

difflib库中的算法,尤其是SequenceMatcher类,使用了递归和动态规划技术,确保了比较操作的高效性。其时间复杂度与待比较序列的长度相关。

对于简单的字符串相似度计算,最坏情况下的时间复杂度为O(n^2),其中n是字符串的长度。而在LCS问题中,使用动态规划的方法,时间复杂度可以降低到O(m*n),其中m和n分别是两个序列的长度。这样的时间复杂度保证了即使是大型数据集,difflib也能够有效地处理。

### 2.3 核心类和函数的理论框架

difflib库提供了几个核心类和函数,可以用于执行序列比较任务。最重要的类是SequenceMatcher和Differ,以及一些辅助函数如get_close_matches()和ndiff()。

SequenceMatcher是difflib库中最为核心的类,它用来比较两个序列中的相似元素,并提供一种方式来输出这些差异的详细报告。SequenceMatcher类的主要方法包括match()、find_longest_match()和get_matching_blocks()。

Differ类是另一个用于生成差异报告的主要类。它的工作方式类似于SequenceMatcher,但是提供了用于显示差异的更详细的文本报告。Differ类通过逐行比较两个序列,并标记出哪些行是相同的,哪些行是不同的,哪些行是仅存在于一个序列中的。

辅助函数如get_close_matches(),它用来找出一组词中最接近的匹配项,通常用于自动完成或者拼写检查程序。而ndiff()函数则用来生成两个序列的差异报告,报告以一种易于阅读的格式呈现,非常适合需要清晰展示数据差异的场景。

# 3. difflib库实践技巧

## 3.1 序列比较与分析

### 3.1.1 序列匹配器的使用方法

Python的difflib库提供了一个非常直观的类:SequenceMatcher,用于比较两个序列,它被广泛用于文本和数据的比较工作中。SequenceMatcher主要通过比较序列中元素的匹配程度,然后计算出匹配比率来描述两个序列的相似度。其使用方法简单明了,通过实例化该类并调用其get_matching_blocks()方法可以得到一系列匹配块的信息。

下面是一个简单的使用示例:

```python

from difflib import SequenceMatcher

# 比较两个序列

seq1 = [1,2,3,5,6,7]

seq2 = [1,2,3,4,5,6,7]

matcher = SequenceMatcher(None, seq1, seq2)

# 获取匹配块

blocks = matcher.get_matching_blocks()

for block in blocks:

print("start1, size: ", block.a, block.size)

print("start2, size: ", block.b, block.size)

```

上述代码定义了两个序列,并使用SequenceMatcher比较它们,最后打印出每个匹配块的起始位置和长度。`get_matching_blocks()`返回一个`Match`对象的序列,每个对象描述一个匹配块。`a`和`b`属性表示匹配块在两个序列中的起始位置,`size`属性表示匹配块的长度。

### 3.1.2 输出分析结果的技巧

为了输出更易读的比较结果,可以利用difflib库中的context_diff和unified_diff方法。这些方法可以将两个序列的差异以人类可读的格式输出,通常用于展示两个文件之间的差异。

这里是一个如何利用`context_diff`的实例:

```python

from difflib import context_diff

# 比较两个字符串

s1 = """def foo():

print("Hello, world!")

s2 = """def bar():

print("Hello, world!")

# 输出为人类可读的格式

diff = context_diff(StringIO(s1), StringIO(s2), lineterm='')

print(diff)

```

输出结果类似于:

```plaintext

***

---

***

1,2 ***

- def foo():

! print("Hello, world!")

3,3 ***

+ def bar():

! print("Hello, world!")

```

这个输出展示了从第一个字符串(s1)到第二个字符串(s2)的修改,删除的行前面有减号(-),添加的行前面有加号(+)。这种格式尤其适用于版本控制系统,让使用者可以清楚地看到文件修改的具体内容。

## 3.2 文件比较与处理

### 3.2.1 文件差异的提取步骤

比较文件差异是difflib库中的一个常见用途。这里我们分步骤讲解如何使用difflib来提取两个文本文件之间的差异。

首先,确保你有两个需要比较的文本文件,例如:

```plaintext

# file1.txt

line1

line2

line3

# file2.txt

line1

line2

line4

```

下面是提取和输出这两个文件差异的代码:

```python

from difflib import unified_diff

with open('file1.txt', 'r') as file1, open('file2.txt', 'r') as file2:

diff = unified_diff(file1.readlines(), file2.readlines(), fromfile='file1.txt', tofile='file2.txt')

# 输出差异

print('\n'.join(diff))

```

这段代码通过读取两个文件的每一行并传递给`unified_diff()`函数来获取它们之间的差异。`fromfile`和`tofile`参数分别指定了文件的来源和目标。

### 3.2.2 常见文件格式的差异比较

在实际应用中,文件格式多种多样,包括文本、二进制、文档等。difflib库在处理纯文本文件时表现最佳,但对于二进制或特定格式的文件,可能需要借助其他库或工具进行预处理,将其转换为difflib可以处理的格式。

对于文本文件,difflib可以很好地处理;对于纯文本差异,difflib的`context_diff`和`unified_diff`可以生成易于理解的差异展示。对于CSV或JSON文件等结构化数据,可以通过解析为内部数据结构,再使用difflib比较数据结构的差异。

这里是一个使用difflib比较CSV文件差异的例子:

```python

import csv

from difflib import unified_diff

def read_csv_to_dict(filename):

with open(filename, newline='') as csv***

***

*** [row for row in reader]

def diff_csv_files(file1, file2):

dict1 = read_csv_to_dict(file1)

dict2 = read_csv_to_dict(file2)

# 比较逻辑(此处略去)

# ...

diff_csv_files('data1.csv', 'data2.csv')

```

在这个例子中,我们首先定义了一个辅助函数`read_csv_to_dict`,它读取CSV文件并将其内容转换为字典的列表。之后,我们可以对这个列表使用difflib进行差异比较。

### 3.2.3 差异结果的可视化展示

difflib本身不提供差异结果的可视化功能,但是我们可以通过其他工具比如可视化库matplotlib,或者在线工具如Diffchecker等,来将difflib的输出进行图形化展示。

假设我们已经通过difflib获取了两个文件之间的差异结果,接下来我们将使用matplotlib库来可视化这些差异。下面是一个基本的示例:

```python

import matplotlib.pyplot as plt

import matplotlib.patches as patches

def visualize_diff(file_diff):

# 这里只是示例,实际代码会根据差异结果解析具体细节

# ...

# 假设我们已经解析了差异,并将它们保存在diffs列表中

diffs = [/* 差异细节数据 */]

fig, ax = plt.subplots()

# 为了简化,我们假设diffs包含两个文件中的每一行的匹配状态

for diff in diffs:

if diff['is_match']:

# 相同行用灰色表示

ax.add_patch(patches.Rectangle((diff['x'], diff['y']), 1, 1, facecolor='lightgrey'))

elif diff['is_add']:

# 新增行用绿色表示

ax.add_patch(patches.Rectangle((diff['x'], diff['y']), 1, 1, facecolor='green'))

elif diff['is_delete']:

# 删除行用红色表示

ax.add_patch(patches.Rectangle((diff['x'], diff['y']), 1, 1, facecolor='red'))

plt.xlim(0, 5) # 假设有5行数据

plt.ylim(0, 5)

plt.show()

```

这个示例展示了如何用颜色区分文件之间的差异,其中相同行、新增行、删除行分别用不同颜色的方块表示。实际情况下,你需要解析difflib的输出来创建这个可视化图表。

## 3.3 高级应用实例

### 3.3.1 简单的文本合并工具开发

文本合并是版本控制、代码审查和多用户编辑场景下的常见需求。我们可以利用difflib的`merge_diffs()`方法开发一个简单的文本合并工具。此方法可以帮助我们合并两个文件内容的差异,通常用于解决合并冲突。

下面是一个简单的文本合并工具的示例:

```python

from difflib import DiffResult, Differ

# 为方便起见,这里我们将文件内容读取到字符串列表

file1_lines = ["line1", "line2", "line3"]

file2_lines = ["line1", "line2", "line4"]

# 使用differ进行差异比较

d = Differ()

diff = list(***pare(file1_lines, file2_lines))

# 使用merge_diffs尝试合并

result = DiffResult.from_string("".join(diff))

merged = result.merge()

print(merged)

```

这段代码首先比较了两个字符串列表,然后通过`merge()`方法尝试将它们合并。`DiffResult.from_string()`方法用于解析由Differ生成的差异字符串,之后调用`merge()`合并冲突。

### 3.3.2 自动化文本审查流程

自动化文本审查是提高代码质量的有效手段之一。通过比较不同版本的代码,difflib可以帮助我们自动发现潜在的代码变更错误。

这里是一个自动化审查流程的基本框架:

```python

def check_code_diff(old_code, new_code):

"""

比较旧版本代码和新版本代码,检查是否有潜在问题。

"""

# 使用difflib比较代码差异

# ...

# 假设diffs是差异结果列表

diffs = [/* 差异分析结果 */]

# 分析差异结果,查找潜在问题

# ...

# 假设old_code和new_code是代码文件的字符串

old_code = "..."

new_code = "..."

check_code_diff(old_code, new_code)

```

在这个示例中,`check_code_diff`函数将负责比较旧版本和新版本的代码差异,并分析可能存在的问题。这个过程可以集成到持续集成(CI)系统中,实现代码质量的实时监控。

## 3.4 总结

在本章节中,我们深入探讨了difflib库在实践中的技巧和应用。通过实例演示了如何使用SequenceMatcher类进行序列匹配和分析,我们学习了如何输出易读的差异报告,通过context_diff和unified_diff生成人类可读的差异展示。同时,我们也演示了如何使用difflib处理不同格式的文件,包括如何将CSV文件转换为字典列表后进行比较。最终,我们探索了difflib在高级应用中的潜力,包括开发文本合并工具和自动化文本审查流程。

在接下来的章节中,我们将继续深入了解difflib库的进阶用法,并探讨与其它Python库结合使用的方式,以及性能调优和最佳实践。

# 4. difflib与文本处理进阶

## 4.1 自定义比较器的开发

### 4.1.1 自定义比较类的设计与实现

在文本处理任务中,`difflib`库默认的功能可能无法满足所有的定制需求。在这种情况下,自定义比较器就显得尤为重要。通过继承`difflib.SequenceMatcher`类并重写相应的方法,可以实现一个功能更加丰富的比较器。

下面是一个简单例子,展示了如何实现一个自定义的比较器,该比较器除了能比较文本差异之外,还能根据自定义的权重来调整比较的结果。

```python

import difflib

class CustomSequenceMatcher(difflib.SequenceMatcher):

def __init__(self, isjunk=None, a=None, b=None, autojunk=True):

super().__init__(isjunk, a, b, autojunk)

self.custom_weights = {'insert': 0.5, 'delete': 0.5, 'replace': 1.0}

def set_weights(self, insert=None, delete=None, replace=None):

if insert is not None:

self.custom_weights['insert'] = insert

if delete is not None:

self.custom_weights['delete'] = delete

if replace is not None:

self.custom_weights['replace'] = replace

def get_matching_blocks(self):

for block in super().get_matching_blocks():

block = (block, self.custom_weights)

yield block

# 使用自定义比较器

a = "this is a test".split()

b = "this is a test".split()

matcher = CustomSequenceMatcher(a=a, b=b)

matcher.set_weights(insert=0.5, delete=0.5, replace=1.0)

print(matcher.get_matching_blocks())

```

上述代码创建了一个`CustomSequenceMatcher`类,其中增加了一个自定义权重的字典,用于调整不同操作(插入、删除、替换)的相对重要性。通过`set_weights`方法,可以动态地改变这些权重。`get_matching_blocks`方法被重写以返回调整后的匹配块。

### 4.1.2 自定义比较器的性能优化

自定义比较器虽然灵活,但如果不注意优化,可能会带来性能下降。性能优化可以从以下几个方面着手:

1. **预处理数据**:在比较之前,先对数据进行预处理,比如清理无关字符、缩进等,这可以减少比较器的负担。

2. **优化算法逻辑**:优化比较器内部算法的逻辑,比如减少不必要的循环或者递归调用。

3. **利用缓存**:如果比较器会多次对同样的数据进行比较,可以考虑使用缓存技术来存储已有的比较结果。

4. **并行处理**:对于大数据集,可以考虑将数据分割,然后使用多线程或多进程进行并行比较。

性能优化示例代码:

```python

import multiprocessing

def parallel_diff(a, b, workers):

chunk_size = len(a) // workers

with multiprocessing.Pool(workers) as pool:

for result in pool.starmap(diff_chunk, [(a[i:i + chunk_size], b[i:i + chunk_size]) for i in range(0, len(a), chunk_size)]):

yield from result

def diff_chunk(a_chunk, b_chunk):

matcher = CustomSequenceMatcher(a=a_chunk, b=b_chunk)

yield from matcher.get_matching_blocks()

a = "this is a test".split() * 1000 # Large list for demonstration

b = "this is a test".split() * 1000 # Large list for demonstration

for block in parallel_diff(a, b, workers=4):

print(block)

```

在此代码中,我们定义了一个`parallel_diff`函数,它将数据集分割成若干块,然后使用Python的`multiprocessing`模块并行计算每块的差异。这样可以有效地利用多核CPU的优势,提高大型数据集处理的速度。

# 5. difflib与其他库的结合使用

## 5.1 结合正则表达式处理文本

在文本处理和差异比较中,正则表达式是强大的工具,它允许用户定义匹配文本的模式。通过将difflib与正则表达式结合使用,我们可以实现更复杂的文本清洗和预处理。

### 5.1.1 使用正则表达式进行文本清洗

正则表达式可以用来删除无关紧要的字符、格式化文本、提取特定信息等。例如,在比较两个文本文件之前,我们可能需要删除所有的空白字符和换行符,以便进行更干净的比较。

```python

import re

import difflib

# 定义一个正则表达式清洗函数

def clean_text(text):

# 使用正则表达式移除所有空白字符和换行符

return re.sub(r'\s+', '', text)

# 读取两个文件的内容

with open('file1.txt', 'r') as ***

***

***'file2.txt', 'r') as ***

***

* 清洗两个文件内容

cleaned_file1 = clean_text(file1_content)

cleaned_file2 = clean_text(file2_content)

# 使用difflib进行差异比较

d = difflib.Differ()

diff_result = list(***pare(cleaned_file1, cleaned_file2))

```

在上述代码中,我们首先定义了一个`clean_text`函数,它使用`re.sub`来移除字符串中的空白字符。之后,我们读取两个文件的内容,并对它们应用了清洗函数。最后,我们使用difflib的`Differ`类来比较清洗后的内容。

### 5.1.2 在差异比较前的预处理流程

预处理是文本比较中非常重要的步骤。通过预处理,我们可以确保比较的准确性,避免因为格式问题导致的误报。除了清洗文本外,预处理还可以包括文本的标准化,如大小写统一、统一使用全角或半角字符等。

```python

# 统一文本为小写进行预处理

def normalize_text(text):

return text.lower()

normalized_file1 = normalize_text(cleaned_file1)

normalized_file2 = normalize_text(cleaned_file2)

# 使用difflib进行差异比较

d = difflib.Differ()

diff_result = list(***pare(normalized_file1, normalized_file2))

```

在这段代码中,`normalize_text`函数将文本统一转换为小写。这样的预处理可以帮助我们忽略大小写差异,专注于更实质性的内容差异。

## 5.2 集成数据库进行数据比较

数据库是存储和处理大量数据的强大工具。在实际应用中,数据可能存储在数据库中。使用difflib库,我们可以轻松地将数据从数据库中提取出来,并进行比较分析。

### 5.2.1 使用SQL进行数据差异分析

使用SQL可以对存储在数据库中的数据进行复杂的查询。我们可以先查询出需要比较的数据集,然后使用difflib进行比较。

```python

import sqlite3

import difflib

# 连接到SQLite数据库

conn = sqlite3.connect('database.db')

cursor = conn.cursor()

# 查询需要比较的数据

cursor.execute("SELECT column FROM table WHERE condition")

rows_file1 = cursor.fetchall()

cursor.execute("SELECT column FROM table WHERE condition2")

rows_file2 = cursor.fetchall()

# 将查询结果转换为字符串列表

file1_str = [str(row[0]) for row in rows_file1]

file2_str = [str(row[0]) for row in rows_file2]

# 使用difflib进行差异比较

d = difflib.Differ()

diff_result = list(***pare(file1_str, file2_str))

# 关闭连接

conn.close()

```

在这段代码中,我们首先连接到SQLite数据库,并执行了两个SQL查询来获取比较的数据。然后,我们使用列表推导式将查询结果转换为字符串列表,以便使用difflib进行比较。

### 5.2.2 将difflib与ORM框架结合

对象关系映射(ORM)框架如SQLAlchemy可以让我们以面向对象的方式操作数据库,而不必直接编写SQL语句。将difflib与ORM结合使用可以更方便地进行数据的提取和比较。

```python

from sqlalchemy import create_engine, Column, Integer, String

from sqlalchemy.orm import sessionmaker

from sqlalchemy.ext.declarative import declarative_base

from difflib import Differ

# 定义一个基础模型

Base = declarative_base()

# 定义数据模型

class DataItem(Base):

__tablename__ = 'data_items'

id = Column(Integer, primary_key=True)

content = Column(String)

# 创建数据库引擎

engine = create_engine('sqlite:///database.db')

Base.metadata.create_all(engine)

Session = sessionmaker(bind=engine)

session = Session()

# 使用ORM提取数据

data_file1 = session.query(DataItem).filter_by(condition=True).all()

data_file2 = session.query(DataItem).filter_by(condition=False).all()

# 将数据对象转换为字符串列表

file1_str = [item.content for item in data_file1]

file2_str = [item.content for item in data_file2]

# 使用difflib进行差异比较

d = difflib.Differ()

diff_result = list(***pare(file1_str, file2_str))

# 关闭会话

session.close()

```

在这段代码中,我们定义了一个简单的数据模型`DataItem`,使用SQLAlchemy连接到数据库,并通过ORM查询条件来提取数据。提取的数据然后被转换为字符串列表,并使用difflib进行比较。

通过上述的预处理和数据提取,我们可以更精确地使用difflib库进行文本和数据的比较分析。在处理复杂的数据集时,这些结合使用的方法显得尤为重要,使得差异分析既高效又具有针对性。

# 6. difflib的性能调优与最佳实践

性能调优是任何开发过程中的重要环节,尤其是在处理大量数据时。Python的difflib库虽然强大,但在某些场景下可能因性能瓶颈而无法满足需求。在本章中,我们将探讨如何识别和解决difflib在使用过程中可能遇到的性能瓶颈,以及一些最佳实践。

## 6.1 性能分析与调优技巧

### 6.1.1 识别性能瓶颈的方法

在开始优化之前,我们首先需要识别出性能瓶颈所在。性能瓶颈可能来自于数据的规模、处理算法的效率,或者是执行环境的限制。

- **数据规模影响:** 处理的数据量越大,difflib库的性能自然会受到影响。例如,在比较两个大型文本文件时,difflib可能需要更多时间来计算差异。

- **算法效率:** difflib使用动态规划算法来计算最长公共子序列,这本身就是一个时间复杂度为O(n^2)的操作。对于已经排序的序列,可以使用二分查找来降低复杂度至O(n log n),但difflib目前没有实现这一点。

- **执行环境限制:** Python通常比编译语言运行慢,如果difflib的某些计算密集型操作能够用C语言重写,可能会大大提升性能。

识别性能瓶颈的最直接方法是通过性能分析工具。在Python中,我们可以使用`cProfile`模块来确定程序中的热点函数。以下是一个使用`cProfile`来分析一个基于difflib的脚本的例子:

```python

import cProfile

from difflib import SequenceMatcher

def test_func():

seq1 = range(10000)

seq2 = list(seq1)

seq2.reverse()

return SequenceMatcher(None, seq1, seq2).ratio()

cProfile.run('test_func()')

```

### 6.1.2 提升difflib处理效率的策略

一旦我们识别出性能瓶颈,我们就可以采取相应的策略来提升性能。以下是一些常见的优化方法:

- **使用`get_matching_blocks`方法:** 这个方法可以返回两个序列中匹配的部分,而且不需要计算整个序列的相似度,可以减少计算量。

- **并行处理:** 如果比较的序列很长,可以考虑将序列分割成多个部分,然后并行处理这些部分。

- **内存优化:** 在处理大型数据集时,确保在可能的情况下使用生成器,避免一次性加载整个数据集到内存中。

一个优化的difflib使用示例:

```python

from difflib import SequenceMatcher

from concurrent.futures import ProcessPoolExecutor

def parallel_diff(seq1, seq2):

seq1 = list(seq1)

seq2 = list(seq2)

with ProcessPoolExecutor() as executor:

future = executor.submit(SequenceMatcher(None, seq1, seq2).get_matching_blocks)

return future.result()

# 示例数据

large_seq1 = range(100000)

large_seq2 = large_seq1[::-1] # 逆序,创建一个与原序列有大量匹配的序列

# 调用优化后的函数

parallel_diff(large_seq1, large_seq2)

```

通过将数据分割成小块,并利用多进程并行计算,可以大大加快处理速度。

## 6.2 实际案例分析与代码优化

### 6.2.1 分析真实世界中的文本比较案例

让我们考虑一个真实的案例,比如比较两个大型日志文件,找出不一致的部分。原始的日志文件可能包含大量的重复信息,但关键的区别可能只在几个小的区域。我们可以使用`get_matching_blocks`来直接定位这些区域,从而避免不必要的全量比较。

```python

def find_log_differences(log1, log2):

with open(log1, 'r') as file1:

seq1 = file1.readlines()

with open(log2, 'r') as file2:

seq2 = file2.readlines()

matcher = SequenceMatcher(None, seq1, seq2)

blocks = matcher.get_matching_blocks()

for block in blocks:

print(f"Block with similarity: {block.size} lines, starting at line {block.a}")

find_log_differences('log1.txt', 'log2.txt')

```

### 6.2.2 代码层面的优化建议

在代码层面,我们可以通过以下方式来优化difflib的使用:

- **使用`difflib.unified_diff`简化输出:** 该方法可以生成一个类似`git diff`的输出,展示差异,非常适合在开发工具或日志中使用。

- **避免重复比较:** 如果需要频繁地比较相同的序列,可以缓存之前的比较结果,重复使用。

- **合并小改动:** 对于细微的改动,可以考虑合并这些改动而不是单独处理每个改动,以减少计算量。

最后,持续地监控和评估difflib的性能,根据实际的数据规模和使用场景不断优化代码,是维护高性能应用程序的关键。

在本章中,我们探讨了difflib性能优化的方法和技巧,提供了实际案例分析,并给出了代码层面的优化建议。通过这些内容,读者应该能够更好地理解和应用difflib进行高效和有效的文本比较。在下一章节中,我们将深入探讨difflib与其他库的结合使用,包括正则表达式和数据库集成,以进一步扩展difflib的使用场景。

0

0