【Python文本比较的艺术】:使用unicodedata库,实现文本比较的精准艺术

发布时间: 2024-09-29 21:25:15 阅读量: 15 订阅数: 28

# 1. Python文本比较的理论基础

在当今的IT领域中,文本处理成为了数据处理的常见环节之一,而Python作为一款强大的编程语言,提供了丰富的文本处理工具和库,其中Python的文本比较功能尤其令人关注。文本比较技术主要涉及两个方面:一是理解文本之间的差异,二是找出文本之间的相似性。在更深入的层面上,文本比较不仅是简单的字符串匹配问题,而是涉及到了文本中的字符编码、语言学特性、语境等因素。这就要求开发者不仅要熟悉编程语言本身,还要对字符编码、文本标准化等理论有较为深入的理解。在本章节中,我们将首先探讨文本比较的基本理论,为后续章节对unicodedata库的深入分析和实际应用打下坚实的基础。

# 2. ```

# 第二章:unicodedata库的深入解析

在本章节中,我们将深入探讨Python标准库中的`unicodedata`模块。`unicodedata`模块是Python对Unicode标准的实现,它为处理Unicode数据提供了丰富的工具。Unicode旨在提供一种为每个字符分配一个唯一的数字编号的方法,这对于全球文本处理具有重要意义。了解`unicodedata`模块不仅能够帮助我们深入理解文本处理,还能在实现文本比较和分析时更加高效。

## 2.1 unicodedata库的字符处理机制

`unicodedata`模块的核心是字符处理。Unicode通过规范分解和规范化来简化字符的等价性问题。字符的规范分解允许我们将字符分解为更简单的形式,而规范化则涉及到将字符重新组合成特定的、统一的形式。

### 2.1.1 字符的规范分解与合成

Unicode定义了两种主要的分解形式:标准化分解(NFD)和标准化合成(NFC)。NFD将字符分解成基字符和修饰符,而NFC则相反,它将字符合成它们的组合形式。理解这两种形式对于消除文本中的不一致性非常重要。

```python

import unicodedata

# 规范分解示例

s = "é" # 'e' with acute accent

print(unicodedata.normalize('NFD', s)) # 分解为 'e' 和组合重音符

print(unicodedata.normalize('NFC', s)) # 保持组合形式

```

### 2.1.2 字符的类别与属性

`unicodedata`模块为每个字符提供了多种属性和类别信息。这些信息包括字符的类别(如字母、数字、标点符号等),以及其他与字符相关的属性(如大小写、是否为空白等)。

```python

# 查看字符类别

print(unicodedata.category('A')) # 'Lu' - 大写字母

print(unicodedata.category('3')) # 'Nd' - 数字

print(unicodedata.category('\n')) # 'Zl' - 行结束符

# 查看字符属性

print(unicodedata.name('A')) # 'LATIN CAPITAL LETTER A'

print(unicodedata.name('α')) # 'GREEK SMALL LETTER ALPHA'

```

## 2.2 unicodedata库在文本比较中的应用

文本比较通常涉及到确定两个字符串是否在逻辑上相等,考虑到可能存在的字符等价性问题。`unicodedata`模块为这一任务提供了多种工具。

### 2.2.1 比较基础:等价类划分

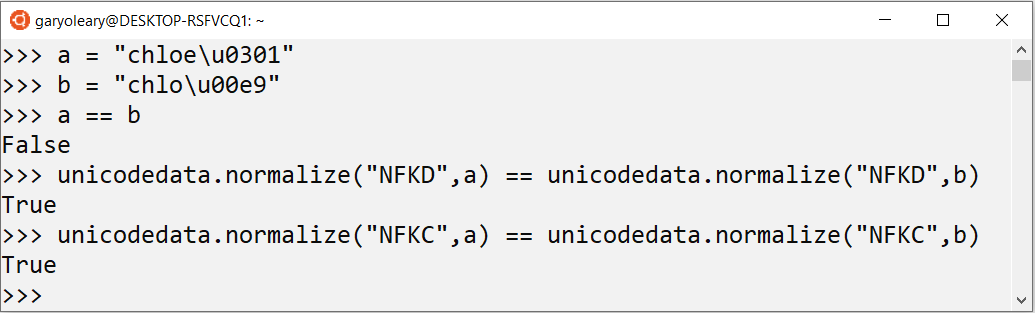

在进行文本比较时,首先需要考虑到等价类的问题。等价类是指在不同上下文中具有相同语义的字符集合。例如,字符"é"可以通过多种方式来表示,如使用字符"e"加上重音符("e"和"´")或是单独的拉丁小写字母"é"。在文本比较中,这两种表示方式应当被视为等价。

### 2.2.2 标准化文本数据

为了进行有效的文本比较,常常需要将文本数据标准化。这涉及到将文本转换成一个统一的形式,从而可以进行精确的比较。`unicodedata`模块提供了标准化函数来实现这一点。

```python

# 标准化文本数据

s1 = "é"

s2 = "e\u0301" # e + combining acute accent

print(unicodedata.normalize('NFC', s1) == unicodedata.normalize('NFC', s2)) # True

```

### 2.2.3 消除大小写和重音符号的影响

在比较文本时,大小写和重音符号的差异通常不影响文本的实际含义。因此,在进行文本比较时,常常需要忽略这些差异。

```python

# 消除大小写和重音符号的影响

import unicodedata

def normalize_text(text):

text = unicodedata.normalize('NFD', text)

text = text.encode('ascii', 'ignore').decode('utf-8')

return text.lower()

s1 = "Straße"

s2 = "strasse"

print(normalize_text(s1) == normalize_text(s2)) # True

```

## 2.3 unicodedata库的高级特性

`unicodedata`模块还包含了一些高级特性,如排序规则和正则表达式的集成,这些可以进一步提升文本处理的能力。

### 2.3.1 排序规则与文本排序

Unicode标准中定义了字符的排序规则,这些规则可以用来进行多语言环境下的文本排序。`unicodedata`模块提供了函数来访问这些排序规则。

```python

# 排序规则示例

import unicodedata

s = ['café', 'cafe', 'cafe2']

s.sort(key=unicodedata.normalize('NFC'))

print(s) # 输出排序后的列表

```

### 2.3.2 正则表达式与unicodedata结合

在处理文本数据时,`unicodedata`模块可以与正则表达式相结合,实现更复杂的字符匹配逻辑。

```python

# 正则表达式与unicodedata结合示例

import re

import unicodedata

# 匹配所有控制字符(属于Cc类别)

pattern = ***pile(r'\p{Cc}')

text = "abc\n"

print(pattern.findall(unicodedata.normalize('NFC', text))) # 输出匹配到的控制字符

```

通过深入理解`unicodedata`模块的这些高级特性,我们可以构建出更加强大和灵活的文本处理和比较工具。下一章我们将着手实践,结合具体实例来构建文本比较工具。

```

# 3. 文本比较技术实践

## 3.1 使用unicodedata进行文本清洗

### 3.1.1 去除文本中的控制字符

文本数据在收集和传输过程中往往夹杂着各种不可见的控制字符,这些字符不仅影响阅读,还会在文本比较时造成不必要的复杂性。利用Python中的`unicodedata`库,我们可以轻松地识别并去除这些控制字符。

以下是使用Python代码实现去除文本中控制字符的示例:

```python

import unicodedata

def remove_control_characters(text):

return "".join(ch for ch in text if unicodedata.category(ch) != "Cc")

# 示例文本

text_with_controls = "Hel\u200blo, World\u200b!"

clean_text = remove_control_characters(text_with_controls)

print(clean_text)

```

在上述代码中,`unicodedata.category(ch)`函数用于获取字符的Unicode类别。类别为`"Cc"`的字符即为控制字符。这段代码会输出无控制字符的文本。

### 3.1.2 标准化文本格式

文本标准化是文本比较的重要前置步骤。在不同上下文中,相同的字符可能以不同的形式出现。例如,一些字符可能带有变音符号,或者字符的编码可能存在差异。`unicodedata`库提供了一个`normalize`函数,能够帮助我们将文本转换成统一的规范形式。

举例来说,可以将带有变音符号的字符转换为等效的无变音字符:

```python

import unicodedata

def normalize_text(text):

return unicodedata.normalize('NFKD', text).encode('ASCII', 'ignore').decode('ASCII')

original_text = "naïve"

normalized_text = normalize_text(original_text)

print(normalized_text)

```

上述代码中的`normalize('NFKD', text)`将文本转换为规范分解形式,然后通过编码和解码过程去除变音符号,输出为"naive"。

## 3.2 构建文本比

0

0