【Python文本清洗术】:unicodedata库提升文本数据质量的绝招

发布时间: 2024-09-29 21:00:28 阅读量: 121 订阅数: 31

python 文本空格处理

# 1. 文本清洗与数据质量的重要性

在处理各种类型的数据时,文本数据往往是最常见的数据类型之一。文本清洗是数据处理流程中的关键步骤,对于确保数据质量和后续分析的准确性至关重要。本章将探讨文本清洗的重要性,以及它对数据质量的影响,从而为读者理解后续章节中将要介绍的文本处理技术和工具奠定基础。

## 1.1 数据质量的关键因素

在数据科学的世界里,数据质量直接影响到分析结果的准确性和可靠性。高质量的数据集具有以下特征:一致性、完整性、准确性和及时性。数据集中的文本字段往往包含大量的噪声,如格式不一、重复信息、拼写错误、以及不可见的特殊字符等。未经清洗的数据会导致算法效率降低,甚至可能导致错误的分析结论。

## 1.2 文本清洗的定义和作用

文本清洗是指通过一系列操作去除数据中的不必要成分,使文本变得更加规范、干净和可用。一个清洁的文本数据集可以提高数据处理流程的效率,增强数据分析和机器学习模型的性能。它包括去除无关字符、纠正拼写错误、统一文本格式等任务。有效的文本清洗能够为数据科学家提供干净、一致的输入,从而提升数据处理和分析的质量。

通过本章的阅读,读者将理解为什么在处理任何类型的数据集时都要重视文本清洗,并准备好学习如何使用Python进行高效的文本数据清洗。

# 2. Python中的文本处理基础

## 2.1 文本清洗的基本概念

文本数据是数据分析的重要组成部分,但往往伴随着各种问题,如拼写错误、格式不一致、非结构化数据等,这些都会影响到数据分析的质量和效率。文本清洗旨在通过一系列的预处理步骤,将原始文本转化为更符合分析要求的格式,为后续的数据处理和分析打好基础。

### 2.1.1 了解数据集中的文本问题

在进行文本清洗之前,首先需要理解数据集中存在的文本问题。文本问题可能包括但不限于:多余的空格、大小写不一致、不规则的缩写、拼写错误、编码问题等。例如,在处理用户生成的数据时,经常会遇到数据字段缺失、含有特殊符号、乱码等情况。这些因素都会对后续的数据分析带来影响,因此需要通过文本清洗来解决这些问题。

### 2.1.2 文本清洗的目的和方法概述

文本清洗的目的是确保数据的准确性、一致性和完整性,以便于进行有效的数据分析。常见的文本清洗方法包括:去除无关字符、标准化大小写、纠正拼写错误、处理缺失值、移除噪音数据等。在本章节中,我们将介绍如何使用Python进行基本的文本清洗操作,并展示一些常见的清洗方法。

## 2.2 Python中的字符串操作

Python语言中,字符串操作是最基本的文本处理手段之一。掌握字符串的基本操作,是进行更复杂文本处理的前提。

### 2.2.1 Python字符串的创建和表示

在Python中,字符串可以用单引号、双引号或三引号定义。例如:

```python

single_quoted = 'Hello, World!'

double_quoted = "Hello, World!"

triple_quoted = """Hello, World!"""

```

这三种定义方式基本等价,但三引号字符串可以跨越多行,并且可以包含单引号和双引号,而不会引起语法错误。

### 2.2.2 字符串的常用方法和属性

Python的字符串对象提供了大量方法和属性,可以帮助我们实现常见的文本操作。以下是一些常用的方法:

- `lower()`: 将字符串中的所有大写字母转换为小写字母。

- `upper()`: 将字符串中的所有小写字母转换为大写字母。

- `strip()`: 去除字符串前后的空白字符。

- `replace()`: 替换字符串中的某些子串。

- `split()`: 以某个字符作为分隔符,将字符串分割成一个列表。

- `find()`: 查找子串在字符串中的位置。

- `len()`: 获取字符串的长度。

```python

text = " Hello, World! "

# 转换为小写

lower_text = text.lower()

print(lower_text) # " hello, world! "

# 去除前后空格

stripped_text = text.strip()

print(stripped_text) # "Hello, World!"

# 替换字符

replaced_text = text.replace("World", "Python")

print(replaced_text) # " Hello, Python! "

# 分割字符串

split_text = text.split(',')

print(split_text) # [' Hello', ' World! ']

```

## 2.3 正则表达式在文本清洗中的应用

正则表达式(Regular Expression)是一种强大的文本匹配工具,能够匹配字符串中的特定模式,广泛应用于文本清洗中。

### 2.3.1 正则表达式的构建和匹配原理

正则表达式由一系列字符和特殊符号组成,这些符号定义了匹配模式。例如:

- `.` 匹配除换行符以外的任意字符。

- `*` 匹配前一个字符0次或多次。

- `+` 匹配前一个字符1次或多次。

- `?` 匹配前一个字符0次或1次。

- `{n}` 匹配前一个字符n次。

- `[abc]` 匹配字符集中的任意字符。

- `|` 表示逻辑“或”(OR)。

- `^` 匹配字符串的开始位置。

- `$` 匹配字符串的结束位置。

正则表达式通过构建复杂的匹配模式来寻找符合规则的字符串片段。

### 2.3.2 Python的re模块使用技巧

Python通过内置的`re`模块提供了对正则表达式的支持。`re`模块提供了多个函数用于进行正则表达式的匹配,例如:

- `re.match(pattern, string)`: 从字符串的开始位置匹配模式。

- `re.search(pattern, string)`: 在字符串的任意位置搜索模式。

- `re.findall(pattern, string)`: 寻找字符串中所有与模式匹配的子串。

```python

import re

# 使用正则表达式匹配电子邮件

email_pattern = r'\b[A-Za-z0-9._%+-]+@[A-Za-z0-9.-]+\.[A-Z|a-z]{2,}\b'

email = '***'

match = re.match(email_pattern, email)

if match:

print("Match found:", match.group())

```

在上面的代码中,我们定义了一个正则表达式来匹配电子邮件地址,并使用`re.match`函数在给定的字符串中寻找匹配项。如果找到匹配项,则输出匹配结果。

正则表达式在文本清洗中的应用非常广泛,它可以帮助我们识别和处理各种复杂的文本模式,从而提高文本清洗的效率和准确性。在本章节中,我们将详细介绍如何在文本清洗中有效地使用正则表达式,并提供一些常见正则表达式的使用实例。

# 3. unicodedata库的文本清洗技巧

在处理多语言和特殊字符时,Python的`unicodedata`库提供了一组工具来标准化文本,使之更容易处理。本章节将深入探讨`unicodedata`库的细节、如何使用它来标准化文本表示,以及处理特定字符的方法。

## 3.1 unicodedata库概述

`unicodedata`库是Python标准库的一部分,它为字符提供了标准化的Unicode表示,并允许你查询字符属性和进行字符的标准化处理。理解这个库及其作用对于提高数据质量至关重要。

### 3.1.1 unicodedata库的作用和重要性

Unicode标准是一个旨在为每个字符分配唯一代码点的全球字符集,它解决了不同语言和脚本中的字符编码问题。`unicodedata`库利用这一标准,为开发者提供了一套处理Unicode字符的工具。例如,在文本清洗过程中,字符的标准化可以确保相同含义的字符被统一表示,这对于后续的文本分析和处理至关重要。

### 3.1.2 库中的主要模块和函数

`unicodedata`库包含多个函数,用于查询字符信息和标准化文本。例如:

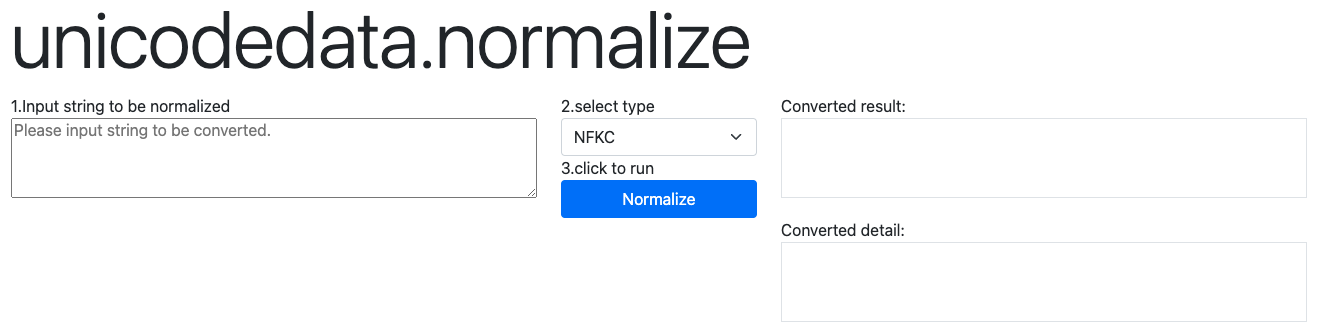

- `unicodedata.normalize()`: 用于转换字符到规范形式。

- `unicodedata.category()`: 返回字符的类别。

- `***bining()`: 返回字符的组合值。

- `unicodedata.name()`: 返回字符的官方名称。

## 3.2 标准化文本表示

Unicode标准化是处理文本时不可或缺的步骤,它涉及到将文本转换为规范形式,并处理等价字符。

### 3.2.1 Unicode标准化的概念

Unicode标准化有多种形式,包括NFC、NFD、NFKC和NFKD。NFC(Normalization Form C)和NFD(Normalization Form D)是基于字符分解的规范形式,而NFKC(Normalization Form KC)和NFKD(Normalization

0

0