【Python Unicode编码的前世今生】:unicodedata库背后的深厚历史与原理

发布时间: 2024-09-29 21:18:47 阅读量: 78 订阅数: 31

Python库 | unicodedata2-14.0.0-cp38-cp38-win32.whl

# 1. Unicode编码的起源和意义

## 1.1 信息交换的历史需求

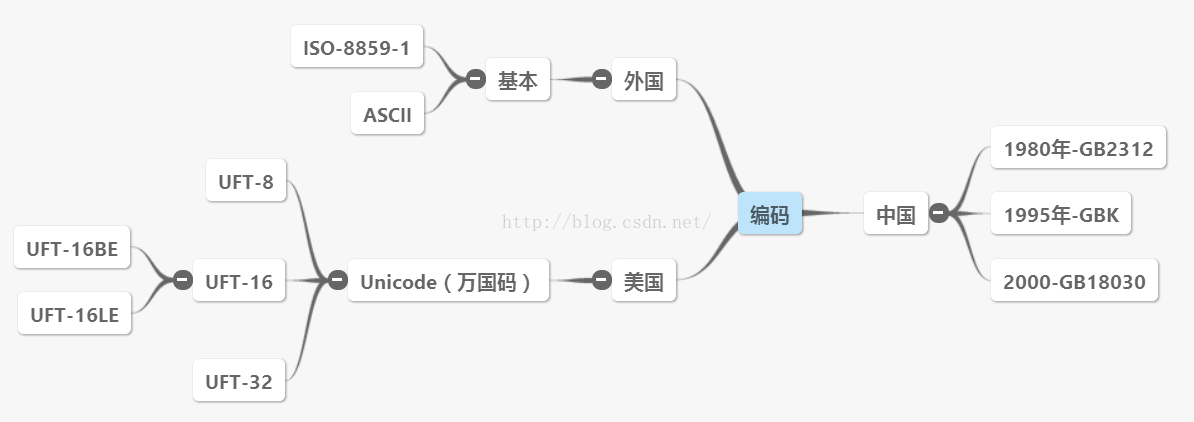

Unicode的起源可以追溯到计算机发展的早期阶段,那时的数据交换主要受限于不同系统间字符编码的不一致性。计算机使用八位字节(即1个字节)来存储字符,而一个字节能表示的字符数量是有限的。这导致了ASCII编码(美国信息交换标准代码)的诞生,它用7位(或者说是128个可能的值)来代表字符,支持128个不同的字符,足以表示英语字母和一些符号。但随着计算机技术在全球范围内的普及,ASCII无法满足对多语言字符集的需求,这就需要一种能够表示全世界所有书面语言的统一字符编码。

## 1.2 Unicode的提出和标准化

为了解决字符编码的国际化问题,Unicode应运而生。Unicode的目标是为每种语言的每个字符提供一个独一无二的数字,即“码点”(code point),从而彻底解决字符编码的兼容性问题。1991年,Unicode标准化组织成立,其第一个版本在1993年发布,涵盖了当时需要表示的大部分字符集。Unicode的编码方式包括基本多文种平面(BMP)、辅助平面等,能够支持几乎所有语言和符号的编码需求。

## 1.3 Unicode与现代信息技术的融合

随着时间的发展,Unicode逐渐成为现代信息技术中不可或缺的一部分。它不仅确保了文本数据的全球互操作性,而且成为了互联网标准的基础。Unicode标准化不仅简化了字符编码的复杂性,还推动了多语言处理技术的发展,比如本地化软件、多语言搜索引擎、国际化的网站等等。Unicode的核心意义不仅在于技术上的统一,还在于促进了不同文化之间的交流和理解。

通过本章的介绍,我们可以理解到Unicode编码对于信息时代的重要性,以及它如何帮助我们处理全球各种语言的文本数据。在后续章节中,我们将深入探讨Python中的Unicode编码机制及其在实际应用中的高级话题。

# 2. Python中的Unicode编码机制

## 2.1 Unicode编码的基本概念

### 2.1.1 Unicode的历史背景

Unicode的起源可以追溯到1988年,当时计算机领域逐渐意识到ASCII(美国信息交换标准代码)已无法满足全球化的字符编码需求。随着互联网的发展和全球化的推进,需要一个能够包含世界上所有字符的单一字符编码标准。Unicode的出现,就是为了填补这一空缺。

Unicode提供了一个为每个字符分配一个独一无二编码的方案。不同于之前某些字符集的1字节(8位)的限制,Unicode最初被设计为16位的字符编码,能够表示65,536个不同的字符,远远超出了ASCII能表示的128个字符的范围。这使得Unicode能够包含世界上绝大多数的语言文字,并为各种不同的书写系统提供支持。

### 2.1.2 Unicode与ASCII、UTF-8的关系

Unicode与ASCII之间的关系非常密切。ASCII是Unicode的基础,所有ASCII字符的Unicode编码与其ASCII编码相同,这意味着ASCII向下兼容。UTF-8(Unicode Transformation Format - 8-bit)是Unicode字符集的一种实现方式,它是一种变长的编码格式,能够根据字符的不同而使用不同数量的字节进行编码,这使得它对旧有系统非常友好。

UTF-8的设计非常巧妙,能够与ASCII编码无缝兼容。在UTF-8编码中,ASCII字符只占用一个字节,与ASCII编码完全一致。而对于需要更多字节来表示的字符,UTF-8则根据字符的Unicode编码值动态决定占用1到4个字节。这使得UTF-8在互联网上非常流行,它既能够支持多语言字符,又能够保持与ASCII的兼容性。

## 2.2 Python的字符串和Unicode

### 2.2.1 Python字符串类型简述

在Python中,字符串是一个非常重要的数据类型,用于表示文本信息。Python 3中,字符串类型是`str`,它默认使用Unicode编码。而Python 2中,字符串有两种类型:`str`和`unicode`。`str`类型是字节序列,以ASCII或其他编码方式存储,而`unicode`类型才是真正的Unicode字符串。

Python 3对字符串的处理做了一些改进,消除了`str`和`unicode`之间的区别,让所有字符串默认都是Unicode编码。这大大简化了字符串处理,尤其是国际化和多语言处理变得更加直观和方便。

### 2.2.2 Unicode字符串在Python中的表示

在Python 3中创建一个Unicode字符串非常简单,只需在字符串前加上`u`或`U`前缀即可,例如:

```python

text = u'你好,世界!'

```

这里的`text`变量就存储了一个Unicode字符串。在Python 3的交互式解释器中,你可以直接输入Unicode字符,解释器会自动将其识别为Unicode字符串。

### 2.2.3 Unicode编码在Python中的存储方式

在计算机内存中,Unicode字符串的存储通常涉及到编码转换。Python使用UTF-8作为其内部编码格式,当Unicode字符串被存储到磁盘或其他外部媒介时,它们会被转换为UTF-8或其他指定的编码格式。

例如,要将Unicode字符串保存到文本文件中,可以使用`open`函数并指定编码为`utf-8`:

```python

text = u'你好,世界!'

with open('text.txt', 'w', encoding='utf-8') as ***

***

```

这段代码将Unicode字符串`text`以UTF-8格式写入名为`text.txt`的文件中。需要注意的是,不同的操作系统和环境可能默认使用不同的编码,因此在涉及到文件编码时一定要明确指定。

## 2.3 Unicode编码在Python 2和Python 3中的差异

### 2.3.1 Python 2中的Unicode处理

在Python 2中,字符串类型包括`str`和`unicode`。`str`类型是字节序列,使用默认的编码(通常是ASCII或取决于系统的区域设置)。若要表示Unicode字符串,则使用`unicode`类型:

```python

text = unicode('你好,世界!', 'utf-8')

```

如果需要将`unicode`类型转换为`str`类型(例如,进行文件操作时),必须指定编码。而将`str`类型转换为`unicode`则需要解码:

```python

byte_string = text.encode('utf-8') # 转换为字节序列

decoded_string = byte_string.decode('utf-8') # 从字节序列转换回unicode

```

### 2.3.2 Python 3对Unicode的支持和改进

Python 3对Unicode的支持做了许多改进。首先,所有字符串默认都是Unicode,无需在字符串前加`u`前缀。其次,Python 3的文件操作默认使用Unicode编码,大大简化了文本处理流程。

此外,Python 3的`str`类型与Python 2的`unicode`类型相似,它能够表示并处理文本数据。而字节序列则由新的`bytes`类型表示,与`str`类型区分开来,从而在处理文本和二进制数据时更具有清晰性。

```python

# Python 3 示例

text = '你好,世界!'

with open('text.txt', 'w', encoding='utf-8') as ***

***

***'utf-8')

```

在Python 3中,从文件中读取文本也会自动解码为`str`类型:

```python

with open('text.txt', 'r', encoding='utf-8') as ***

***

```

内容读取后将是一个Unicode字符串,无需担心编码和解码的问题。总之,Python 3的改进极大地简化了Unicode的处理,使得开发者可以更专注于逻辑实现,而不必为编码问题所困扰。

# 3. unicodedata库的使用和原理

## 3.1 包含的Unicode数据和函数

### 3.1.1 unicodedata模块概览

Python的`unicodedata`模块是处理Unicode字符的一个标准库,它提供了对Unicode字符的属性和类别进行查询的功能,并且支持对字符进行规范分解、组合等操作。此模块基于Unicode标准的第13版,它定义了函数来获取字符的标准类别、规范化形式、大小写转换等,是处理文本数据时不可或缺的工具。

### 3.1.2 Unicode字符属性的获取

在`unicodedata`模块中,通过`category()`函数可以获取一个字符的类别,如字母、标点、数字等。这些类别基于Unicode标准的字符属性数据库,为字符的分类提供了基础。

```python

import unicodedata

# 获取字符的Unicode类别

char = 'A'

print(unicodedata.category(char)) # 输出: Lu

```

字符属性的获取通常涉及特定的类别代码,例如:

- `Lu` 表示大写字母;

- `Ll` 表示小写字母;

- `Nd` 表示数字,十进制;

- `Zs` 表示空格。

## 3.2 字符属性和规范分解

### 3.2.1 获取字符的标准类别和属性

除了类别,Unicode字符还可能有其他属性,例如是否为货币符号,是否为空白字符等。这些属性通过`unicodedata`模块中的`charinfo()`函数可以获得。

```python

char = ' '

info = unicodedata.c

```

0

0