:yolo安卓目标检测:从原理到实战,一文读懂

发布时间: 2024-08-15 16:13:18 阅读量: 28 订阅数: 22

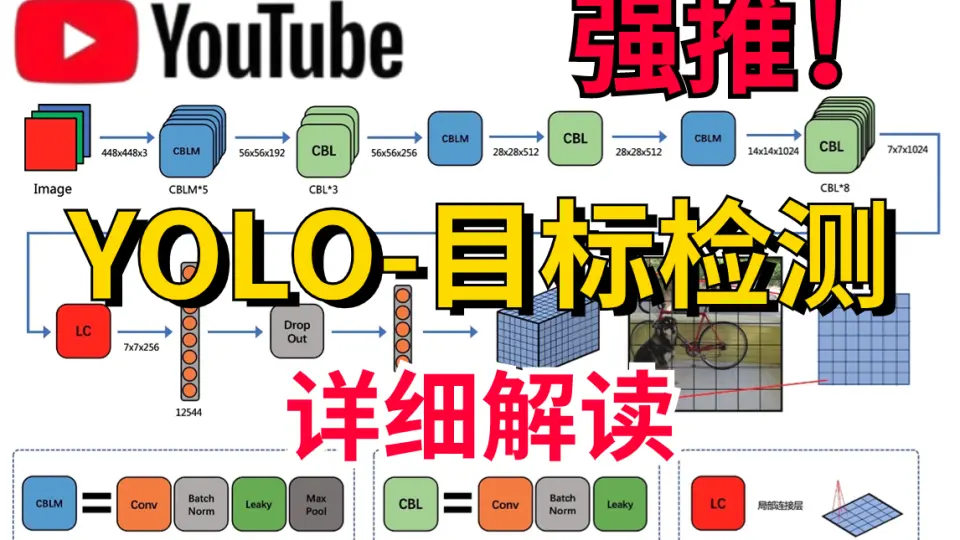

# 1. YOLO目标检测原理**

YOLO(You Only Look Once)是一种单阶段目标检测算法,它将目标检测问题视为回归问题。与传统的多阶段目标检测算法不同,YOLO直接从输入图像中预测目标的边界框和类别。

YOLO算法的基本原理是将输入图像划分为网格,并为每个网格单元预测多个边界框和对应的类别概率。如果网格单元中存在目标,则该单元负责预测该目标的边界框和类别。YOLO算法通过一个卷积神经网络(CNN)实现,该网络将输入图像作为输入,并输出一个包含边界框和类别概率的张量。

# 2. YOLO目标检测算法实现

### 2.1 YOLOv3网络结构

YOLOv3网络结构由主干网络和检测头两部分组成。

#### 2.1.1 主干网络

主干网络采用Darknet-53作为特征提取器。Darknet-53是一个深度卷积神经网络,由53个卷积层组成。它具有较强的特征提取能力,可以提取图像中丰富的语义信息。

#### 2.1.2 检测头

检测头负责将主干网络提取的特征转换为目标检测结果。它由多个卷积层和全连接层组成。

检测头首先通过卷积层对特征图进行处理,提取目标的特征。然后通过全连接层将特征图转换为目标检测结果。目标检测结果包括目标的类别和边界框。

### 2.2 YOLOv3训练流程

YOLOv3训练流程主要包括数据预处理和模型训练两个步骤。

#### 2.2.1 数据预处理

数据预处理包括图像缩放、裁剪和归一化等操作。

图像缩放将图像缩放到统一的大小,以满足模型的输入要求。裁剪从图像中随机裁剪出部分区域作为训练数据,可以增加模型的鲁棒性。归一化将图像像素值归一化到0到1之间,以减少不同图像之间的差异。

#### 2.2.2 模型训练

模型训练采用梯度下降算法,通过反向传播更新模型参数。损失函数由分类损失和回归损失两部分组成。

分类损失衡量模型预测目标类别的准确性,回归损失衡量模型预测目标边界框的准确性。

### 2.3 YOLOv3推理过程

YOLOv3推理过程主要包括图像预处理和目标检测两个步骤。

#### 2.3.1 图像预处理

图像预处理与训练过程中的数据预处理类似,包括图像缩放、裁剪和归一化等操作。

#### 2.3.2 目标检测

目标检测过程如下:

1. 将预处理后的图像输入模型。

2. 模型提取图像的特征并将其转换为目标检测结果。

3. 对目标检测结果进行后处理,包括非极大值抑制(NMS)和阈值过滤。

4. 输出最终的目标检测结果,包括目标的类别和边界框。

```python

import cv2

import numpy as np

# 加载模型

net = cv2.dnn.readNet("yolov3.weights", "yolov3.cfg")

# 图像预处理

image = cv2.imread("image.jpg")

image = cv2.resize(image, (416, 416))

image = cv2.cvtColor(image, cv2.COLOR_BGR2RGB)

image = np.array(image) / 255.0

# 将图像输入模型

blob = cv2.dnn.blobFromImage(image, 1 / 255.0, (416, 416), (0, 0, 0), swapRB=True, crop=False)

net.setInput(blob)

# 目标检测

detections = net.forward()

# 后处理

for detection in detections:

# 获取目标的类别和置信度

class_id = int(detection[5])

confidence = detection[2]

# 过滤置信度低的检测结果

if confidence > 0.5:

# 获取目标的边界框

x, y, w, h = detection[3:7] * np.array([image.shape[1], image.shape[0], image.shape[1], image.shape[0]])

# 绘制目标边界框

cv2.rectangle(image, (int(x - w / 2), int(y - h / 2)), (int(x + w / 2), int(y + h / 2)), (0, 255, 0), 2)

# 显示检测结果

cv2.imshow("Image", image)

cv2.waitKey(0)

cv2.destroyAllWindows()

```

# 3. YOLO目标检测实战

### 3.1 YOLOv3模型部署

#### 3.1.1 模型转换

YOLOv3模型训练完成后,需要将其转换为部署环境支持的格式。常用的模型转换工具有:

- **TensorFlow Lite Converter:**用于将 TensorFlow 模型转换为 TensorFlow Lite 格式,适用于移动和嵌入式设备。

- **ONNX Runtime:**用于将各种深度学习框架模型转换为 ONNX 格式,适用于跨平台部署。

- **OpenVINO:**用于将深度学习模型转换为 OpenVINO 格式,适用于 Intel 硬件加速。

**代码块:**

```python

import tensorflow as tf

# 加载 YOLOv3 模型

model = tf.keras.models.load_model("yolov3.h5")

# 转换模型为 TensorFlow Lite 格式

converter = tf.lite.TFLiteConverter.from_keras_model(model)

tflite_model = converter.convert()

# 保存 TensorFlow Lite 模型

with open("yolov3.tflite", "wb") as f:

f.write(tflite_model)

```

**逻辑分析:**

该代码将 TensorFlow 模型加载并转换为 TensorFlow Lite 格式。`tf.lite.TFLiteConverter.from_keras_model()` 函数将模型转换为 TensorFlow Lite 模型,然后将其保存到文件中。

#### 3.1.2 部署环境搭建

部署 YOLOv3 模型需要搭建相应的部署环境。常见的部署环境有:

- **移动设备:**使用 TensorFlow Lite 或 Core ML 框架在移动设备上部署模型。

- **嵌入式设备:**使用 OpenVINO 或 Edge TPU 等工具在嵌入式设备上部署模型。

- **云平台:**使用 AWS SageMaker 或 Google Cloud AI Platform 等云平台部署模型。

**表格:**

| 部署环境 | 优势 | 劣势 |

|---|---|---|

| 移动设备 | 便携性、低功耗 | 计算能力有限 |

| 嵌入式设备 | 低成本、低功耗 | 存储空间有限 |

| 云平台 | 可扩展性、高性能 | 成本较高 |

### 3.2 YOLOv3目标检测应用

#### 3.2.1 图像目标检测

部署好 YOLOv3 模型后,即可进行图像目标检测。

**代码块:**

```python

import cv2

import numpy as np

# 加载 YOLOv3 模型

net = cv2.dnn.readNet("yolov3.weights", "yolov3.cfg")

# 加载图像

image = cv2.imread("image.jpg")

# 预处理图像

blob = cv2.dnn.blobFromImage(image, 1 / 255.0, (416, 416), (0, 0, 0), swapRB=True, crop=False)

# 输入图像到模型

net.setInput(blob)

# 执行前向传播

detections = net.forward()

# 后处理检测结果

for detection in detections[0, 0]:

if detection[5] > 0.5:

x1, y1, x2, y2 = detection[3:7] * np.array([image.shape[1], image.shape[0], image.shape[1], image.shape[0]])

cv2.rectangle(image, (int(x1), int(y1)), (int(x2), int(y2)), (0, 255, 0), 2)

```

**逻辑分析:**

该代码使用 OpenCV 加载 YOLOv3 模型,预处理图像,输入图像到模型,执行前向传播,并后处理检测结果。`cv2.dnn.blobFromImage()` 函数将图像转换为模型输入所需的格式,`net.setInput()` 函数将图像输入到模型,`net.forward()` 函数执行前向传播,`detection[5]` 是检测置信度,`x1, y1, x2, y2` 是检测框坐标。

#### 3.2.2 视频目标检测

YOLOv3 模型也可以用于视频目标检测。

**代码块:**

```python

import cv2

import numpy as np

# 加载 YOLOv3 模型

net = cv2.dnn.readNet("yolov3.weights", "yolov3.cfg")

# 打开视频流

cap = cv2.VideoCapture("video.mp4")

while True:

# 读取帧

ret, frame = cap.read()

if not ret:

break

# 预处理帧

blob = cv2.dnn.blobFromImage(frame, 1 / 255.0, (416, 416), (0, 0, 0), swapRB=True, crop=False)

# 输入帧到模型

net.setInput(blob)

# 执行前向传播

detections = net.forward()

# 后处理检测结果

for detection in detections[0, 0]:

if detection[5] > 0.5:

x1, y1, x2, y2 = detection[3:7] * np.array([frame.shape[1], frame.shape[0], frame.shape[1], frame.shape[0]])

cv2.rectangle(frame, (int(x1), int(y1)), (int(x2), int(y2)), (0, 255, 0), 2)

# 显示帧

cv2.imshow("Video", frame)

if cv2.waitKey(1) & 0xFF == ord("q"):

break

# 释放视频流

cap.release()

cv2.destroyAllWindows()

```

**逻辑分析:**

该代码使用 OpenCV 加载 YOLOv3 模型,打开视频流,逐帧读取帧,预处理帧,输入帧到模型,执行前向传播,后处理检测结果,并显示帧。`cap.read()` 函数读取帧,`cv2.imshow()` 函数显示帧,`cv2.waitKey()` 函数等待用户输入。

# 4. YOLO目标检测优化**

**4.1 模型优化**

模型优化旨在减少模型的大小和计算成本,同时保持或提高其精度。

**4.1.1 量化**

量化是一种将浮点模型转换为低精度模型(例如,int8)的技术。这可以显著减少模型的大小和推理时间,同时保持相似的精度。

**代码块:**

```python

import tensorflow as tf

# 创建一个浮点模型

model = tf.keras.models.load_model("model.h5")

# 将模型量化为 int8

converter = tf.lite.TFLiteConverter.from_keras_model(model)

converter.optimizations = [tf.lite.Optimize.DEFAULT]

quantized_model = converter.convert()

# 保存量化后的模型

with open("quantized_model.tflite", "wb") as f:

f.write(quantized_model)

```

**逻辑分析:**

此代码将浮点模型转换为量化后的 int8 模型。`converter.optimizations` 参数指定要应用的优化,包括量化。转换后的模型存储在 `quantized_model.tflite` 文件中。

**4.1.2 剪枝**

剪枝是一种去除模型中不重要的权重和神经元的方法。这可以减少模型的大小和计算成本,而不会显著降低精度。

**代码块:**

```python

import tensorflow as tf

# 创建一个浮点模型

model = tf.keras.models.load_model("model.h5")

# 剪枝模型

pruning_params = {

"pruning_method": "magnitude",

"target_sparsity": 0.5,

}

pruned_model = tf.keras.models.prune_low_magnitude(model, **pruning_params)

# 保存剪枝后的模型

pruned_model.save("pruned_model.h5")

```

**逻辑分析:**

此代码使用`prune_low_magnitude`函数剪枝模型。`pruning_method` 参数指定剪枝方法(在本例中为权重幅度),`target_sparsity` 参数指定目标稀疏度(即要去除的权重百分比)。剪枝后的模型存储在 `pruned_model.h5` 文件中。

**4.2 训练数据优化**

训练数据优化旨在提高模型的精度和泛化能力。

**4.2.1 数据增强**

数据增强是一种通过对训练数据进行变换(例如,翻转、旋转、裁剪)来生成更多训练样本的技术。这可以帮助模型学习数据中的不变特征,并提高其泛化能力。

**代码块:**

```python

import tensorflow as tf

from tensorflow.keras.preprocessing.image import ImageDataGenerator

# 创建一个图像数据生成器

data_generator = ImageDataGenerator(

rotation_range=15,

width_shift_range=0.1,

height_shift_range=0.1,

shear_range=0.1,

zoom_range=0.1,

horizontal_flip=True,

vertical_flip=True,

)

# 使用数据生成器训练模型

model.fit(

data_generator.flow_from_directory("train_data", target_size=(224, 224)),

epochs=10,

)

```

**逻辑分析:**

此代码使用`ImageDataGenerator`类创建了一个数据生成器,该生成器对训练图像进行各种变换。然后,使用生成的数据训练模型。

**4.2.2 数据过滤**

数据过滤是一种去除噪声数据或不相关数据的方法。这可以提高模型的精度,并减少训练时间。

**代码块:**

```python

import pandas as pd

# 加载训练数据

data = pd.read_csv("train_data.csv")

# 过滤掉缺失值或不相关的数据

data = data.dropna()

data = data[data["label"] != "other"]

# 保存过滤后的数据

data.to_csv("filtered_data.csv", index=False)

```

**逻辑分析:**

此代码使用`pandas`库加载训练数据,然后过滤掉缺失值和不相关的数据。过滤后的数据存储在 `filtered_data.csv` 文件中。

# 5. YOLO目标检测应用案例

### 5.1 人脸检测和识别

YOLO目标检测在人脸检测和识别领域有着广泛的应用。其强大的目标检测能力可以快速准确地定位人脸,并提取人脸特征。

**人脸检测:**

YOLOv3模型可以用于人脸检测,其流程如下:

1. 图像预处理:将输入图像调整为模型要求的尺寸。

2. 模型推理:将预处理后的图像输入YOLOv3模型,得到目标检测结果。

3. 后处理:过滤置信度低的检测结果,得到最终的人脸检测结果。

**人脸识别:**

在人脸检测的基础上,YOLO目标检测还可以用于人脸识别。其流程如下:

1. 人脸特征提取:使用YOLOv3模型检测人脸并提取人脸特征。

2. 特征比对:将提取的人脸特征与已知的人脸数据库进行比对。

3. 识别结果:根据比对结果,得到人脸识别结果。

### 5.2 物体检测和分类

YOLO目标检测在物体检测和分类领域也得到了广泛的应用。其快速准确的检测能力可以快速识别图像中的物体并对其进行分类。

**物体检测:**

YOLOv3模型可以用于物体检测,其流程如下:

1. 图像预处理:将输入图像调整为模型要求的尺寸。

2. 模型推理:将预处理后的图像输入YOLOv3模型,得到目标检测结果。

3. 后处理:过滤置信度低的检测结果,得到最终的物体检测结果。

**物体分类:**

在物体检测的基础上,YOLO目标检测还可以用于物体分类。其流程如下:

1. 物体检测:使用YOLOv3模型检测图像中的物体。

2. 特征提取:提取检测到的物体的特征。

3. 分类:使用分类器对提取的特征进行分类,得到物体分类结果。

### 5.3 交通监控

YOLO目标检测在交通监控领域也有着重要的应用。其强大的目标检测能力可以快速准确地检测交通参与者(如车辆、行人、自行车),并对其进行跟踪和分析。

**交通参与者检测:**

YOLOv3模型可以用于交通参与者检测,其流程如下:

1. 图像预处理:将输入图像调整为模型要求的尺寸。

2. 模型推理:将预处理后的图像输入YOLOv3模型,得到目标检测结果。

3. 后处理:过滤置信度低的检测结果,得到最终的交通参与者检测结果。

**交通参与者跟踪:**

在交通参与者检测的基础上,YOLO目标检测还可以用于交通参与者跟踪。其流程如下:

1. 交通参与者检测:使用YOLOv3模型检测交通参与者。

2. 轨迹关联:将检测到的交通参与者与历史轨迹进行关联,得到交通参与者的运动轨迹。

3. 跟踪结果:根据关联的轨迹,得到交通参与者跟踪结果。

# 6.1 YOLOv4及后续版本

YOLOv4是YOLO系列算法的最新版本,于2020年发布。相较于YOLOv3,YOLOv4在网络结构、训练策略和推理速度方面进行了多项改进。

### 网络结构改进

YOLOv4采用CSPDarknet53作为主干网络,该网络由53个卷积层组成,具有更深的网络结构和更强的特征提取能力。此外,YOLOv4还引入了SPP(空间金字塔池化)模块,可以提取不同尺度的特征,增强目标检测的鲁棒性。

### 训练策略改进

YOLOv4采用了Mosaic数据增强技术,该技术将多张图像拼接成一张更大的图像,从而增加训练数据的多样性。同时,YOLOv4还使用了CIOU(综合交并比)损失函数,该损失函数可以更准确地衡量预测框与真实框之间的重叠程度,从而提高目标检测的精度。

### 推理速度改进

YOLOv4通过引入Bag-of-Freebies技术,对网络结构进行了优化,该技术包括:

- Mish激活函数:一种平滑且非单调的激活函数,可以提高网络的非线性。

- DropBlock正则化:一种正则化技术,可以防止网络过拟合。

- Cross-Stage Partial Connections:一种连接策略,可以减少网络的计算量。

这些改进使YOLOv4在推理速度方面有了显著提升,在保持精度的情况下,其推理速度比YOLOv3快了约2倍。

### 后续版本

YOLOv5是YOLO系列算法的最新版本,于2020年发布。YOLOv5在YOLOv4的基础上进行了进一步的改进,包括:

- 采用Focus结构作为网络的第一个卷积层,可以减少计算量。

- 引入Path Aggregation Network(PAN),可以融合不同尺度的特征,增强目标检测的鲁棒性。

- 使用Generalized Intersection over Union(GIoU)损失函数,可以更准确地衡量预测框与真实框之间的重叠程度。

YOLOv5在精度和推理速度方面都取得了进一步的提升,成为目前最先进的目标检测算法之一。

0

0