【高级技巧揭秘】:MapReduce中的自适应技术与数据倾斜处理

发布时间: 2024-11-01 07:47:57 阅读量: 3 订阅数: 8

# 1. MapReduce编程模型概述

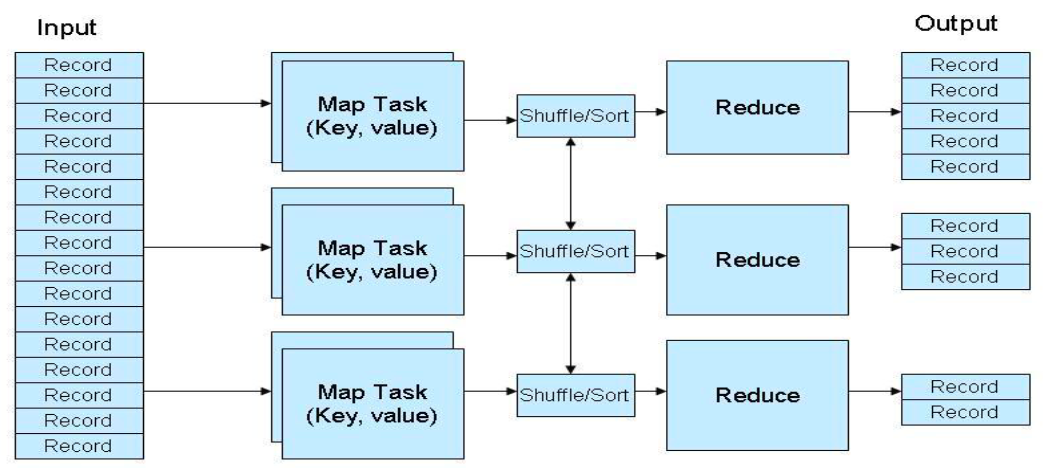

MapReduce是Hadoop生态中的核心组件之一,主要用于大规模数据集的并行运算。它的出现,简化了大数据处理的复杂性,使得开发者能够在不了解底层分布式计算细节的情况下进行编程。MapReduce模型将任务分为两个阶段:Map阶段和Reduce阶段。在Map阶段,系统将输入数据分割成独立的块,然后对每个块执行Map函数;在Reduce阶段,系统对Map阶段输出的中间结果进行汇总处理。

MapReduce编程模型因其易用性和高效性,被广泛应用于各种数据密集型任务中,比如搜索引擎索引构建、日志分析、数据挖掘等。其特点在于容错能力强,支持高并发处理,能够处理PB级别的数据。

在实际应用中,MapReduce编程模型也有其局限性,比如对于需要复杂迭代处理的算法,它的效率就不是那么理想。因此,对MapReduce的深入理解,对于优化大数据处理至关重要。接下来的章节,我们将详细探讨MapReduce中的自适应技术,以及如何应对数据倾斜问题,这些都是优化MapReduce性能的关键因素。

# 2. MapReduce中的自适应技术

MapReduce已经成为处理大数据集的有力工具,然而在大规模数据处理中,系统的性能往往受限于静态的资源分配和任务调度策略。自适应技术作为一种优化手段,在处理性能波动、资源供需不均等问题时,显得尤为关键。本章将探讨自适应技术的理论基础,以及其在MapReduce中的应用和实践案例分析。

## 2.1 自适应技术的理论基础

### 2.1.1 自适应技术的定义和原理

自适应技术是一种可以根据环境变化或系统状态动态调整策略的智能技术。在MapReduce的上下文中,自适应技术涉及对任务调度、资源分配和数据处理等环节进行动态调整,以满足实时计算的需求,提高资源利用率和计算效率。

从原理上讲,自适应技术依赖于实时监控系统中的关键指标,如CPU使用率、内存消耗、网络带宽、磁盘I/O等。这些指标被用来评估当前的系统负载和性能状态,从而指导自适应算法作出适当的决策。

### 2.1.2 自适应算法的工作机制

自适应算法的工作机制包括以下几个关键步骤:

1. 系统状态监测:持续监测系统的关键性能指标。

2. 决策制定:分析监测数据,识别出可能的性能瓶颈或资源浪费。

3. 调整策略:根据决策结果,动态地调整任务调度计划、资源分配等。

4. 反馈调整:实施调整后,继续监测系统状态,并根据需要进行迭代优化。

自适应算法的实现通常采用控制理论、机器学习或启发式搜索等方法,以实现对系统动态变化的快速响应。

## 2.2 自适应技术在MapReduce中的应用

### 2.2.1 动态任务调度

MapReduce中的动态任务调度指的是根据实时的系统负载和资源状况动态地调度任务执行。传统的任务调度方式往往在作业开始前进行一次性的静态分配,这种模式无法应对运行时出现的负载波动。动态任务调度通过引入反馈机制,实时调整任务分配策略,优化资源使用。

### 2.2.2 资源动态分配

资源动态分配则是指根据任务的实际需求来动态地分配计算资源。如,某些Map任务由于数据局部性的原因,其运行速度可能会比其他任务慢。在这种情况下,可以临时为这些任务增加更多的CPU核心或者内存资源,从而加快任务完成速度。

### 2.2.3 数据局部性优化

数据局部性优化的目的在于减少数据在不同节点间传输的次数,降低网络带宽的消耗。通过监控数据访问模式,自适应技术可以将任务调度到数据所在的节点上执行,或者尽可能地调度到数据所在的机架上,以减少跨机架的数据传输。

## 2.3 自适应技术的实践案例分析

### 2.3.1 实际应用场景展示

某大数据处理平台在使用MapReduce进行数据处理时,通过引入自适应技术显著提升了处理效率。具体表现在以下几个方面:

- 在数据处理的高峰时段,通过动态资源调度,系统成功地将更多的资源分配给了急需的任务,避免了任务队列的堆积;

- 针对不同的Map任务,系统根据其实际的CPU和内存使用情况,自动调整资源分配,既保证了任务的顺利执行,又避免了资源的浪费;

- 利用自适应技术优化了数据的存储和访问模式,减少了数据的跨网络传输,显著降低了网络I/O的压力。

### 2.3.2 性能提升的效果评估

通过引入自适应技术,该平台在性能提升方面取得了如下具体效果:

- 任务处理速度提升了20%-30%,在数据处理高峰期效果更加明显;

- 系统资源利用率提高,CPU和内存的平均使用率分别增加了15%和25%;

- 数据传输量下降了25%,网络带宽的使用更加高效。

通过这些具体的性能指标,可以看出自适应技术在MapReduce中的应用是成功的,并且有潜力进一步提升大数据处理的效率和稳定性。

通过本章节的介绍,我们深入理解了自适应技术在MapReduce中应用的理论基础与实践案例,并对其带来的性能提升效果有了初步的认识。在下一章节中,我们将探讨MapReduce数据倾斜问题及原因。

# 3. MapReduce数据倾斜问题及原因

MapReduce作为大数据处理的核心框架之一,虽然在处理大规模数据集方面有出色的表现,但其设计和实现并非完美无缺。数据倾斜是MapReduce中常见的问题,它极大地影响了作业的执行效率和资源的使用效率。本章深入探讨数据倾斜现象,分析其产生的原因,并通过案例研究来评估数据倾斜对MapReduce作业的影响。

## 3.1 数据倾斜现象的解释

### 3.1.1 数据倾斜的定义和特点

数据倾斜是指在MapReduce作业中,大部分的数据处理工作集中在少数的Reducer上,导致这些Reducer成为性能瓶颈,而其他Reducer则相对空闲。数据倾斜的一个典型特点是在作业执行过程中,部分Reducer的处理时间远超平均值,甚至可能是其他Reducer的数倍或数十倍。

### 3.1.2 数据倾斜产生的根本原因

数据倾斜的根本原因通常在于数据分布不均匀。当数据按照特定的键值进行分组时,如果某个键的出现频率远高于其他键,那么处理该键的所有数据的任务将集中在一个或少数几个Reducer上。此外,数据倾斜还可能由以下因素引起:

- **不恰当的键选择**:选择了一个分布不均匀的键作为Map输出的键。

- **自然倾斜**:某些应用天然倾向于某些键值的集中,如社交网络中的好友关系数

0

0