CNN图像识别优化秘籍:从原理到性能提升的全面解读

发布时间: 2024-11-21 15:29:27 阅读量: 56 订阅数: 32

java+sql server项目之科帮网计算机配件报价系统源代码.zip

# 1. CNN图像识别技术概述

## 简介

随着人工智能的飞速发展,卷积神经网络(Convolutional Neural Networks, CNNs)已成为图像识别领域的核心技术之一。图像识别在医疗诊断、自动驾驶、安防监控等领域扮演着至关重要的角色。CNN通过模拟人类视觉系统的工作方式,从图像中自动提取特征,实现了对图像内容的识别和分类。

## 发展历程

CNN的发展历程可以追溯到上世纪80年代,当时的LeNet-5模型奠定了现代CNN的雏形。随着计算能力的增强和大数据的出现,CNN经历了从AlexNet、VGG、Inception到ResNet的几次重大突破。每一次的架构创新都极大地提升了网络的性能,并在各种图像识别任务上取得了前所未有的准确性。

## 核心优势

CNN的核心优势在于其能够自动学习并提取图像的层次化特征表示。通过卷积层、池化层和全连接层的组合,CNN有效地减少了图像识别问题中的参数量和计算复杂度。此外,CNN的权重共享机制降低了过拟合的风险,并提高了模型的泛化能力。

在后续章节中,我们将详细探讨CNN图像识别的理论基础,性能优化策略,以及在实践中如何应用这些技术解决实际问题。

# 2. CNN图像识别基础理论

## 2.1 卷积神经网络(CNN)原理

### 2.1.1 神经网络与深度学习的联系

深度学习是机器学习的一个分支,它通过模拟人脑的神经网络来处理数据。在传统的神经网络中,每一层都是全连接层,意味着每一个节点都与上一层的所有节点相连。然而,随着数据集的大小和复杂性增加,全连接网络的参数数量也随之增加,导致计算量巨大且容易过拟合。

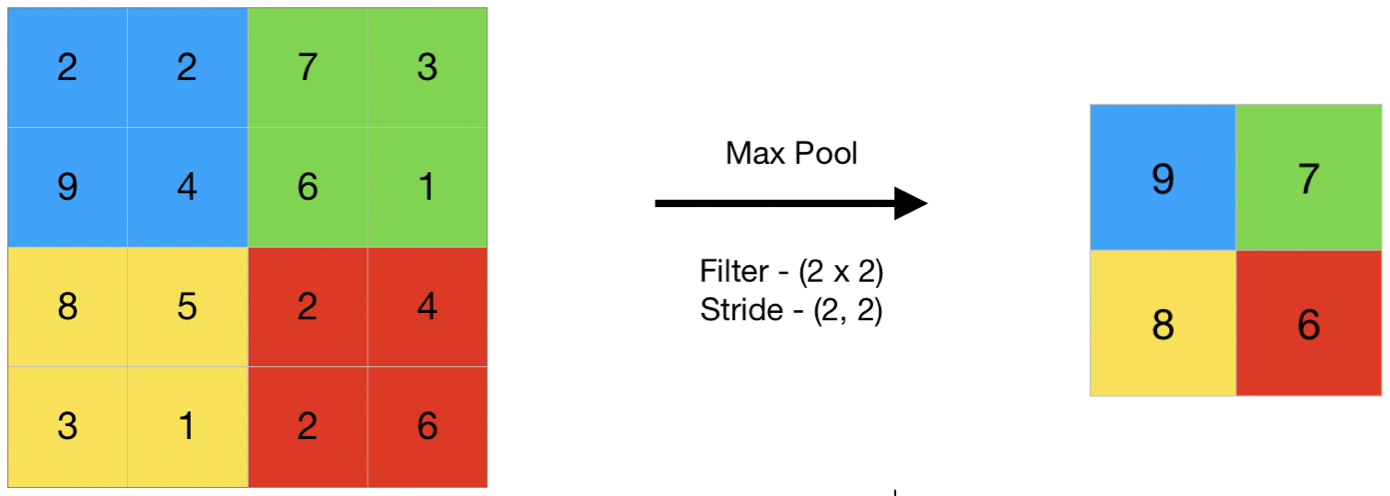

卷积神经网络(CNN)作为一种特殊的深度学习网络,特别适合处理具有网格结构的数据,如图像。CNN的核心思想是利用局部感受野、权重共享和池化层来提取图像的空间特征。局部感受野允许网络只关注输入数据的一个小区域,而权重共享则意味着网络在处理图像的不同位置时复用相同的滤波器,从而极大地减少了模型的参数数量。池化层则用来降低特征维度,提高网络对平移、缩放和旋转等变化的不变性。

### 2.1.2 CNN的架构与关键组件

一个典型的CNN架构包括输入层、卷积层、激活层、池化层、全连接层和输出层。输入层负责接收原始图像数据。卷积层通过应用多个可学习的滤波器(也称为卷积核或特征检测器)来提取图像特征。激活层,如ReLU(Rectified Linear Unit),为模型引入非线性,提高模型的表达能力。池化层在空间维度上对数据进行降采样,减少计算量和控制过拟合。最后,全连接层将学习到的特征映射到样本标记空间进行分类。

### 2.1.3 CNN的架构与关键组件的代码示例

为了更好地理解CNN的工作原理,下面是一个使用TensorFlow和Keras构建简单CNN模型的代码示例。

```python

import tensorflow as tf

from tensorflow.keras import datasets, layers, models

# 加载CIFAR10数据集

(train_images, train_labels), (test_images, test_labels) = datasets.cifar10.load_data()

# 归一化图像数据

train_images, test_images = train_images / 255.0, test_images / 255.0

# 构建CNN模型

model = models.Sequential()

model.add(layers.Conv2D(32, (3, 3), activation='relu', input_shape=(32, 32, 3)))

model.add(layers.MaxPooling2D((2, 2)))

model.add(layers.Conv2D(64, (3, 3), activation='relu'))

model.add(layers.MaxPooling2D((2, 2)))

model.add(layers.Conv2D(64, (3, 3), activation='relu'))

# 添加全连接层

model.add(layers.Flatten())

model.add(layers.Dense(64, activation='relu'))

model.add(layers.Dense(10))

# 编译模型

model.compile(optimizer='adam',

loss=tf.keras.losses.SparseCategoricalCrossentropy(from_logits=True),

metrics=['accuracy'])

# 训练模型

history = model.fit(train_images, train_labels, epochs=10,

validation_data=(test_images, test_labels))

```

在上述代码中,我们首先加载了CIFAR-10数据集,并对其进行了归一化处理。然后我们构建了一个包含三个卷积层和两个池化层的简单CNN模型。接着我们添加了全连接层,并使用`adam`优化器和`SparseCategoricalCrossentropy`损失函数进行编译。最后,我们使用`fit`方法训练模型,并观察在训练集和测试集上的性能。

## 2.2 CNN图像识别的数据预处理

### 2.2.1 数据增强技术

数据增强是提高模型泛化能力的有效手段。通过增加训练集的多样性和大小,可以帮助模型学习到更加鲁棒的特征。常见的数据增强技术包括旋转、缩放、平移、翻转、裁剪和颜色调整等。在图像识别任务中,数据增强可以让模型更加适应不同的拍摄条件,如不同的光照和角度。

```python

from tensorflow.keras.preprocessing.image import ImageDataGenerator

# 实例化数据增强生成器

datagen = ImageDataGenerator(

rotation_range=20,

width_shift_range=0.2,

height_shift_range=0.2,

horizontal_flip=True,

fill_mode='nearest'

)

# 使用数据生成器进行数据增强

history_generator = datagen.flow(train_images, train_labels, batch_size=32)

```

在上述代码中,我们使用`ImageDataGenerator`类来创建一个数据增强生成器,其中包括了旋转、平移和水平翻转等操作。然后我们可以使用这个生成器来批量生成增强后的数据,用于模型训练。

### 2.2.2 归一化与标准化方法

归一化和标准化是数据预处理的常用方法,可以加速模型的收敛速度并提高模型的泛化性能。归一化将数值缩放到[0, 1]区间,而标准化则是将数据的均值变为0,标准差变为1。

```python

import numpy as np

# 归一化处理

train_images_normalized = train_images / 255.0

# 标准化处理

train_images_normalized = (train_images - np.mean(train_images)) / np.std(train_images)

```

在上述代码中,我们首先对训练图像进行了归一化处理,然后进行了标准化处理。通过这种方式,图像数据被适当地缩放,可以加快模型训练过程。

## 2.3 CNN的训练过程

### 2.3.1 前向传播与反向传播算法

在CNN中,前向传播是指数据从输入层到输出层的正向传递过程。通过前向传播,我们可以计算输出结果与真实标签之间的误差。反向传播是指基于误差反向计算梯度的过程,这些梯度用于更新网络中的权重。

```python

# 前向传播计算输出

output = model(train_images_normalized)

# 计算损失函数值

loss = loss_function(train_labels, output)

# 反向传播计算梯度

gradients = tape.gradient(loss, model.trainable_variables)

# 更新权重

optimizer.apply_gradients(zip(gradients

```

0

0