视觉框架大对决:TensorFlow vs PyTorch的选择攻略

发布时间: 2024-11-21 16:36:12 阅读量: 34 订阅数: 32

知识领域: 机器学习 技术关键词: TensorFlow、PyTorch、机器学习算法

# 1. 深度学习框架概述

在当今的科技领域,深度学习框架已成为不可或缺的工具,它们极大地简化了复杂神经网络的设计、训练和部署工作。这些框架抽象了底层的数学运算和优化算法,为研究者和开发者提供了更高级的API接口,使得实现深度学习模型变得更加直观和高效。

本章将对深度学习框架的概念进行简要回顾,并探讨其发展背景。接下来,我们将深入分析目前最流行的两个深度学习框架:TensorFlow和PyTorch。我们会了解它们各自的核心原理、特性、以及如何在实践中选择使用。

我们会从全局的角度审视这些框架,了解它们如何适应不同的工作流程,并为不同层次的深度学习项目带来影响。对于初学者和专业开发者而言,本章的概述将为深入理解后续章节的内容打下坚实的基础。

# 2. TensorFlow核心原理与特性

## 2.1 TensorFlow的计算图与会话

### 2.1.1 计算图的构建与优化

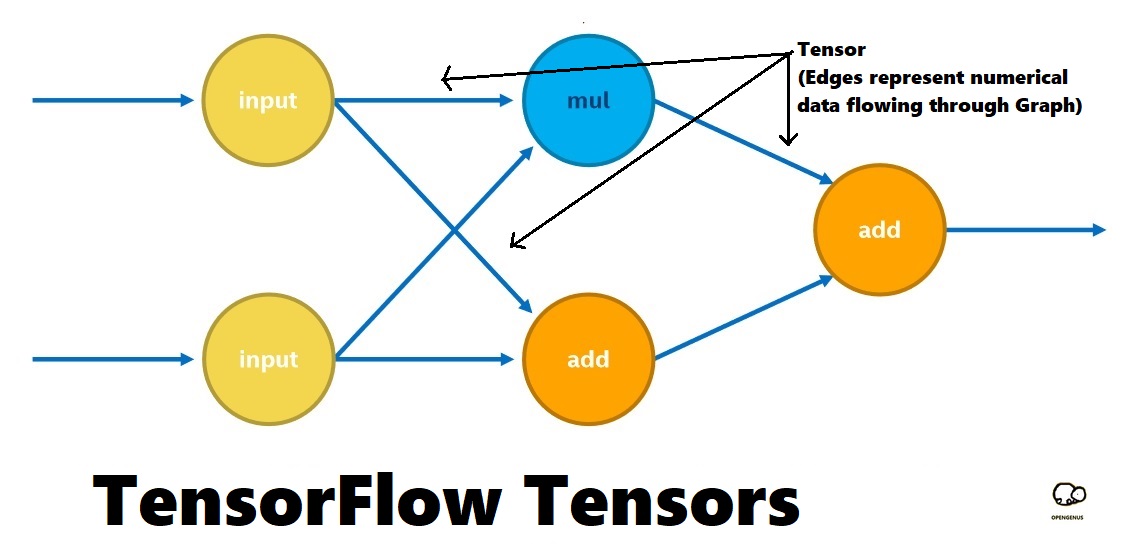

TensorFlow中的计算图是一个有向无环图(DAG),它描述了计算的流程。每个节点代表一个操作(如加法、乘法、卷积等),而边代表节点间的多维数组数据流,即张量(Tensor)。计算图的核心作用是抽象和优化计算过程,让开发者能够专注于模型的构建,而将底层的执行细节留给TensorFlow的运行时系统。

构建计算图的步骤通常涉及定义操作节点和数据流。在TensorFlow 1.x中,计算图的构建和执行是分离的,而在TensorFlow 2.x中,Eager Execution模式提供了一种更加直观的方式,允许开发者直接操作数据流和执行节点。

```python

import tensorflow as tf

# 在TensorFlow 1.x中定义计算图

g = tf.Graph()

with g.as_default():

a = tf.constant([[1, 2], [3, 4]])

b = tf.constant([[5, 6], [7, 8]])

c = tf.add(a, b)

```

在上述代码中,我们首先创建了一个`tf.Graph()`实例,该实例是计算图的基础。通过`with g.as_default():`,我们指定了后续操作都在这个图上执行。随后,我们定义了两个常量`a`和`b`,以及它们的加法操作`c`。这里需要注意的是,操作定义完成后,节点并未立即执行。

为了进一步优化计算图,TensorFlow提供了图变换(Graph Transformations)工具,允许开发者对图进行裁剪和优化,比如节点融合(Node Fusion)、死代码消除(Dead Code Elimination)等。

### 2.1.2 会话的启动与资源管理

TensorFlow的会话(Session)是图执行的实际载体。在TensorFlow 1.x中,会话管理了图的生命周期,负责执行图中定义的操作,并返回操作的结果。而在TensorFlow 2.x中,Eager Execution模式下,会话被自动管理,无需手动创建。

```python

# 在TensorFlow 1.x中启动会话并执行图

with tf.Session(graph=g) as sess:

result = sess.run(c)

print(result)

```

在这个例子中,我们使用`tf.Session()`启动了一个会话,并指定了图`g`作为参数。通过`sess.run(c)`,我们将计算图中的加法操作`c`提交给会话进行计算,并获取结果。

在资源管理方面,TensorFlow的会话负责分配和释放计算资源。在完成计算任务后,开发者需要调用会话的`close()`方法来释放资源。为了避免资源泄漏,TensorFlow 2.x引入了`with`语句,以确保会话正确关闭,例如:

```python

# 在TensorFlow 2.x中自动管理资源

print(tf.reduce_sum([[1, 2], [3, 4]] + [[5, 6], [7, 8]]))

```

上例中,`tf.reduce_sum`直接在Eager模式下运行,无需手动管理会话。

## 2.2 TensorFlow的数据流管道

### 2.2.1 数据集API的使用与自定义

TensorFlow提供了一组强大的API,以构建高效和可扩展的数据加载管道,这些API被集成在`tf.data`模块中。`tf.data.Dataset`类是构建数据管道的核心,它允许开发者以声明式的方式组合各种数据转换操作。

一个典型的数据管道包含以下步骤:

1. 创建数据集(例如,从内存、文件或自定义生成器中)。

2. 应用数据转换和预处理操作(如映射、批处理、打乱等)。

3. 创建迭代器来遍历数据集。

```python

import tensorflow as tf

# 使用tf.data.Dataset API创建数据管道

dataset = tf.data.Dataset.from_tensor_slices((data, labels))

dataset = dataset.shuffle(buffer_size).batch(batch_size)

```

在上述代码中,`from_tensor_slices`方法将一组numpy数组转换为数据集。`shuffle`方法对数据进行随机打乱,`batch`方法将数据分为指定大小的批次。

开发者可以自定义数据集,通过创建一个继承自`tf.data.Dataset`的子类来实现特定的数据处理逻辑。自定义数据集通常通过实现`_generate_transformed_element`方法来完成,该方法负责生成处理后的数据元素。

### 2.2.2 数据预处理与增强方法

数据预处理是深度学习训练过程中的重要步骤,它包括归一化、标准化、数据增强等多种技术。在TensorFlow中,数据预处理通常集成在`tf.data`管道中,并可利用现有的转换函数和方法。

```python

# 数据预处理示例

dataset = dataset.map(lambda x, y: (tf.divide(x, 255.0), y))

dataset = dataset.map(lambda x, y: (tf.image.random_flip_left_right(x), y))

```

在上述代码中,我们使用`map`方法对数据集中的每个元素应用了两个预处理操作:第一个`map`操作将图片数据归一化至[0,1]区间内,第二个`map`操作通过随机水平翻转来增强数据集。

数据增强是一个提升模型泛化能力的常用技术,尤其在图像识别领域。TensorFlow通过`tf.image`模块提供了各种图像处理操作,如旋转、缩放、裁剪等,这些都可以作为数据增强的方法。

## 2.3 TensorFlow的高级工具与接口

### 2.3.1 TensorFlow Hub与预训练模型

TensorFlow Hub是Google提供的一个开源库,它允许开发者分享和发布可复用的机器学习模块,这些模块可以在多个任务中被重用。通过TensorFlow Hub,开发者可以轻松地将最新的预训练模型集成到自己的项目中。

TensorFlow Hub中的模块包括经过训练的权重和模型架构。这些模块可以直接被用作特征提取器,或者作为转移学习的基础。在使用TensorFlow Hub时,通常需要执行以下步骤:

1. 导入TensorFlow Hub模块。

2. 通过指定的函数或类进行模型构建。

3. 在自定义的数据管道中适配模块。

```python

import tensorflow as tf

import tensorflow_hub as hub

# 使用TensorFlow Hub中的预训练模型

module_url = "https://tfhub.dev/google/imagenet/resnet_v2_50/classification/4"

model = tf.keras.Sequential([

hub.KerasLayer(module_url, trainable=False),

tf.keras.layers.Dense(num_classes, activation='softmax')

])

```

在上面的例子中,我们首先导入了TensorFlow和TensorFlow Hub的模块。然后,我们使用`tf.keras.Sequential`来创建一个模型,并添加一个从TensorFlow Hub导入的预训练模型层。`trainable=False`参数表示在训练过程中冻结该层的权重,通常在转移学习初期使用。

### 2.3.2 TensorFlow Extended (TFX)的生产级部署

TFX是TensorFlow的一个端到端机器学习平台,旨在简化从数据准备到模型部署的完整生命周期。TFX被设计用来支持在生产环境中部署机器学习模型,它包括了一系列的组件来处理数据验证、模型训练、优化、评估以及部署等任务。

一个典型的TFX流水线包括以下组件:

- **TFX组件**:如Transform、Trainer、Evaluator、Pusher等。

- **服务**:如ML Metadata (MLMD) 存储。

- **数据流**:从数据准备到模型评估再到模型部署。

```mermaid

graph LR

A[数据源] -->|训练数据| B[Transform]

B -->|转换数据| C[Trainer]

C -->|训练好的模型| D[Evaluator]

D -->|评估结果| E[Pusher]

E -->|最终模型| F[模型部署]

```

在上面的Mermaid流程图中,我们展示了TFX流水线的基本流程。数据首先通过`Transform`进行预处理,接着由`Trainer`组件训练模型,然后`Evaluator`用于评估模型的性能,`Pusher`最后负责将模型部署到生产环境。

TFX组件之间通过ML Metadata共享元数据,这些元数据记录了关于数据集、训练结果和模型版本的信息。这种元数据管理方式有助于开发者维护模型的版本和理解数据的来源,确保模型的可追溯性和可靠性。

TFX的使用使得机器学习工程师可以更加关注模型本身,而不是底层的数据处理和部署细节。这种从模型构建到部署的无缝过渡极大地降低了生产级机器学习应用的复杂性。

以上章节展示了TensorFlow核心原理与特性的深入分析。在下一节中,我们将详细探讨PyTorch的核心原理与特性,并对这两种深度学习框架进行对比

0

0