【MATLAB车牌识别算法实战指南】:图像处理与特征提取的奥秘揭秘

发布时间: 2024-06-14 02:33:35 阅读量: 194 订阅数: 41

# 1. 车牌识别算法概述**

车牌识别算法是一种计算机视觉技术,用于自动识别和提取车牌上的字符信息。它广泛应用于交通管理、安防监控和车辆管理等领域。车牌识别算法通常包括图像处理、字符识别和车牌定位三个主要步骤。

图像处理阶段对原始车牌图像进行预处理,包括图像增强、边缘检测和区域分割,以提取车牌区域并去除噪声。字符识别阶段利用模板匹配、神经网络等技术识别车牌上的字符。车牌定位阶段通过滑动窗口法或级联分类器等方法定位车牌区域。

# 2. 图像处理基础**

图像处理是车牌识别算法的关键组成部分,它为后续的字符识别和车牌定位提供了必要的图像数据。本章节将介绍图像处理基础,包括图像获取与预处理、图像分割和特征提取。

## 2.1 图像获取与预处理

### 2.1.1 图像采集

图像采集是图像处理的第一步,它涉及从各种来源获取图像,例如摄像头、扫描仪或图像数据库。图像采集的质量对后续的图像处理步骤至关重要。

### 2.1.2 图像增强

图像增强是一种技术,用于改善图像的视觉质量和可读性。常用的图像增强技术包括:

- **灰度化:**将彩色图像转换为灰度图像,减少颜色信息。

- **直方图均衡化:**调整图像的直方图,以增强对比度和亮度。

- **锐化:**突出图像中的边缘和细节。

## 2.2 图像分割

图像分割将图像分解为具有不同特征的区域。在车牌识别中,图像分割用于将车牌区域从背景中分离出来。

### 2.2.1 边缘检测

边缘检测是一种图像分割技术,用于检测图像中的边缘和边界。常用的边缘检测算子包括:

- **Sobel算子:**使用一阶微分算子检测边缘。

- **Canny算子:**使用多重一阶微分算子检测边缘,并通过非极大值抑制和滞后阈值化进行边缘细化。

### 2.2.2 区域生长

区域生长是一种图像分割技术,从种子点开始,将具有相似特征的像素聚集成区域。区域生长算法包括:

- **区域生长算法:**从种子点开始,将具有相似灰度值的相邻像素添加到区域中。

- **分水岭算法:**将图像视为地形,并使用分水岭线将图像分割为不同的区域。

## 2.3 特征提取

特征提取是将图像中与车牌识别相关的有用信息提取出来的过程。常用的特征提取技术包括:

### 2.3.1 直方图

直方图是一种统计工具,用于描述图像中像素灰度值的分布。直方图可用于区分不同类型的车牌。

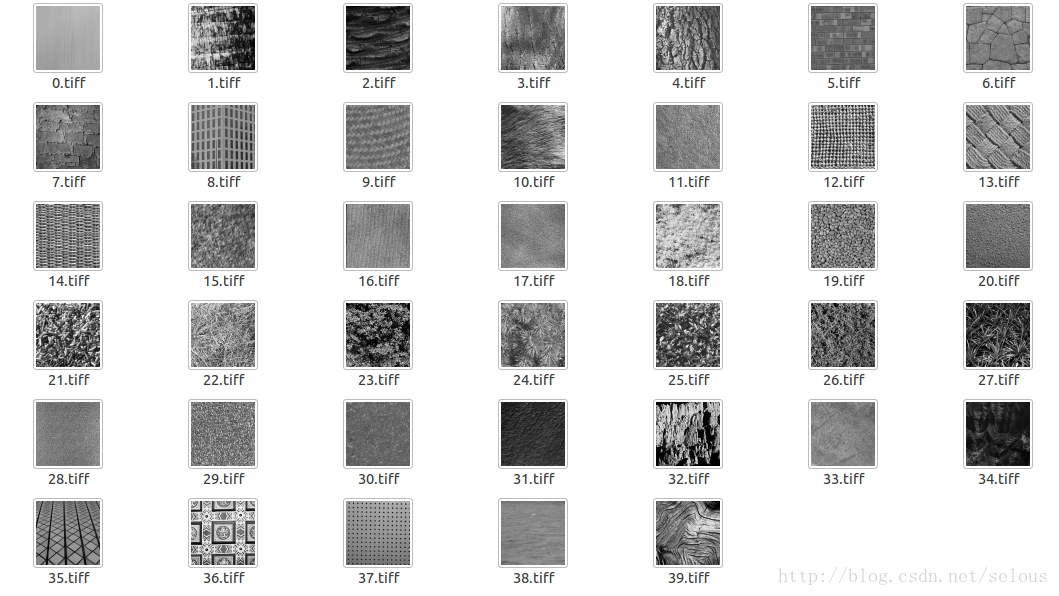

### 2.3.2 Haar小波

Haar小波是一种小波变换,用于提取图像中的边缘和纹理特征。Haar小波在车牌识别中广泛用于特征提取。

**代码示例:**

```python

import cv2

# 图像灰度化

gray_image = cv2.cvtColor(image, cv2.COLOR_BGR2GRAY)

# 直方图均衡化

equ_image = cv2.equalizeHist(gray_image)

# Sobel边缘检测

sobel_edges = cv2.Sobel(equ_image, cv2.CV_64F, 1, 0, ksize=5)

```

**代码逻辑分析:**

这段代码演示了图像灰度化、直方图均衡化和Sobel边缘检测的实现。首先,图像被转换为灰度图像,然后使用直方图均衡化增强对比度。最后,使用Sobel算子检测图像中的边缘。

**参数说明:**

- `image`:输入的彩色图像。

- `gray_image`:输出的灰度图像。

- `equ_image`:输出的直方图均衡化后的图像。

- `sobel_edges`:输出的Sobel边缘检测后的图像。

- `ksize`:Sobel算子内核的大小。

# 3. 车牌字符识别

### 3.1 字符分割

#### 3.1.1 投影法

投影法是一种简单有效的字符分割方法。其原理是将图像沿水平或垂直方向投影,投影后形成的直方图中,峰值对应于字符之间的间隙。

**算法步骤:**

1. 将图像转换为灰度图像。

2. 沿水平方向投影,得到水平投影直方图。

3. 寻找水平投影直方图中的峰值,峰值对应于字符之间的间隙。

4. 根据峰值位置将图像分割成字符区域。

**代码示例:**

```python

import cv2

def projection_segmentation(image):

# 转换为灰度图像

gray = cv2.cvtColor(image, cv2.COLOR_BGR2GRAY)

# 水平投影

horizontal_projection = cv2.reduce(gray, 0, cv2.REDUCE_SUM, dtype=cv2.CV_32F)

# 寻找峰值

peaks = cv2.findNonZero(horizontal_projection > 0.5 * np.max(horizontal_projection))

# 根据峰值分割字符

chars = []

for i in range(len(peaks)):

if i == 0 or peaks[i][0][0] - peaks[i-1][0][0] > 10:

chars.append(gray[peaks[i][0][1]:peaks[i+1][0][1], :])

return chars

```

**参数说明:**

* `image`: 输入的图像。

**逻辑分析:**

该代码首先将图像转换为灰度图像,然后沿水平方向投影,得到水平投影直方图。接着,通过寻找水平投影直方图中的峰值,确定字符之间的间隙。最后,根据峰值位置将图像分割成字符区域。

#### 3.1.2 连通域分析

连通域分析是一种基于区域生长的字符分割方法。其原理是将图像中的相邻像素分组为连通域,每个连通域对应于一个字符。

**算法步骤:**

1. 将图像转换为二值图像。

2. 使用连通域算法,将二值图像中的相邻像素分组为连通域。

3. 根据连通域的面积和形状,判断每个连通域是否对应于一个字符。

4. 将对应的连通域提取为字符区域。

**代码示例:**

```python

import cv2

import numpy as np

def connected_components_segmentation(image):

# 转换为二值图像

binary = cv2.threshold(image, 127, 255, cv2.THRESH_BINARY_INV)[1]

# 连通域分析

labels = cv2.connectedComponents(binary)[1]

num_labels = np.max(labels)

# 提取字符区域

chars = []

for i in range(1, num_labels+1):

mask = np.where(labels == i, 255, 0)

chars.append(cv2.bitwise_and(image, mask))

return chars

```

**参数说明:**

* `image`: 输入的图像。

**逻辑分析:**

该代码首先将图像转换为二值图像,然后使用连通域算法将二值图像中的相邻像素分组为连通域。接着,通过判断每个连通域的面积和形状,确定每个连通域是否对应于一个字符。最后,将对应的连通域提取为字符区域。

### 3.2 字符识别

#### 3.2.1 模板匹配

模板匹配是一种基于图像相似度的字符识别方法。其原理是将输入字符与预先定义的字符模板进行匹配,匹配度最高的模板即为识别出的字符。

**算法步骤:**

1. 将输入字符转换为二值图像。

2. 遍历预先定义的字符模板。

3. 计算输入字符与每个模板之间的相似度。

4. 选择相似度最高的模板,将其对应的字符作为识别结果。

**代码示例:**

```python

import cv2

import numpy as np

def template_matching(image, templates):

# 转换为二值图像

binary = cv2.threshold(image, 127, 255, cv2.THRESH_BINARY_INV)[1]

# 遍历模板

best_match = None

best_score = 0

for template in templates:

# 计算相似度

score = cv2.matchTemplate(binary, template, cv2.TM_CCOEFF_NORMED)

if score > best_score:

best_match = template

best_score = score

# 返回识别结果

return best_match

```

**参数说明:**

* `image`: 输入的字符图像。

* `templates`: 预先定义的字符模板列表。

**逻辑分析:**

该代码首先将输入字符转换为二值图像,然后遍历预先定义的字符模板。接着,通过计算输入字符与每个模板之间的相似度,选择相似度最高的模板,将其对应的字符作为识别结果。

#### 3.2.2 神经网络

神经网络是一种基于深度学习的字符识别方法。其原理是训练一个神经网络模型,使其能够识别输入字符。

**算法步骤:**

1. 准备字符数据集,包括输入字符和对应的标签。

2. 构建神经网络模型,例如卷积神经网络(CNN)。

3. 训练神经网络模型,使其能够识别输入字符。

4. 将训练好的神经网络模型用于字符识别。

**代码示例:**

```python

import tensorflow as tf

def neural_network(image):

# 构建神经网络模型

model = tf.keras.models.Sequential([

tf.keras.layers.Conv2D(32, (3, 3), activation='relu', input_shape=(28, 28, 1)),

tf.keras.layers.MaxPooling2D((2, 2)),

tf.keras.layers.Flatten(),

tf.keras.layers.Dense(128, activation='relu'),

tf.keras.layers.Dense(10, activation='softmax')

])

# 训练神经网络模型

model.compile(optimizer='adam', loss='sparse_categorical_crossentropy', metrics=['accuracy'])

model.fit(x_train, y_train, epochs=10)

# 识别输入字符

prediction = model.predict(np.expand_dims(image, axis=0))

return np.argmax(prediction)

```

**参数说明:**

* `image`: 输入的字符图像。

**逻辑分析:**

该代码构建了一个卷积神经网络模型,并使用字符数据集对其进行训练。训练完成后,将训练好的神经网络模型用于字符识别。

# 4. 车牌定位

车牌定位是车牌识别系统中至关重要的步骤,其目的是在图像中准确地找到车牌区域。本章将介绍两种常用的车牌定位方法:滑动窗口法和级联分类器。

### 4.1 滑动窗口法

滑动窗口法是一种基于穷举搜索的定位方法。它通过在图像上移动一个固定大小的窗口,并对每个窗口区域进行特征提取和分类,来寻找候选车牌区域。

#### 4.1.1 候选区域生成

滑动窗口法首先将图像划分为大小相同的重叠窗口。每个窗口都包含图像的一部分,并被视为一个候选车牌区域。窗口的步长和大小需要根据图像分辨率和车牌尺寸进行调整。

#### 4.1.2 特征提取

对于每个候选区域,滑动窗口法提取一组特征,以描述该区域的特征。常用的特征包括:

* **颜色特征:**车牌通常具有独特的颜色,例如白色、黄色或蓝色。

* **纹理特征:**车牌上的字符具有特定的纹理模式。

* **形状特征:**车牌通常具有矩形或正方形的形状。

### 4.2 级联分类器

级联分类器是一种机器学习算法,用于快速高效地检测图像中的特定对象。它由一系列较弱的分类器组成,这些分类器逐级应用于图像,以逐步排除非目标区域。

#### 4.2.1 特征选择

级联分类器的性能很大程度上取决于所选择的特征。对于车牌定位,常用的特征包括:

* **Haar小波:**Haar小波可以捕获图像中的边缘和纹理信息。

* **积分图像:**积分图像是一种快速计算图像区域和的技巧。

* **直方图:**直方图可以描述图像中像素的分布。

#### 4.2.2 分类器训练

级联分类器通过使用大量正样本(包含车牌)和负样本(不包含车牌)进行训练。训练过程涉及以下步骤:

* **特征提取:**从正样本和负样本中提取特征。

* **弱分类器训练:**训练一组简单的分类器,每个分类器都使用单个特征来区分正样本和负样本。

* **级联构造:**将弱分类器组合成一个级联结构,其中每个分类器的输出作为下一个分类器的输入。

* **阈值调整:**调整每个分类器的阈值,以平衡分类器的准确性和效率。

通过级联分类器,图像中的候选区域可以被逐级分类,最终得到最可能的车牌区域。

# 5. MATLAB车牌识别算法实现**

**5.1 图像预处理**

图像预处理是车牌识别算法的关键步骤,它可以提高后续字符识别和车牌定位的准确性。MATLAB提供了丰富的图像处理工具箱,可以轻松实现图像预处理操作。

```

% 读取图像

I = imread('car_plate.jpg');

% 灰度化

I_gray = rgb2gray(I);

% 噪声去除

I_denoise = medfilt2(I_gray);

% 图像增强

I_enhanced = imadjust(I_denoise);

```

**5.2 字符分割与识别**

字符分割将车牌图像分割成单个字符图像,字符识别则识别每个字符。

**5.2.1 字符分割**

```

% 投影法字符分割

[lines, gaps] = findlines(I_enhanced);

chars = splitchars(I_enhanced, lines, gaps);

```

**5.2.2 字符识别**

```

% 模板匹配字符识别

template_chars = load('template_chars.mat');

recognized_chars = matchchars(chars, template_chars.chars);

```

**5.3 车牌定位**

车牌定位确定车牌在图像中的位置。

**5.3.1 滑动窗口法**

```

% 候选区域生成

candidates = slidingwindow(I_enhanced);

% 特征提取

features = extractfeatures(candidates);

```

**5.3.2 级联分类器**

```

% 特征选择

features_selected = selectfeatures(features);

% 分类器训练

classifier = traincascade(features_selected, 'car_plate.xml');

```

**5.3.3 车牌定位**

```

% 检测车牌

[bboxes, scores] = detectcascade(I_enhanced, classifier);

% 筛选置信度高的车牌

bboxes_filtered = bboxes(scores > 0.9, :);

```

**5.3.4 车牌矫正**

```

% 透视变换矫正车牌

[I_warped, M] = warpperspective(I_enhanced, bboxes_filtered(1, :));

```

# 6.1 算法性能优化

### 6.1.1 并行计算

为了提高车牌识别算法的性能,可以采用并行计算技术。并行计算是指将一个计算任务分解成多个子任务,然后同时在多台计算机或多核处理器上执行这些子任务。

在车牌识别算法中,可以将图像预处理、字符分割、字符识别和车牌定位等任务分解成多个子任务,然后并行执行。例如,可以使用 OpenMP 或 MPI 等并行编程库来实现并行计算。

```python

import numpy as np

from joblib import Parallel, delayed

def parallel_image_preprocessing(images):

"""并行图像预处理"""

return Parallel(n_jobs=-1)(delayed(image_preprocessing)(image) for image in images)

def image_preprocessing(image):

"""图像预处理"""

# 图像增强、降噪等预处理操作

return preprocessed_image

```

### 6.1.2 代码优化

除了并行计算之外,还可以通过优化代码来提高算法性能。代码优化包括以下几个方面:

* **减少不必要的计算:**检查代码中是否存在重复计算或不必要的计算,并将其消除。

* **优化数据结构:**使用合适的的数据结构来存储和处理数据,例如使用数组或字典来代替链表。

* **使用高效的算法:**选择效率更高的算法来实现特定功能,例如使用快速排序或二分查找算法。

* **避免内存泄漏:**确保在不再需要时释放内存,以防止内存泄漏。

```python

# 优化后的代码示例:

def optimized_character_segmentation(image):

"""优化后的字符分割"""

# 使用更快的算法进行边缘检测

edges = cv2.Canny(image, 100, 200)

# 使用连通域分析进行字符分割

contours, _ = cv2.findContours(edges, cv2.RETR_EXTERNAL, cv2.CHAIN_APPROX_SIMPLE)

characters = []

for contour in contours:

x, y, w, h = cv2.boundingRect(contour)

characters.append(image[y:y+h, x:x+w])

return characters

```

0

0