决策树超参数调优:如何平衡解释性与性能,专家的平衡艺术

发布时间: 2024-09-05 05:25:53 阅读量: 65 订阅数: 49

# 1. 决策树基础与超参数概述

## 1.1 决策树简介

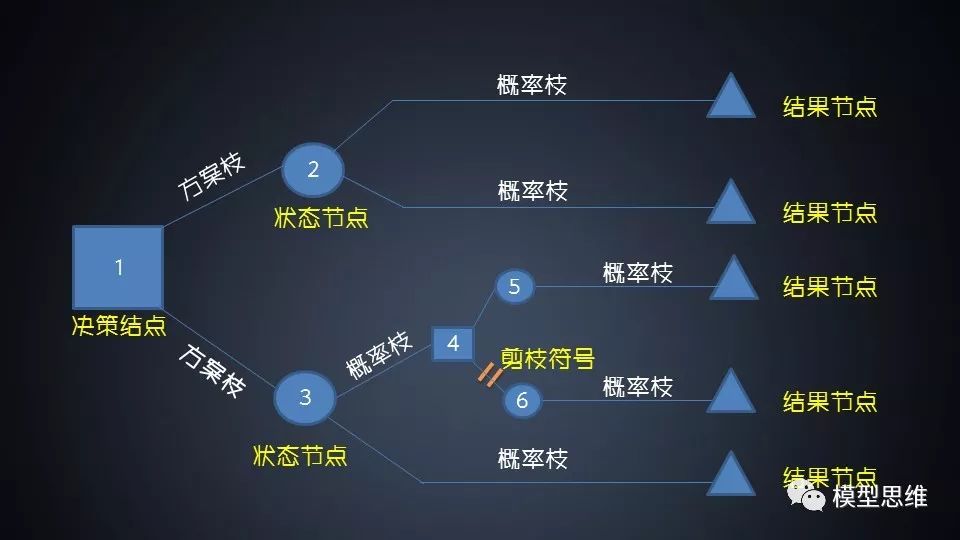

决策树是一种广泛应用的机器学习算法,因其直观和易于理解而受到青睐。它模拟了人类做决策的过程,通过一系列规则对数据进行分类或回归。每个节点代表一个属性上的判断,每个分支代表判断结果的输出,而每个叶节点代表一种分类结果。

## 1.2 超参数的作用

在构建决策树模型时,超参数的设定对模型性能和解释性具有决定性影响。超参数通常不通过训练学习得到,而是需要在建模前设定。它们决定了树的结构,包括树的深度、分支方式及最终的复杂度。

## 1.3 决策树与超参数优化的重要性

理解和优化决策树的超参数对提高模型准确性和效率至关重要。一个优化的决策树能够更好地泛化到新数据上,同时保持足够的解释性来满足业务需求。接下来的章节将深入探讨决策树的解释性、性能优化策略以及如何调整超参数。

# 2. 理解决策树的解释性

## 决策树模型的特点

### 决策树的构成和工作原理

决策树是一种经典的机器学习算法,它通过一系列的问题划分数据集来构建模型。每个问题对应一个节点(Node),而每个节点进一步分为子节点。最终,这种问题划分会形成一个树状结构,每个叶节点(Leaf)代表一个分类或者预测结果。

工作原理上,决策树从根节点开始,基于某种准则(比如信息增益或Gini指数)选取特征并进行分割,根据分割结果将数据分为不同的子集,并在子集上递归地重复这个过程。当达到某个终止条件时(例如,子集中所有样本属于同一类别或达到最大深度),构建过程结束,形成叶节点。整个过程可以视为一种贪心算法,通过局部最优解来逼近全局最优解。

### 决策树的可视化和逻辑清晰度

决策树的主要优势之一是其高度的可视化和易于理解的逻辑结构。通过树状图的可视化展示,即使是非专业人士也能较容易理解模型的决策过程。每个内部节点代表数据集中的一个特征,而边代表特征的不同取值。叶节点显示分类结果。

逻辑清晰度让决策树在需要解释模型预测原因的场合变得非常有用。这在医疗诊断、金融信贷审批等领域尤为重要,因为决策树能够以一种直观的方式说明决策依据。

### 决策树的可解释性评价指标

#### 理解度量标准:Gini指数和信息增益

评价决策树模型性能的常用指标包括基尼不纯度(Gini Index)和信息增益(Information Gain)。

- 基尼不纯度:衡量从数据集中随机选取两个样本,其类别标签不一致的概率。基尼不纯度越低,数据的纯度越高,表示节点的分类效果越好。

- 信息增益:基于熵的概念,衡量在知道某个特征的信息之后数据不确定性减少的程度。信息增益越大,表示该特征对分类的贡献越大。

在构建决策树时,一般会使用以上指标来确定最佳的特征分割点,从而提高模型的准确性和可解释性。

#### 可解释性对业务决策的影响

在业务决策中,模型的可解释性是一个重要的考量因素。一个高可解释性的模型可以帮助决策者理解模型的决策逻辑,提高对模型预测结果的信任度。同时,当模型的预测结果与预期不符时,可解释性可以帮助找到原因,从而调整模型或业务策略。

例如,在信贷审批模型中,如果模型拒绝了某个客户的贷款申请,决策者可以通过查看决策树的路径来了解拒绝的原因。这可以是客户的信用评分低于某个阈值,或者是财务状况没有满足一定的条件。这种清晰的解释性大大增强了业务的透明度和公正性。

### 表格:决策树常用度量标准对比

| 度量标准 | 描述 | 适用场景 | 计算复杂度 |

| --- | --- | --- | --- |

| Gini Index | 基于概率的不纯度度量 | 速度快,适用于二分类和多分类问题 | 低 |

| Information Gain | 基于熵的度量,衡量信息的不确定性减少量 | 适用于分类问题,但计算成本较高 | 高 |

### 代码块:构建决策树模型

```python

from sklearn.tree import DecisionTreeClassifier

from sklearn.datasets import load_iris

from sklearn.model_selection import train_test_split

from sklearn.metrics import accuracy_score

# 加载数据集

iris = load_iris()

X, y = iris.data, iris.target

# 划分训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.3, random_state=42)

# 构建决策树模型

clf = DecisionTreeClassifier(criterion='gini') # 使用基尼不纯度作为分割标准

clf.fit(X_train, y_train)

# 进行预测

y_pred = clf.predict(X_test)

# 计算并输出准确率

print(f'Accuracy: {accuracy_score(y_test, y_pred)}')

```

在构建决策树模型时,可以通过`criterion`参数指定不同的度量标准。在本例中,使用了基尼不纯度。在应用决策树模型后,对测试数据集进行预测,并计算了准确率。

### 逻辑分析和参数说明

在上述代码块中,我们使用了`sklearn`库中的`DecisionTreeClassifier`来构建一个决策树分类器。我们加载了Iris数据集,这是一个常用的分类数据集,包含了三种不同种类的鸢尾花的特征数据。通过`train_test_split`函数,我们划分了训练集和测试集,比例为70%训练集和30%测试集。

构建模型时,我们没有对决策树的深度、叶节点的最小样本数等参数进行特别设置,这意味着使用了`DecisionTreeClassifier`的默认参数。在实践中,这些超参数的设置对于提高模型的性能和解释性至关重要。

### 总结

本章节介绍了决策树模型的特点,包括其构成、工作原理以及可视化优势。我们深入探讨了决策树的可解释性评价指标,包括Gini指数和信息增益,以及它们对业务决策的影响。通过代码块展示了如何构建一个基本的决策树模型,为读者提供了一个直观的理解和实践机会。通过以上内容,读者应能更好地掌握决策树模型的核心概念和应用方法。

# 3. 决策树的性能优化策略

## 3.1 决策树超参数的分类和作用

### 3.1.1 树深度、叶节点最小样本数等基础超参数

在构建决策树模型时,超参数的选择是影响模型性能的关键因素。其中,树深度(max_depth)和叶节点最小样本数(min_samples_leaf)是两个基础且对模型影响显著的超参数。

树深度(max_depth)定义了树的最大层数,即决策树从根节点到叶节点的最大路径长度。如果树深度过大,模型可能会过拟合,因为过深的树会记住训练数据中的噪声。相反,如果树深度太浅,模型可能欠拟合,无法捕捉到数据中的规律。

叶节点最小样本数(min_samples_leaf)是指构成叶节点所需的最小样本数目。当设置较大值时,可以减少模型的复杂度,避免过拟合。然而,过大的值会导致模型泛化能力降低,不能很好地适应新数据。

```python

from sklearn.datasets import load_iris

from sklearn.tree import DecisionTreeClassifier

# 加载数据集

iris = load_iris()

X, y = iris.data, iris.target

# 创建决策树分类器实例

clf = DecisionTreeClassifier(max_depth=3, min_samples_leaf=5)

# 训练模型

clf.fit(X, y)

```

在上述Python代码中,我们使用了scikit-learn库创建了一个决策树分类器,其中`max_depth=3`和`min_samples_leaf=5`分别设置了树的最大深度和叶节点的最小样本数。

### 3.1.2 正则化项和剪枝策略的影响

正则化项和剪枝策略是控制决策树复杂度、防止过拟合的重要工具。正则化项通过引入一个惩罚项来约束模型的复杂度,常见的正则化项有L1和L2。在决策树中,正则化项的作用是对叶节点的纯度进行惩罚,促使树选择更加简单的结构。

剪枝策略是对已经生成的决策树进行简化的过程。它分为预剪枝(pre-pruning)和后剪枝(post-pruning)。预剪枝在树构建过程中提前停止树的增长,而后剪枝是在树构建完成后,移除那些对输出影

0

0