【动态内容解析大师】:使用PyQuery解析动态加载的数据

发布时间: 2024-10-01 01:49:41 阅读量: 45 订阅数: 35

android 动态解析获取json数据的键值对

# 1. PyQuery与动态数据解析简介

在当今的互联网时代,动态内容无处不在,从在线新闻、社交媒体到电子商务平台,这些网站大多利用JavaScript动态地加载数据,以提供更为丰富的用户体验。然而,这为数据提取带来了新的挑战,传统的数据抓取技术难以应对动态加载的内容。PyQuery应运而生,它是一个强大的Python库,能够利用CSS选择器解析HTML和XML文档,并且它非常适合处理动态数据。

PyQuery的出现,让Python开发者能够像操作jQuery一样简洁地操作和解析HTML,它简化了数据抽取的过程,提高了爬虫和数据抓取的效率。本章将介绍PyQuery的基本概念,以及如何使用PyQuery进行动态数据的解析。通过本章内容的学习,读者将对PyQuery有一个初步的认识,并了解到动态数据解析的重要性。这将为后续章节中更深入的技术实践和应用打下坚实的基础。

# 2. PyQuery基础知识

## 2.1 PyQuery的基本安装与配置

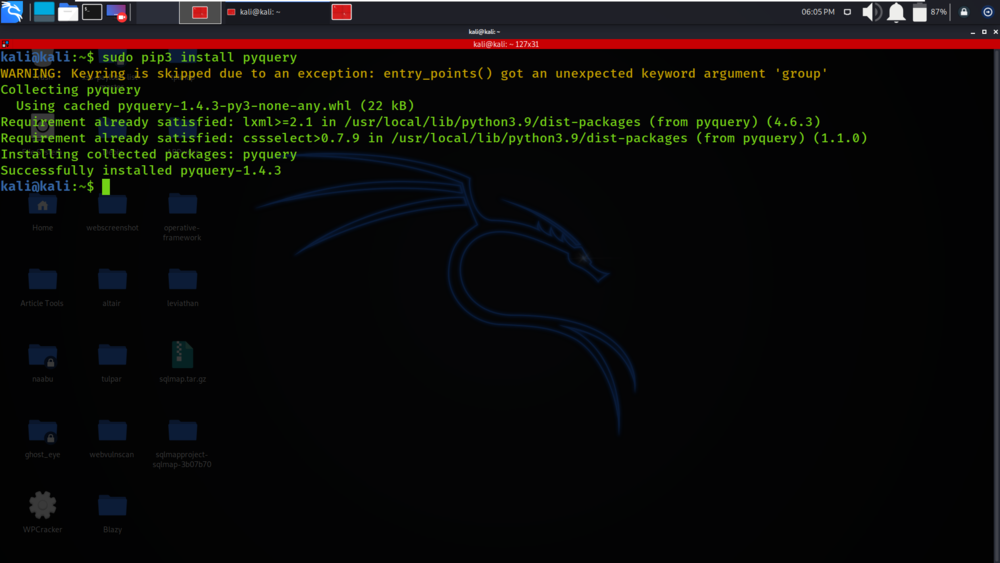

### 2.1.1 安装PyQuery库的几种方法

PyQuery是Python中一个强大的库,用于解析和操作HTML和XML文档,类似于jQuery的语法风格。我们可以利用以下方法来安装PyQuery:

- 使用pip安装:这是最简单且常用的方法。在命令行中输入以下命令:

```bash

pip install pyquery

```

- 使用conda进行安装:如果你的开发环境使用conda作为包管理工具,那么可以使用以下命令进行安装:

```bash

conda install -c conda-forge pyquery

```

- 从源码安装:如果你需要最新版本的PyQuery或者想尝试自己开发的版本,可以从GitHub上克隆项目源码,然后手动安装。

### 2.1.2 配置PyQuery环境的注意事项

在配置PyQuery环境时,有几项重要的注意事项需要遵循:

- 确保Python版本兼容:PyQuery要求Python版本至少为2.7或3.4及以上,确保你的Python版本满足要求。

- 虚拟环境的使用:为了保证环境的整洁,推荐在虚拟环境中安装PyQuery。可以使用`virtualenv`或`conda env`创建隔离的Python环境。

- 安装依赖库:PyQuery依赖于`lxml`库,所以确保`lxml`或`xml.etree.ElementTree`(Python自带的XML库)已正确安装。

- 注意网络安全问题:安装过程中,请确保只从可信的源安装PyQuery库,避免潜在的安全风险。

## 2.2 PyQuery的语法结构

### 2.2.1 CSS选择器在PyQuery中的使用

PyQuery允许我们使用CSS选择器来选取HTML文档中的特定部分。下面是几个示例:

```python

from pyquery import PyQuery as pq

# 选择页面内所有的div元素

d = pq('<html><div class="container"><p>PyQuery is awesome!</p></div></html>')

print(d('div.container').text())

# 选择具有特定id的元素

print(d('#container').text())

# 选择具有特定class的元素

print(d('.container').text())

```

### 2.2.2 PyQuery对象的操作方法

PyQuery对象的操作方法非常丰富,包括但不限于:

```python

d = pq('<div><p>PyQuery is awesome!</p><p>It is so powerful.</p></div>')

# 获取节点的文本内容

print(d('p').text())

# 添加新元素

d('div').append('<p>New paragraph!</p>')

# 删除元素

d('p:last').remove()

```

### 2.2.3 PyQuery与jQuery的相似之处和差异

PyQuery的设计初衷是向jQuery靠拢,因此在语法和API设计上有很多相似之处,使得从jQuery转向PyQuery的开发者能够快速上手。但是,二者在一些细节上也存在差异:

- 语法差异:PyQuery支持直接使用CSS选择器,而jQuery需要使用`$()`来选取元素。

- 文件格式支持:PyQuery能够处理XML和HTML,而jQuery主要集中在HTML文档操作。

- 性能差异:PyQuery在执行时可能对性能进行优化,因为它内建了一些处理函数。

## 2.3 PyQuery的文档操作

### 2.3.1 解析HTML文档的基本步骤

解析HTML文档并获取所需数据是PyQuery的常见用途之一。下面是基本步骤:

```python

# 加载HTML文档

doc = pq('<div class="content"><h1>PyQuery tutorial</h1></div>')

# 选择特定元素并获取内容

heading = doc('h1').text()

print(f'Heading: {heading}')

```

### 2.3.2 编辑和修改HTML元素

PyQuery提供了丰富的API来编辑和修改HTML元素。例如:

```python

# 修改元素的class

doc('h1').addClass('big')

# 修改元素的文本内容

doc('h1').text('Updated heading')

print(doc.html())

```

### 2.3.3 从HTML中提取数据

提取数据是PyQuery另一个非常重要的用法。例如:

```python

# 假设有一个HTML文档,我们需要从中提取所有链接

doc = pq('<div><a href="***">Link 1</a><a href="***">Link 2</a></div>')

links = doc('a').items()

for link in links:

print(link.attrib['href'])

```

通过以上步骤,我们可以有效地解析HTML文档,并提取其中的数据。这为动态数据的解析奠定了基础,也为接下来的章节提供了重要的基础知识。

# 3. 动态数据解析技巧

在这一章节中,我们将深入探讨动态数据解析的技巧,这是现代Web开发和数据抓取过程中不可或缺的一环。首先,我们会介绍如何识别和分析动态加载的数据,以及它们的来源和加载机制。接下来,会重点讲解如何使用PyQuery获取和解析这些动态内容。最后,我们通过两个实战案例,让读者能够更直观地理解动态数据解析的应用。

## 3.1 动态数据的识别与分析

### 3.1.1 如何识别动态加载的数据

在Web页面上,动态加载的数据通常是通过Ajax或其他异步请求技术从服务器动态获取的。这些数据可能包括用户评论、实时股票报价、天气信息等,它们在页面初始加载时并不包含在HTML中,而是在页面加载完成后,通过JavaScript动态地添加到DOM树中。

识别动态加载数据的一个简单方法是:

1. 使用浏览器的开发者工具(DevTools)进行网络监控。

2. 在网络请求面板中,找到请求类型为“XHR”或“Fetch”的记录,这些通常是动态加载数据的来源。

3. 观察响应,查看返回的数据格式(通常是JSON或XML)。

### 3.1.2 分析动态数据的来源和加载机制

动态数据的来源可能分为几种类型,比如API端点、WebSocket、或者使用JavaScript直接修改DOM。加载机制通常分为以下几种:

- **请求-响应模式**:前端发送请求到后端API,后端返回数据,前端接收数据并更新页面。

- **推送模式**:服务器主动将数据推送给客户端,例如WebSocket技术。

- **客户端脚本动态更新**:客户端JavaScript脚本读取数据并更新页面,可能是从本地缓存或者从其他数据源。

为了分析动态数据的加载机制,我们可以:

- 分析网络请求:查看请求头、请求方法、参数等,了解是如何发起的。

- 观察响应数据:了解返回数据的格式和内容,判断数据结构。

- 使用时间轴分析:在开发者工具中,利用时间轴记录页面加载的各个环节,了解数据加载的时机。

## 3.2 使用PyQuery获取动态内容

### 3.2.1 处理Ajax请求和响应

PyQuery本身并不直接处理Ajax请求,通常会结合其他工具(如Selenium、Requests等)来获取动态内容。但我们可以使用PyQuery来解析通过Ajax请求返回的HTML或JSON数据。

示例代码如下:

```python

import requests

from pyquery import PyQuery as pq

# 发起Ajax请求

url = '***'

response = requests.get(url)

data = response.json() # 假设返回的数据是JSON格式

# 使用PyQuery解析返回的HTML数据

if 'html' in data:

doc = pq(data['html'])

# 对文档进行操作

else:

print("数据不是HTML格式")

```

在上述代码中,我们首先使用Requests库发起一个HTTP GET请求到API端点,然后解析返回的JSON数据。如果数据中包含HTML内容,我们则使用PyQuery解析它。

### 3.2.2 实时监听页面元素变化

PyQuery同样不能直接实现实时监控DOM变化的功能,这通常需要结合浏览器的开发者工具或者使用浏览器自动化工具如Selenium。

但我们可以利用PyQuery对页面变化进行分析和数据提取,通过定时刷新页面或在DOM发生变化时重新加载页面数据:

```python

import requests

from pyquery import PyQuery as pq

from time import sleep

def fetch_data(url):

response = requests.get(url)

return response.json()

def update_content(url, selector):

previous_data = {}

while True:

data = fetch_data(url)

doc = pq(data['html'])

current_data = doc(selector).text()

if current_data != previous_data:

print(f"发现更新: {current_data}")

previous_data = current_data

sleep(5) # 每5秒检查一次变化

update_content('***', '.target-data-selector')

```

在这个例子中,我们定义了一个`update_content`函数,它会不断请求更新的数据并使用PyQuery来检查页面中的特定元素内容是否有变化。

## 3.3 动态内容解析的实践案例

### 3.3.1 实战:解析在线股票信息

假设我们要解析某个网站上的实时股票信息,这些信息是通过JavaScript动态加载的。

1. **分析数据源**:通过浏览器开发者工具的网络监控,找到动态加载股票信息的Ajax请求。

2. **获取数据**:使用PyQuery结合Requests库或者Selenium获取并解析这些数据。

3. **提取数据**:通过PyQuery的选择器功能,提取股票代码、价格、涨跌幅度等信息。

示例代码片段:

```python

from selenium import webdriver

from pyquery import PyQuery as pq

# 启动Selenium驱动

driver = webdriver.Chrome()

# 打开目标页面

driver.get('***')

# 等待页面加载

sleep(3)

# 使用PyQuery解析页面

doc = pq(driver.page_source)

# 提取股票信息

stocks = doc('.stock-item').items()

for stock in stocks:

stock_code = stock.find('.code').text()

stock_price = stock.find('.price').text()

print(f"股票代码: {stock_code}, 当前价格: {stock_price}")

# 关闭驱动

driver.quit()

```

### 3.3.2 实战:提取在线论坛帖子数据

动态内容解析的另一个实战例子是提取在线论坛的帖子信息,这些信息也可能通过Ajax异步加载。

1. **分析网页**:通过浏览器开发者工具找到动态加载帖子内容的JavaScript代码。

2. **模拟请求**:分析请求的参数和请求方法,尝试使用Requests库模拟这个请求。

3. **解析数据**:获取到帖子内容的HTML后,使用PyQuery提取帖子标题、作者、内容等信息。

示例代码片段:

```python

import requests

from pyquery import PyQuery as pq

# 模拟请求论坛的Ajax请求

url = '***'

params = {'page': 1, 'per_page': 10}

response = requests.get(url, params=params)

data = response.json()

# 提取帖子信息

posts = data['posts']

for post in posts:

post_title = post['title']

post_author = post['author']

post_content = post['content']

print(f"帖子标题: {post_title}\n作者: {post_author}\n内容: {post_content}\n")

```

在动态内容解析中,PyQuery提供了强大的HTML文档操作能力,结合其他工具,可以有效地处理动态加载的Web数据。以上案例展示了如何将PyQuery应用在实战中,通过具体的代码示例和逻辑分析,加深了我们对动态内容解析技巧的理解。

# 4. PyQuery高级应用

## 4.1 异步数据加载与处理

在现代Web应用中,异步数据加载(AJAX技术)是一种常见的技术,它能够实现无需刷新整个页面就能加载新数据。这种方法虽然提升了用户体验,但也给数据抓取带来了额外的挑战。

### 4.1.1 使用Selenium与PyQuery结合处理异步加载

Selenium是一个用于Web应用测试的工具,但它也被广泛用于模拟用户行为,如点击、滚动和填表等操作,这对于处理异步加载的数据非常有用。结合PyQuery,可以实现复杂的动态内容解析。

首先,安装Selenium库并下载对应的WebDriver。

```bash

pip install selenium

```

以下是一个简单的Python脚本,展示如何使用Selenium定位到一个动态加载数据的元素,并使用PyQuery进行解析。

```***

***mon.keys import Keys

from selenium.webdriver.support.ui import WebDriverWait

from selenium.webdriver.support import expected_conditions as EC

from pyquery import PyQuery as pq

driver = webdriver.Chrome() # 或者使用其他浏览器驱动

driver.get("***") # 替换为目标页面URL

try:

# 等待异步数据加载完成

element = WebDriverWait(driver, 10).until(

EC.presence_of_element_located((By.ID, "data-container"))

)

# 使用PyQuery解析页面

doc = pq(driver.page_source)

# 操作文档...

# 示例:提取某数据

data = doc.find("#data-container").text()

finally:

driver.quit()

```

### 4.1.2 分析异步加载数据的XHR请求

另一种处理异步加载数据的方式是直接分析浏览器发出的XHR请求。使用开发者工具可以找到触发数据加载的XHR请求,然后可以使用PyQuery解析响应内容。

具体操作步骤如下:

1. 打开开发者工具,切换到“Network”标签页。

2. 刷新页面,观察网络请求,找到对应的XHR请求。

3. 右键点击请求,选择“Copy as cURL”(复制为cURL命令)。

4. 将复制的cURL命令转换为Python代码,并使用`requests`库来发送请求。

5. 使用PyQuery解析返回的HTML响应。

```python

import requests

from pyquery import PyQuery as pq

# 假设复制得到的cURL命令如下

url = '***'

headers = {

'User-Agent': 'Mozilla/5.0',

# 其他可能的HTTP头信息

}

response = requests.get(url, headers=headers)

doc = pq(response.content)

# 操作文档...

```

通过上述方法,可以有效地处理和解析异步加载的数据。需要注意的是,对于某些网站,可能还需要处理登录认证、CSRF令牌、Cookies管理等安全措施。

## 4.2 PyQuery在Web爬虫中的应用

### 4.2.1 构建基础爬虫框架

PyQuery不仅可以用于解析动态内容,还可以作为构建Web爬虫的工具之一。以下是构建基础爬虫框架的步骤:

1. **目标页面分析**:确定爬虫的目标页面,分析页面结构,确定需要抓取的数据。

2. **请求发送**:使用`requests`等HTTP库发送请求获取页面内容。

3. **内容解析**:使用PyQuery解析响应的HTML,提取所需数据。

4. **数据存储**:将提取的数据保存到文件或数据库中。

5. **异常处理**:确保爬虫能够处理异常情况,如网络错误、数据结构变化等。

6. **爬虫调度**:设置爬虫运行时间、频率和抓取深度等。

以下是使用PyQuery构建爬虫的一个示例:

```python

import requests

from pyquery import PyQuery as pq

def fetch_data(url):

try:

response = requests.get(url)

doc = pq(response.text)

# 提取数据...

return data

except Exception as e:

print(f"Error occurred: {e}")

if __name__ == "__main__":

url = "***"

data = fetch_data(url)

print(data)

```

### 4.2.2 遇到反爬机制的PyQuery解决方案

在使用PyQuery进行爬虫开发时,经常会遇到各种反爬措施,如验证码、IP限制、User-Agent检查等。针对这些问题,可以采取以下策略:

- **动态User-Agent**:循环使用不同的User-Agent来模拟真实用户的访问行为。

- **IP代理**:使用代理池技术,通过不同IP进行请求。

- **请求头伪造**:模拟浏览器的请求头进行请求,如添加`Referer`、`Accept`等信息。

- **验证码识别**:使用OCR技术或第三方验证码识别服务解决验证码问题。

```python

from pyquery import PyQuery as pq

import requests

from fake_useragent import UserAgent

ua = UserAgent()

def fetch_data(url):

headers = {

"User-Agent": ua.random,

# 其他必要的HTTP头信息

}

proxies = {

'http': '***',

'https': '***',

}

try:

response = requests.get(url, headers=headers, proxies=proxies)

doc = pq(response.text)

# 提取数据...

return data

except Exception as e:

print(f"Error occurred: {e}")

if __name__ == "__main__":

url = "***"

data = fetch_data(url)

print(data)

```

## 4.3 PyQuery错误处理与日志记录

### 4.3.1 PyQuery异常捕获与处理机制

在使用PyQuery进行页面解析时,可能会遇到各种异常情况,如选择器错误、找不到元素等。合理使用异常处理机制可以避免程序意外中断。

```python

from pyquery import PyQuery as pq

import requests

def safe_parse(url):

try:

response = requests.get(url)

doc = pq(response.text)

return doc

except Exception as e:

# 在这里可以记录日志,打印异常信息等

print(f"Failed to parse URL {url} due to {e}")

return None

if __name__ == "__main__":

url = "***"

document = safe_parse(url)

if document:

# 继续进行数据提取...

```

### 4.3.2 记录日志与调试PyQuery应用

在开发过程中,记录日志可以方便地追踪程序运行情况和调试问题。使用Python的`logging`模块可以实现日志记录功能。

```python

import logging

from pyquery import PyQuery as pq

import requests

logging.basicConfig(level=***)

def parse_with_logging(url):

try:

response = requests.get(url)

doc = pq(response.text)

# 提取数据...

***(f"Successfully parsed URL: {url}")

return doc

except Exception as e:

logging.error(f"Failed to parse URL: {url} due to {e}")

return None

if __name__ == "__main__":

url = "***"

document = parse_with_logging(url)

if document:

# 继续进行数据提取...

```

通过以上示例可以看出,PyQuery的异常处理和日志记录机制对于维护程序的健壮性和可调试性至关重要。

# 5. 动态内容解析的进阶实战

在本章节,我们将深入探讨动态内容解析的进阶实战应用,将从构建实时数据监控系统、结合数据分析的方法论,以及高级动态内容解析案例分析三个方面来展开。

## 5.1 构建实时数据监控系统

### 5.1.1 实时监控网页变化的策略

为了实时监控网页的变化,我们首先需要确定监控的触发条件,比如页面的特定部分发生了更新,或是某个特定的元素值发生了变化。接下来,我们需要一个有效的方法来周期性地检查这些条件是否得到满足。以下是实现这一策略的几个关键步骤:

1. **定义监控目标:**确定需要监控的页面以及需要关注的页面元素。

2. **选择合适的监控工具:**可以使用像Selenium这样的自动化测试工具来模拟浏览器的行为。

3. **编写监控脚本:**利用PyQuery处理Selenium获取的页面源码,检查变化。

4. **数据存储与通知:**一旦发现变化,将数据存储到数据库,并通过邮件或消息服务通知相关人员。

为了确保监控的实时性,我们可以将这个监控脚本设置为定时任务,或者使用Webhook来实现事件驱动的监控。

```***

***mon.by import By

import time

def check_for_changes(driver, element_selector, expected_value):

# 检查页面是否已加载完成

driver.implicitly_wait(10)

# 找到指定元素并获取其值

element = driver.find_element(By.CSS_SELECTOR, element_selector)

current_value = element.text

# 判断当前值是否与期望值一致

if current_value == expected_value:

return True

return False

# 初始化WebDriver

driver = webdriver.Chrome()

driver.get("***")

# 循环检查条件

while True:

if not check_for_changes(driver, "#target-element", "expected-value"):

# 如果检测到变化,则可以在这里处理数据和发送通知

print("变化已检测到!")

# 存储数据和发送通知的代码

time.sleep(60) # 每分钟检查一次

```

在上面的代码示例中,我们使用了Selenium库来模拟浏览器的行为,并通过PyQuery解析页面,来监控特定元素的变化。这里的`check_for_changes`函数是我们创建的一个检查变化的函数,通过CSS选择器找到目标元素,并与期望值进行比对。

### 5.1.2 实际案例:创建股票价格监控系统

创建一个实时监控股票价格变化的系统,我们需要关注股票价格的实时数据,并在价格出现变化时通知用户。这里可以利用股票市场的API接口,定期获取最新价格数据,然后使用PyQuery检查这些数据的变化。

```python

import requests

import time

def get_stock_price(stock_code):

# 假设有一个提供股票数据的API

response = requests.get(f"***{stock_code}")

data = response.json()

return data["price"]

def check_stock_price_change(stock_code, expected_price):

current_price = get_stock_price(stock_code)

if current_price != expected_price:

print(f"股票{stock_code}的价格已从{expected_price}变更为{current_price}。")

# 这里可以添加发送通知的代码

stock_code = "000001" # 以某股票代码为例

expected_price = 1000 # 假设的股票价格

while True:

check_stock_price_change(stock_code, expected_price)

time.sleep(300) # 每5分钟检查一次价格变化

```

在这个实际案例中,我们定义了一个`get_stock_price`函数从股票市场的API接口中获取股票的当前价格,然后在`check_stock_price_change`函数中,我们检查价格是否发生了变化,并在变化时输出提示信息。

## 5.2 动态内容解析与数据分析

### 5.2.1 分析动态数据集的方法论

动态数据通常包含大量信息,要想有效地利用这些数据,我们需要使用数据分析的方法论,从数据中提取有价值的信息。以下是进行动态数据集分析时可能会采用的一些方法论:

1. **数据预处理:**清洗数据,处理缺失值和异常值。

2. **探索性数据分析(EDA):**使用统计方法和可视化手段探索数据集的基本特征。

3. **构建数据模型:**根据分析目的,选择合适的统计模型或机器学习模型。

4. **结果评估:**使用适当的评估标准来检验模型的有效性。

5. **结果部署:**将分析结果转换为实际应用,比如提供决策支持。

使用PyQuery和Pandas进行数据可视化是一个强大的组合,能够将复杂的动态数据进行可视化展示,帮助我们更好地理解数据和发现趋势。

```python

import pandas as pd

import pyquery as pq

# 假设已经从动态加载的页面中抓取了数据

html_data = """

<div id="data-container">

<div class="data-point">10</div>

<div class="data-point">25</div>

<div class="data-point">15</div>

<div class="data-point">40</div>

</div>

# 使用PyQuery解析HTML并提取数据

doc = pq.PyQuery(html_data)

data_points = [int(pq.text(p)) for p in doc('div.data-point')]

# 将提取的数据转换为Pandas DataFrame

df = pd.DataFrame({'data': data_points})

# 使用Pandas的绘图功能来可视化数据

df.plot(kind='bar')

```

### 5.2.2 实战:使用PyQuery和Pandas进行数据可视化

假设我们从动态加载的网页中提取了某些数据,并想要通过图表的形式来展示这些数据。我们可以使用PyQuery来解析HTML,并结合Pandas进行数据处理和可视化。

```python

import matplotlib.pyplot as plt

# 假设df是已经创建好的DataFrame

df = pd.DataFrame({'data': [10, 25, 15, 40]})

# 使用matplotlib绘制柱状图

plt.figure(figsize=(10, 6))

df.plot(kind='bar', ax=plt.gca())

plt.title('Data Visualization with PyQuery and Pandas')

plt.xlabel('Data Point')

plt.ylabel('Value')

plt.show()

```

以上代码展示了如何使用matplotlib库与Pandas的DataFrame进行结合,将数据通过柱状图的形式展示出来,为数据分析结果提供直观的视觉表示。

## 5.3 高级动态内容解析案例分析

### 5.3.1 高级案例:社交媒体趋势分析

社交媒体平台上的动态内容包含了大量关于用户行为、产品反馈和市场趋势的信息。解析这些内容可以帮助企业洞察市场和用户需求。动态数据的高级解析通常涉及以下几个步骤:

1. **数据采集:**使用爬虫技术从社交媒体API或页面上获取动态数据。

2. **内容解析:**分析并提取用户评论、点赞数、转发数等关键信息。

3. **情感分析:**利用自然语言处理技术对文本内容进行情感分析,判断正负面情绪。

4. **趋势预测:**利用时间序列分析等方法对数据进行趋势预测。

```python

# 伪代码,演示如何使用PyQuery和第三方库进行社交媒体数据的解析

from tweepy import Stream

import pyquery as pq

import json

def on_status(stream, status):

# 使用PyQuery解析获取到的推文内容

tweet = pq(json.loads(status))

# 提取并分析推文的关键信息

text = pq.text(tweet('p.text'))

analysis = sentiment_analysis(text)

# 打印分析结果

print(f"推文内容: {text}, 情感倾向: {analysis}")

# 认证并连接到Twitter的流媒体

stream = Stream认证信息, 'keywords')

stream.filter(track=['keywords'], is_async=True)

# 定义情感分析函数(需要使用特定的NLP库,如TextBlob)

def sentiment_analysis(text):

# 假设使用TextBlob进行情感分析

from textblob import TextBlob

return TextBlob(text).sentiment.polarity

# 在实际应用中,需要处理认证和连接的细节,以及定义更复杂的分析逻辑

```

### 5.3.2 高级案例:自动化测试中的动态数据交互

在自动化测试过程中,经常需要与动态加载的内容进行交互。例如,测试一个网站的表单填写流程时,可能需要填写由JavaScript动态生成的表单项。使用PyQuery可以方便地操作和测试这些动态内容。

```python

import pytest

from selenium import webdriver

from pyquery import PyQuery as pq

def setup_function():

# 初始化WebDriver

driver = webdriver.Chrome()

driver.get("***")

def test_dynamic_form_field():

# 使用Selenium定位到动态加载的表单项

driver = pq(driver.page_source)

form_field = driver.find('input[name="dynamic_field"]')

# 输入测试数据

form_field.val("Test Data")

# 验证输入是否成功

assert form_field.val() == "Test Data"

def teardown_function():

# 关闭浏览器

driver.quit()

```

以上代码展示了如何在使用Selenium进行自动化测试时,结合PyQuery处理动态加载的表单字段。我们通过定位到特定的表单项,并进行值的设置和验证,以确保测试的正确性。

通过这些实战案例,我们可以看到PyQuery在动态内容解析的进阶应用中如何发挥重要作用。它能够帮助开发者高效地处理和分析动态加载的内容,为数据监控、数据分析和自动化测试等提供有力支持。

# 6. PyQuery扩展应用与展望

在上一章节中,我们深入了解了动态内容解析的进阶实战,并探索了如何构建实时数据监控系统以及使用PyQuery进行数据分析和可视化。随着技术的不断进步,PyQuery也在不断地扩展其应用范围,并与其他技术融合。本章将着重探讨PyQuery的扩展应用与未来的发展趋势。

## 6.1 PyQuery的插件与扩展库

PyQuery作为一个强大的库,其能力不仅限于内置的功能。社区不断贡献了许多插件和扩展库,这些资源极大地丰富了PyQuery的功能,使其能够应对更加复杂和多变的解析任务。

### 6.1.1 探索PyQuery的插件生态

在探索PyQuery的插件生态时,我们首先需要了解如何查找和使用这些插件。一个常用的途径是通过PyPI(Python Package Index)搜索PyQuery相关插件。例如,`pyquery-plugin-xpath` 插件扩展了PyQuery对XPath的支持,使其可以更加灵活地处理复杂的HTML结构。

```python

# 示例代码:使用pyquery-plugin-xpath插件

from pyquery import PyQuery as pq

from pyquery_plugin_xpath import PyQueryXpath as pqx

html = """

<div>

<ul>

<li class="item-0">first item</li>

<li class="item-1">second item</li>

<li class="item-2">third item</li>

</ul>

</div>

doc = pq(html)

items = pqx(doc).css('li').xpath('.//li').items()

for item in items:

print(item.text)

```

这段代码演示了如何使用扩展库`pyquery-plugin-xpath`结合PyQuery进行元素的查询。需要注意的是,安装扩展库前,应确认其兼容性以及对PyQuery版本的要求。

### 6.1.2 实践:集成第三方库进行复杂操作

除了使用官方插件外,我们还可以根据实际需求,集成其他第三方库来扩展PyQuery的功能。比如,在处理大量数据时,我们可以借助`pandas`库将PyQuery解析的数据导出为DataFrame,进而进行复杂的数据分析。

```python

import pandas as pd

from pyquery import PyQuery as pq

html_content = """

<table>

<tr>

<th>Name</th>

<th>Age</th>

</tr>

<tr>

<td>John</td>

<td>27</td>

</tr>

<tr>

<td>Jane</td>

<td>23</td>

</tr>

</table>

doc = pq(html_content)

data = []

for row in doc('tr'):

name = row.find('td')[0].text

age = row.find('td')[1].text

data.append([name, age])

df = pd.DataFrame(data, columns=['Name', 'Age'])

print(df)

```

通过上述代码,我们能够将PyQuery解析的数据转换成pandas的DataFrame对象,这样就更容易利用pandas提供的丰富功能进行数据处理和分析。

## 6.2 PyQuery与其他技术的融合

PyQuery不仅可以独立使用,还能与其他技术如机器学习、大数据平台等进行深度整合,从而构建出更为强大的应用。

### 6.2.1 PyQuery结合机器学习应用示例

结合机器学习技术,我们可以利用PyQuery从网页中提取数据,作为训练机器学习模型的输入。例如,我们可以提取评论内容,并使用文本分类算法来预测评论的情感倾向。

```python

from sklearn.feature_extraction.text import CountVectorizer

from sklearn.naive_bayes import MultinomialNB

from sklearn.pipeline import make_pipeline

# 假设我们已经使用PyQuery提取了评论数据

comments = ["This is a great movie!", "Not a fan of this one."]

labels = [1, 0] # 1 表示正面评论,0 表示负面评论

vectorizer = CountVectorizer()

classifier = MultinomialNB()

model = make_pipeline(vectorizer, classifier)

# 训练模型

model.fit(comments, labels)

```

在这个示例中,我们创建了一个简单的文本分类流程,使用PyQuery提取评论数据,并构建了一个朴素贝叶斯分类器。这种方式可以广泛应用于情感分析、评论自动分类等任务。

### 6.2.2 PyQuery在大数据平台的角色和应用

随着大数据技术的发展,PyQuery能够处理的数据量也在不断扩大。结合大数据平台,我们可以利用PyQuery进行大规模网页内容的抓取和解析,为大数据分析提供丰富的原始数据。

```python

# 示例代码:使用PyQuery和Hadoop进行大规模数据抓取和解析

from pyquery import PyQuery as pq

from mrjob.job import MRJob

class MRPyQueryScraper(MRJob):

def mapper(self, _, url):

response = requests.get(url)

doc = pq(response.text)

for element in doc('div'):

yield element.attrib['id'], element.text()

if __name__ == '__main__':

MRPyQueryScraper.run()

```

在这个示例中,我们创建了一个`MRJob`类,它可以作为Hadoop MapReduce作业运行。通过PyQuery获取网页内容,并从中提取所需的信息。这种方式适用于需要在分布式环境中处理大量网页数据的场景。

## 6.3 未来动态内容解析的趋势与挑战

随着互联网技术的不断发展,动态内容解析在数据抓取、监控、分析等领域的应用变得越来越广泛。未来的趋势和挑战也应引起我们的关注。

### 6.3.1 随着Web技术演进的动态解析新动向

现代Web应用越来越依赖于JavaScript动态渲染页面内容,这使得传统爬虫难以抓取到动态生成的数据。未来动态内容解析将需要更多地依赖于JavaScript渲染引擎(如Selenium、Puppeteer)和无头浏览器技术。

### 6.3.2 应对动态内容解析中的安全问题

动态内容解析在提高数据抓取效率的同时,也带来了安全风险。例如,爬虫可能会遭遇反爬机制、分布式拒绝服务(DDoS)攻击等安全威胁。因此,未来的动态内容解析工具需要集成更加智能的安全策略,比如行为模拟、IP代理池、自动化反爬识别与绕过等技术。

通过上述内容的探讨,我们可以发现PyQuery不仅是一个用于解析静态HTML的强大工具,它还在不断地发展和拓展,与多种技术融合,成为处理动态数据的有效解决方案。随着技术的演进,我们可以期待PyQuery及其相关技术未来将会带给我们更多令人激动的应用。

0

0