【PyQuery终极指南】:掌握网页数据提取的艺术

发布时间: 2024-10-01 01:38:25 阅读量: 48 订阅数: 36

# 1. PyQuery简介与环境配置

PyQuery是一个基于Python的库,用于解析HTML和XML文档。它的设计灵感来源于jQuery,因此很多熟悉jQuery的开发者会发现PyQuery的API非常亲切。PyQuery的优势在于简洁易用的API设计和强大的CSS选择器支持,使得在Python环境中进行网页数据提取变得异常方便。接下来的章节将逐步介绍如何设置环境、创建PyQuery对象以及如何应用PyQuery进行高效的数据操作和提取。

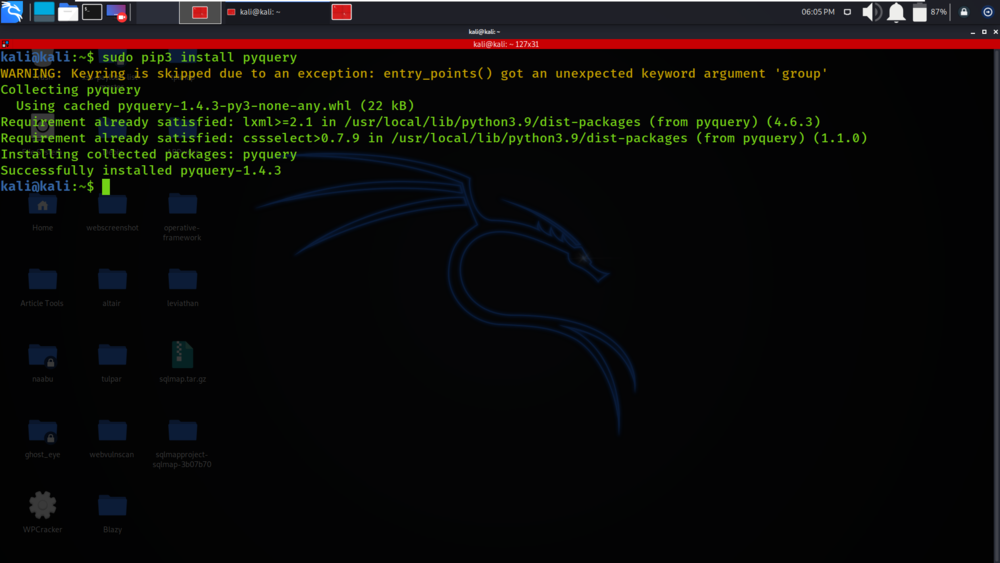

在开始使用PyQuery之前,需要确保Python环境已经正确安装,并通过pip安装PyQuery库。可以通过以下命令安装:

```python

pip install pyquery

```

安装完成后,可以进行一些简单的测试来验证PyQuery是否安装成功。以下是一个快速入门的代码示例:

```python

from pyquery import PyQuery as pq

html_content = """

<html>

<head>

<title>示例页面</title>

</head>

<body>

<p class="content">欢迎使用PyQuery</p>

</body>

</html>

doc = pq(html_content)

print(doc('p.content').text()) # 输出: 欢迎使用PyQuery

```

在实际项目中,您可能会从网页URL加载文档或从本地文件中读取内容。PyQuery提供了多种方法来创建对象实例,这些方法包括从HTML字符串、文件以及URL加载内容。本章的后续部分将详细介绍创建PyQuery对象的多种方式和选择器的应用。

# 2. PyQuery基础使用方法

## 2.1 PyQuery对象的创建和选择器

### 2.1.1 创建PyQuery对象的几种方式

PyQuery 是基于 jQuery 的 Python 库,它允许用户以类似 jQuery 的方式操作和解析 HTML 和 XML 文档。要开始使用 PyQuery,首先需要学会如何创建 PyQuery 对象。以下是几种常用的创建 PyQuery 对象的方法:

- **从HTML字符串创建:**

```python

from pyquery import PyQuery as pq

html_str = '<div><p class="hello">Hello, PyQuery!</p></div>'

d = pq(html_str)

print(d('p.hello').text())

```

在这段代码中,我们导入了 PyQuery 并从一个 HTML 字符串创建了一个 PyQuery 对象 `d`。使用选择器 `('p.hello')` 找到类名为 `hello` 的段落元素,并提取其文本内容。

- **从本地文件创建:**

```python

from pyquery import PyQuery as pq

d = pq(filename='index.html')

print(d('h1').text())

```

此代码段展示了如何从本地文件创建 PyQuery 对象。通过指定文件名,PyQuery 加载了 HTML 文件,并允许我们使用选择器进行操作。

- **从URL加载内容:**

```python

from pyquery import PyQuery as pq

import requests

url = '***'

response = requests.get(url)

d = pq(response.text)

print(d('title').text())

```

在这个例子中,我们首先使用 `requests` 库从指定的 URL 加载 HTML 内容,然后将响应内容传递给 PyQuery 来创建对象。之后,使用选择器来获取页面标题的文本。

### 2.1.2 CSS和XPath选择器的应用

PyQuery 支持 CSS 和 XPath 两种选择器,这使得它非常灵活。以下是两种选择器的应用示例:

- **CSS选择器:**

```python

from pyquery import PyQuery as pq

html_str = '''

<div id="container">

<p class="active">Active paragraph</p>

<p class="inactive">Inactive paragraph</p>

</div>

d = pq(html_str)

for paragraph in d('p.active, p.inactive'):

print(paragraph.text)

```

这里使用了 CSS 类选择器 `p.active, p.inactive` 来选取具有 `active` 或 `inactive` 类的段落,并打印它们的文本内容。

- **XPath选择器:**

```python

from pyquery import PyQuery as pq

html_str = '''

<div id="container">

<p class="first">First paragraph</p>

<p class="second">Second paragraph</p>

</div>

d = pq(html_str)

for paragraph in d('descendant-or-self::div[@id="container"]//p'):

print(paragraph.text)

```

在上述代码中,使用了 XPath 表达式来选取 ID 为 `container` 的 div 元素内的所有段落元素(`p`),并打印它们的文本内容。

通过这些例子,我们可以看到 PyQuery 的灵活性和强大功能,能够方便地从不同来源创建对象,并利用 CSS 和 XPath 选择器进行元素的定位和操作。

# 3. PyQuery在网页数据提取中的应用

## 3.1 表格数据的提取

### 3.1.1 单表数据的提取方法

在进行网页数据提取时,表格数据的抓取是一项常见且重要的工作。使用PyQuery进行表格数据提取非常直观和方便,下面介绍如何提取单表中的数据。

首先,使用PyQuery加载含有表格的网页,然后通过CSS选择器定位到表格元素。通常,表格会被`<table>`标签包裹。一旦定位到表格,可以进一步通过行(`<tr>`)和单元格(`<td>`或`<th>`)的组合来提取需要的数据。

举个例子,假设我们有一个网页 `***` 包含如下表格结构:

```html

<table id="myTable">

<tr>

<th>姓名</th>

<th>年龄</th>

<th>职业</th>

</tr>

<tr>

<td>张三</td>

<td>28</td>

<td>工程师</td>

</tr>

<tr>

<td>李四</td>

<td>30</td>

<td>设计师</td>

</tr>

</table>

```

要使用PyQuery提取这个表格的数据,可以按照以下步骤:

1. 导入PyQuery库。

2. 加载网页内容。

3. 选择表格元素。

4. 遍历表格中的每一行,提取每行中的单元格数据。

```python

from pyquery import PyQuery as pq

# 假设已经通过某种方式获取了网页内容到变量html中

html = '''

<!DOCTYPE html>

<html>

<head><title>示例网页</title></head>

<body>

<table id="myTable">

<tr>

<th>姓名</th>

<th>年龄</th>

<th>职业</th>

</tr>

<tr>

<td>张三</td>

<td>28</td>

<td>工程师</td>

</tr>

<tr>

<td>李四</td>

<td>30</td>

<td>设计师</td>

</tr>

</table>

</body>

</html>

doc = pq(html)

table = doc('#myTable')

rows = table.find('tr')

for row in rows:

cells = row.find('td')

data = [cell.text for cell in cells]

print(data)

```

执行上述代码,将得到每行表格数据的列表。

### 3.1.2 多表数据合并提取

在实际应用中,往往需要从同一个网页上的多个表格中提取数据。PyQuery提供了多种选择器来方便地进行这种操作。例如,可以使用属性选择器或者类名选择器来分别定位到不同的表格,并提取它们的数据。

继续以之前的例子为基础,假设页面上还有另一个表格:

```html

<table id="anotherTable">

<tr>

<th>姓名</th>

<th>电话</th>

<th>邮箱</th>

</tr>

<tr>

<td>张三</td>

<td>123-456-7890</td>

<td>***</td>

</tr>

<tr>

<td>李四</td>

<td>234-567-8901</td>

<td>***</td>

</tr>

</table>

```

要同时提取这两个表格的数据,可以在遍历表格行的时候加上一个条件判断,或者分别对每个表格进行处理:

```python

tables = doc('#myTable, #anotherTable') # 使用CSS选择器同时定位到两个表格

for table in tables:

rows = table.find('tr')

for row in rows:

cells = row.find('td')

data = [cell.text for cell in cells]

print(data)

```

执行上述代码会打印出两个表格的所有数据。

## 3.2 动态内容和异步请求处理

### 3.2.1 使用PyQuery处理Ajax加载的数据

Web2.0时代,越来越多的网站内容是通过JavaScript动态加载的。PyQuery本身不提供执行JavaScript的能力,但如果使用它结合selenium或requests-html这类可以执行JavaScript的工具,你依然可以处理动态内容。

例如,当使用requests-html获取网页内容时,可以通过设置浏览器上下文来执行JavaScript:

```python

from requests_html import HTMLSession

session = HTMLSession()

r = session.get('***')

# 确保所有的JavaScript都已执行完毕

r.html.render()

doc = pq(r.html.html)

# 之后的提取步骤与普通网页数据提取相同

```

### 3.2.2 针对动态网页的解析策略

动态网页的解析通常需要采取不同的策略。一种是直接使用支持JavaScript执行的工具获取动态生成的数据源,如Ajax请求的响应。另一种策略是分析页面请求,找到动态内容加载的API接口,然后直接请求这些接口获取数据。

例如,通过浏览器的开发者工具,我们可能发现一个API端点返回了某个动态加载的数据:

```json

{

"name": "张三",

"age": 28,

"job": "工程师"

}

```

这时可以直接使用requests库请求这个API接口:

```python

import requests

url = '***'

response = requests.get(url)

data = response.json()

# 使用数据

print(data)

```

## 3.3 处理网页数据时的常见问题及解决方案

### 3.3.1 网页结构变化应对策略

网页结构的变化是数据提取过程中经常遇到的问题。一个好的实践是编写尽可能通用的代码,避免依赖于网页的特定结构。使用类选择器、属性选择器而不是ID选择器,因为它们对结构变化的容忍度更高。

同时,可以设计异常捕获机制来在数据提取失败时进行处理,例如重试请求或者回退到手动处理某些情况。

### 3.3.2 编码问题和字符处理

编码问题也是数据提取中经常遇到的问题。正确处理编码问题可以避免数据损坏或解析错误。在Python中,确保在读取文件或网络请求响应时正确指定了字符编码。

```python

response = requests.get(url)

data = response.content.decode('utf-8') # 默认情况下应使用utf-8编码

```

在处理文本数据时,注意某些字符可能无法直接显示,例如HTML中的特殊字符。可以使用HTML实体解码来处理这些字符:

```python

from html import unescape

escaped_data = '<span>张三</span>'

unescape_data = unescape(escaped_data)

print(unescape_data) # 输出: <span>张三</span>

```

# 3.4 小结

在本章节中,我们深入了解了PyQuery在网页数据提取中的实际应用,包括表格数据的提取、动态内容处理和编码问题处理等。通过实际的代码示例,我们展示了如何使用PyQuery来应对网页数据提取时的挑战,以及如何优化我们的提取策略来提高数据提取的准确性和鲁棒性。在下一章,我们将深入探索PyQuery数据提取的实战案例,从中将学会如何构建一个完整的数据提取项目,并学习到一些进阶的数据提取技巧。

# 4. ```markdown

# 第四章:PyQuery数据提取实战案例

## 4.1 数据爬取与清洗

### 4.1.1 网页数据抓取的基本流程

在进行数据爬取时,我们首先需要明确爬取的目标网页,以及我们想要提取的数据类型。这通常涉及到网页分析,以确定数据在HTML中的结构位置。通过PyQuery,我们可以快速地加载网页内容,并使用其强大的选择器来定位需要的数据。

以抓取一个网页中的新闻标题和链接为例,下面是用PyQuery实现网页数据抓取的基本流程:

```python

from pyquery import PyQuery as pq

# 加载网页内容

url = '***'

doc = pq(url)

# 使用选择器提取新闻标题和链接

news_list = []

for news in doc('ul.news_list li a.title'):

news_list.append({

'title': news.text(),

'link': news.attr('href')

})

```

接下来,我们进行数据分析,确定出需要的数据类型、数据结构、以及数据在网页中的具体定位方式。

### 4.1.2 数据预处理与清洗技巧

提取的数据往往需要进行预处理和清洗,以去除无用信息,修正错误,和转换数据格式。在PyQuery中,我们通常利用Python的内置功能来处理这些任务。例如,可以使用正则表达式对字符串进行处理,用`strip()`方法去除首尾空白字符等。

```python

import re

# 对新闻标题进行预处理

cleaned_news_list = []

for news in news_list:

# 使用正则表达式去除HTML标签

clean_title = re.sub('<.*?>', '', news['title'])

# 去除标题末尾的额外空格

clean_title = clean_title.strip()

cleaned_news_list.append({

'title': clean_title,

'link': news['link']

})

```

通过预处理和清洗,我们可以确保数据的准确性和一致性,为后续的数据分析和使用打下良好的基础。

## 4.2 数据提取项目构建

### 4.2.1 构建一个简单的数据提取项目

构建数据提取项目通常需要考虑到项目的结构、代码组织、错误处理以及日志记录。一个简单的项目结构可以包括以下几个部分:

1. `extractor.py`: 负责数据提取的主要逻辑。

2. `cleaner.py`: 负责数据预处理和清洗。

3. `config.py`: 存放配置信息,例如请求头、超时设置等。

4. `main.py`: 项目的入口点,负责协调其他模块的工作。

5. `log.py`: 日志记录模块。

一个简单的提取函数可能如下所示:

```python

# extractor.py

def extract_data(url):

doc = pq(url)

# ...提取逻辑...

return extracted_data

```

### 4.2.2 项目中的错误处理和日志记录

在数据提取项目中,错误处理是非常重要的。它可以帮助我们了解在爬取过程中遇到的问题,并提供必要的信息来调试和解决问题。同时,日志记录可以让我们追踪爬虫的运行状态,便于监控和审计。

```python

# log.py

import logging

def setup_logging():

logging.basicConfig(filename='extractor.log', level=***,

format='%(asctime)s:%(levelname)s:%(message)s')

# 在 main.py 中配置和调用日志记录

from log import setup_logging

setup_logging()

def main():

try:

# ...爬取逻辑...

except Exception as e:

logging.exception("An error occurred while extracting data")

raise

```

通过合理配置错误处理和日志记录,可以有效提高项目的鲁棒性和可维护性。

## 4.3 数据提取进阶技巧

### 4.3.1 提取复杂结构的网页数据

面对结构复杂的网页,我们可能需要结合多个选择器,并利用PyQuery的DOM遍历功能来提取数据。有时,使用XPath选择器可以更加精确地定位复杂结构的数据。

例如,如果我们要从一个包含多个嵌套的`div`元素中提取信息,我们可能需要递归地遍历DOM树,并根据特定的层级关系来提取数据。

```python

# 使用XPath定位复杂的嵌套数据结构

def extract_complex_structure(doc):

# 假设我们需要提取特定层级的div元素中的内容

complex_data = []

for div in doc('div.layer1 div.layer2 div.layer3'):

complex_data.append({

'content': div.text(),

# ...其他提取逻辑...

})

return complex_data

```

### 4.3.2 大规模数据提取的性能优化

对于大规模的数据提取,性能是一个关键考量因素。为了优化性能,我们可以采取如下措施:

1. 使用`lxml`作为PyQuery的解析器,因为它比默认的解析器更快。

2. 对于重复的数据提取,使用缓存机制以减少网络请求和重复的计算。

3. 分布式爬取,通过多线程或异步IO来提高爬虫的并发能力。

```python

import requests

from pyquery import PyQuery as pq

from requests_cache import CachedSession

# 设置缓存

session = CachedSession(cache_name='http_cache', backend='sqlite')

def optimized_extraction(url):

response = session.get(url)

doc = pq(response.text, parser='lxml')

# ...提取逻辑...

return extracted_data

```

在这个例子中,我们使用了`requests-cache`库来缓存HTTP响应,减少对同一URL的重复请求。此外,通过指定解析器为`lxml`,可以加快数据解析的速度。

通过以上进阶技巧的应用,我们可以有效地提高数据提取的效率和质量。

```

# 5. PyQuery的高级功能与扩展

## 5.1 PyQuery与其他库的协同使用

### 5.1.1 Scrapy框架与PyQuery的整合

整合PyQuery与Scrapy框架可以帮助我们在爬虫项目中更加灵活地解析网页。Scrapy是一个强大的异步爬虫框架,它提供了很多高级功能如中间件、管道和信号处理等。当配合PyQuery使用时,可以简化数据提取的逻辑,提高开发效率。

下面是一个简单的例子,展示如何在Scrapy Item Pipeline中使用PyQuery:

```python

import scrapy

from scrapy.pipelines.images import ImagesPipeline

from scrapy.exceptions import DropItem

from itemloaders.processors import TakeFirst, MapCompose

from pyquery import PyQuery as pq

class MyItem(scrapy.Item):

# define the fields for your item here like:

# name = scrapy.Field()

pass

class MyImagesPipeline(ImagesPipeline):

def get_media_requests(self, item, info):

# 使用PyQuery获取图片链接

doc = pq(item['html_content'])

images = doc('img').items()

return [scrapy.Request(img.attr('src')) for img in images]

def item_completed(self, results, item, info):

# 对返回的数据进行处理

item['image_urls'] = [x['path'] for ok, x in results if ok]

return item

def file_path(self, request, response=None, info=None):

# 定义文件路径规则

return '%s.jpg' % request.url.split('/')[-1]

```

在上面的代码中,我们定义了一个`MyImagesPipeline`类,在这个类中,我们使用了PyQuery来解析从Scrapy Item中获取的HTML内容,并提取图片链接。然后,我们通过Scrapy的`ImagesPipeline`来下载这些图片。

### 5.1.2 Pandas库结合PyQuery进行数据分析

Pandas是一个强大的数据分析和操作库,当与PyQuery结合时,我们可以轻松地从复杂的HTML表格或列表中提取数据,并进一步进行分析。首先我们需要安装Pandas库。

```bash

pip install pandas

```

假设我们要从一个网页中提取表格数据,并使用Pandas进行分析,以下是实现流程的代码示例:

```python

import pandas as pd

from pyquery import PyQuery as pq

def get_pandas_dataframe(html):

# 解析HTML文档

doc = pq(html)

# 提取表格

table = doc('table').eq(0) # 假设我们关心第一个表格

# 初始化DataFrame

df = pd.DataFrame(columns=["Column1", "Column2", "Column3"])

# 遍历表格行

for row in table('tr'):

cells = row('td')

if len(cells) == 3: # 检查是否是数据行

df = df.append({

"Column1": cells.eq(0).text(),

"Column2": cells.eq(1).text(),

"Column3": cells.eq(2).text()

}, ignore_index=True)

return df

```

这段代码首先利用PyQuery解析HTML文档,然后定位第一个表格元素,并创建一个空的Pandas DataFrame。通过遍历表格中的每一行,提取出对应的单元格数据并添加到DataFrame中,最后返回填充好的DataFrame对象。

## 5.2 自定义插件与PyQuery的扩展

### 5.2.1 创建自定义PyQuery插件

PyQuery的扩展性很强,我们可以通过创建自定义插件来增强它的功能。插件通常是Python模块,可以通过添加新的方法来扩展PyQuery的功能。以下是如何创建一个简单的PyQuery插件的示例:

```python

from pyquery import PyQuery as pq

def custom_plugin(q, selector):

return q(selector).find('a').attr('href')

# 添加插件到PyQuery类

pq.plugins.custom_plugin = custom_plugin

# 使用自定义插件

doc = pq(html)

urls = doc('body').custom_plugin()

print(urls)

```

上面的`custom_plugin`函数通过接收一个PyQuery对象和一个选择器,返回页面中所有匹配该选择器的`<a>`标签的`href`属性值。我们通过将这个函数绑定到`pq.plugins`来创建一个插件,然后就可以像调用PyQuery内建方法一样使用它。

### 5.2.2 插件在数据提取中的应用实例

假设我们需要频繁地提取网页中所有的图片URL,我们可以创建一个专门用于这一功能的插件:

```python

def extract_image_urls(q):

return [img.attr('src') for img in q('img')]

# 添加插件

pq.plugins.extract_image_urls = extract_image_urls

# 使用插件提取图片URL

doc = pq(html)

image_urls = doc().extract_image_urls()

print(image_urls)

```

在这个插件中,我们定义了一个`extract_image_urls`函数,它接受一个PyQuery对象并返回一个包含所有图片`src`属性的列表。之后我们将这个函数添加为`pq`对象的方法,就可以轻松地在任何PyQuery对象上调用它来提取图片URL了。

## 5.3 PyQuery的未来发展趋势

### 5.3.1 社区动态和版本更新

***y自发布以来,就因简洁的API和强大的功能受到前端开发人员和数据提取从业者的喜爱。随着项目的不断更新,它引入了越来越多的改进,例如对新的CSS选择器的支持、性能的优化以及插件机制的完善。

用户可以通过参与社区讨论,加入邮件列表或者关注GitHub上的更新来了解最新的动态。这些渠道通常会提供最新的发布说明、已解决的Bug和即将进行的改进计划,帮助用户保持对PyQuery最新发展的了解。

### 5.3.2 探索PyQuery在前端开发中的潜在用途

虽然PyQuery主要是设计用于服务器端的网页解析和数据提取,但是它的轻量级和灵活性也为我们提供了在前端开发中应用的可能性。比如,我们可以利用PyQuery来实现前端的组件渲染,或者在构建工具中进行HTML内容的预处理。结合现代的前端框架和工具,PyQuery完全有可能成为前端开发中一个非常有用的工具。

例如,在Webpack的loader或Babel的插件中,我们可能会需要解析特定的模板语法或属性,而PyQuery提供的强大的CSS选择器正好可以派上用场。尽管这可能需要一些额外的工作来集成到构建流程中,但PyQuery的灵活性和易用性使得这样的尝试成为可能。随着Web开发技术的不断进步,PyQuery也许能够在未来扮演更加重要的角色。

请注意,本章内容仅为对PyQuery高级功能和未来应用的一个概述和展望,并未涉及具体代码实现,因此不存在总结性的内容。

0

0