R语言进阶:wordcloud包深度解析与高效文本分析策略

发布时间: 2024-11-10 11:02:07 阅读量: 6 订阅数: 11

# 1. R语言与文本分析基础

在当前数据驱动的环境下,掌握文本分析技术对于IT专业人士来说是一项重要技能。本章将向读者介绍文本分析的基本概念以及R语言在这一领域的应用。文本分析是利用计算机技术从文本数据中提取有价值信息和见解的过程。它包括了多个步骤,如数据清洗、分词、特征提取等。R语言作为一种功能强大的统计分析工具,在文本分析中占据了独特地位,尤其是它在处理、分析数据集和可视化输出方面的便捷性。

## 1.1 R语言简介

R语言是一种广泛用于数据分析和统计计算的开源编程语言。它因具有强大的包生态系统而闻名,使得各种分析任务变得简单高效。无论是简单的数据操作还是复杂的统计建模,R语言都能提供相应的工具和方法。R语言的这些特性使其成为进行文本分析的理想选择。

## 1.2 文本分析的重要性

文本分析在处理未结构化数据时显得尤为重要。通过分析社交媒体上的帖子、客户反馈、电子邮件、新闻文章等,企业可以获得宝贵的洞察力。这有助于了解公众情绪、市场趋势、消费者行为等关键业务信息,从而做出更有信息支持的决策。文本分析对于数据科学家来说,不仅能够挖掘数据的深层含义,而且还是展示数据洞察的重要手段。

本章为后续章节的学习打下基础,我们将会探讨如何利用R语言中的wordcloud包来创建和优化词云,从而进行有效的文本分析。在进入实际应用之前,了解R语言的基础和文本分析的重要性是至关重要的。接下来的章节将逐步介绍wordcloud包的安装、使用、高级特性和实战应用。

# 2. ```

# 第二章:wordcloud包的安装与配置

安装和配置`wordcloud`包是创建词云的第一步。在R语言环境中,包的安装和配置过程相对简单且标准化,但用户在安装时仍需注意细节,以确保安装的包能够正常工作。本章将详细介绍如何在R语言环境中安装`wordcloud`包,并进行基本的配置,以确保用户能够顺利进行后续的词云生成和定制化工作。

## 2.1 安装wordcloud包

### 2.1.1 通过CRAN安装

安装`wordcloud`包最常见的方式是通过R的官方包管理器CRAN进行安装。CRAN(The Comprehensive R Archive Network)是一个庞大的R包仓库,保证了大多数包的稳定性和可靠性。

安装`wordcloud`包的R代码如下:

```R

install.packages("wordcloud")

```

在执行上述代码后,R会自动从CRAN下载并安装`wordcloud`包及其依赖。用户无需手动管理依赖关系,因为R会自动处理。

### 2.1.2 从GitHub安装

对于希望使用最新功能或修复的用户,可以选择从GitHub直接安装`wordcloud`包的开发版本。GitHub上的版本可能包含最新特性,但同样也可能伴随一些尚未解决的问题。

首先,需要安装`devtools`包:

```R

install.packages("devtools")

```

然后使用`devtools`包提供的`install_github`函数来安装`wordcloud`包:

```R

devtools::install_github("brianwdavis/wordcloud")

```

上述命令中`brianwdavis/wordcloud`是`wordcloud`包在GitHub上的路径。安装开发版包时,可能会遇到一些不稳定因素,因此建议仅在了解这些风险的情况下使用此方法。

## 2.2 配置wordcloud包环境

安装完成后,用户需要加载`wordcloud`包才能使用其提供的功能。加载包的R代码如下:

```R

library(wordcloud)

```

上述代码将`wordcloud`包加载到当前的R会话中。如果用户在执行上述命令时遇到“找不到对象”的错误,通常意味着包没有正确安装,此时应返回第2.1节检查安装步骤。

此外,用户还可以检查`wordcloud`包的版本,确保其满足使用要求:

```R

packageVersion("wordcloud")

```

输出的版本信息应该与用户安装的版本一致。如果输出的版本信息不符合预期,用户可能需要重新安装包或检查是否有其他包的版本冲突。

### 2.2.1 设置图形设备

在生成词云之前,可能需要设置图形设备。R语言支持多种图形输出格式,如PDF、PNG、SVG等。使用`png()`, `pdf()`, `svg()`等函数可以开启相应的图形设备。

例如,设置生成PNG格式的图形设备,可以使用以下代码:

```R

png(file = "wordcloud.png")

# 在此处生成词云的代码

dev.off() # 关闭图形设备

```

在上述代码中,`file`参数指定了输出图形文件的名称和路径。此外,还可以通过其他参数对生成的图形文件进行自定义设置,如分辨率、图形尺寸等。

配置好图形设备后,用户便可以开始使用`wordcloud`包创建词云,并将结果输出到不同的格式文件中。下节我们将详细介绍如何创建基础词云。

```

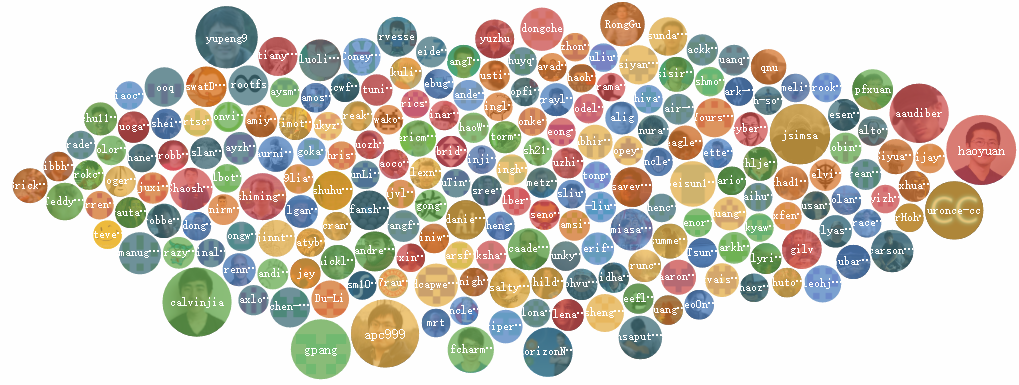

# 3. wordcloud包的基础使用

在第三章中,我们将探索R语言中`wordcloud`包的初步应用。这个包是文本分析中非常受欢迎的工具,它能够将文本数据可视化为词云。词云中,单词的大小和颜色的深浅可以表示单词出现的频率或其他指标。

## 3.1 创建基础词云

首先,我们将学习如何创建一个基础的词云。我们将从准备文本数据开始,然后学习生成词云的参数。

### 3.1.1 准备文本数据

在准备文本数据时,首先确保数据的格式适合进行词云分析。文本数据通常需要清洗和格式化,以去除无用的信息,并统一格式。

```r

# 安装并加载wordcloud包

install.packages("wordcloud")

library(wordcloud)

# 准备文本数据

text_data <- c(

"R语言是用于统计分析和图形表示的编程语言和软件环境。",

"wordcloud包可以创建词云,直观展示文本中单词的频率。",

"词云是一种有趣的数据可视化方法,可以快速识别文本中的关键词。",

"在本章节中,我们将逐步学习如何使用wordcloud包。",

"通过本章节的介绍,你将掌握创建和定制词云的技能。"

)

# 清洗和格式化文本

clean_text <- gsub("[[:punct:] ]+", " ", text_data) # 移除标点和多余的空格

clean_text <- tolower(clean_text) # 转换为小写

clean_text <- removeNumbers(clean_text) # 移除数字

clean_text <- removeWords(clean_text, stopwords("en")) # 移除常见的停用词

```

### 3.1.2 生成词云的基本参数

创建词云时,可以设置多个参数来控制词云的外观。一些基础参数包括`min.freq`、`max.words`、`random.order`等。

```r

# 生成词云

wordcloud(words = clean_text, min.freq = 1, max.words = 100, random.order = FALSE,

colors = c("darkred", "blue", "green"))

```

- `min.freq` 参数定义了单词在文本中出现的最小频率,低于这个频率的单词不会出现在词云中。

- `max.words` 参数定义了词云中最多出现的单词数量。

- `random.order` 参数决定了单词是否随机排列。`FALSE`表示按照频率降序排列。

## 3.2 词云的定制化设置

在基础词云创建之后,我们可以通过定制化设置来进一步美化我们的词云。我们将探讨形状与布局控制以及颜色方案与字体选择。

### 3.2.1 形状与布局控制

`wordcloud`包提供了`shape`参数,使得用户可以控制词云的形状。默认形状为圆形,但用户也可以选择其他形状,如`"oval"`、`"cardioid"`(心形)、`"diamond"`等。

```r

# 使用心形布局

wordcloud(words = clean_text, min.freq = 1, max.words = 100, random.order = FALSE,

colors = c("darkred", "blue", "green"), shape = "cardioid")

```

### 3.2.2 颜色方案与字体选择

颜色方案是决定词云视觉效果的关键因素之一。用户可以自行定义颜色向量,也可以使用`rainbow`、`heat.colors`等R语言内置颜色函数来生成颜色方案。

```r

# 使用内置颜色函数生成颜色方案

wordcloud(words = clean_text, min.freq = 1, max.words = 100, random.order = FALSE,

colors = heat.colors(10))

```

字体选择在词云展示中也非常重要,特别是当需要展示非英文内容时。`font`参数可以用来指定字体样式。

```r

# 设置字体为中文楷体

wordcloud(words = clean_text, min.freq = 1, max.words = 100, random.order = FALSE,

colors = c("darkred", "blue", "green"), font = 3)

```

在使用`wordcloud`包进行词云的创建时,我们已经了解了如何准备文本数据、生成基础的词云并对其进行了定制化设置。接下来的章节将进一步深入探讨`wordcloud`包的高级特性,包括词频加权、图形设备输出和词云的性能优化与故障排除。这些内容将帮助我们更好地理解如何利用`wordcloud`包进行文本分析,并将其应用到实际项目中。

# 4. wordcloud包的高级特性

## 4.1 词频加权与词云构建

### 4.1.1 词频权重的计算方法

在文本分析中,词频(Term Frequency,TF)是一个重要的概念,它指的是词在文档中出现的频率。通过对词频的分析,我们可以得到文档中哪些词是重要的,这些词的频率越高,通常意味着它们越重要。在生成词云时,词频常常被用作权重,以突出显示重要词汇。

然而,仅仅使用TF可能会导致常用词被过分强调,而忽略了那些在文档中不常见但在上下文中具有特别意义的词。为了解决这个问题,可以使用逆文档频率(Inverse Document Frequency,IDF)来进行调整。IDF是一种用于信息检索与文本挖掘的常用加权技术。词的IDF值越大,意味着它在语料库中越少见,因此应该被赋予更高的权重。

计算TF-IDF的过程如下:

1. 计算每个词的TF值,即每个词在当前文档中出现的频率。

2. 计算每个词的IDF值,即所有文档中包含该词的文档数量的倒数的对数。

3. 将TF值与IDF值相乘得到TF-IDF值,用作词在词云中的权重。

### 4.1.2 权重对词云的影响

在wordcloud包中,我们可以手动指定每个词的权重。权重越大,相应的词在词云中的字体尺寸也就越大。通过调整权重,我们可以精确地控制词云的展示效果,比如强调某些特定的词汇,或是平衡那些经常出现的词汇的显示大小,以便让读者更容易地识别出文本中的核心内容。

例如,在分析一组新闻文章时,我们可能希望“政治”和“经济”这样的通用词汇不要占据太大的词云空间,因为它们在每篇文章中都会频繁出现。相反,那些出现在特定文章中,频率较低但相关的词,如“政策”或“金融”,可能更能代表文章的主题。通过适当调整权重,词云就能反映出这种主题。

代码块展示如何在wordcloud函数中使用weight参数:

```r

# 示例代码块,计算词汇权重并生成词云

library(wordcloud)

# 假设已经加载了包含词汇及其频率的data.frame: terms_freq

# 以下是示例数据

terms_freq <- data.frame(word = c("data", "science", "cloud", "analysis", "term"),

freq = c(100, 80, 60, 40, 20))

# 计算TF-IDF权重

library(tidytext)

word_tfidf <- terms_freq %>%

bind_tf_idf(term = "word", document = NULL, n = "freq")

# 使用TF-IDF权重生成词云

set.seed(123)

wordcloud(words = word_tfidf$word,

freq = word_tfidf$tf_idf,

min.freq = 1,

max.words = 100,

random.order = FALSE,

rot.per = 0.35,

colors = brewer.pal(8, "Dark2"))

```

在这个示例中,我们首先计算了每个词的TF-IDF权重,然后在wordcloud函数中使用这个权重来生成词云。`random.order = FALSE`参数保证了权重较高的词会优先显示,而`rot.per`参数控制了词云中水平单词的比例。

## 4.2 图形设备与词云输出

### 4.2.1 输出到不同图形设备

在R语言中,我们可以将词云输出到多种图形设备中,例如保存为图片文件或者直接在RStudio的绘图窗口中展示。根据输出需要,可以选择不同的设备和格式。

以下是几种常用的图形设备及输出格式:

- PNG(便携式网络图形):适合在网页上使用,支持无损压缩。

- JPEG(联合照片专家组):适合在需要较小文件大小的场景,支持有损压缩。

- PDF(便携文档格式):适合文档打印,保持矢量图形质量。

- SVG(可缩放矢量图形):适合在网页上使用,可进行无损缩放。

以下示例展示如何将词云保存为PNG和PDF文件:

```r

# 生成词云并保存为PNG

png("wordcloud.png", width = 800, height = 600)

wordcloud(words = word_tfidf$word,

freq = word_tfidf$tf_idf,

min.freq = 1,

max.words = 100,

random.order = FALSE,

rot.per = 0.35,

colors = brewer.pal(8, "Dark2"))

dev.off() # 关闭图形设备

# 生成词云并保存为PDF

pdf("wordcloud.pdf", width = 8, height = 6)

wordcloud(words = word_tfidf$word,

freq = word_tfidf$tf_idf,

min.freq = 1,

max.words = 100,

random.order = FALSE,

rot.per = 0.35,

colors = brewer.pal(8, "Dark2"))

dev.off() # 关闭图形设备

```

### 4.2.2 词云的保存与分享

生成的词云可以被保存为文件,便于分享和进一步使用。上述代码展示了如何将词云保存为PNG和PDF格式。这些文件可以通过电子邮件、社交媒体或者网站等多种方式进行分享。

当需要在报告或者演示文档中引用词云时,保存为矢量图形格式(如PDF或SVG)是比较好的选择,因为这样可以在缩放时保持清晰度。

## 4.2.3 代码逻辑解读

- `png()`和`pdf()`函数分别启动了PNG和PDF格式的图形设备,并设置了图形输出的尺寸。

- `wordcloud()`函数绘制词云,并将结果显示在刚刚打开的图形设备上。

- `dev.off()`函数关闭图形设备,完成图形输出。

这些步骤是生成词云,并将其保存为不同格式文件的典型流程。对于熟悉R语言图形输出的读者来说,这是一个标准的操作流程,而对于初学者来说,这是掌握R语言文本分析可视化输出的重要步骤。

# 5. wordcloud包与文本分析实战

## 5.1 文本数据预处理

### 5.1.1 清洗与格式化文本数据

在进行文本分析之前,数据预处理是至关重要的一步。文本数据往往夹杂着许多不需要的字符,如标点符号、特殊字符和多余的空白字符。这些不需要的字符会干扰分析的准确性,因此,我们需要对原始文本数据进行清洗和格式化。

```r

# 加载必要的包

library(tm)

# 读取文本数据

text_data <- readLines("path/to/your/textfile.txt")

# 创建一个corpus

corpus <- Corpus(VectorSource(text_data))

# 文本预处理

corpus <- tm_map(corpus, content_transformer(tolower))

corpus <- tm_map(corpus, removePunctuation)

corpus <- tm_map(corpus, removeNumbers)

corpus <- tm_map(corpus, removeWords, stopwords("en"))

corpus <- tm_map(corpus, stripWhitespace)

# 查看清洗后的文本

inspect(corpus[1:3])

```

在上述代码中,我们首先使用`tm`包来创建一个文本语料库(corpus)。接着,利用`tm_map`函数结合内容转换器`content_transformer`对文本进行了小写转换,移除了标点符号、数字,并剔除了英语停用词。最后,我们使用`stripWhitespace`函数清理了多余的空白字符。预处理完成后的文本数据更干净、更适合分析。

### 5.1.2 文本分词与标记化

文本分词是将一段连续的文本分割成有意义的单位(如单词、词组等)的过程。在R中,分词通常是与文本预处理一起进行的。标记化是将文本转换成标记(tokens)的过程,这些标记可以是单词、短语或者其他有意义的文本单位。以下是如何使用R进行文本分词和标记化的一个例子:

```r

# 分词与标记化

corpus <- tm_map(corpus, content_transformer(wordcloud), minWordLength=4)

# 查看标记化后的文本

inspect(corpus[1:3])

```

在这里,我们对文本语料库应用了`content_transformer`函数,结合`wordcloud`函数将文本拆分为长度大于或等于4个字符的单词。这是一个简化的例子,实际操作中可能需要更复杂的分词规则。这些预处理步骤对于生成高质量的词云至关重要,因为它们直接影响到词云中显示的词汇和最终的可视化效果。

## 5.2 文本主题可视化分析

### 5.2.1 主题模型与词云的关系

在文本分析中,主题模型是一种统计模型,用于从文档集合中发现抽象的主题信息。一个主题可以被看作是词频的分布,每个主题都有一组相关的词汇。主题模型允许我们以更加结构化的方式理解和解释大量文本数据。

词云是一种可视化技术,可以直观地展示文档或文档集合中最常出现的词汇。通过调整词云中词汇的大小和颜色,我们可以在视觉上快速识别出文本中的关键词和主题。

结合主题模型和词云,我们不仅能够快速捕捉文本的主要内容,而且可以深入分析文本数据的多维度结构。一个典型的分析流程是首先使用主题模型提取文本的主要主题,然后使用词云将这些主题可视化展示。

### 5.2.2 实现主题词云的步骤与代码示例

接下来,我们将展示如何结合主题模型和词云来可视化文本数据的主题。在这个例子中,我们将使用`topicmodels`包来应用LDA(Latent Dirichlet Allocation)算法对文本进行主题建模,并使用`wordcloud`包来生成主题词云。

```r

# 加载topicmodels包

library(topicmodels)

# 假设我们已经完成了文本数据的预处理,并保存为corpus对象

# 我们接下来将corpus转换为一个document-term matrix

dtm <- DocumentTermMatrix(corpus)

# 应用LDA算法提取主题

# 假设我们想要提取5个主题

lda_model <- LDA(dtm, k = 5)

# 提取主题的词汇及其概率

terms <- terms(lda_model, topn = 10)

# 打印出每个主题的前10个词

for (i in seq_along(terms)) {

cat(sprintf("Topic %d:\n", i))

print(terms[i])

}

# 使用wordcloud包生成词云

# 首先我们需要从LDA模型中获取每个主题的词汇概率分布

tm <- posterior(lda_model)$terms

# 为词云的生成准备数据

m <- slam::row_sums(tm > 0)

tm <- tm[tm > 0]

topic <- rep(seq_len(nrow(tm)), times = m)

word <- rep(names(tm), m)

# 将数据转换为data.frame形式

wordcloud_df <- data.frame(word = word, topic = factor(topic))

# 生成词云

library(wordcloud)

library(ggplot2)

# 为了美观,我们可以为每个主题选择不同的颜色

cols <- RColorBrewer::brewer.pal(n = 5, name = "Set1")

ggplot(wordcloud_df, aes(label = word, size = tm, color = topic)) +

geom_text_wordcloud_area() +

scale_size_area(max_size = 24) +

scale_color_manual(values = cols) +

theme_minimal() +

facet_wrap(~ topic)

```

在这段代码中,我们首先使用`DocumentTermMatrix`函数将清洗后的文本语料库转换为文档-词项矩阵。然后,我们应用LDA算法来识别文本集合中的主题。`terms`函数被用来提取每个主题的词汇及其概率。为了生成词云,我们使用`posterior`函数来获取词项的概率分布,并准备相应的数据格式。最后,我们利用`ggplot2`和`geom_text_wordcloud_area`函数生成了多个主题的词云,并用不同的颜色来区分这些主题。

该词云可视化允许我们通过主题快速识别文本集合中的关键概念,并能有效地突出显示每个主题下的常用词汇。这种技术对于理解和分析大规模文本数据集特别有用。

# 6. wordcloud包的性能优化与故障排除

## 6.1 性能优化技巧

在使用`wordcloud`包进行大规模文本数据的词云生成时,性能往往会成为限制因素。为了提高效率,我们可以采取以下策略:

### 6.1.1 减少内存占用的策略

1. **数据压缩**:在内存中压缩数据可以显著降低内存消耗。在R中,可以使用`gzip`或者其他压缩函数处理文本数据。

2. **预处理数据**:在将数据输入`wordcloud`函数之前,尽量减少数据量,例如通过过滤掉低频词或无关词汇来减少数据集的大小。

3. **利用向量化操作**:尽可能使用向量化操作替代循环,减少中间变量的创建,这些都有助于减少内存占用。

### 6.1.2 提升生成词云速度的建议

1. **并行计算**:利用R的并行计算能力,分散任务到多个核心进行处理。

2. **调整分词函数**:选择效率更高的分词函数,一些专门的文本处理库如`jiebaR`在处理中文时效率更高。

3. **优化字体与布局**:减少图形元素的复杂度,使用更简单的字体和布局,这样可以减少渲染时间。

## 6.2 故障排除与常见问题解决

### 6.2.1 识别与诊断常见问题

1. **内存溢出**:当处理大量文本数据时,容易出现内存溢出。检查是否合理使用内存管理技巧,如果问题依旧存在,尝试增加系统内存或者使用更强大的机器。

2. **词云效果不佳**:这可能是由于参数设置不当导致的。通常需要调整词频的权重、词云的布局、颜色等参数。

3. **字体渲染问题**:某些字体可能不被图形设备支持,或者在特定平台上有兼容性问题。

### 6.2.2 针对性解决方案与建议

1. **内存溢出问题**:考虑优化数据预处理步骤,减少数据量。对于无法优化的情况,可以使用R的内存分析工具(如`tracemem`)来诊断内存问题,或者转向使用专门为大数据设计的编程语言和库。

2. **词云效果不佳**:针对词云效果不佳的问题,建议仔细调整`wordcloud`函数中的参数。例如,可以使用`scale`参数控制大小,`min.freq`设置词频阈值,`min.word.length`确定词的最小长度。

3. **字体渲染问题**:使用通用字体或者确保目标平台支持特定字体。可以使用`showtext`包来管理字体和渲染问题。

### 实际应用示例

以生成一个包含10000个词的词云为例,以下是一个简单的示例,展示如何优化内存使用和生成速度:

```R

library(wordcloud)

library(tm)

# 假设已经有一个包含10000个词的文本数据集text_data

# text_data <- ...

# 使用tm包进行文本预处理

corpus <- Corpus(VectorSource(text_data))

corpus <- tm_map(corpus, content_transformer(tolower))

corpus <- tm_map(corpus, removePunctuation)

corpus <- tm_map(corpus, removeNumbers)

corpus <- tm_map(corpus, removeWords, stopwords("english"))

corpus <- tm_map(corpus, stripWhitespace)

# 创建文档矩阵

tdm <- TermDocumentMatrix(corpus)

m <- as.matrix(tdm)

word_freqs <- sort(rowSums(m), decreasing = TRUE)

word_freqs <- data.frame(word = names(word_freqs), freq = word_freqs)

# 生成词云

wordcloud(words = word_freqs$word, freq = word_freqs$freq, min.freq = 1,

max.words = 100, random.order = FALSE, rot.per = 0.35,

colors = brewer.pal(8, "Dark2"))

```

以上代码首先对文本进行了预处理,然后生成了一个词频矩阵,并最终生成了一个词云。在这个过程中,我们可以通过修改`min.freq`和`max.words`参数来进一步优化内存使用和处理速度。

通过这样的优化,我们可以更有效地使用`wordcloud`包,避免遇到性能瓶颈和常见故障。

0

0