集成学习模型调优指南:提升模型性能的秘诀(必读)

发布时间: 2024-08-21 21:12:05 阅读量: 41 订阅数: 47

# 1. 集成学习模型概述**

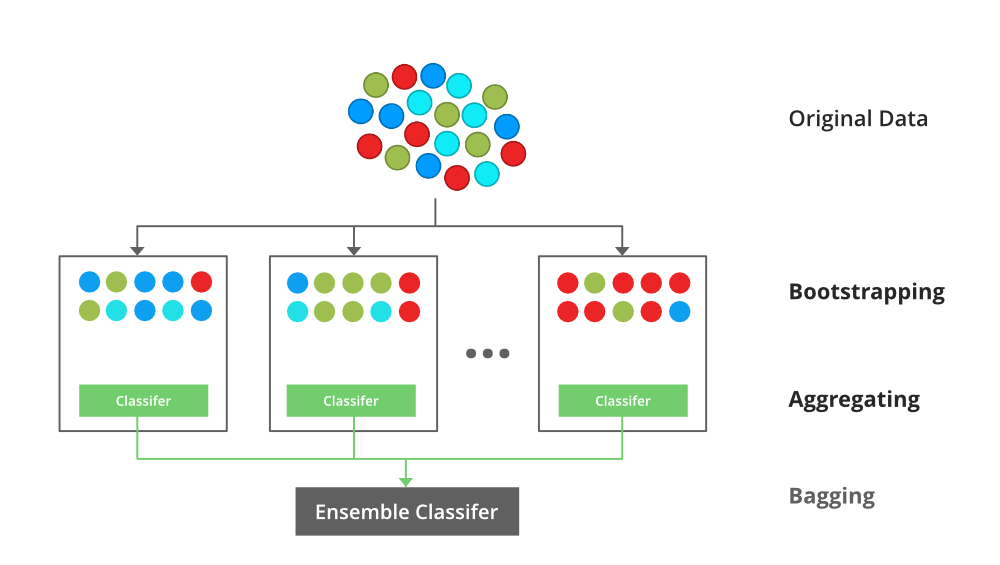

集成学习是一种机器学习技术,它通过组合多个较弱的学习模型来创建一个更强大的模型。集成学习模型的优势包括:

* **提高准确性:**集成学习模型通常比单个模型更准确,因为它们可以从多个模型的预测中学习。

* **减少过拟合:**集成学习模型可以帮助减少过拟合,因为它们可以从不同的角度对数据进行建模。

* **提高鲁棒性:**集成学习模型通常比单个模型更鲁棒,因为它们不太容易受到异常值或噪声数据的影响。

# 2. 集成学习模型调优理论

### 2.1 模型选择与评估

#### 模型评估指标

在集成学习模型调优中,选择合适的评估指标至关重要。常见的评估指标包括:

- **准确率(Accuracy):**预测正确的样本数量占总样本数量的比例。

- **召回率(Recall):**预测为正类的正样本数量占实际正样本数量的比例。

- **精确率(Precision):**预测为正类的样本中实际为正类的比例。

- **F1-Score:**召回率和精确率的加权调和平均值。

- **AUC(Area Under Curve):**ROC曲线下的面积,衡量模型区分正负样本的能力。

#### 模型选择策略

模型选择策略决定了集成学习模型中使用的基学习器类型。常见的模型选择策略有:

- **经验选择:**根据以往经验或领域知识选择基学习器。

- **交叉验证:**将数据集划分为训练集和验证集,在验证集上评估不同基学习器的性能,选择性能最佳的基学习器。

- **网格搜索:**在预定义的超参数空间中搜索最佳超参数组合,选择性能最佳的模型。

### 2.2 超参数调优

#### 超参数的类型和作用

超参数是集成学习模型训练过程中不直接从数据中学到的参数,它们对模型性能有显著影响。常见的超参数包括:

- **基学习器类型:**集成学习模型中使用的基学习器的类型。

- **基学习器数量:**集成学习模型中基学习器的数量。

- **学习率:**梯度下降算法中更新模型参数的步长。

- **最大深度:**决策树的最大深度。

- **最小样本分裂数:**决策树分裂节点所需的最小样本数量。

#### 超参数调优方法

超参数调优方法旨在找到最佳的超参数组合,以最大化模型性能。常见的超参数调优方法有:

- **网格搜索:**在预定义的超参数空间中搜索最佳超参数组合。

- **随机搜索:**在超参数空间中随机采样,并选择性能最佳的组合。

- **贝叶斯优化:**利用贝叶斯定理迭代更新超参数分布,并选择最优超参数组合。

**代码块:**

```python

# 网格搜索超参数调优示例

from sklearn.model_selection import GridSearchCV

from sklearn.ensemble import RandomForestClassifier

# 定义超参数空间

param_grid = {

'n_estimators': [10, 50, 100],

'max_depth': [2, 4, 6],

'min_samples_split': [2, 5, 10]

}

# 创建随机森林分类器

rfc = RandomForestClassifier()

# 进行网格搜索

grid_search = GridSearchCV(rfc, param_grid, cv=5)

grid_search.fit(X_train, y_train)

# 输出最佳超参数组合

print(grid_search.best_params_)

```

**逻辑分析:**

该代码块使用网格搜索方法对随机森林分类器进行超参数调优。它定义了超参数空间,包括决策树数量(n_estimators)、最大深度(max_depth)和最小样本分裂数(min_samples_split)。然后,它创建了一个随机森林分类器,并使用交叉验证(cv=5)进行网格搜索。最后,它输出最佳的超参数组合。

# 3. 集成学习模型调优实践

### 3.1 随机森林调优

#### 3.1.1 决策树参数调优

决策树是随机森林的基础,其参数调优至关重要。主要参数包括:

- **max_depth:**树的最大深度,控制树的复杂度。较深的树可能导致过拟合,而较浅的树可能欠拟合。

- **min_samples_split:**分裂内部节点所需的最小样本数。较高的值可防止过拟合,但可能导致欠拟合。

- **min_samples_leaf:**叶子节点所需的最小样本数。较高的值可防止过拟合,但可能导致欠拟合。

- **max_features:**每个节点分裂时考虑的特征数量。较高的值可提高模型的泛化能力,但可能降低准确性。

#### 3.1.2 随机森林参数调优

随机森林是决策树的集成,其参数调优包括:

- **n_estimators:**森林中决策树的数量。较多的树可提高准确性,但可能导致过拟合。

- **max_samples:**训练每个决策树时使用的样本比例。较高的值可提高模型的泛化能力,但可能降低准确性。

- **bootstrap:**是否使用放回抽样训练决策树。True表示使用放回抽样,False表示不使用。

- **oob_score:**是否使用袋外数据评估模型。True表示使用袋外数据,False表示不使用。

### 3.2 梯度提升机调优

#### 3.2.1 决策树参数调优

梯度提升机也使用决策树作为基学习器,因此其决策树参数调优与随机森林类似。

#### 3.2.2 梯度提升机参数调优

梯度提升机特有参数包括:

- **n_estimators:**与随机森林相同,表示森林中决策树的数量。

- **learning_rate:**步长,控制每个决策树对最终模型的影响。较高的值可提高模型的泛化能力,但可能降低准确性。

- **subsample:**训练每个决策树时使用的样本比例。较高的值可提高模型的泛化能力,但可能降低准确性。

- **max_depth:**与决策树相同,控制树的最大深度。

### 3.3 AdaBoost调优

#### 3.3.1 弱分类器选择

AdaBoost是一种集成学习算法,它使用一系列弱分类器来构建强分类器。弱分类器选择至关重要。

#### 3.3.2 AdaBoost参数调优

AdaBoost特有参数包括:

- **n_estimators:**与随机森林和梯度提升机相同,表示弱分类器的数量。

- **learning_rate:**与梯度提升机相同,控制每个弱分类器对最终模型的影响。

- **algorithm:**AdaBoost的算法类型,包括SAMME和SAMME.R。

# 4. 集成学习模型调优进阶

### 4.1 特征工程

特征工程是机器学习中至关重要的一步,它可以有效提升模型的性能。集成学习模型也不例外,通过对特征的精心设计和处理,我们可以进一步提高模型的预测能力。

**4.1.1 特征选择**

特征选择旨在从原始特征集中选择最具信息量和预测力的特征子集。常用的特征选择方法包括:

* **Filter Methods:**基于特征的统计属性进行选择,如方差、信息增益或卡方检验。

* **Wrapper Methods:**将特征选择过程嵌入到模型训练中,通过迭代地添加或删除特征来优化模型性能。

* **Embedded Methods:**在模型训练过程中同时进行特征选择,如 L1 正则化或树形模型中的特征重要性评分。

**4.1.2 特征变换**

特征变换可以将原始特征转换为更具可预测性的形式。常见的特征变换方法包括:

* **One-Hot Encoding:**将分类特征转换为二进制向量。

* **Log Transformation:**对非负特征进行对数变换,以减小特征分布的偏度。

* **Normalization:**将特征缩放或归一化到特定范围内,以提高模型的收敛速度和稳定性。

### 4.2 数据预处理

数据预处理是集成学习模型调优的另一个关键步骤。它可以去除数据中的噪声和异常值,并确保数据处于适合模型训练的格式。

**4.2.1 数据清洗**

数据清洗包括以下步骤:

* **Missing Value Imputation:**处理缺失值,如删除、插补或使用平均值填充。

* **Outlier Removal:**识别和去除异常值,以防止它们对模型产生负面影响。

* **Data Type Conversion:**将特征转换为适当的数据类型,如数字、分类或布尔值。

**4.2.2 数据归一化**

数据归一化可以将不同特征的取值范围缩放到一致的范围内。常用的归一化方法包括:

* **Min-Max Scaling:**将特征值映射到 [0, 1] 范围内。

* **Standard Scaling:**将特征值减去均值并除以标准差,使其具有均值为 0 和标准差为 1 的分布。

**代码示例:**

```python

# 导入必要的库

import pandas as pd

from sklearn.preprocessing import StandardScaler

# 加载数据

data = pd.read_csv('data.csv')

# 归一化数据

scaler = StandardScaler()

data_scaled = scaler.fit_transform(data)

```

# 5. 集成学习模型调优最佳实践

### 调优流程和注意事项

集成学习模型调优是一个迭代的过程,通常包括以下步骤:

1. **数据预处理:**清洗和归一化数据,以确保模型的稳定性和准确性。

2. **模型选择和评估:**选择合适的集成学习算法,并使用交叉验证或留出法评估模型性能。

3. **超参数调优:**优化算法的超参数,如决策树深度、学习率和正则化参数。

4. **特征工程:**选择和转换特征,以提高模型的预测能力。

5. **模型融合:**结合多个集成学习模型的预测,以获得更好的结果。

在调优过程中,需要注意以下事项:

* **避免过度拟合:**使用交叉验证或正则化技术来防止模型过度拟合训练数据。

* **选择合适的评估指标:**根据任务选择合适的评估指标,如准确率、召回率或 F1 分数。

* **使用调优工具:**利用自动调优工具(如 Optuna 或 Hyperopt)简化调优过程。

* **记录调优过程:**记录调优参数和结果,以便将来参考和改进。

### 调优工具和资源

以下是一些用于集成学习模型调优的工具和资源:

* **Optuna:**一个 Python 库,用于超参数调优和贝叶斯优化。

* **Hyperopt:**另一个 Python 库,用于超参数调优和树形帕累托优化。

* **scikit-learn:**一个 Python 库,提供各种集成学习算法和调优工具。

* **XGBoost:**一个用于梯度提升机的开源库,具有内置的调优功能。

* **LightGBM:**一个用于梯度提升机的轻量级库,具有高效的调优算法。

### 调优案例分享

**案例:**使用随机森林预测客户流失

**调优过程:**

1. 使用交叉验证选择决策树深度和随机森林中的树木数量。

2. 使用网格搜索调优决策树的最小样本分裂和最小叶子样本。

3. 使用特征重要性选择和删除不重要的特征。

4. 使用 AdaBoost 融合多个随机森林模型。

**结果:**

经过调优,随机森林模型的准确率提高了 5%,召回率提高了 3%。

0

0