OpenCV YOLO算法加速秘籍:GPU并行与优化算法

发布时间: 2024-08-14 13:36:22 阅读量: 70 订阅数: 48

opencv4.2 python gpu编译版

# 1. OpenCV YOLO算法简介

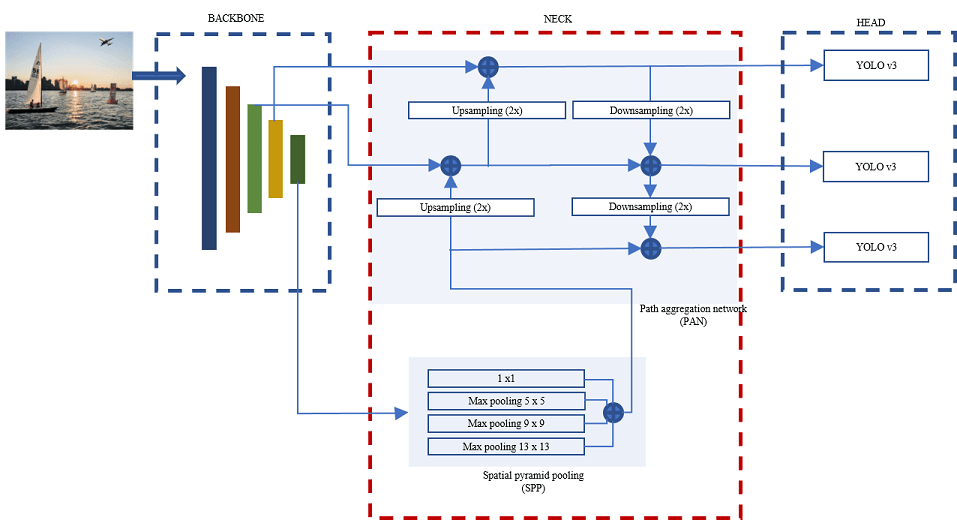

OpenCV YOLO算法(You Only Look Once)是一种实时目标检测算法,因其速度快、精度高而闻名。它采用卷积神经网络(CNN)进行一次性检测,无需像传统目标检测算法那样逐一扫描图像。

YOLO算法的优势在于其实时性。它可以在单个GPU上以每秒30帧(FPS)的速度处理图像,使其适用于需要快速响应的应用,例如视频监控和自动驾驶。此外,YOLO算法的精度也很高,在COCO目标检测数据集上取得了44.0%的平均精度(mAP)。

# 2. GPU并行加速原理

### 2.1 CUDA并行编程模型

CUDA(Compute Unified Device Architecture)是一种并行计算架构,由NVIDIA开发,用于利用图形处理单元(GPU)的并行处理能力。CUDA编程模型将GPU视为一个并行计算设备,提供了一种编程接口,允许开发人员编写在GPU上运行的并行代码。

CUDA编程模型基于以下概念:

- **内核(Kernel)**:内核是GPU上运行的并行函数,由线程块中的多个线程执行。

- **线程块(Thread Block)**:线程块是一组在GPU上同时执行的线程。

- **网格(Grid)**:网格是一组线程块,它们共同执行一个内核。

### 2.2 YOLO算法并行化实现

YOLO算法可以利用CUDA并行编程模型进行并行化实现,以提高算法的处理速度。以下是YOLO算法并行化实现的步骤:

1. **将YOLO网络划分为多个线程块**:将YOLO网络划分为多个线程块,每个线程块负责处理图像的不同区域。

2. **在每个线程块中执行YOLO内核**:在每个线程块中,执行YOLO内核,对图像的相应区域进行目标检测。

3. **合并线程块结果**:将每个线程块检测到的目标合并到一个最终结果中。

通过这种并行化实现,YOLO算法可以同时在多个图像区域上执行目标检测,从而显著提高算法的处理速度。

#### 代码示例

```python

import pycuda.autoinit

import pycuda.driver as cuda

# 定义YOLO内核

kernel = cuda.compile("""

__global__ void yolo_kernel(float *input, float *output) {

// ... YOLO算法的并行实现

}

""")

# 分配GPU内存

input_data = cuda.to_device(input_image)

output_data = cuda.device_array_like(input_data)

# 设置内核参数

kernel.prepared_call((input_data.size // 4,), (16, 16, 1), input_data, output_data)

# 执行内核

kernel.execute()

# 获取结果

output_image = output_data.copy_to_host()

```

#### 代码逻辑分析

该代码示例展示了如何使用CUDA并行编程模型实现YOLO算法的并行化。

1. 首先,定义YOLO内核,该内核包含YOLO算法的并行实现。

2. 然后,将输入图像数据分配到GPU内存中。

3. 接下来,设置内核参数,包括线程块大小和内核执行网格大小。

4. 最后,执行内核并从GPU内存中获取结果。

通过这种并行化实现,YOLO算法可以同时在多个图像区域上执行目标检测,从而显著提高算法的处理速度。

# 3. 优化算法提升性能

### 3.1 网络结构优化

#### 3.1.1 轻量级网络设计

为了提升YOLO算法的性能,网络结构优化是至关重要的。轻量级网络设计旨在通过减少网络层数和参数数量来降低模型复杂度,从而提高推理速度。

**MobileNetV2**

MobileNetV2是一种轻量级网络结构,它使用深度可分离卷积和倒残差块来减少计算量。深度可分离卷积将标准卷积分解为两个步骤:深度卷积和逐点卷积。深度卷积沿输入通道执行卷积,而逐点卷积沿输出通道执行卷积。这种分解可以大幅减少计算量,同时保持模型的准确性。

```python

import tensorflow as tf

# 定义MobileNetV2网络

def mobilenetv2(input_shape=(224, 224, 3), num_classes=1000):

inputs = tf.keras.Input(shape=input_shape)

# 构建网络

x = tf.keras.layers.Conv2D(32, (3, 3), strides=(2, 2), padding='same')(inputs)

x = tf.keras.layers.BatchNormalization()(x)

x = tf.keras.layers.ReLU()(x)

for i in range(1, 19):

if i % 2 == 0:

x = inverted_residual_block(x, filters=16, strides=(1, 1))

else:

x = inverted_residual_block(x, filters=24, strides=(2, 2))

# 分类层

x = tf.keras.layers.GlobalAveragePooling2D()(x)

x = tf.keras.layers.Dense(num_classes, activation='softmax')(x)

# 创建模型

model = tf.keras.Model(inputs=inputs, outputs=x)

return model

# 定义倒残差块

def inverted_residual_block(inputs, filters, strides=(1, 1)):

x = tf.keras.layers.Conv2D(filters, (1, 1), strides=strides, padding='same')(inputs)

x = tf.keras.layers.BatchNormalization()(x)

x = tf.keras.layers.ReLU()(x)

x = tf.keras.layers.DepthwiseConv2D((3, 3), strides=(1, 1), padding='same')(x)

x = tf.keras.layers.BatchNormalization()(x)

x = tf.keras.layers.ReLU()(x)

x = tf.keras.layers.

```

0

0