MySQL数据库高可用架构设计:保障业务连续性,让数据库永不宕机

发布时间: 2024-07-24 15:48:48 阅读量: 30 订阅数: 36

# 1. MySQL数据库高可用架构概述**

MySQL数据库高可用架构是指通过冗余、故障转移和灾难恢复等技术,确保数据库系统在发生故障或灾难时仍然能够正常运行,保证数据的可用性、完整性和一致性。

高可用架构的构建需要考虑以下原则:

* **冗余:**通过创建数据库的副本(例如主从复制),实现数据和服务的冗余,当主数据库发生故障时,可以快速切换到备用数据库继续提供服务。

* **故障转移:**当主数据库发生故障时,需要自动或手动触发故障转移,将服务切换到备用数据库,以最小化服务中断时间。

* **灾难恢复:**在发生自然灾害或其他严重事件时,需要能够从备份中恢复数据库,以确保数据的安全性和可用性。

# 2. MySQL高可用架构设计原则

### 2.1 冗余与故障转移

**冗余**是指在系统中创建多个组件的副本,以防止单点故障。在MySQL高可用架构中,冗余通常通过以下方式实现:

- **主从复制:**创建数据库主节点的多个副本(从节点)。主节点负责处理写入操作,而从节点负责处理读取操作。如果主节点发生故障,其中一个从节点可以被提升为主节点,继续提供服务。

- **异地多活:**在不同的地理位置部署多个数据库集群,每个集群都包含一个主节点和多个从节点。如果一个集群发生故障,其他集群可以继续提供服务。

**故障转移**是指在故障发生时将服务转移到冗余组件的过程。在MySQL高可用架构中,故障转移通常通过以下方式实现:

- **自动故障转移:**使用第三方工具或MySQL内置功能自动检测故障并触发故障转移。

- **手动故障转移:**由管理员手动执行故障转移过程。

### 2.2 可扩展性和弹性

**可扩展性**是指系统能够随着需求的增长而扩展的能力。在MySQL高可用架构中,可扩展性通常通过以下方式实现:

- **水平扩展:**通过添加更多节点来增加系统容量。

- **垂直扩展:**通过升级硬件或增加内存和CPU资源来提高单个节点的容量。

**弹性**是指系统能够在故障或负载高峰时继续提供服务的能力。在MySQL高可用架构中,弹性通常通过以下方式实现:

- **负载均衡:**将请求分布到多个节点,以避免单个节点过载。

- **自动故障恢复:**在故障发生后自动恢复服务,无需人工干预。

### 2.3 灾难恢复与数据保护

**灾难恢复**是指在发生灾难(如自然灾害或人为错误)时恢复系统和数据的能力。在MySQL高可用架构中,灾难恢复通常通过以下方式实现:

- **异地备份:**将数据备份到不同的地理位置,以防止数据丢失。

- **灾难恢复计划:**制定详细的计划,概述在灾难发生时恢复系统的步骤。

**数据保护**是指保护数据免受未经授权的访问、修改或破坏的能力。在MySQL高可用架构中,数据保护通常通过以下方式实现:

- **数据加密:**使用加密算法对数据进行加密,以防止未经授权的访问。

- **权限管理:**限制对数据库和数据的访问权限,以防止未经授权的修改或破坏。

# 3.1 主从复制

### 3.1.1 主从复制的原理和配置

**原理**

主从复制是一种将数据从一台数据库服务器(主服务器)复制到另一台或多台数据库服务器(从服务器)的技术。它通过在主服务器上记录所有数据更改(称为二进制日志),然后将这些更改传输到从服务器并应用它们来实现。

**配置**

配置主从复制需要在主服务器和从服务器上进行以下步骤:

**主服务器:**

- 启用二进制日志记录:`binlog-do-db=db1,db2`(指定要复制的数据库)

- 创建复制用户:`CREATE USER 'repl'@'%' IDENTIFIED BY 'password'`(用于从服务器连接主服务器)

**从服务器:**

- 停止从服务器

- 连接到主服务器:`mysql -h master-host -u repl -p password`

- 执行以下命令:

- `CHANGE MASTER TO MASTER_HOST='master-host', MASTER_USER='repl', MASTER_PASSWORD='password', MASTER_LOG_FILE='binlog.000001', MASTER_LOG_POS=4`(指定主服务器信息和要复制的二进制日志位置)

- 启动从服务器

### 3.1.2 主从复制的监控和管理

**监控**

监控主从复制的健康状况至关重要,可以确保数据的一致性和可用性。以下是一些关键指标:

- **IO线程状态:**`SHOW SLAVE STATUS\G`,检查`Slave_IO_Running`和`Slave_SQL_Running`是否为`Yes`

- **SQL线程状态:**`SHOW SLAVE STATUS\G`,检查`Last_IO_Error`和`Last_SQL_Error`是否为空

- **延迟:**`SHOW SLAVE STATUS\G`,检查`Seconds_Behind_Master`的值,以了解从服务器与主服务器之间的延迟

**管理**

管理主从复制涉及以下任务:

- **故障转移:**如果主服务器发生故障,需要将其中一台从服务器提升为主服务器

- **重新同步:**如果从服务器与主服务器失去同步,需要执行`RESET SLAVE`命令重新同步

- **监控和告警:**设置监控系统来监视主从复制的状态并触发告警

# 4. MySQL高可用架构优化

### 4.1 性能优化

#### 4.1.1 硬件优化

**选择高性能硬件**

* 选择具有多核CPU、大内存和快速存储(如SSD)的服务器。

* 考虑使用NVMe SSD,它比传统SSD提供更高的读写速度。

* 对于高并发场景,可以考虑使用多台服务器进行负载均衡。

**优化存储配置**

* 对于主从复制架构,将数据文件和日志文件放在不同的磁盘上,以减少IO争用。

* 使用RAID 10或RAID 5等RAID级别来提高存储性能和冗余性。

* 启用文件系统缓存,如InnoDB文件格式的innodb_buffer_pool_size参数。

#### 4.1.2 软件优化

**优化数据库参数**

* 根据业务场景调整innodb_buffer_pool_size、innodb_log_file_size等参数,以优化缓存和日志性能。

* 启用innodb_flush_log_at_trx_commit=2,以提高写入性能,但会降低数据安全性。

* 启用innodb_flush_method=O_DIRECT,以绕过文件系统缓存,直接将数据写入磁盘。

**使用索引**

* 创建适当的索引以加速查询。

* 使用覆盖索引,只从索引中读取数据,避免回表。

* 避免使用过多的索引,因为它们会增加更新成本。

**优化查询**

* 使用EXPLAIN命令分析查询计划,找出性能瓶颈。

* 重写复杂查询,使其更简单、更高效。

* 使用批处理操作,一次执行多个查询,减少网络开销。

### 4.2 安全优化

#### 4.2.1 数据加密和权限管理

**数据加密**

* 使用SSL/TLS加密客户端和服务器之间的连接。

* 使用AES-256等算法加密数据库中的敏感数据。

* 定期轮换加密密钥,以提高安全性。

**权限管理**

* 遵循最小权限原则,只授予用户必要的权限。

* 使用角色和组来管理权限,简化管理。

* 定期审核权限,撤销不再需要的权限。

#### 4.2.2 安全审计和入侵检测

**安全审计**

* 启用MySQL审计插件,记录数据库操作。

* 定期审查审计日志,查找可疑活动。

* 使用安全信息和事件管理(SIEM)系统收集和分析审计数据。

**入侵检测**

* 使用入侵检测系统(IDS)监控数据库流量,检测异常活动。

* 设置告警规则,在检测到可疑活动时触发警报。

* 定期更新IDS规则,以跟上最新的威胁。

# 5. MySQL高可用架构案例分析

### 5.1 电商平台的MySQL高可用架构

#### 5.1.1 业务场景

电商平台业务特点:

- **高并发访问:**秒杀、双十一等活动期间,数据库面临海量并发访问。

- **大数据量:**商品、订单、用户等数据量庞大,对数据库存储和查询能力要求高。

- **高可用性:**业务中断会造成巨大损失,要求数据库系统具备极高的可用性。

#### 5.1.2 架构设计

电商平台采用主从复制+读写分离的高可用架构:

- **主库:**负责写入操作,保证数据一致性。

- **从库:**负责读操作,分担主库压力。

- **读写分离:**通过中间件或代理工具,将读写请求分别路由到主库和从库。

#### 5.1.3 优化措施

- **主从复制优化:**使用半同步复制,提高数据复制速度和可靠性。

- **读写分离优化:**根据读写比例动态调整读写流量,优化数据库负载均衡。

- **性能优化:**使用索引、分区表等技术优化查询性能,减少数据库响应时间。

### 5.2 金融机构的MySQL高可用架构

#### 5.2.1 业务场景

金融机构业务特点:

- **高安全性:**金融数据敏感,对数据库安全要求极高。

- **高可靠性:**交易系统不能中断,要求数据库系统具备极高的可靠性。

- **高并发访问:**高峰期交易量巨大,数据库面临高并发访问压力。

#### 5.2.2 架构设计

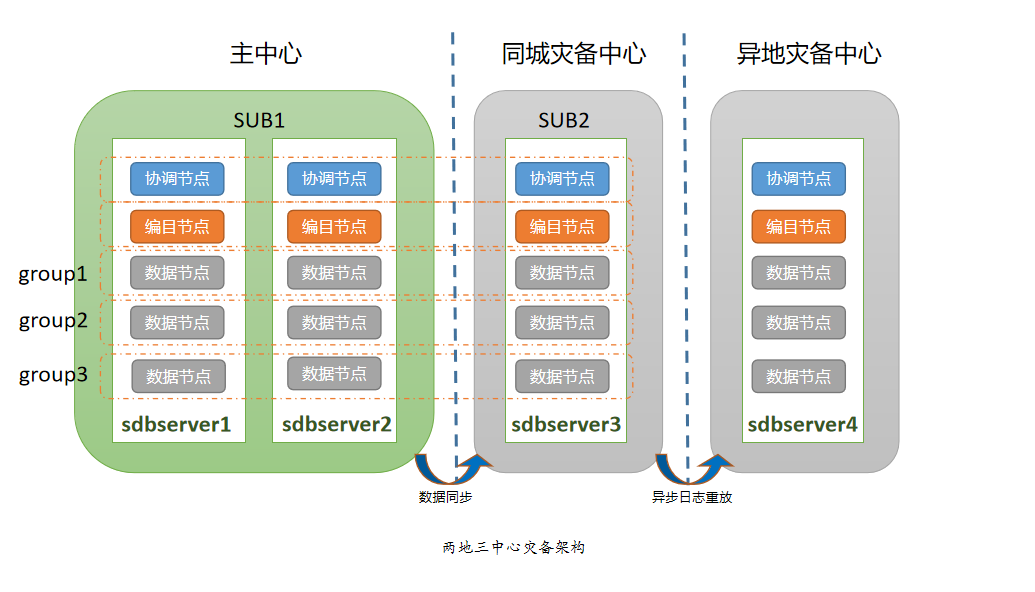

金融机构采用异地多活的高可用架构:

- **主库:**位于主数据中心,负责写入操作。

- **从库:**位于异地数据中心,负责读操作和故障转移。

- **仲裁节点:**位于第三个数据中心,负责协调主从切换。

#### 5.2.3 优化措施

- **异地多活优化:**使用数据复制技术,实现主从数据同步,保证数据一致性。

- **安全优化:**采用数据加密、权限管理、安全审计等措施,保障数据库安全。

- **故障转移优化:**使用自动故障转移机制,快速切换主从,保证业务连续性。

# 6. MySQL高可用架构未来趋势**

**6.1 云原生MySQL**

云原生MySQL是指在云计算环境中部署和运行的MySQL数据库。它利用了云计算的优势,例如弹性、可扩展性和按需付费,为MySQL数据库提供了更高的可用性、可靠性和成本效益。

**6.1.1 云原生MySQL的优势**

* **弹性:**云原生MySQL可以根据需求自动扩展或缩减,以满足不断变化的工作负载。

* **可扩展性:**云原生MySQL可以轻松地横向扩展,以处理大量数据和并发请求。

* **按需付费:**云原生MySQL通常采用按需付费模式,用户仅为实际使用的资源付费。

* **管理简化:**云原生MySQL由云服务提供商管理,这简化了数据库管理任务,例如备份、恢复和监控。

**6.1.2 云原生MySQL的实现**

云原生MySQL可以通过多种方式实现,包括:

* **托管服务:**云服务提供商提供托管的MySQL服务,用户无需管理基础设施或软件。

* **容器化部署:**MySQL可以在容器中部署,并使用Kubernetes等编排工具进行管理。

* **无服务器:**无服务器MySQL服务允许用户运行MySQL而无需管理服务器或基础设施。

**6.2 分布式数据库**

分布式数据库是一种数据库系统,其数据分布在多个服务器或节点上。它提供了更高的可用性、可扩展性和性能,非常适合处理大规模数据和复杂的工作负载。

**6.2.1 分布式数据库的类型**

分布式数据库有以下几种主要类型:

* **键值存储:**键值存储将数据存储在键值对中,并提供快速和高效的查询。

* **文档数据库:**文档数据库将数据存储在文档中,并支持灵活的模式和查询。

* **关系数据库:**关系数据库将数据存储在表中,并支持传统的SQL查询。

**6.2.2 分布式数据库的优势**

* **高可用性:**分布式数据库通过将数据复制到多个节点来提供高可用性,即使一个节点发生故障,数据仍然可用。

* **可扩展性:**分布式数据库可以轻松地横向扩展,以处理不断增长的数据量和并发请求。

* **性能:**分布式数据库通过并行处理查询和数据分片来提高性能。

0

0