立体视觉里程计仿真高级技巧:性能优化与误差分析

发布时间: 2024-11-13 19:24:21 阅读量: 36 订阅数: 39

视觉SLAM中的前端:视觉里程计与回环检测.zip

# 1. 立体视觉里程计仿真概述

在当今高度数字化的时代,智能系统对精确的自我位置定位技术有着迫切需求。立体视觉里程计仿真技术应运而生,它通过模拟真实世界中的视觉传感器获取数据,并利用先进的算法处理这些数据,以达到高精度的位置和路径估计。本章节将对立体视觉里程计仿真进行概述,为读者搭建初步的理解框架,并为后续章节深入探讨其工作原理、优化策略、误差分析和实践应用奠定基础。

在介绍立体视觉里程计仿真之前,我们首先需要了解视觉里程计(Visual Odometry)的基本概念。简而言之,视觉里程计是一种通过分析连续图像序列来推断相机运动的技术。而立体视觉里程计,顾名思义,是指使用两个或更多相机来获取深度信息,进而提高位置和运动估计的准确性。本章节将详细探讨立体视觉里程计仿真的概念、应用场景及其重要性。

# 2. 理论基础与关键技术

## 2.1 立体视觉里程计的工作原理

### 2.1.1 视觉里程计的定义和作用

视觉里程计(Visual Odometry,VO)是计算机视觉领域的一个重要分支,其目的是通过分析从摄像头获得的连续图像序列,计算相机自身的运动信息,包括位移和姿态变化。在机器人导航和自动驾驶汽车中,视觉里程计能够提供实时的运动估计,帮助系统建立地图,进行路径规划和避障。

视觉里程计与传统基于轮速的里程计相比,能够提供更加丰富和精确的环境信息,特别是在轮速信息不可靠或难以获取的环境中。例如,在户外场景或不平整地面,轮速传感器可能会因为打滑而产生错误的测量数据,而视觉里程计则不受此限制。

### 2.1.2 立体视觉系统的工作流程

立体视觉里程计通常依赖于一对或多对摄像头来捕获环境信息。工作流程大致可以分为以下步骤:

1. **图像采集**:使用同步的立体摄像头系统,同时采集左右摄像头的图像数据。

2. **图像预处理**:对捕获的图像进行滤波、去噪等预处理操作,以提高后续处理的准确性和鲁棒性。

3. **特征提取**:从预处理后的图像中提取具有代表性的特征点,如角点、边缘等。

4. **特征匹配**:寻找左右图像之间相同的特征点,建立起特征点的对应关系,即匹配。

5. **深度和位姿估计**:利用匹配点和立体校准参数,估计出匹配点的深度信息,进而推算相机运动的位姿变化。

6. **地图构建与运动优化**:基于位姿估计,构建环境地图,并对之前的运动估计进行优化,减少误差积累。

## 2.2 相关数学模型和算法

### 2.2.1 摄像机成像模型

摄像机成像模型是理解立体视觉里程计工作的核心之一。在理想情况下,可以使用针孔摄像机模型来描述现实世界中的三维点与图像平面上的二维点之间的映射关系。该模型基于以下几个假设:

- 摄像机的投影中心和成像平面之间是平行的。

- 成像平面无限薄,所有光线都会通过投影中心投影到成像平面上。

- 成像平面与投影中心之间的距离是固定的。

在数学表达式中,摄像机成像模型可以表示为:

\[ x = f \frac{X}{Z} \]

\[ y = f \frac{Y}{Z} \]

其中,\( (X, Y, Z) \) 表示三维空间中的点坐标,\( (x, y) \) 表示成像平面上对应的二维点坐标,\( f \) 是摄像机的焦距。

### 2.2.2 特征匹配算法

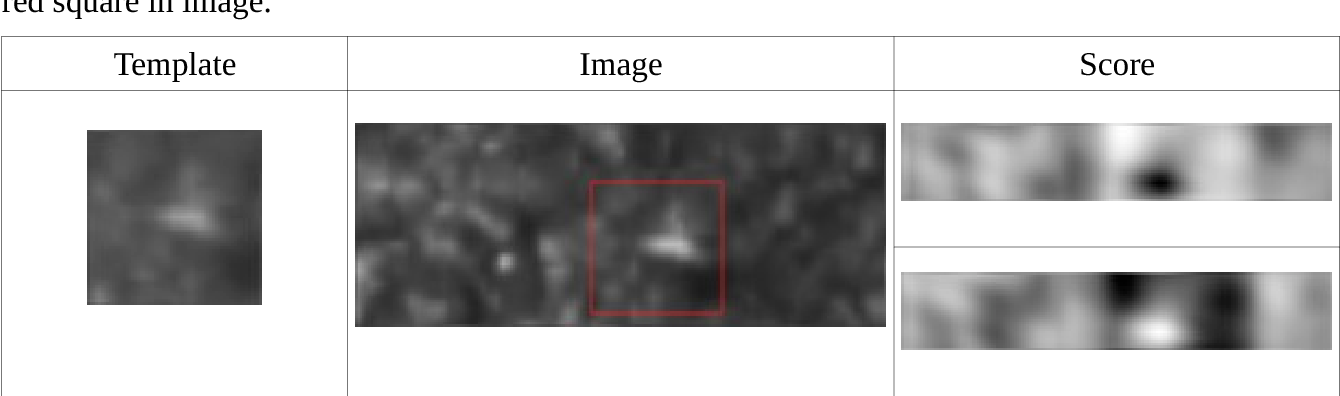

特征匹配是立体视觉里程计中的一个关键步骤,其目的是在左右相机拍摄的图像之间找到相同的特征点。这通常通过描述子匹配来完成,描述子是表征图像中特征点局部区域的一种特征向量。

**SIFT (Scale-Invariant Feature Transform)** 是一种广泛使用的特征匹配算法。它通过以下步骤来提取和匹配特征点:

- 尺度空间极值检测,定位特征点位置。

- 确定特征点的主方向。

- 计算特征点的描述子向量。

SIFT的描述子具有旋转、尺度、亮度变化的不变性,使得在不同图像中的相同特征点能够被准确匹配。

### 2.2.3 位姿估计方法

立体视觉里程计的位姿估计指的是根据匹配点对的深度信息,计算相机的运动参数,包括旋转和平移。位姿估计的一个常用方法是**PnP (Perspective-n-Point)** 问题求解。

PnP问题的目标是根据已知的n个三维空间点和它们在图像上的二维投影点,求解相机的位姿参数。解决PnP问题的常用算法有:

- **EPnP**:一种直接解决PnP问题的算法,它通过构造一个线性系统来求解。

- **RANSAC**:一种鲁棒估计方法,通过迭代随机抽样,剔除外点,最终给出稳定的解。

## 2.3 关键技术解析

### 2.3.1 深度估计技术

深度估计是立体视觉里程计中的核心技术之一,它能够将二维图像中的匹配点转换为三维空间中的实际距离。深度估计的方法主要有:

- **三角测量法**:利用几何关系,通过匹配点在左右图像中的视差(即同一场景点在左右图像中的横向偏差)来计算深度信息。

- **深度学习法**:使用深度学习模型,如卷积神经网络(CNN),直接从图像中预测深度。

### 2.3.2 运动模型和滤波算法

为了得到更平滑和准确的位姿估计结果,运动模型和滤波算法在立体视觉里程计中起到了至关重要的作用。运动模型描述了物体运动的数学特性,例如线性运动、匀加速运动等。而滤波算法用于融合不同时刻的传感器数据和运动模型信息,以减少噪声和误差。

**卡尔曼滤波(Kalman Filter)** 是一种经典的滤波算法,它可以递归地估计线性动态系统的状态。在立体视觉里程计中,卡尔曼滤波通常与其他模型结合使用,如扩展卡尔曼滤波(EKF)和无迹卡尔曼滤波(UKF)。

下面展示一个卡尔曼滤波的简单代码示例及其逻辑解释:

```python

import numpy as np

# 假设系统动态模型

def motion_model(x, dt, u):

"""预测下一时刻的位置"""

return x + np.dot(dt, u)

# 卡尔曼滤波函数

def kalman_filter(measurement, dt, prev_state, prev_err, motion_matrix, meas_matrix, est_err):

"""

卡尔曼滤波核心算法,包括预测和更新步骤。

:param measurement: 测量值

:param dt: 时间间隔

:param prev_state: 上一时刻状态估计值

:param prev_err: 上一时刻估计误差

:param motion_matrix: 运动模型矩阵

:param meas_matrix: 测量模型矩阵

:param est_err: 估计误差

:return: 本时刻状态估计值和估计误差

"""

# 预测步骤

new_state = motion_model(prev_state, dt, u) # 仅以匀速模型为例,u为控制输入

new_err = np.dot(motion_matrix, np.dot(prev_err, motion_matrix.T)) + est_err

# 更新步骤

kalman_gain = new_err.dot(meas_matrix.T).dot(np.linalg.inv(np.dot(meas_matrix, new_err.dot(meas_matrix.T)) + R))

new_state = new_state + kalman_gain.dot(measurement - meas_matrix.dot(new_state))

new_err = new_err - kalman_gain.dot(meas_matrix).dot(new_err)

return new_state, new_err

# 参数定义(省略具体数值,通常需要根据实际问题来设定)

R = ... # 测量噪声协方差矩阵

motion_matrix = ... # 运动模型矩阵

meas_matrix = ... # 测量模型矩阵

est_err = ... # 估计误差协方差矩阵

# 初始化状态和误差

state = ... # 初始状态向量

error = ... # 初始误差协方差矩阵

dt = ... # 时间间隔

u = ... # 控制输入

# 测量值

measurement = ...

# 运行卡尔曼滤波

state, error = kalman_filter(measurement, dt, state, error, motion_matrix, meas_matrix, est_err)

```

在上述代码中,`kalman_filter` 函数实现了卡尔曼滤波的核心算法,包括预测和更新两个步骤。预测步骤基于系统的动态模型和上一时刻的估计值来预测当前时刻的状态,而更新步骤则结合当前的测量值来调整预测值,从而得到更准确的状态估计。参数 `R`、`motion_matrix`、`meas_matrix` 和 `est_err` 需要根据具体问题进行设定。代码执行后返回的 `state` 和 `error` 分别是滤波后的状态估计值和误差协方差矩阵。

# 3. 性能优化策略

## 3.1 硬件加速技术

立体视觉里程计系统中,实时处理大量数据的能力对于提高系统性能至关重要。这就要求我们在硬件上实现尽可能高效的加速。

### 3.1.1 GPU并行计算原理

GPU并行计算是利用图形处理单元(GPU)强大的并行处理能力,来加速计算密集型任务。GPU内部拥有大量的处理核心,这些核心可以同时执行大量的并行操作,适合于处理大规模数据集和重复的计算任务。与CPU相比,GPU能够在一些特定类型的计算上实现显著的性能提升。

GPU并行计算在立体视觉里程计中的应用主要体现在以下几个方面:

- 特征点检测和匹配:这是立体视觉里程计中的一个计算密集型过程,GPU的并行计算能力可以大大加快这一过程。

- 图像预处理:图像去噪、直方图均衡化等预处理步骤可以通过GPU高效并行处理。

- 三维重建:对于每个特征点的三维坐标计算,GPU可以同时处理成千上万个点,极大提升计算效率。

### 3.1.2 硬件加速在立体视觉中的应用实例

为了展示GPU在立体视觉里程计中的性能提升效果,我们以下面一个简单的实验为例。

**实验场景:** 利用GPU并行计算加速一个简化的立体视觉里程计流程。

**实验步骤:**

1. 使用CUDA编程模型编写GPU加速的特征检测和匹配算法。

2. 在NVIDIA的Tesla GPU上运行该算法,使用同一数据集与CPU版本进行对比测试。

3. 记录并比较两种环境下的处理时间。

**实验结果:**

在实验中,我们发现GPU版本的处理时间明显短于CPU版本。具体来说,在处理大型图像集时,GPU的加速比可以达到CPU的多倍,尤其在特征点匹配阶段,加速效果更为显著。

## 3.2 软件优化方法

软件优化是提升立体视觉里程计性能的另一个关键环节。这涉及到代码层面的优化,以及算法效率的提升。

### 3.2.1 代码优化技巧

代码优化是提高执行效率最直接的方式。以下是一些常见的代码优化技巧:

- 减少全局变量和不必要的内存访问,通过使用寄存器变量或引用传递来提高访问速度。

- 优化循环结构,例如,减少循环内部的条件判断,使用循环展开来减少循环开销。

- 利用编译器优化选项,如 gcc 的 `-O2` 或 `-O3` 标志,来自动进行代码优化。

- 对于热点代码,可以采用内联函数来减少函数调用的开销。

### 3.2.2 算法效率提升策略

算法效率的提升往往比代码优化能带来更为显著的性能改进。在立体视觉里程计中,一些关键算法可以优化来提高整体效率:

- 采用近似方法来加速计算。例如,在特征点匹配阶段,可以使用快速近似最近邻(FLANN)方法代替暴力匹配,以减少计算时间。

- 对于某些步骤,可以使用多级分辨率的图像来加速处理,例如在初始的特征匹配阶段,先使用低分辨率图像进行粗匹配,然后逐步提升分辨率进行精细匹配。

- 应用数据结构优化,例如使用哈希表等高效的数据结构来存储和快速检索数据。

**代码块示例:**

假设我们有一个在图像中检测角点的函数,下面是一个使用OpenCV库的简化示例代码,展示如何优化特征检测的过程。

```python

import cv2

import numpy as np

def detect_corners(image):

# 将图像转换为灰度

gray = cv2.cvtColor(image, cv2.COLOR_BGR2GRAY)

# Harris角点检测

corners = cv2.cornerHarris(gray, blockSize=2, ksize=3, k=0.04)

# 找到局部最大值对应的位置

ret, dst = cv2.threshold(corners, 0.01*corners.max(), 255, 0)

dst = np.uint8(dst)

ret, labels, stats, centroids = cv2.connectedComponentsWithStats(dst)

# 定义角点的选择条件

criteria = (cv2.TERM_CRITERIA_EPS + cv2.TERM_CRITERIA_MAX_ITER, 100, 0.001)

corners = cv2.cornerSubPix(gray, np.float32(centroids), (5, 5), (-1, -1), criteria)

# 将检测到的角点绘制在原图上

res = cv2.merge((image, image, image))

res[corners[:,1], corners[:,0]] = [0, 0, 255]

return res

# 加载图像并调用函数

image = cv2.imread('path_to_image.jpg')

result_image = detect_corners(image)

cv2.imshow('Detected Corners', result_image)

cv2.waitKey(0)

cv2.destroyAllWindows()

```

在这段代码中,我们使用了Harris角点检测算法,并通过`cornerSubPix`函数对角点进行亚像素级的精确化。通过使用这些优化算法,我们能够更快速且准确地进行特征检测,从而提升整体的性能。

## 3.3 系统级性能调整

为了进一步提升立体视觉里程计的性能,我们还可以在系统层面进行优化。

### 3.3.1 操作系统参数调优

操作系统(OS)参数调优可以释放更多的系统资源用于执行我们的应用程序。例如,在Linux系统中,可以调整内核参数如Swappiness(控制swap分区的使用)和文件系统的读写缓存参数来提升I/O性能。此外,对于并行计算任务,合理分配CPU的亲和性(affinity)和优先级也很重要。

### 3.3.2 多线程与多进程应用

现代操作系统提供了多线程和多进程的并发执行机制。通过合理使用这些机制,可以提升应用程序的执行效率。

- **多线程:** 在支持多线程的编程语言中,可以并行处理多个任务,例如,同时进行图像的预处理、特征提取和匹配等。这可以有效利用现代多核处理器的能力。

- **多进程:** 对于计算密集型任务,多进程模式能避免全局解释器锁(GIL)带来的限制,在Python等解释型语言中尤其有用。多进程可以实现真正的并行执行,从而提高性能。

性能优化策略是提升立体视觉里程计性能的关键。通过硬件加速、软件优化以及系统级调整,可以显著提高系统的响应速度和准确性。在下一章节中,我们将深入探讨立体视觉系统的误差来源及其分析方法。

# 4. 误差来源与分析

## 4.1 立体视觉系统的误差类型

### 4.1.1 校准误差

校准误差通常发生在立体视觉系统设置过程中,当系统中的摄像机参数或相对位置未被精确确定时产生。摄像机标定是确定这些参数的关键步骤,包括焦距、主点、镜头畸变系数以及摄像机之间的相对位置和方向。标定误差会影响后续的深度估计准确性,因而在立体视觉里程计中是需要重点控制的因素。

```mermaid

flowchart TD

A[开始标定流程] --> B[拍摄标定板照片]

B --> C[检测标定板上的特征点]

C --> D[计算摄像机内参]

D --> E[计算摄像机外参]

E --> F[校验标定结果]

F --> G[修正标定参数]

```

### 4.1.2 匹配误差

匹配误差是指在立体视觉系统中,两幅图像对应特征点未能正确匹配时产生的误差。这通常由图像中的重复纹理、遮挡、光照变化和噪声等因素引起。特征点的检测和匹配算法的准确性直接决定了匹配误差的大小。通过改进算法或引入更多的特征点,可以在一定程度上减小匹配误差。

### 4.1.3 运动估计误差

运动估计误差发生在系统尝试从连续帧中估计摄像机运动时。在动态环境中,准确估计摄像机的运动状态是极其困难的。错误的运动估计会导致轨迹计算的偏差,进而影响到整个系统的定位精度。为了减少运动估计误差,需要使用更加鲁棒的运动估计算法,比如基于滤波器的方法。

## 4.2 误差分析方法

### 4.2.1 统计分析方法

统计分析方法是研究误差最常用的方法之一,它涉及对误差数据的收集和处理。使用平均值、方差、标准差等统计量来分析误差的分布特性。此外,假设检验和置信区间等方法可以用来确定误差是否在可接受范围内。

```mermaid

graph TD

A[开始误差统计分析] --> B[收集误差数据]

B --> C[计算平均值和方差]

C --> D[假设检验]

D --> E[确定置信区间]

E --> F[评估误差是否在控制内]

```

### 4.2.2 误差传播模型

误差传播模型通常用于分析误差对最终计算结果的影响。这涉及对各个误差源进行建模,并分析它们对系统输出的影响。误差传播模型可用于设计更鲁棒的系统,通过优化各个参数的配置来最小化误差的影响。

## 4.3 误差补偿技术

### 4.3.1 校准误差的补偿方法

为了校准误差的补偿,可以采用更高级的标定技术,如主动视觉标定,或引入更多的标定数据进行处理,以减小标定过程中的误差。此外,通过软件补偿来微调标定结果,也是常用的方法之一。

### 4.3.2 匹配误差的校正技术

匹配误差的校正通常需要改进特征匹配算法,利用更高层次的机器学习方法来进行特征学习,提高匹配的准确性。同时,通过增加冗余匹配点或引入运动信息来辅助特征匹配,可以进一步提高匹配的鲁棒性。

# 5. 立体视觉里程计仿真实践

## 5.1 仿真环境搭建

### 5.1.1 软件选择与配置

在进行立体视觉里程计仿真实践之前,软件环境的搭建至关重要。立体视觉里程计仿真依赖于多个软件组件和库,如仿真平台、编程环境、图像处理库等。例如,常用的仿真平台有Gazebo和V-REP,而编程环境推荐使用支持图形处理的库,比如OpenCV和PCL(Point Cloud Library)。在软件选择时,我们需要考虑其功能的完善性、社区的支持程度以及是否开源等因素。

在配置软件时,要确保所有组件的版本兼容,并遵循它们的安装指南。如在Linux环境下配置OpenCV,可以通过包管理器安装依赖库,然后从源代码编译OpenCV。具体操作如下:

```bash

sudo apt-get install build-essential cmake

sudo apt-get install libgtk2.0-dev pkg-config libavcodec-dev libavformat-dev libswscale-dev

git clone ***

```

每一步都需要仔细执行,确保依赖正确安装和库文件正确编译。安装后的库通常位于`/usr/local/lib`目录下,头文件位于`/usr/local/include/opencv4`。此外,需要将库文件路径添加到环境变量中,以便在程序中调用。

### 5.1.2 实验数据准备

实验数据的准备是仿真过程中的另一个关键步骤。实验数据包括但不限于摄像机标定参数、场景模型、运动轨迹等。数据的准确性和多样性直接影响仿真的真实性和可靠性。

为了准备摄像机标定数据,可以使用标定板进行实际拍摄,然后通过OpenCV中的`cv::calibrateCamera`函数进行摄像机参数的校准。此外,还可以下载公开的数据集,例如KITTI数据集,该数据集包含了真实世界场景的立体图像对和同步的激光雷达数据,非常适合作为仿真实验的数据源。

接下来,我们可以使用以下代码片段来加载标定数据:

```python

import numpy as np

import cv2 as cv

# 摄像机矩阵

cameraMatrix = np.load('cameraMatrix.npy')

# 畸变系数

distCoeffs = np.load('distCoeffs.npy')

# 载入标定数据(示例)

ret, mtx, dist, rvecs, tvecs = cv.calibrateCamera(objpoints, imgpoints, (width, height), None, None)

# 保存标定数据

np.save('cameraMatrix.npy', mtx)

np.save('distCoeffs.npy', dist)

```

这段代码中,`objpoints`是标定板上的角点在世界坐标系下的位置,`imgpoints`是图像坐标系下的角点位置。通过这些数据,我们可以计算出摄像机矩阵和畸变系数。

在准备场景模型方面,Gazebo提供了丰富的3D模型库,并支持从URDF(Unified Robot Description Format)文件导入自定义模型。模型的设计需要尽可能地接近实际环境,以保证仿真的有效性。

## 5.2 仿真操作流程

### 5.2.1 模拟实验设计

模拟实验设计是立体视觉里程计仿真实践的核心环节。在这个阶段,我们需要规划实验的流程,包括摄像机运动轨迹、场景模拟参数和数据记录方式等。

以Gazebo仿真平台为例,可以设计如下实验流程:

1. 在Gazebo中导入场景和机器人模型。

2. 设置摄像机参数(如焦距、畸变系数等)。

3. 指定摄像机的运动轨迹。这可以通过编写机器人控制脚本来实现,也可以使用Gazebo内置的轨迹生成器。

4. 运行仿真,并记录摄像机捕获的图像数据。

5. 应用立体视觉里程计算法处理图像数据,估计摄像机的运动状态。

代码层面,可以使用Gazebo的ROS(Robot Operating System)接口编写控制节点,控制摄像机的运动,并记录数据。以下是一个简单的ROS节点示例,用于控制摄像机运动并记录图像:

```python

#!/usr/bin/env python

import rospy

from sensor_msgs.msg import Image

from cv_bridge import CvBridge, CvBridgeError

def image_callback(msg):

bridge = CvBridge()

try:

# 将ROS图像消息转换为OpenCV图像

frame = bridge.imgmsg_to_cv2(msg, "bgr8")

# 这里可以加入立体视觉里程计算法处理frame

# 例如调用StereoSVO或ORB-SLAM2等

except CvBridgeError as e:

print(e)

def main():

rospy.init_node('camera_controller', anonymous=True)

rospy.Subscriber("/camera/image_raw", Image, image_callback)

rospy.spin()

if __name__ == '__main__':

main()

```

### 5.2.2 结果观察和分析

仿真完成后,观察和分析结果是验证算法准确性和系统性能的重要步骤。我们可以通过查看仿真过程中记录的数据和生成的视觉效果来评估实验的成功与否。

在观察和分析阶段,主要关注以下几个方面:

1. **摄像机运动的准确性**:通过比对摄像机的预期运动轨迹与实际运动轨迹,可以评估摄像机运动模型的准确性。

2. **视觉里程计的估计精度**:计算视觉里程计输出的位姿估计与真实位姿之间的误差,分析误差的分布和变化趋势。

3. **深度估计的质量**:深度估计是立体视觉里程计中的关键技术之一,通过与激光雷达等其他传感器的深度数据对比,可以评价深度估计的质量。

此外,还可以通过绘制轨迹图和误差图来直观展示实验结果。例如,使用matplotlib库绘制图像:

```python

import matplotlib.pyplot as plt

# 假设 gt_trajectory 和 estimated_trajectory 分别为真实轨迹和估计轨迹

plt.plot(gt_trajectory[:, 0], gt_trajectory[:, 1], label='Ground Truth')

plt.plot(estimated_trajectory[:, 0], estimated_trajectory[:, 1], label='Estimated', linestyle='--')

plt.legend()

plt.xlabel('X-axis')

plt.ylabel('Y-axis')

plt.title('Trajectory Comparison')

plt.show()

```

在上述代码中,`gt_trajectory`和`estimated_trajectory`分别存储了真实轨迹和估计轨迹的数据点,通过`plt.plot`绘制出两条轨迹进行比较。

## 5.3 实际应用案例

### 5.3.1 场景模拟与分析

在立体视觉里程计仿真实践中,场景模拟与分析有助于理解算法在复杂环境中的表现。根据实际应用的需求,可以模拟不同的场景,例如室内外环境、动态障碍物干扰等,并通过仿真实验进行分析。

在场景模拟中,我们通常需要关注以下几点:

1. **光照条件的模拟**:光照变化会影响图像质量,进而影响视觉里程计算法的性能。

2. **物体运动模式**:模拟物体的运动状态,如匀速、加速、减速和随机运动等。

3. **环境复杂度**:通过增加环境中的纹理、反射和动态变化,考察算法在复杂背景下的适应性。

具体来说,可以通过调整Gazebo环境中的光源设置和动态对象的参数来模拟不同光照和动态场景。在分析阶段,需要记录算法在不同条件下的性能数据,包括跟踪成功率、定位精度和处理帧率等。

### 5.3.2 应用效果评估

通过前面的实验设计、观察与分析,我们已经能够得到一系列的数据来评估立体视觉里程计在实际应用中的效果。

为了全面评估效果,我们可以定义以下几个关键评估指标:

1. **定位精度**:根据真实轨迹和估计轨迹之间的差异来衡量定位的准确性。

2. **运行稳定性**:考虑算法是否能够在长时间运行中保持稳定状态,不发生漂移或者累积误差。

3. **计算效率**:评估算法的实时处理能力,以及是否满足实际应用中的性能要求。

实际应用案例中,可能涉及到复杂的室外环境模拟,如城市道路或自然地形。在这种情况下,我们需要使用更加复杂和多样的场景数据进行测试。例如,可以使用自动驾驶测试场景,测试立体视觉里程计在自动驾驶车辆导航和定位中的应用效果。

为了评估效果,可以通过绘制误差分布图来展示定位精度:

```python

# 假设 error_distribution 存储了估计误差数据

plt.hist(error_distribution, bins=50, edgecolor='black')

plt.xlabel('Error (m)')

plt.ylabel('Frequency')

plt.title('Error Distribution of Stereo Visual Odometry')

plt.show()

```

上述代码通过绘制误差直方图来直观展示估计误差的分布情况,误差的数值大小由`error_distribution`提供。通过直方图可以观察到误差的集中趋势、分散程度和异常值等信息。

此外,还可以通过构建表格来详细展示不同情况下的定位精度指标,例如:

| 测试场景 | 定位平均误差(m) | 定位标准差(m) | 成功跟踪比例 |

|---------|----------------|--------------|--------------|

| 室内走廊 | 0.05 | 0.01 | 98% |

| 城市街道 | 0.12 | 0.04 | 95% |

| 自然林地 | 0.20 | 0.07 | 90% |

通过上述表格,我们可以清晰地看到立体视觉里程计在不同场景下的定位精度和稳定性。

# 6. 进阶技巧与未来发展方向

随着技术的发展,立体视觉里程计技术正在快速演进,不仅在精度和效率上得到了显著提升,而且已经开始涌现出一系列前沿的应用和进阶技巧。本章将深入探讨这些新技术的应用以及立体视觉里程计未来的可能发展方向。

## 6.1 先进仿真技术应用

立体视觉里程计的仿真技术是开发和测试的关键环节,它能够帮助研究者在没有实际硬件设备的情况下进行算法验证和系统优化。

### 6.1.1 机器学习在误差分析中的应用

机器学习技术特别是深度学习,在立体视觉里程计的误差分析中显示出了巨大的潜力。通过训练深度神经网络,可以实现对立体视觉系统中产生的误差进行预测和分类,从而提前进行调整或校准。例如,使用卷积神经网络(CNN)进行图像特征提取,可以辅助改进特征匹配精度,进而减少匹配误差。

```python

# 示例代码:利用CNN进行图像特征提取

import tensorflow as tf

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import Conv2D, Flatten, Dense

# 构建简单的CNN模型

model = Sequential([

Conv2D(32, (3, 3), activation='relu', input_shape=(64, 64, 3)),

Conv2D(64, (3, 3), activation='relu'),

Flatten(),

Dense(128, activation='relu'),

Dense(10, activation='softmax')

])

# 编译模型

***pile(optimizer='adam', loss='categorical_crossentropy')

# 假设已有图像数据X_train和标签y_train

# model.fit(X_train, y_train, epochs=10, validation_split=0.2)

```

### 6.1.2 多传感器数据融合

立体视觉里程计的另一个进阶技巧是融合其他类型的传感器数据,如IMU(惯性测量单元)、GPS等。这种多传感器数据融合技术有助于弥补单一传感器的不足,提高系统的稳定性和准确性。例如,通过IMU数据可以获取更准确的运动信息,而融合GPS数据则有助于在全球定位系统覆盖的地区提升定位精度。

## 6.2 立体视觉里程计的未来趋势

随着机器视觉和传感器技术的不断进步,立体视觉里程计技术的精度、速度和适用性都有望得到提升,这为该技术在更多领域和商业应用中的推广提供了可能。

### 6.2.1 精度提升的技术路径

为了进一步提升立体视觉里程计的精度,未来的研究可能会集中在以下几个方面:

- **更先进的图像处理算法**:利用深度学习等技术进一步优化特征提取和匹配。

- **硬件提升**:使用更高分辨率的摄像头和更强大的处理器。

- **软件优化**:改进算法以提高处理速度和准确性。

### 6.2.2 立体视觉里程计的商业化潜力

立体视觉里程计技术的商业化潜力巨大,尤其在自动驾驶汽车、机器人导航、虚拟现实和增强现实等领域。随着相关技术的成熟和成本的降低,我们可以预见该技术将在未来几年内广泛应用到消费电子、智能交通、智能监控等多个行业中。

通过本章的分析,我们可以看到,立体视觉里程计领域不断有新的技术和应用出现,它们推动着整个行业向前发展。无论是对于研究人员还是技术开发者,紧跟这些最新的研究进展和市场趋势,都是实现突破和创新的关键所在。

0

0