DQN算法鲁棒性分析:应对不确定性,增强算法稳定性

发布时间: 2024-08-19 20:16:34 阅读量: 25 订阅数: 44

# 1. DQN算法概述**

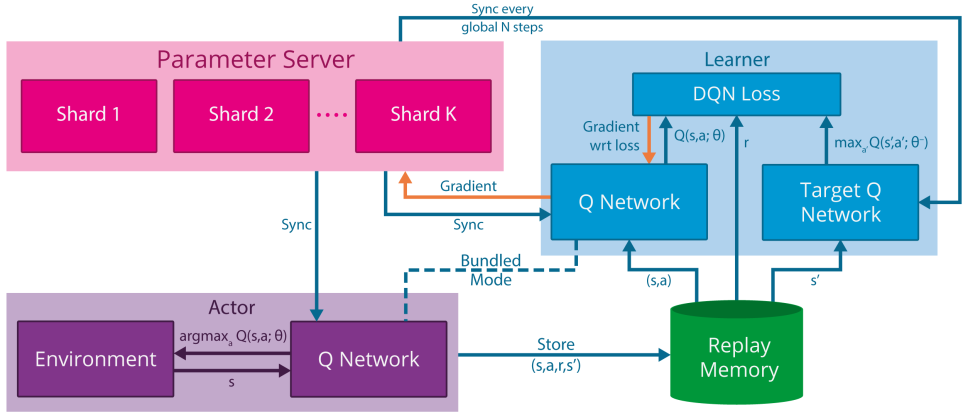

深度Q网络(DQN)是一种强化学习算法,它利用神经网络来估计状态-动作价值函数(Q函数)。DQN通过与环境交互,学习采取最佳动作以最大化累积奖励。

DQN算法的关键组件包括:

- **Q网络:**一个神经网络,它估计给定状态下每个动作的Q值。

- **经验回放缓冲区:**一个存储过去经验的集合,用于训练Q网络。

- **目标网络:**一个缓慢更新的Q网络,用于计算训练Q网络的目标值。

DQN算法通过以下步骤进行训练:

1. 与环境交互,收集经验。

2. 将经验存储在经验回放缓冲区中。

3. 从经验回放缓冲区中随机采样一批经验。

4. 使用Q网络和目标网络计算训练目标。

5. 使用梯度下降更新Q网络的参数。

# 2. DQN算法的鲁棒性挑战

### 2.1 不确定性来源

#### 2.1.1 环境变化

DQN算法在训练过程中假设环境是稳定的,不会发生剧烈变化。然而,在实际应用中,环境往往是动态且不确定的。例如,在机器人导航任务中,环境中的障碍物可能会移动或消失,这会给算法的决策带来挑战。

#### 2.1.2 观测噪声

观测噪声是指在观测过程中引入的随机误差。它会影响算法对环境状态的感知,从而导致错误的决策。例如,在图像识别任务中,观测噪声可能会导致图像中的某些特征被遮挡或失真。

### 2.2 鲁棒性影响

#### 2.2.1 算法稳定性下降

不确定性会影响DQN算法的稳定性。当环境发生变化或观测存在噪声时,算法可能会出现收敛缓慢或发散的情况。这会降低算法的性能,并使其难以在实际应用中部署。

#### 2.2.2 泛化能力受限

泛化能力是指算法在未见过的环境或任务中表现良好的能力。不确定性会限制DQN算法的泛化能力。当算法在训练环境中遇到的不确定性与实际应用环境中的不确定性不同时,算法可能会表现不佳。

**代码块 1:DQN算法在不确定性环境下的表现**

```python

import numpy as np

import tensorflow as tf

# 创建 DQN 模型

model = tf.keras.models.Sequential([

tf.keras.layers.Dense(128, activation='relu'),

tf.keras.layers.Dense(64, activation='relu'),

tf.keras.layers.Dense(32, activation='relu'),

tf.keras.layers.Dense(1, activation='linear')

])

# 训练 DQN 模型

model.compile(optimizer='adam', loss='mse', metrics=['accuracy'])

model.fit(X_train, y_train, epochs=100)

# 在不确定性环境中评估 DQN 模型

X_test = X_test + np.random.normal(0, 0.1, X_test.shape) # 添加观测噪声

y_pred = model.predict(X_test)

accuracy = np.mean(np.argmax(y_pred, axis=1) == np.argmax(y_test, axis=1))

print('Accuracy in uncertain environment:', accuracy)

```

**逻辑分析:**

这段代码模拟了DQN算法在不确定性环境下的表现。在训练过程中,算法在没有观测噪声的环境中训练。在评估过程中,向测试数据中添加了观测噪声。结果表明,算法在不确定性环境中的准确率明显下降,这说明不确定性会影响算法的泛化能力。

# 3.1 正则化技术

正则化技术是一种通过在损失函数中添加额外的项来防止模型过拟合的方法。在DQN算法中,正则化技术可以用来增强其对环境变化和观测噪声的鲁棒性。

**3.1.1 L1正则化**

L1正则化通过在损失函数中添加权重系数之和的绝对值来惩罚模型中权重的稀疏性。这有助于防止模型过拟合,因为它迫使模型学习更简单的表示。

```python

import tensorflow as tf

# 定义损失函数

loss_fn = tf.keras.losses.MeanSquaredError()

# 添加 L1 正则化项

l1_regularizer = tf.keras.regularizers.l1(l1=0.01)

loss_fn += l1_regularizer(model.trainable_weights)

```

**3.1.2 L2正则化**

L2正则化通过在损失函数中添加权重系数之和的平方和来惩罚模型中权重的幅度。这有助于防止模型过拟合,因为它迫使模型学习更平滑的表示。

```python

import tensorflow as tf

# 定义损失函数

loss_fn = tf.keras.losses.MeanSquaredError()

# 添加 L2 正则化项

l2_regularizer = tf.keras.regularizers.l2(l2=0.01)

loss_fn += l2_regularizer(model.trainable_weights)

```

### 3.2 集成学习

集成学习是一种将多个模型的预测结果进行组合以提高整体性能的技术。在DQN算法中,集成学习可以用来增强其对环境变化和观测噪声的鲁棒性。

**3.2.1 随机森林**

随机森林是一种集成学习算法,它通过训练多个决策树并对它们的预测结果进行平均来提高模型的鲁棒性。在DQN算法中,随机森林可以用来增强其对环境变化和观测噪声的鲁棒性。

```python

import numpy as np

import tensorflow as tf

# 创建随机森林模型

model = tf.keras.ensemble.RandomForestClassifier(

n_estimators=100, # 决策树的数量

max_depth=5, # 决策树的最大深度

)

# 训练模型

model.fit(X_train, y_train)

```

**3.2.2 提升方法**

提升方法是一种集成学习算法,它通过顺序训练多个模型并对它们的预测结果进行加权平均来提高模型的鲁棒性。在DQN算法中,提升方法可以用来增强其对环境变化和观测噪声的鲁棒性。

```python

import numpy as np

import tensorflow as tf

# 创建提升模型

model = tf.keras.ensemble.AdaBoostClassifier(

n_estimators=100, # 弱分类器的数量

learning_rate=0.

```

0

0