DQN算法并行化实现:加速学习,提升效率

发布时间: 2024-08-19 19:54:28 阅读量: 181 订阅数: 26

莫烦老师 走迷宫 智能强化学习DQN算法实现,开箱即用

# 1. DQN算法简介

深度Q网络(DQN)算法是一种强化学习算法,它使用深度神经网络来估计动作价值函数。DQN算法在许多复杂任务中取得了成功,包括围棋和自动驾驶。

DQN算法的主要思想是使用深度神经网络来估计动作价值函数。动作价值函数估计每个动作在给定状态下获得的长期奖励。通过使用深度神经网络,DQN算法可以学习复杂的状态-动作关系,从而做出更优的动作决策。

# 2. DQN算法并行化理论基础

### 2.1 并行计算原理

并行计算是一种利用多个处理单元同时执行计算任务的技术。它可以显著提高计算效率,尤其是在处理大规模数据或复杂算法时。

#### 2.1.1 多核并行和分布式并行

并行计算有两种主要类型:

* **多核并行:**使用一台计算机中的多个处理器核心同时执行任务。

* **分布式并行:**使用多台计算机连接在一起,共同执行任务。

#### 2.1.2 并行算法设计方法

设计并行算法时,需要考虑以下方法:

* **任务并行:**将任务分解成独立的部分,并分配给不同的处理单元。

* **数据并行:**将数据分解成块,并分配给不同的处理单元。

* **混合并行:**结合任务并行和数据并行。

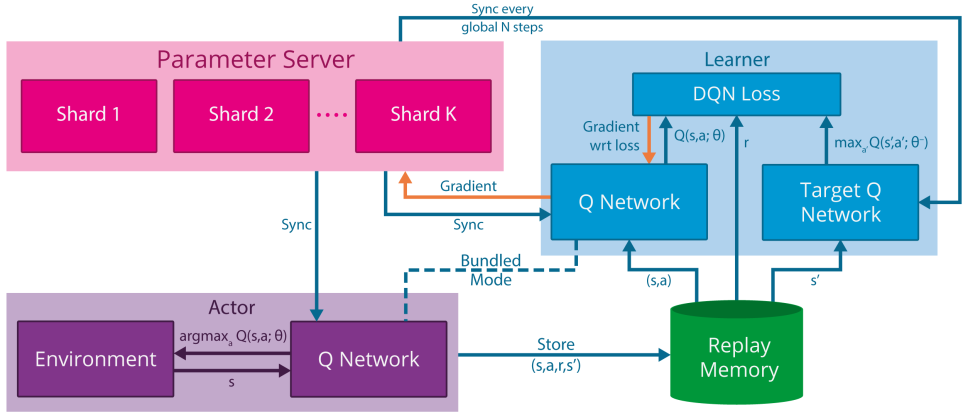

### 2.2 DQN算法并行化理论

#### 2.2.1 DQN算法并行化的必要性

DQN算法涉及大量的计算,包括经验回放、目标网络更新和梯度下降。并行化可以显著减少这些计算的执行时间。

#### 2.2.2 DQN算法并行化的可行性

DQN算法具有以下特性,使其适合并行化:

* **独立的经验回放:**经验回放中的数据可以独立地进行处理。

* **可并行的目标网络更新:**目标网络的更新可以并行执行,因为它们不依赖于当前状态。

* **可并行的梯度下降:**梯度下降可以并行执行,因为每个样本的梯度计算是独立的。

```mermaid

graph LR

subgraph 多核并行

A[多核处理器] --> B[任务并行]

A[多核处理器] --> C[数据并行]

A[多核处理器] --> D[混合并行]

end

subgraph 分布式并行

E[计算机1] --> F[任务并行]

E[计算机1] --> G[数据并行]

E[计算机1] --> H[混合并行]

end

```

上图展示了多核并行和分布式并行的流程图。

# 3. DQN算法并行化实践

### 3.1 基于多核的DQN算法并行化

#### 3.1.1 OpenMP并行编程

OpenMP(Open Multi-Processing)是一种用于共享内存并行编程的应用程序编程接口(API)。它允许程序员使用编译器指令和库函数将并行性添加到现有代码中。

在OpenMP中,并行性是通过创建线程来实现的。线程是轻量级的执行单元,可以并行执行代码。OpenMP提供了一组指令,用于创建和管理线程,以及同步它们的执行。

#### 3.1.2 多线程并行实现

使用OpenMP实现DQN算法的多线程并行化,可以采用以下步骤:

1. **创建线程:**使用`#pragma omp parallel`指令创建线程。

2. **分配任务:**使用`#pragma omp for`指令将DQN算法的训练过程分配给不同的线程。

3. **同步线程:**使用`#pragma omp barrier`指令同步线程,确保所有线程在继续执行之前都完成各自的任务。

**代码块:**

```cpp

#include <omp.h>

// DQN算法的训练函数

void train_dqn() {

// 创建线程

#pragma omp parallel

{

// 分配任务

#pragma omp for

for (int i = 0; i < num_episodes; i++) {

// 训练DQN算法

}

}

// 同步线程

#pragma omp barrier

}

```

**逻辑分析:**

该代码块使用OpenMP创建线程并行执行DQN算法的训练过程。`#pragma omp parallel`指令创建线程,`#pragma omp for`指令将训练过程分配给不同的线程,`#pragma omp barrier`指令同步线程,确保所有线程在继续执行之前都完

0

0