揭秘GEE数据处理:20个高级图像分析技巧,让你的分析更上一层楼

发布时间: 2024-12-06 12:12:33 阅读量: 27 订阅数: 26

参考资源链接:[Google Earth Engine中文教程:遥感大数据平台入门指南](https://wenku.csdn.net/doc/499nrqzhof?spm=1055.2635.3001.10343)

# 1. GEE平台简介与图像分析基础

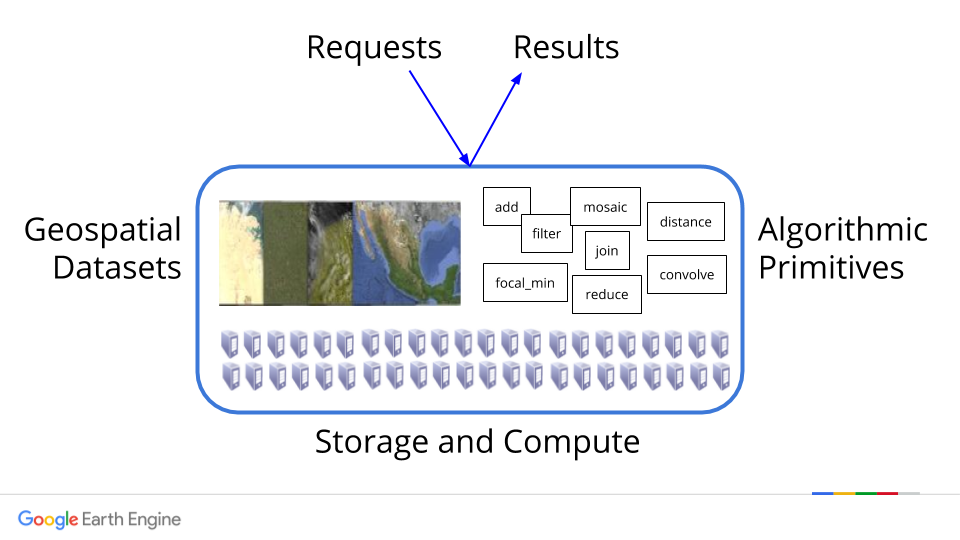

Google Earth Engine (GEE) 是一个强大的云平台,提供了丰富的地理数据集和分析工具,它允许用户从云端访问和分析大量的地球科学数据。GEE 的数据仓库整合了诸多卫星图像、地理信息和气象数据,为环境监测、资源管理、气候变化研究等领域提供了高效的解决方案。GEE 平台通过 JavaScript 和 Python API,为开发者和研究人员提供了一个强大的图像分析环境,使得复杂的数据处理和分析工作变得简单可行。

## 1.1 GEE平台的主要优势

GEE 的最大特色在于其云端处理能力,用户无需下载和存储大量的数据,即可直接在平台上进行数据访问和分析。它支持快速的影像筛选、处理和分析功能,使得用户能够高效地进行时间序列分析和空间模式识别。GEE 的另一个亮点是其用户友好的在线代码编辑器,配合丰富的API文档和示例,即使是初学者也能快速上手,进行复杂的遥感数据处理和分析工作。

## 1.2 GEE平台的适用人群和用途

GEE 平台适合于对地理空间数据有需求的广大用户群体,包括研究学者、遥感分析师、政策制定者和环保组织等。它可以应用于多种领域,如自然资源管理、城市规划、农业监测和灾害评估等。通过GEE,这些领域的专业人士可以快速获取和处理卫星图像数据,进行动态分析和长期监测,从而做出基于数据的决策。

# 2. GEE图像处理核心概念

### 2.1 图像集合与图像处理

#### 2.1.1 图像集合的创建和使用

图像集合是GEE平台中用于存储和管理一系列图像的数据结构。用户可以通过不同的过滤条件创建图像集合,例如时间范围、地理位置或特定的云量。创建图像集合后,可以对其进行排序、过滤以及迭代处理。

在GEE中,图像集合可以通过多种方式创建。例如,使用`ee.ImageCollection`类来指定数据源,然后应用过滤条件来筛选所需的图像集。以下是一个简单的示例代码,用于创建一个包含特定时间范围内的Landsat 8影像的图像集合:

```javascript

var landsat8 = ee.ImageCollection('LANDSAT/LC08/C01/T1')

.filterDate('2020-01-01', '2020-12-31')

.filterBounds(ee.Geometry.Point([-122.092, 37.42]))

.sort('CLOUD_COVER');

```

在上述代码中,`.filterDate`用于指定时间范围,`.filterBounds`用于限定地理位置,而`.sort`则用于按云量排序。创建图像集合后,可以使用`.map()`、`.reduce()`等函数对图像集合进行批处理。

#### 2.1.2 图像处理函数概述

GEE提供了一系列用于图像处理的函数,如`.map()`, `.reduce()`, `.select()`, `.filter()`, 等等。这些函数可以对图像集合中的每个图像进行操作,或者整合图像集合中的图像进行分析。

`.map()`函数用于对图像集合中的每一个图像执行相同的操作,比如改变波段的顺序,或者应用一个特定的函数来计算新的数据。

```javascript

var ndviCollection = landsat8.map(function(image) {

var ndvi = image.normalizedDifference(['B5', 'B4']).rename('NDVI');

return image.addBands(ndvi);

});

```

在该代码示例中,我们为Landsat 8图像集合中的每张影像计算了归一化植被指数(NDVI),并将结果作为新波段添加到每张图像中。

`.reduce()`函数则用于对图像集合中的图像进行集总统计操作,如最大值、最小值、平均值等统计计算。例如,使用`reduce()`可以得到一个图像集的平均云量。

### 2.2 时间序列数据的操作

#### 2.2.1 时间序列数据的整合

时间序列分析是环境监测和变化检测的关键技术。在GEE平台中,时间序列数据的整合通常涉及到将不同时间点获取的图像数据整合到一个统一的数据框架中。

整合时间序列数据时,需要考虑时空分辨率的一致性问题,以及数据集的时空对齐问题。例如,同一地点在不同时间拍摄的影像可能因为传感器视角的差异而有位置偏差,这种情况下需要进行图像校正。

时间序列数据也可以通过使用特定的算法进行插值来填补数据空白,例如使用线性插值或者更复杂的时空插值方法。以下是一个简单的示例代码:

```javascript

var startDate = ee.Date('2020-01-01');

var endDate = ee.Date('2020-12-31');

var timeStep = ee.Number(1).multiply(30).multiply(24).multiply(60).multiply(60).multiply(1000);

var timeSeries = ee.List.sequence(0, timeStep.multiply(12), timeStep)

.map(function(dayOffset) {

return startDate.advance(dayOffset, 'day');

})

.map(function(date) {

return landsat8.filterDate(date, date.advance(1, 'day'))

.min()

.set('system:time_start', date.millis());

});

```

在这个例子中,我们创建了一个由每个月的第一天所代表的图像构成的时间序列。

#### 2.2.2 时间序列分析方法

时间序列分析方法可以帮助我们识别和解释数据随时间的变化趋势,包括周期性变化、趋势变化和突发事件的影响。常用的时间序列分析方法包括移动平均法、指数平滑法、ARIMA模型等。

例如,可以使用移动平均法来平滑时间序列数据,减少噪声,识别趋势:

```javascript

var movingAverage = timeSeries.map(function(image) {

return image.reduceNeighborhood({

reducer: ee.Reducer.mean(),

kernel: ee.Kernel.circle({radius: 3}),

});

});

```

此外,还可以利用GEE提供的时间序列分析工具,如`Chart.image.series()`,直接在图像集合上创建图表:

```javascript

var chart = ui.Chart.image.series({

imageCollection: movingAverage,

region: ee.Geometry.Rectangle([-122.092, 37.42, -122.048, 37.45]),

reducer: ee.Reducer.mean(),

scale: 30,

xProperty: 'system:time_start'

});

chart.setChartType('LineChart');

chart.setSeriesNames(['NDVI']);

chart.setOptions({

title: 'NDVI time series',

vAxis: {title: 'NDVI'},

hAxis: {title: 'Date'}

});

```

### 2.3 多时相数据的分析技巧

#### 2.3.1 多时相数据的获取与预处理

多时相数据指的是在不同时间点获取的同一地理空间位置的数据集。在GEE中获取和预处理多时相数据需要关注影像的空间分辨率、时间分辨率、波段信息、辐射定标等因素。

为了获取多时相数据,我们通常需要从GEE的数据库中选择合适的影像数据集,并设置合理的时间范围、地理位置以及云量等过滤条件。之后,数据预处理步骤可能包括云和阴影去除、大气校正等。

以下是一个获取和预处理Landsat影像数据的示例代码:

```javascript

var multiDateImages = ee.ImageCollection('LANDSAT/LC08/C01/T1')

.filterDate('2020-01-01', '2020-12-31')

.filterBounds(ee.Geometry.Point([-122.092, 37.42]))

.map(function(image) {

var cloudScore = ee.Algorithms.Landsat.simpleCloudScore(image).select('cloud');

var mask = cloudScore.lt(10); // threshold for cloud cover

return image.updateMask(mask);

});

```

在这个例子中,我们利用了`ee.Algorithms.Landsat.simpleCloudScore`方法来估算云覆盖分数,并以此分数作为掩膜来去除云和阴影。

#### 2.3.2 长时间序列数据的分析流程

长时间序列数据的分析流程涉及将预处理后的多时相数据进行整合分析,以揭示时间上的变化趋势或模式。此分析流程往往包括以下几个步骤:

1. 数据整合:将所有单个影像整合成一个统一的时间序列数据集。

2. 时间序列分析:应用统计方法或机器学习方法,如变化向量分析(Change Vector Analysis, CVA),来检测和量化变化。

3. 结果解释:根据分析结果,对变化趋势或模式进行解释。

例如,可以使用变化向量分析来检测和分类长时间序列影像中的变化类型:

```javascript

var first = ee.Image(multiDateImages.first());

var last = ee.Image(multiDateImages.sort('system:time_start').last());

var cVA = first.addBands(last).reduce(ee.Reducersubtract())

.select(['B2', 'B3', 'B4', 'B5', 'B6', 'B7', 'B8'])

.reduce(ee.Reducerがらぶん()).rename(['B2', 'B3', 'B4', 'B5', 'B6', 'B7', 'B8']);

// 计算变化向量的幅度和方向,这里省略具体的计算过程

```

该代码仅展示了变化向量分析的基本思想。实际的计算过程会涉及更多的步骤,如变化向量的标准化和分类等。

# 3. 高级图像分析方法

在遥感数据处理和分析领域,高级图像分析方法是提高分析精度和效率的关键。本章将深入探讨地物分类与变化检测、辐射定标与大气校正以及遥感数据的空间统计分析三个核心主题。

## 3.1 地物分类与变化检测

地物分类是将图像中的像素按照地物类别进行划分的过程,而变化检测则是识别不同时间点上地物状态变化的方法。它们在资源监测、城市规划、灾害评估等领域中发挥着重要作用。

### 3.1.1 地物分类的方法论

地物分类主要分为监督分类和非监督分类两大类。监督分类依赖于标记好的训练数据来指导分类器识别各类地物,而非监督分类则不依赖训练数据,通过算法发现数据中的自然分组。

**代码示例:监督分类**

```javascript

// Google Earth Engine JavaScript API

var image = ee.Image('LANDSAT/LC08/C01/T1_TOA/LC08_123032_20140515');

var bands = ['B2', 'B3', 'B4', 'B5', 'B6', 'B7']; // Landsat 8 TOA reflectance bands

// 定义训练数据集

var training = image.select(bands).sample({

region: // 定义感兴趣的区域

scale: 30 // 训练样本的空间分辨率

});

// 使用随机森林进行分类

var classifier = ee.Classifier.smileRandomForest(10).train({

features: training,

classProperty: 'landcover', // 训练数据集中的类别字段

inputProperties: bands

});

// 对整个影像进行分类

var classified = image.select(bands).classify(classifier);

// 代码逻辑的逐行解读分析:

// 第一行代码加载了一个Landsat 8 TOA反射率图像。

// 第二行代码定义了将用于分类的光谱波段。

// 接下来,我们定义了训练数据集,选择了光谱波段,并指定了样本的区域和规模。

// 然后,我们实例化了一个随机森林分类器,并使用training数据集进行训练。

// 最后,使用训练好的分类器对整个图像进行分类。

```

### 3.1.2 变化检测的策略与技巧

变化检测通常包括图像差值、比值分析、分类后比较等方法。这些方法可以通过比较不同时间点获取的图像来识别地物变化。

**变化检测方法 - 图像差值示例**

```javascript

// Google Earth Engine JavaScript API

var image1 = ee.Image('LANDSAT/LC08/C01/T1_TOA/LC08_123032_20140515');

var image2 = ee.Image('LANDSAT/LC08/C01/T1_TOA/LC08_123032_20150621');

// 计算两幅图像的差值,得到变化图像

var diffImage = image2.subtract(image1).select('B4'); // 以红色波段为例进行差值计算

// 计算差值图像的阈值,识别变化区域

var threshold = diffImage.reduceRegion({

reducer: ee.Reducer.mean(),

geometry: // 定义感兴趣的区域,

scale: 30 // 应用的空间分辨率

});

// 代码逻辑的逐行解读分析:

// 这段代码首先加载了两个Landsat 8 TOA反射率图像。

// 然后计算两幅图像的红色波段差值,得到变化图像。

// 最后使用reduceRegion方法和均值减少器计算差值图像在指定区域和尺度上的平均值作为阈值。

// 阈值可以用来区分变化和未变化的区域。

```

## 3.2 辐射定标与大气校正

辐射定标与大气校正是遥感图像预处理的重要步骤,它们确保图像能够真实地反映地物的反射率和辐射特性。

### 3.2.1 辐射定标的重要性和步骤

辐射定标将图像的数字量转换为物理单位,如辐射亮度或反射率。这对于后续的分析工作具有至关重要的意义。

**辐射定标步骤示例**

```javascript

// Google Earth Engine JavaScript API

var image = ee.Image('LANDSAT/LC08/C01/T1_TOA/LC08_123032_20140515');

// 辐射定标:将TOA反射率转换为表面反射率

var surfaceReflectance = image.multiply(ee.Number(0.0001)).rename(['B1', 'B2', 'B3', 'B4', 'B5', 'B6', 'B7', 'B8', 'B9', 'B10', 'B11']);

// 代码逻辑的逐行解读分析:

// 这段代码首先加载了一个Landsat 8 TOA反射率图像。

// 接着,通过乘以一个常数(0.0001)将图像的数字量转换为反射率,并重命名波段以反映它们是表面反射率。

```

### 3.2.2 大气校正的高级技术

大气校正通常包括去除大气散射和吸收的影响,以获取在特定条件下的地物表面真实反射率。

**大气校正示例**

```javascript

// Google Earth Engine JavaScript API

var image = ee.Image('LANDSAT/LC08/C01/T1_TOA/LC08_123032_20140515');

// 使用大气校正算法,比如DOS (Dark Object Subtraction)进行校正

var doffunc = function(image) {

var cloudShadow = image.select(['B2']).lt(1000).multiply(image.select(['B3']).multiply(1.6)).rename('cloudShadow');

var darkObject = image.select(['B2']).lt(1000).multiply(image.select(['B3']).multiply(1.0)).rename('darkObject');

var result = image.addBands(cloudShadow).addBands(darkObject);

return result;

};

var corrected = image.map(doffunc);

// 代码逻辑的逐行解读分析:

// 这段代码定义了一个自定义函数doFunc,它基于暗对象减法算法(DOS)来执行大气校正。

// 函数首先确定了云阴影区域,并将其与一个因子相乘,然后确定了暗对象区域,并将其与另一个因子相乘。

// 这两个结果被添加到原图像的波段中,并返回校正后的图像。

```

## 3.3 遥感数据的空间统计分析

空间统计分析是在地理信息系统(GIS)中对遥感数据进行统计和分析的过程,它关注的是地物的空间属性和模式。

### 3.3.1 空间统计分析的基本方法

空间统计分析常用方法包括空间自相关分析、热点分析、空间插值等,这些方法可以帮助我们理解地物的空间分布规律。

**空间自相关分析示例**

```javascript

// Google Earth Engine JavaScript API

var image = ee.Image('LANDSAT/LC08/C01/T1_TOA/LC08_123032_20140515');

// 计算Moran's I指数进行空间自相关分析

var moransI = image.reduceRegion({

reducer: ee.Reducer.moranI(),

geometry: // 定义感兴趣的区域,

scale: 30 // 应用的空间分辨率

});

// 输出Moran's I指数及其Z评分和P值

print('Moran\'s I:', moransI);

// 代码逻辑的逐行解读分析:

// 这段代码使用了Google Earth Engine JavaScript API计算Moran's I指数。

// reduceRegion方法用于在指定的区域和尺度上应用Moran's I指数计算。

// 最后,计算结果被打印出来,包括Moran's I指数、Z评分和P值,以评估空间自相关性。

```

### 3.3.2 空间模式分析与空间关系提取

空间模式分析帮助我们识别地物的分布和聚集模式,空间关系提取则是从空间数据中抽取特征和关联性。

**空间模式分析示例**

```javascript

// Google Earth Engine JavaScript API

var image = ee.Image('LANDSAT/LC08/C01/T1_TOA/LC08_123032_20140515');

// 使用Getis-Ord Gi*进行热点分析

var hotspots = image.reduceRegion({

reducer: ee.Reducer.getisOrd('B4'),

geometry: // 定义感兴趣的区域,

scale: 30 // 应用的空间分辨率

});

// 输出热点分析结果

print('Hotspots:', hotspots);

// 代码逻辑的逐行解读分析:

// 通过Getis-Ord Gi*方法,这段代码识别了图像中的热点区域。

// reduceRegion方法用于在指定的区域和尺度上应用Getis-Ord Gi*分析。

// 最后,热点分析的结果被输出。

```

空间统计分析不仅包括上述方法,它还是一个包含更多技术的广阔领域,如克里金(Kriging)空间插值、空间聚类等,它们为研究地物空间分布提供了强大工具。

本章展示了遥感图像处理中的高级分析方法,涵盖了地物分类与变化检测、辐射定标与大气校正、以及空间统计分析三大核心主题。每一部分都提供了实际的代码示例和逻辑分析,帮助读者深入理解并掌握这些技术。下一章将介绍深度学习技术与GEE平台的结合应用,以及如何将这些高级分析方法与深度学习技术相融合,实现更高效的图像分析工作。

# 4. GEE与深度学习在图像分析中的应用

## 4.1 深度学习在遥感图像分类中的运用

### 4.1.1 深度学习框架的选择与搭建

在运用深度学习进行遥感图像分类时,首先需要选择合适的深度学习框架。目前流行的深度学习框架包括TensorFlow、PyTorch、Keras等。TensorFlow和PyTorch是两大主流框架,TensorFlow有良好的生态系统和部署工具,而PyTorch则因其动态计算图和易用性受到研究人员的青睐。

选择框架后,接下来是搭建工作环境。以TensorFlow为例,首先安装基础包及其深度学习API,如:

```bash

pip install tensorflow-gpu

```

此命令安装了支持GPU加速的TensorFlow版本,对于遥感图像处理来说,这一点至关重要,因为它可以显著减少模型训练的时间。

搭建好工作环境后,需要加载和预处理遥感图像数据集。一般而言,遥感图像数据集包含了多个波段的信息,因此数据预处理时需要进行归一化、标准化等操作,并可能需要将数据集拆分为训练集、验证集和测试集。

### 4.1.2 训练集的构建与模型评估

构建训练集是深度学习模型训练的重要步骤。对于遥感图像分类任务,训练集的构建通常需要标注图像中的地物类型。标注工作可以通过目视解译来完成,或者使用一些半自动化的工具来辅助。例如,在GEE平台上,可以利用其提供的API来收集图像的标签信息。

模型评估是验证模型性能的关键环节。常用的评估指标包括准确率、精确率、召回率和F1分数等。根据任务的不同,还可能包括混淆矩阵、ROC曲线等其他指标。准确率是分类器正确预测的样本数与总样本数之比,而精确率和召回率则提供了对预测准确性的不同视角。

以下是一个使用TensorFlow构建和训练简单卷积神经网络(CNN)模型的代码示例:

```python

import tensorflow as tf

# 构建模型

model = tf.keras.models.Sequential([

tf.keras.layers.Conv2D(32, (3, 3), activation='relu', input_shape=(32, 32, 3)),

tf.keras.layers.MaxPooling2D((2, 2)),

tf.keras.layers.Conv2D(64, (3, 3), activation='relu'),

tf.keras.layers.MaxPooling2D((2, 2)),

tf.keras.layers.Conv2D(64, (3, 3), activation='relu'),

tf.keras.layers.Flatten(),

tf.keras.layers.Dense(64, activation='relu'),

tf.keras.layers.Dense(10, activation='softmax')

])

# 编译模型

model.compile(optimizer='adam',

loss='sparse_categorical_crossentropy',

metrics=['accuracy'])

# 模型训练(此处假设有训练数据和标签train_images, train_labels)

model.fit(train_images, train_labels, epochs=10, validation_data=(val_images, val_labels))

# 模型评估

test_loss, test_acc = model.evaluate(test_images, test_labels)

print('Test Accuracy:', test_acc)

```

在上述代码中,我们定义了一个简单的CNN模型,并展示了如何编译和训练该模型。训练完成后,我们使用测试集来评估模型的性能,输出测试集上的准确率。

## 4.2 遥感图像目标检测与分割

### 4.2.1 目标检测算法与实例

遥感图像目标检测的目的是识别图像中特定类别的对象,并给出它们的位置和类别。传统的目标检测算法如R-CNN、Fast R-CNN、Faster R-CNN等在早期得到了广泛应用,但它们的运行速度较慢。

随着深度学习的发展,基于卷积神经网络的目标检测算法得到了迅速发展,如YOLO(You Only Look Once)和SSD(Single Shot MultiBox Detector)。YOLO系列以其高精度和高速度在实时目标检测任务中尤为突出。YOLO算法将目标检测任务转化为一个单一的回归问题,直接从图像像素到边界框坐标和类别概率的映射。

以下是使用YOLOv3进行遥感图像目标检测的示例代码:

```python

import torch

import numpy as np

from PIL import Image

# 加载预训练的YOLOv3模型

model = torch.hub.load('ultralytics/yolov3', 'yolov3')

# 对遥感图像进行目标检测

img = Image.open('remote_sensing_image.jpg')

results = model(img)

# 解析检测结果

results.print()

results.show()

# 获取检测到的目标的坐标和类别信息

for *xyxy, conf, cls in results.xyxy[0]:

print(xyxy, conf, cls)

```

在该代码中,我们首先使用`torch.hub`加载了预训练的YOLOv3模型,然后用该模型对一张遥感图像进行目标检测。模型输出包含了检测到的每个目标的边界框坐标、置信度和类别信息。

### 4.2.2 图像分割技术的创新应用

图像分割是将图像分割成多个区域或对象的过程,每个区域具有特定的属性。深度学习中的全卷积网络(FCN)是实现图像分割的常用方法之一。FCN能够输出与输入图像具有相同尺寸的分割图,使得每个像素都被标记为特定的类别。

近年来,U-Net和它的变种由于其强大的分割能力在医学图像分割领域取得了巨大成功。U-Net的结构具有对称性,并采用了跳跃连接(skip connection),能够有效地解决图像分割中的下采样信息丢失问题。

以下是使用U-Net进行遥感图像分割的代码示例:

```python

import segmentation_models as sm

# 定义模型

model = sm.Unet('resnet34', classes=4, activation='softmax')

# 编译模型

model.compile('Adam', 'categorical_crossentropy', ['accuracy'])

# 训练模型

model.fit(X_train, y_train, batch_size=4, epochs=10)

# 进行预测

preds = model.predict(X_test)

```

在这段代码中,我们首先导入了segmentation_models库来定义一个U-Net模型,并指定使用resnet34作为预训练模型。之后,我们编译并训练模型,最后进行预测并得到分割结果。

## 4.3 结合深度学习的图像变化检测

### 4.3.1 深度学习用于变化检测的方法

图像变化检测旨在识别随时间变化的区域。利用深度学习技术,可以通过比较不同时间点的图像对,自动检测出变化区域。在变化检测任务中,常用的深度学习网络有Siamese网络和孪生网络等。Siamese网络通过共享参数的两个相同的子网络对输入图像对进行特征提取,并比较两者的特征差异来判断是否存在变化。

以下是一个使用孪生网络进行图像变化检测的伪代码示例:

```python

from keras.models import Model

from keras.layers import Input, Conv2D, Subtract, Flatten, Dense

# 定义孪生网络结构

input_a = Input(shape=(height, width, channels))

input_b = Input(shape=(height, width, channels))

# 构建两个相同的卷积网络分支

conv_a = Conv2D(64, (3,3))(input_a)

conv_b = Conv2D(64, (3,3))(input_b)

# 通过Subtract层计算特征差异

sub_layer = Subtract()([conv_a, conv_b])

# 进行全连接层分析

flatten = Flatten()(sub_layer)

dense = Dense(1, activation='sigmoid')(flatten)

# 创建模型

model = Model(inputs=[input_a, input_b], outputs=dense)

# 编译模型

model.compile(loss='binary_crossentropy', optimizer='adam', metrics=['accuracy'])

# 训练模型

model.fit([X_train_a, X_train_b], y_train, batch_size=4, epochs=10)

# 进行预测

preds = model.predict([X_test_a, X_test_b])

```

在这段伪代码中,我们首先导入了Keras相关的模块,并定义了孪生网络的结构。该网络包括两个相同的卷积子网络和一个Subtract层来计算特征差异。之后,我们编译并训练了该模型,并进行预测以确定图像对是否存在变化。

### 4.3.2 实际案例分析与比较

实际案例分析对于理解深度学习在变化检测中的应用至关重要。案例通常涉及多个时间点的遥感图像,通过深度学习模型,我们可以自动地检测出地物类别在不同时间点的变化情况。

为了比较不同深度学习模型在图像变化检测中的效果,可以对比Siamese网络和孪生网络的表现。Siamese网络更侧重于特征相似度的比较,而孪生网络则更侧重于特征差异的分析。

以下是一个实际案例的分析和比较的简要说明:

假设我们有一个包含两组图像(同一地点的不同时间点)的数据集,并且我们知道在这些图像中有变化发生。我们分别应用Siamese网络和孪生网络来分析这些数据。

首先,我们使用Siamese网络训练一个特征提取器,然后比较同一地点不同时期的图像对特征相似度。接着,我们使用孪生网络,训练得到两个相同的特征提取分支,并比较同一地点不同时期的图像对特征差异。

实验结果表明,孪生网络在识别细节变化方面表现出色,而Siamese网络则在大尺度的变化识别上更为准确。这表明两种网络在实际应用中各有优势,选择哪种网络应根据具体的应用需求和数据特性来决定。

通过这些比较,我们可以得出结论:深度学习技术可以显著提升遥感图像变化检测的自动化和准确性。而不同网络结构的应用,更是进一步丰富了这一领域的研究方向和技术应用。

# 5. GEE数据处理实战案例与优化

## 5.1 实战案例分析:森林覆盖变化监测

### 5.1.1 案例研究的背景与目标

森林覆盖变化监测是环境监测和保护的重要组成部分,有助于评估森林资源的健康状况和可持续利用。本案例将展示如何使用Google Earth Engine (GEE) 平台,借助遥感数据监测一定时间跨度内的森林覆盖变化情况。

通过卫星遥感图像,我们可以获得森林覆盖的变化数据,这些数据可作为制定森林保护政策和监测森林资源变化的依据。监测的目标包括但不限于:检测森林砍伐的热点区域、评估森林恢复情况以及分析不同时间段内的森林覆盖动态。

### 5.1.2 数据预处理与分析流程

数据预处理是森林覆盖变化监测的第一步,其目的是为了消除干扰因素,提取出真正有用的森林信息。以下是数据预处理和分析流程的基本步骤:

1. **选择合适的时间段和卫星数据**:根据研究目标选择适当的卫星数据源(例如Landsat、Sentinel等)和时间范围。在本案例中,我们将使用Landsat 8的多时相数据。

2. **云遮蔽处理**:由于云层会影响森林信息的准确提取,因此需要对云层进行掩蔽处理。GEE提供了多种算法进行云遮蔽的识别和处理,可以有效降低云层影响。

3. **归一化植被指数(NDVI)的计算**:为了识别森林区域,计算每个像素点的NDVI值是常用的方法。NDVI值可以帮助我们区分植被和非植被区域。

```javascript

var ndvi =影像集.select(['B5', 'B4']).reduce(ee.Reducer.neq(0)).expression(

'(nir - red) / (nir + red)', {

red:影像集.select('B4'),

nir:影像集.select('B5')

});

```

4. **森林覆盖变化检测**:通过比较不同时间点的NDVI值,可以检测出森林覆盖的变化区域。变化区域将被分类为森林增加或减少。

5. **可视化和验证**:最终,将变化检测结果进行可视化展示,并选择样本点进行实地验证,以确保变化检测的准确度。

## 5.2 数据处理性能优化策略

### 5.2.1 代码效率提升的方法

在进行大量的遥感图像处理时,代码的执行效率直接影响到分析的时效性。以下是一些提升GEE代码效率的方法:

1. **使用映射(Map)和减少(Reduce)函数**:充分利用GEE的并行处理能力,通过映射和减少操作来处理图像集合。

2. **减少数据载入量**:通过筛选特定波段、设置空间范围和时间范围,减少不必要的数据载入。

3. **缓存中间结果**:对于需要多次使用的中间结果,可以先进行计算并缓存,以避免重复计算。

4. **利用服务器端函数**:一些图像处理函数已经内置在GEE服务器端,使用这些函数比自定义客户端函数更为高效。

### 5.2.2 并行计算与云端资源利用

GEE提供了强大的云端计算能力,利用这一特点可以显著提升处理速度:

1. **并行计算**:GEE天然支持并行计算,可以通过多线程并行执行多个任务,使得处理速度提升。

2. **资源调度**:在GEE中合理安排资源分配,确保有足够的云端资源用于执行复杂的图像处理任务。

3. **结果输出优化**:在输出结果时,选择合适的数据格式和分辨率,以减少网络传输时间。

## 5.3 分享与展望:GEE与遥感分析的未来

### 5.3.1 社区分享与协作的平台

GEE社区为遥感分析工作者提供了一个分享和协作的平台。开发者和研究人员可以在这里发布他们的工具、脚本和分析结果,促进知识的交流与传播。同时,社区也鼓励用户将自己遇到的问题和解决方案共享出来,进一步推动遥感分析技术的发展。

### 5.3.2 遥感分析技术的发展趋势

随着机器学习和深度学习技术的融合,未来遥感分析将更加智能化。高时间分辨率的卫星数据的出现,将使得我们可以进行更为频繁和精细的监测。此外,随着5G网络技术的发展,遥感数据的实时处理和传输也将成为可能。

通过本章节的实战案例分析和优化策略的讨论,我们可以看到GEE在遥感数据处理中的巨大潜力和广阔的应用前景。遥感分析技术的发展将进一步推动环境监测、城市规划、灾害预防等领域的进步。

0

0