LRU缓存淘汰策略:数据结构中的智能管理术

发布时间: 2025-01-06 01:10:07 阅读量: 8 订阅数: 15

Java实现LRU缓存机制:深入解析与高效编码实践

# 摘要

本文综合介绍了LRU(最近最少使用)缓存淘汰策略的基本原理、实现方式及应用。首先概述了LRU策略,然后深入分析了其工作机制、数据结构应用和与其他策略的比较。第三章着重于编程实践,探讨了使用不同编程语言原生数据结构实现LRU缓存的方法,以及手动实现LRU缓存的细节和并发安全性问题。在第四章中,通过案例分析展示了LRU策略在实际应用中的设计优化,特别是在Web缓存和内存管理中的实践。最后,本文探讨了分布式LRU缓存设计挑战、LRU策略的优化方向以及未来可能的发展趋势,包括机器学习和非易失性内存对LRU策略的影响。

# 关键字

LRU缓存;算法原理;数据结构;编程实践;内存管理;分布式系统

参考资源链接:[数据结构与算法学习指南:刘斌教授讲解](https://wenku.csdn.net/doc/55y4kz8bct?spm=1055.2635.3001.10343)

# 1. LRU缓存淘汰策略概述

在现代计算机系统中,缓存淘汰策略是优化性能的重要手段之一。其中,最近最少使用(Least Recently Used, LRU)策略因其高效性和普遍适用性,被广泛应用于各种缓存系统中。LRU的基本思想是优先淘汰最长时间未被访问的数据,以此保证缓存中存储的是最“新鲜”的数据,提高命中率,从而加速数据检索速度。

## 1.1 LRU缓存淘汰策略的重要性

缓存的作用是减少数据访问延迟和降低数据库或磁盘的I/O操作频率。有效的缓存策略可以显著提高系统的整体性能。LRU策略作为缓存淘汰方法的代表,能够很好地平衡缓存的命中率和存储成本,是很多系统设计不可或缺的一部分。

## 1.2 LRU策略的工作原理简介

LRU策略依赖于“时间局部性”原理,即被访问的数据在近期内可能被再次访问。因此,系统维护着数据的访问顺序,当缓存满时,移除最久未被访问的元素,为新数据腾出空间。这个策略的核心在于保持数据的“新鲜度”,确保缓存能够有效地服务即将到来的请求。

在后续的章节中,我们将深入探讨LRU算法的基本原理和实现方式,分析其在不同编程语言中的应用,并讨论LRU缓存在实际应用中遇到的问题及其优化策略。通过这些内容,我们期望帮助读者全面了解LRU缓存淘汰策略,并在实际工作中有效利用这一技术。

# 2. LRU算法的基本原理和实现

在第一章中,我们概览了LRU(Least Recently Used)缓存淘汰策略的基础知识。现在,让我们深入探讨LRU算法的工作原理,并了解如何在数据结构中实现它,以及如何与其他缓存策略进行比较。

## 2.1 LRU算法的工作机制

### 2.1.1 缓存的维护和数据访问

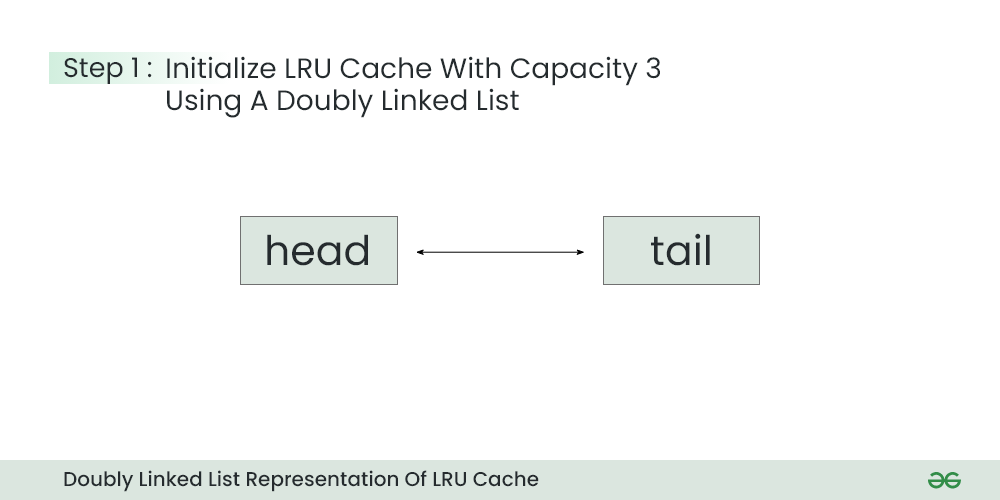

LRU算法的核心在于维护一个有序的数据结构,通常是一个双向链表,其中包含了缓存的所有数据项。链表的头部是最近最少使用的项,尾部是最近使用过的项。当数据项被访问时,它会被移动到链表的尾部,表示它是最近使用过的。

具体来说,当缓存中发生读操作时,如下步骤会被执行:

- 如果数据项存在于缓存中(缓存命中),则将其从当前位置移动到链表尾部,表示最近被访问。

- 如果数据项不在缓存中(缓存未命中),则从链表尾部移除最近最少使用的项,并将新数据项添加到链表尾部。

当缓存发生写操作时,通常也需要更新缓存中的数据项,并将其移动到链表尾部。

```python

class LRUCache:

def __init__(self, capacity):

self.cache = OrderedDict()

self.capacity = capacity

def get(self, key):

if key not in self.cache:

return -1

else:

self.cache.move_to_end(key) # 将键移到有序字典的末尾表示最近使用

return self.cache[key]

def put(self, key, value):

if key in self.cache:

self.cache.move_to_end(key)

self.cache[key] = value

if len(self.cache) > self.capacity:

self.cache.popitem(last=False) # 删除最不常用的键值对

```

### 2.1.2 淘汰策略的逻辑流程

淘汰策略遵循以下逻辑流程:

1. 初始化一个固定大小的缓存结构。

2. 当缓存未满时,新数据项可以无条件地插入。

3. 当缓存满时,根据LRU原则删除链表头部的数据项。

4. 每次数据访问后,更新数据项的位置到链表尾部。

该流程确保了缓存中始终保持最常使用的数据项,而淘汰最不常用的数据项。在实际应用中,这可以帮助系统维护最佳的访问效率和最小的延迟。

## 2.2 LRU算法在数据结构中的应用

### 2.2.1 双向链表+哈希表的实现方式

LRU算法最经典的实现方式是结合使用双向链表和哈希表。双向链表允许我们在常数时间内将元素移动到链表尾部,哈希表则提供了快速的查找功能。

双向链表的特点:

- 允许在常数时间内添加、删除和移动节点。

- 每个节点存储键值对,节点之间相互链接,形成一条双向链。

哈希表的特点:

- 提供快速的查找功能,可以通过键直接定位到数据项。

- 键和节点在双向链表中的位置同步更新。

结合使用这两种数据结构,我们可以实现一个既快速又有效的LRU缓存。在Python中,`OrderedDict`为这种实现提供了一个很好的抽象。

```python

from collections import OrderedDict

# OrderedDict内部使用双向链表+哈希表实现

cache = OrderedDict()

def access_data(key):

if key in cache:

cache.move_to_end(key) # 如果存在,移动到尾部

else:

if len(cache) >= self.capacity:

cache.popitem(last=False) # 如果缓存满了,删除头部

cache[key] = data[key] # 添加新元素到尾部

```

### 2.2.2 时间复杂度分析

时间复杂度是衡量算法效率的重要指标。对于LRU算法来说,其主要操作包括访问数据项、插入数据项和删除数据项。

- 查找操作的时间复杂度:在哈希表中,查找操作的时间复杂度为O(1)。

- 插入操作的时间复杂度:在双向链表中,插入操作的时间复杂度为O(1)。

- 删除操作的时间复杂度:同样在双向链表中,删除操作的时间复杂度也为O(1)。

因此,总体来说,LRU算法的实现可以达到O(1)的时间复杂度,这是它在实际应用中非常受欢迎的原因之一。

## 2.3 LRU算法与其它缓存策略的比较

### 2.3.1 FIFO和LFU策略简介

LRU策略并不是唯一的缓存淘汰策略,还有其它策略如FIFO(先进先出)和LFU(最不常使用)等。

- **FIFO**策略简单地按照数据项进入缓存的时间顺序来决定淘汰哪一项,最早进入的数据项会被淘汰。

- **LFU**策略则淘汰访问次数最少的数据项,即长期未被访问的数据项会被淘汰。

这些策略都旨在为缓存系统提供一种机制,来平衡内存的使用和访问效率。

### 2.3.2 LRU算法的优势和局限性

LRU算法相较于FIFO和LFU等策略,其优势在于考虑了数据项的时间局部性原理。即被频繁访问的数据项在最近的将来也很可能会再次被访问。因此,LRU算法能够在大多数场景中提供更好的性能。

然而,LRU算法也有局限性,主要体现在:

- **实现复杂度**:相比简单的FIFO,LRU的实现更为复杂。

- **内存占用**:需要额外的数据结构来维护数据项的使用顺序。

- **缓存污染问题**:在某些特定的访问模式下,如周期性的数据访问,LRU可能不如LFU有效。

在实际应用中,开发者需要根据系统的具体需求和数据访问模式来选择最合适的缓存策略。

以上章节详细介绍了LRU算法的基本原理和实现方式,以及与其他策略的比较。接下来,我们将探索如何在编程实践中实现LRU缓存,并分析其在实际应用中的案例。

# 3. LRU缓存的编程实践

## 3.1 使用语言原生数据结构实现LRU缓存

### 3.1.1 Python的OrderedDict应用

Python的`collections`模块提供了一个`OrderedDict`类,它是一个特殊的字典,保持了元素被添加的顺序。这一特性使得`OrderedDict`非常适合用来实现LRU缓存,因为我们可以快速地定位并移除最久未使用(Least Recently Used,LRU)的元素。

下面是一个简单的`OrderedDict`实现LRU缓存的例子:

```python

from collections import OrderedDict

class LRUCache(OrderedDict):

def __init__(self, capacity: int):

self.capacity = capacity

def get(self, key: int) -> int:

if key not in self:

return -1

self.move_to_end(key) # 将访问的键移动到有序字典的末尾

return self[key]

def put(self, key: int, value: int) -> None:

if key in self:

self.move_to_end(key)

self[key] = value

if len(self) > self.capacity: # 如果超过了缓存容量,移除最久未使用的元素

self.popitem(last=False)

cache = LRUCache(2) # 初始化一个容量为2的LRU缓存

cache.put(1, 1)

cache.put(2, 2)

print(cache.get(1)) # 返回1

cache.put(3, 3) # 该操作会使得键2作废

print(cache.get(2)) # 返回-1 (未找到)

cache.put(4, 4) # 该操作会使得键1作废

print(cache.get(1)) # 返回-1 (未找到)

print(cache.get(3)) # 返回3

print(cache.get(4)) # 返回4

```

在这个例子中,`LRUCache`类封装了一个`OrderedDict`对象。`get`方法用于获取键对应的值,并将该键移动到字典的末尾以表示最近被访问。`put`方法用于添加或更新键值对,如果键已存在,则同样将其移动到字典的末尾。如果缓存的大小超出了其容量,则移除最久未使用的元素。

### 3.1.2 Java的LinkedHashMap应用

Java的`LinkedHashMap`类是`HashMap`的一个子类,它通过维护一个双向链表来保持元素的插入顺序或访问顺序。默认情况下,`LinkedHashMap`按插入顺序维护元素,但如果在构造器中将其第二个参数设置为`true`,则可以按访问顺序来维护元素,这正好符合LRU缓存的要求。

下面是一个`LinkedHashMap`实现LRU缓存的例子:

```java

import java.util.LinkedHashMap;

import java.util.Map;

public class LRUCache<K, V> extends LinkedHashMap<K, V> {

private final int capacity;

pub

```

0

0