【机器学习入门宝典】:揭秘机器学习的奥秘,开启人工智能之旅

发布时间: 2024-07-08 16:26:10 阅读量: 59 订阅数: 29

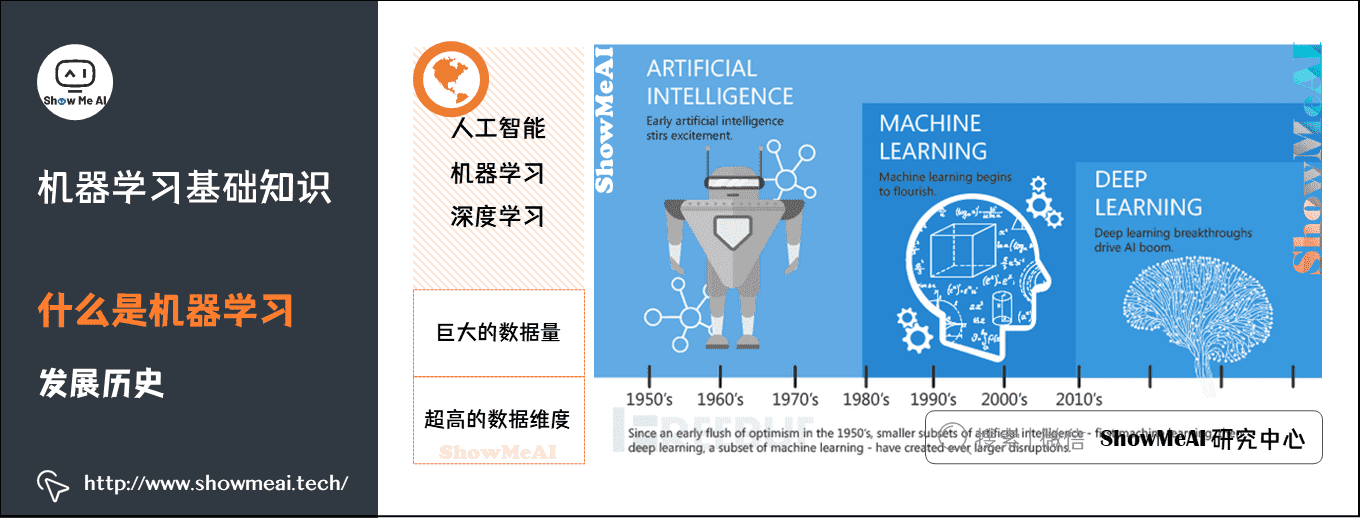

# 1. 机器学习概述**

机器学习是一种人工智能技术,它使计算机能够从数据中学习,而无需明确编程。它涉及算法的开发,这些算法可以识别模式、预测结果并做出决策。机器学习在各个领域都有广泛的应用,包括计算机视觉、自然语言处理和预测分析。

机器学习算法可以分为有监督学习、无监督学习和强化学习。有监督学习算法使用标记数据进行训练,其中输入和输出都已知。无监督学习算法使用未标记数据进行训练,其中只有输入已知。强化学习算法通过与环境交互并接收奖励或惩罚来学习。

# 2. 机器学习基础

### 2.1 机器学习算法类型

机器学习算法根据其学习方式可分为三类:有监督学习、无监督学习和强化学习。

#### 2.1.1 有监督学习

有监督学习算法从带标签的数据中学习,其中标签表示数据的正确输出。算法的目标是学习一个模型,该模型可以将输入数据映射到其相应的标签。

**例子:**

* 分类:预测数据点属于特定类别的概率。

* 回归:预测连续值。

#### 2.1.2 无监督学习

无监督学习算法从未标记的数据中学习,即没有正确输出的数据。算法的目标是发现数据中的模式和结构。

**例子:**

* 聚类:将数据点分组到具有相似特征的组中。

* 降维:减少数据点的维度,同时保留其重要特征。

#### 2.1.3 强化学习

强化学习算法从环境中学习,通过采取行动并获得奖励或惩罚来优化其行为。算法的目标是学习一个策略,该策略可以最大化长期奖励。

**例子:**

* 游戏 AI:学习如何玩游戏并取得最佳成绩。

* 机器人控制:学习如何控制机器人执行任务。

### 2.2 机器学习模型评估

机器学习模型的评估对于确定其性能和可靠性至关重要。常用的评估指标包括:

#### 2.2.1 准确率和召回率

**准确率:**正确预测的样本数与所有样本数之比。

**召回率:**正确预测的正样本数与所有正样本数之比。

#### 2.2.2 精度和查准率

**精度:**正确预测的正样本数与所有被预测为正样本数之比。

**查准率:**正确预测的正样本数与所有实际为正样本数之比。

#### 2.2.3 ROC曲线和AUC

**ROC曲线:**受试者工作特征曲线,绘制真实正例率与虚假正例率之间的关系。

**AUC:**ROC曲线下面积,表示模型区分正负样本的能力。

**代码示例:**

```python

from sklearn.metrics import accuracy_score, recall_score, precision_score, roc_auc_score

# 预测标签

y_pred = model.predict(X_test)

# 计算评估指标

accuracy = accuracy_score(y_test, y_pred)

recall = recall_score(y_test, y_pred)

precision = precision_score(y_test, y_pred)

auc = roc_auc_score(y_test, y_pred)

# 打印评估结果

print("准确率:", accuracy)

print("召回率:", recall)

print("精度:", precision)

print("AUC:", auc)

```

**逻辑分析:**

* `accuracy_score`计算准确率,即正确预测的样本数除以所有样本数。

* `recall_score`计算召回率,即正确预测的正样本数除以所有正样本数。

* `precision_score`计算精度,即正确预测的正样本数除以所有被预测为正样本数。

* `roc_auc_score`计算AUC,即ROC曲线下面积,表示模型区分正负样本的能力。

# 3.1 数据预处理

数据预处理是机器学习实践中至关重要的一步,它可以提高模型的性能和准确性。数据预处理主要包括数据清洗和特征工程两个过程。

#### 3.1.1 数据清洗

数据清洗旨在处理数据中的错误、缺失值和异常值。常见的清洗技术包括:

- **处理缺失值:**可以使用均值、中位数或众数来填充缺失值,也可以删除包含大量缺失值的样本。

- **处理异常值:**异常值可能会对模型产生负面影响,可以使用阈值、Z分数或基于密度的算法来检测和删除异常值。

- **处理重复值:**重复值会增加数据的冗余性,可以使用唯一索引或哈希表来删除重复值。

- **处理不一致性:**数据中的不一致性可能会导致错误的结论,可以使用数据验证和清洗规则来确保数据的一致性。

#### 3.1.2 特征工程

特征工程是将原始数据转换为模型可用的特征的过程。常见的特征工程技术包括:

- **特征选择:**从原始数据中选择与目标变量最相关的特征,可以提高模型的性能和可解释性。

- **特征转换:**将原始特征转换为不同的形式,例如对数转换、标准化或二值化,可以改善模型的拟合度。

- **特征创建:**通过组合或转换原始特征创建新的特征,可以丰富数据集并提高模型的预测能力。

- **特征降维:**使用主成分分析(PCA)或奇异值分解(SVD)等技术将高维特征空间降维到低维空间,可以减少计算复杂度和提高模型的泛化能力。

**示例:**

以下是一个数据清洗和特征工程的示例:

```python

import pandas as pd

# 读取数据

data = pd.read_csv('data.csv')

# 处理缺失值

data['age'].fillna(data['age'].mean(), inplace=True)

# 处理异常值

data = data[(data['age'] > 18) & (data['age'] < 100)]

# 处理重复值

data = data.drop_duplicates()

# 处理不一致性

data['gender'] = data['gender'].str.lower()

# 特征选择

selected_features = ['age', 'gender', 'income']

# 特征转换

data['age'] = np.log(data['age'])

# 特征创建

data['age_group'] = pd.cut(data['age'], bins=[18, 30, 45, 60, 100], labels=['18-30', '30-45', '45-60', '60+'])

# 特征降维

pca = PCA(n_components=2)

data = pca.fit_transform(data[selected_features])

```

通过这些数据预处理步骤,原始数据被转换为一个干净且可用的数据集,可以用于机器学习模型的训练。

# 4. 机器学习进阶

### 4.1 机器学习超参数调优

超参数是机器学习模型中不可训练的参数,它们决定了模型的结构和训练过程。超参数调优是找到一组最优超参数的过程,以最大化模型的性能。

**4.1.1 手动调优**

手动调优是一种逐个调整超参数并评估模型性能的方法。这种方法需要大量的实验和经验,但可以提供对模型的深入了解。

```python

# 导入必要的库

import numpy as np

import pandas as pd

from sklearn.model_selection import GridSearchCV

from sklearn.svm import SVC

# 加载数据

data = pd.read_csv('data.csv')

# 定义超参数网格

param_grid = {'C': np.logspace(-3, 3, 5), 'gamma': np.logspace(-3, 3, 5)}

# 创建网格搜索对象

grid_search = GridSearchCV(SVC(), param_grid, cv=5)

# 拟合网格搜索对象

grid_search.fit(data.drop('target', axis=1), data['target'])

# 获取最优超参数

best_params = grid_search.best_params_

# 重新训练模型使用最优超参数

model = SVC(**best_params)

model.fit(data.drop('target', axis=1), data['target'])

```

**4.1.2 自动调优**

自动调优使用优化算法自动搜索最优超参数。这种方法可以节省时间和精力,但可能无法提供与手动调优相同级别的控制。

```python

# 导入必要的库

import optuna

# 定义目标函数

def objective(trial):

# 获取超参数

C = trial.suggest_loguniform('C', 1e-3, 1e3)

gamma = trial.suggest_loguniform('gamma', 1e-3, 1e3)

# 创建模型

model = SVC(C=C, gamma=gamma)

# 训练模型

model.fit(data.drop('target', axis=1), data['target'])

# 计算模型性能

accuracy = model.score(data.drop('target', axis=1), data['target'])

# 返回模型性能

return accuracy

# 创建优化器

optimizer = optuna.create_study(direction='maximize')

# 运行优化

optimizer.optimize(objective, n_trials=100)

# 获取最优超参数

best_params = optimizer.best_params

```

### 4.2 机器学习模型解释

机器学习模型解释旨在了解模型的决策过程和预测结果背后的原因。这对于确保模型的可靠性和可解释性至关重要。

**4.2.1 特征重要性分析**

特征重要性分析识别对模型预测影响最大的特征。这有助于理解模型的决策过程并确定最重要的输入变量。

```python

# 导入必要的库

from sklearn.feature_selection import SelectKBest

from sklearn.feature_selection import chi2

# 创建特征选择器

selector = SelectKBest(chi2, k=5)

# 拟合特征选择器

selector.fit(data.drop('target', axis=1), data['target'])

# 获取特征重要性分数

feature_importances = selector.scores_

# 打印特征重要性分数

print(feature_importances)

```

**4.2.2 SHAP值解释**

SHAP(Shapley Additive Explanations)值解释是另一种解释模型预测的局部方法。它通过计算每个特征对预测的影响来解释模型的输出。

```python

# 导入必要的库

import shap

# 创建 SHAP 解释器

explainer = shap.TreeExplainer(model)

# 计算 SHAP 值

shap_values = explainer.shap_values(data.drop('target', axis=1))

# 可视化 SHAP 值

shap.plots.waterfall(shap_values[0])

```

### 4.3 机器学习异常检测

异常检测是识别与正常数据模式不同的数据点。这对于欺诈检测、网络安全和故障诊断等应用至关重要。

**4.3.1 异常检测算法**

有许多异常检测算法,包括:

* **k-最近邻 (k-NN)**:识别与k个最相似邻居显着不同的数据点。

* **局部异常因子 (LOF)**:计算每个数据点与其邻居的局部密度,并识别密度明显较低的点。

* **孤立森林 (IF)**:构建一组随机决策树,并识别被树快速隔离的数据点。

**4.3.2 异常检测应用**

异常检测在许多领域都有应用,包括:

* **欺诈检测**:识别可疑的交易或活动。

* **网络安全**:检测网络攻击或入侵。

* **故障诊断**:识别设备或系统中的异常行为。

# 5.1 机器学习在各个领域的应用

机器学习在各个领域都有着广泛的应用,以下是几个主要应用领域:

- **医疗保健:**机器学习用于诊断疾病、预测治疗效果和开发个性化治疗方案。

- **金融:**机器学习用于欺诈检测、风险评估和投资组合优化。

- **制造业:**机器学习用于预测性维护、质量控制和供应链优化。

- **零售:**机器学习用于个性化推荐、客户细分和需求预测。

- **交通:**机器学习用于交通优化、事故检测和自动驾驶。

- **农业:**机器学习用于作物产量预测、病虫害检测和精准农业。

- **能源:**机器学习用于可再生能源预测、能源效率优化和电网管理。

- **教育:**机器学习用于个性化学习、学生评估和教育内容推荐。

- **安全:**机器学习用于网络安全、恶意软件检测和欺诈预防。

- **科学研究:**机器学习用于数据分析、模型构建和科学发现。

在这些领域中,机器学习被用于解决各种问题,从提高效率和准确性到自动化任务和提供新的见解。

0

0