【Python常见库深度剖析】:掌握common库核心功能,精通使用与优化策略

发布时间: 2024-10-08 11:52:42 阅读量: 30 订阅数: 40

# 1. Python常见库概述

Python作为一门功能强大的编程语言,它的魅力在于其庞大的标准库和第三方库生态系统。本章节将对Python中常见的库进行一个概览性的介绍,帮助读者快速了解这些库的用途和功能,为深入学习和使用它们打下基础。

Python的标准库提供了丰富的模块和函数,涵盖了从字符串处理、数学运算到文件操作等多方面的功能。同时,第三方库的广泛支持也使得Python在数据分析、机器学习、网络开发等领域表现出色。

简单来说,Python库可以分为几大类:基础库,这类库属于Python标准发行版的一部分,是Python语言的骨架;第三方库,这类库需要额外安装,它们极大地扩展了Python的功能;以及一些新兴的库,这些库处于不断更新发展的状态中,为Python带来新的特性和应用。

例如,在数据分析领域,Pandas库提供了易于使用的数据结构和数据分析工具;而在Web开发方面,Flask和Django是两个非常流行的Python框架。这些库极大地丰富了Python的应用场景,让Python在各个行业中的应用变得更为广泛。

让我们开始探索Python丰富的库资源,发现它们如何简化开发过程、提高效率,并在第二章深入分析Python基础库的核心组件与实用操作。

# 2. Python基础库深入解析

## 2.1 标准库核心组件

### 2.1.1 内置数据结构解析

Python的标准库中包含了一些高效的内置数据结构,如列表、元组、字典和集合等。这些数据结构是Python编程的基础,并且在大多数程序中扮演着重要的角色。

列表(List)是一种有序的集合,可以随时添加和删除其中的元素:

```python

# 示例代码:列表操作

fruits = ['apple', 'banana', 'cherry'] # 列表创建

fruits.append('orange') # 添加元素

fruits.remove('banana') # 删除元素

print(fruits[0]) # 访问元素

```

元组(Tuple)是另一种有序列表,但是一旦创建便不可修改,它们通常用来确保数据不被改变:

```python

# 示例代码:元组操作

point = (10, 20) # 元组创建

print(point[0] + point[1]) # 元组中元素的访问

```

字典(Dictionary)是无序的键值对集合,每个键唯一对应一个值:

```python

# 示例代码:字典操作

person = {'name': 'Alice', 'age': 25} # 字典创建

print(person['name']) # 访问字典中的值

```

集合(Set)是无序的且元素唯一的集合,适合进行成员资格测试和消除重复元素:

```python

# 示例代码:集合操作

ab = set('abracadabra')

print(ab) # 输出集合内容

```

这些内置数据结构在不同的应用领域发挥着不同的作用,例如,列表和元组通常用于存储数据集,字典用于映射和关联数据,集合用于处理不重复元素的场景。

### 2.1.2 基础算法和工具

Python的标准库还包含了许多基础算法和实用工具,其中 `math` 和 `statistics` 库提供了数学运算和统计分析相关的工具,`datetime` 和 `time` 库用于处理日期和时间,而 `random` 库则提供了随机数生成的功能。

`math` 库提供了常用的数学函数,例如:

```python

import math

# 示例代码:math库使用

print(math.sqrt(16)) # 计算平方根

print(math.ceil(4.2)) # 向上取整

```

`datetime` 库用于日期和时间的计算:

```python

import datetime

# 示例代码:datetime库使用

now = datetime.datetime.now() # 获取当前时间

print(now.strftime("%Y-%m-%d %H:%M:%S")) # 格式化日期时间输出

```

`random` 库生成随机数,它在进行数据模拟和算法测试时非常有用:

```python

import random

# 示例代码:random库使用

print(random.random()) # 生成一个[0.0, 1.0)之间的随机浮点数

print(random.randint(1, 10)) # 生成一个[1, 10]之间的随机整数

```

通过这些基础算法和工具的使用,开发者可以更容易地解决各种编程问题,编写出更高效的代码。

## 2.2 I/O操作与数据处理

### 2.2.1 文件读写和持久化

在程序中进行文件读写操作是常见需求,Python标准库中的 `open` 函数和文件对象为我们提供了便捷的方式来处理文件I/O。

基本文件读写操作如下:

```python

# 示例代码:文件写入与读取

with open('example.txt', 'w') as f: # 打开文件进行写入

f.write('Hello, Python!\n')

with open('example.txt', 'r') as f: # 打开文件进行读取

content = f.read()

print(content)

```

在文件操作中,通常会用到上下文管理器(通过`with`语句),这样可以保证在完成文件操作后自动关闭文件,避免文件资源泄露。

此外,Python支持以二进制模式读写文件:

```python

# 示例代码:二进制文件写入与读取

with open('example.bin', 'wb') as f:

f.write(b'\x00\x01\x02') # 写入二进制数据

with open('example.bin', 'rb') as f:

binary_data = f.read()

print(binary_data)

```

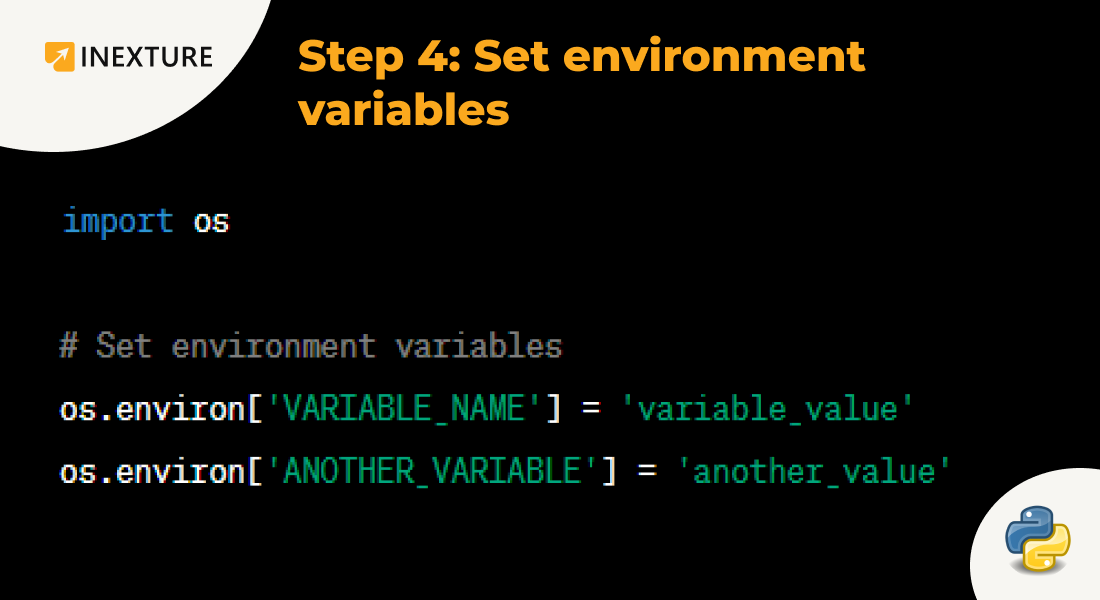

处理文件时,还经常使用`os`和`pathlib`库来进行路径操作,从而提高文件操作的灵活性:

```python

import os

from pathlib import Path

# 示例代码:使用os和pathlib库操作文件路径

file_path = os.path.join('path', 'to', 'your', 'file.txt') # os.path.join创建路径

path_object = Path('path/to/your/file.txt') # pathlib创建路径对象

print(path_object.exists()) # 检查文件是否存在

```

### 2.2.2 数据格式转换和处理

数据格式转换是数据处理过程中的重要环节,标准库中的`json`和`csv`模块可以帮助开发者轻松地处理JSON和CSV这两种常见数据格式。

JSON数据处理:

```python

import json

# 示例代码:处理JSON数据

data = {'name': 'John', 'age': 30, 'city': 'New York'}

json_data = json.dumps(data) # 将字典转换为JSON字符串

with open('data.json', 'w') as f:

f.write(json_data) # 写入JSON文件

with open('data.json', 'r') as f:

loaded_data = json.load(f) # 从JSON文件加载数据

print(loaded_data)

```

CSV数据处理:

```python

import csv

# 示例代码:处理CSV数据

with open('data.csv', 'w', newline='') as csv***

***

***['Name', 'Age', 'City'])

writer.writerow(['John', '30', 'New York'])

with open('data.csv', 'r') as csv***

***

***

***['Name'], row['Age'], row['City'])

```

通过这些标准库模块的使用,我们可以非常方便地处理多种数据格式,进而与外部系统进行数据交换。

## 2.3 网络通信与并行处理

### 2.3.1 网络协议支持库

Python标准库中的`socket`模块提供了底层网络通信的接口,使得网络编程变得简单。此外,`http.client`和`smtplib`模块分别提供了HTTP和SMTP协议的支持。

网络通信的实例:

```python

import socket

# 示例代码:socket网络通信

HOST, PORT = '***.*.*.*', 65432

with socket.socket(socket.AF_INET, socket.SOCK_STREAM) as s:

s.bind((HOST, PORT))

s.listen()

conn, addr = s.accept()

with conn:

print('Connected by', addr)

while True:

data = conn.recv(1024)

if not data:

break

conn.sendall(data)

```

HTTP通信的实例:

```python

import http.client

# 示例代码:http.client模块实现HTTP请求

conn = http.client.HTTPConnection("***")

conn.request("GET", "/")

response = conn.getresponse()

print(response.status, response.reason)

data = response.read()

print(data)

conn.close()

```

这些网络协议库简化了网络编程的复杂性,使得开发者可以专注于业务逻辑的实现。

### 2.3.2 多线程与多进程编程

为了提高程序的运行效率,Python通过`threading`和`multiprocessing`库支持了多线程和多进程编程。这允许程序同时执行多个任务,或者在多核处理器上并行处理任务。

多线程编程示例:

```python

import threading

def thread_function(name):

print(f'Thread {name}: starting')

# 假设这里是需要执行的任务

print(f'Thread {name}: finishing')

if __name__ == "__main__":

threads = list()

for index in range(3):

x = threading.Thread(target=thread_function, args=(index,))

threads.append(x)

x.start()

for index, thread in enumerate(threads):

thread.join()

print("Done")

```

多进程编程示例:

```python

import multiprocessing

def proc_function(name):

print(f'Process {name}: starting')

# 假设这里是需要执行的任务

print(f'Process {name}: finishing')

if __name__ == "__main__":

processes = list()

for index in range(3):

x = multiprocessing.Process(target=proc_function, args=(index,))

processes.append(x)

x.start()

for index, process in enumerate(processes):

process.join()

print("Done")

```

Python通过这些并行处理库能够充分利用现代计算硬件的能力,从而提升应用程序的性能和响应速度。

# 3. Python第三方库实践技巧

## 3.1 数据分析与科学计算

### 3.1.1 NumPy库的数组操作

在数据科学领域,NumPy库是一个不可或缺的工具,它提供了高性能的多维数组对象以及用于处理这些数组的工具集。NumPy的数组比Python原生的列表更加高效,它在内存中连续存储数据,有利于进行高效的数学运算。

#### 数组创建与操作

创建NumPy数组的典型方法包括使用`np.array`从列表或元组创建,或者使用`np.arange`、`np.linspace`等函数来生成。一旦创建,你可以对数组进行各种操作,如索引、切片、变形等。

```python

import numpy as np

# 从列表创建数组

a = np.array([1, 2, 3])

# 使用arange函数创建连续的数组

b = np.arange(10)

# 创建线性间隔的数组

c = np.linspace(0, 1, 5)

```

#### 高级索引与广播

NumPy的高级索引和广播功能允许对数组进行复杂的操作。索引可以是数组、列表或元组,而广播规则允许NumPy自动扩展形状较小的数组,以便与另一个数组进行操作。

```python

# 高级索引

index_arr = np.array([[0, 2], [1, 3]])

a = np.array([[1, 2], [3, 4]])

result = a[index_arr]

# 广播机制

x = np.array([1, 2, 3])

y = np.array([10])

result = x * y # [10, 20, 30]

```

### 3.1.2 Pandas的数据分析能力

Pandas是基于NumPy构建的,提供了快速、灵活且表达能力强的数据结构,专门用于数据分析。它引入了两种主要的数据结构:Series和DataFrame。Series是一维的数据结构,而DataFrame则是二维的表格型数据结构。

#### 数据结构

Series类似于NumPy的一维数组,但其可以存储不同的数据类型。DataFrame则是一个表格数据结构,可以看作是Series对象的容器。

```python

import pandas as pd

# 创建Series

s = pd.Series([1, 3, 5, np.nan, 6, 8])

# 创建DataFrame

df = pd.DataFrame({

'A': [1, 2, 3],

'B': [4, 5, 6]

})

```

#### 数据选择与过滤

Pandas提供了强大的数据选择和过滤功能,使用`.loc[]`和`.iloc[]`可以基于标签和基于整数位置的索引来选择数据。同时,Pandas支持复杂的布尔索引。

```python

# 使用loc选择标签

df.loc[:, ['A', 'B']]

# 使用iloc按位置选择

df.iloc[:, [1, 2]]

# 布尔索引

df[df['A'] > 2]

```

#### 数据清洗与预处理

Pandas能够处理丢失数据、数据合并、分组、透视表以及数据标准化等,这些功能对数据预处理至关重要。

```python

# 处理缺失数据

df.fillna(0) # 将所有缺失值填充为0

# 数据合并

pd.merge(df1, df2, on='key')

# 数据分组

df.groupby('A').sum()

```

### 3.1.3 Matplotlib绘图

Matplotlib是一个用于创建2D图表的库。无论是快速的查看数据、生成简单的统计图表,还是创建复杂的多层图表,Matplotlib都能提供丰富的工具来满足需求。

#### 基本绘图

Matplotlib的基本绘图接口非常直观。使用`plt.plot()`可以快速生成线图,`plt.scatter()`用于散点图。

```python

import matplotlib.pyplot as plt

# 绘制线图

plt.plot([1, 2, 3], [4, 5, 6])

# 绘制散点图

plt.scatter([1, 2, 3], [4, 5, 6])

plt.show()

```

#### 绘图对象和子图

Matplotlib支持面向对象的绘图接口,允许更细致地控制图表的各个方面。此外,子图功能允许在一个画布上创建多个图表。

```python

# 使用面向对象接口绘图

fig, ax = plt.subplots()

# 在一个画布上创建子图网格

fig, axs = plt.subplots(2, 2)

```

### 3.1.4 Seaborn与数据可视化

Seaborn构建在Matplotlib之上,提供了更高级的接口,专注于美观和统计图形。Seaborn简化了许多常见图形的创建,并增强了数据的可视化效果。

#### 统计分布图

Seaborn支持各种统计分布图,例如直方图、箱线图和核密度估计图等,这些图表对于数据分析非常有帮助。

```python

import seaborn as sns

# 绘制直方图

sns.histplot(df['A'])

# 绘制箱线图

sns.boxplot(x='A', data=df)

```

#### 分类变量的可视化

Seaborn还提供了针对分类数据的可视化方法,如点图和小提琴图等,这有助于分析分类数据。

```python

# 使用点图

sns.pointplot(x='A', y='B', data=df)

# 使用小提琴图

sns.violinplot(x='A', y='B', data=df)

```

## 3.2 机器学习与人工智能

### 3.2.1 Scikit-learn库的应用

Scikit-learn是一个开源的机器学习库,它提供简单而高效的工具,用于数据挖掘和数据分析。它支持多种常见的机器学习模型,如分类、回归、聚类等。

#### 基本机器学习工作流

Scikit-learn库的设计遵循一致的API,包括特征提取、模型选择、模型训练、预测和评估等步骤。

```python

from sklearn.datasets import load_iris

from sklearn.model_selection import train_test_split

from sklearn.neighbors import KNeighborsClassifier

from sklearn.metrics import accuracy_score

# 加载数据集

iris = load_iris()

X, y = iris.data, iris.target

# 划分训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.3, random_state=42)

# 训练模型

clf = KNeighborsClassifier(n_neighbors=5)

clf.fit(X_train, y_train)

# 预测和评估

y_pred = clf.predict(X_test)

print(accuracy_score(y_test, y_pred))

```

#### 特征工程与模型调优

特征工程是数据科学的一个重要环节,Scikit-learn提供了特征提取和选择的工具。同时,它还包括了交叉验证、网格搜索等用于模型调优的方法。

```python

from sklearn.feature_selection import SelectKBest

from sklearn.model_selection import GridSearchCV

# 特征选择

select = SelectKBest(k=2)

X_new = select.fit_transform(X, y)

# 模型调优

param_grid = {'n_neighbors': [3, 5, 7]}

grid_search = GridSearchCV(KNeighborsClassifier(), param_grid, cv=5)

grid_search.fit(X_train, y_train)

```

### 3.2.2 TensorFlow与Keras的深度学习框架

TensorFlow是一个开源的深度学习框架,由Google开发,它提供了强大的计算图和自动微分系统,能够支持复杂的神经网络模型。而Keras则是一个高级神经网络API,它能够在TensorFlow之上提供更简洁的接口。

#### TensorFlow的计算图与自动微分

TensorFlow的核心是计算图,它定义了运算的操作和数据流动。通过自动微分,TensorFlow能够高效地计算梯度,加速深度学习模型的训练。

```python

import tensorflow as tf

# 定义计算图

a = tf.constant(2.0)

b = tf.constant(3.0)

c = a * b

# 自动微分

with tf.GradientTape() as tape:

tape.watch(c)

d = c * c

grad = tape.gradient(d, c)

```

#### Keras的模型构建与训练

Keras提供了一个高级API,用于快速构建深度学习模型。它支持序列模型和函数式API两种模型构建方式,并提供了丰富的预定义层和优化器。

```python

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import Dense

# 使用序列模型构建简单的全连接网络

model = Sequential([

Dense(64, activation='relu', input_shape=(X_train.shape[1],)),

Dense(32, activation='relu'),

Dense(3, activation='softmax')

])

***pile(optimizer='adam', loss='sparse_categorical_crossentropy', metrics=['accuracy'])

model.fit(X_train, y_train, epochs=10, validation_split=0.2)

```

### 3.2.3 深度学习进阶技巧

深度学习的进阶技巧包括模型正则化、批归一化、深度学习的调参策略等,这些技巧对于提高模型的性能至关重要。

#### 模型正则化与批归一化

模型正则化,如L1和L2正则化,可以防止过拟合。批归一化则可以提高网络训练的稳定性和收敛速度。

```python

from tensorflow.keras.layers import BatchNormalization, Regularizer

# 添加L2正则化

layer = Dense(64, activation='relu', kernel_regularizer=Regularizer(l2=0.01))

# 使用批归一化

layer = Dense(64, activation='relu')

layer = BatchNormalization()(layer)

```

#### 模型调参与优化

深度学习模型的调参通常涉及选择合适的损失函数、优化器、学习率等。超参数优化常用方法包括网格搜索、随机搜索、贝叶斯优化等。

```python

# 不同的学习率策略

opt = tf.keras.optimizers.Adam(learning_rate=0.01)

# 使用不同的优化器

opt = tf.keras.optimizers.SGD(learning_rate=0.01, momentum=0.9)

```

## 3.3 Web开发与框架应用

### 3.3.1 Flask与Django的对比分析

Flask和Django是Python中最流行的两个Web框架。Flask是一个轻量级的框架,适合小型项目,而Django则提供了更完整的解决方案,适合大型项目。

#### Flask的特点和应用

Flask使用了更为简单的Werkzeug WSGI工具和Jinja2模板引擎,易于学习和使用,适合快速开发简单的Web应用。

```python

from flask import Flask, render_template

app = Flask(__name__)

@app.route('/')

def home():

return render_template('index.html')

if __name__ == '__main__':

app.run(debug=True)

```

#### Django的特点和应用

Django自带了对象关系映射器(ORM),管理后台以及强大的表单处理,适合需要快速开发复杂Web应用的场景。

```python

# Django的视图函数

from django.http import HttpResponse

from django.template import loader

def index(request):

template = loader.get_template('index.html')

context = {}

return HttpResponse(template.render(context, request))

```

### 3.3.2 RESTful API设计与实现

RESTful API已经成为Web服务设计的标准,Flask和Django都提供了实现RESTful API的便捷方式。

#### Flask中的RESTful API实现

Flask通过扩展如Flask-RESTful来实现RESTful API,开发者可以很快地创建资源的CRUD操作。

```python

from flask_restful import Resource, Api, Flask

app = Flask(__name__)

api = Api(app)

class Item(Resource):

def get(self, name):

return {'item': name}

api.add_resource(Item, '/item/<string:name>')

if __name__ == '__main__':

app.run(debug=True)

```

#### Django REST framework

Django REST framework是一个强大的并且灵活的工具包,用于构建Web API。它提供了序列化、权限控制、认证、限流等丰富的功能。

```python

# Django REST framework的视图集

from rest_framework import viewsets

from .models import Item

from .serializers import ItemSerializer

class ItemViewSet(viewsets.ModelViewSet):

queryset = Item.objects.all()

serializer_class = ItemSerializer

```

### 3.3.3 Web应用安全

随着Web应用的普及,Web应用的安全问题也越来越突出。在使用Flask和Django开发时,需要特别注意跨站请求伪造(CSRF)、跨站脚本攻击(XSS)等安全威胁。

#### Flask和Django的安全实践

Flask和Django都提供了相应的模块和中间件来帮助开发者抵御这些攻击。例如,Flask通过扩展Flask-WTF来防范CSRF,Django则在其内置的中间件中已经考虑了这些安全问题。

```python

# Flask防范CSRF攻击

from flask_wtf.csrf import CSRFProtect

app.config['WTF_CSRF_ENABLED'] = True

csrf = CSRFProtect()

csrf.init_app(app)

# Django的CSRF和XSS防护

MIDDLEWARE = [

...

'django.middleware.csrf.CsrfViewMiddleware',

...

]

```

### 3.3.4 性能优化与部署

Web应用的性能优化和部署是保证服务质量的关键步骤。Flask和Django都支持多种部署方式,包括传统的WSGI服务器、云服务器以及容器化部署等。

#### 性能优化技巧

对于性能优化,可以采用代码层面的优化,如异步任务处理、缓存策略等,也可以通过硬件层面的升级,如使用负载均衡和CDN等。

```python

# 使用Flask-Caching实现缓存

from flask_caching import Cache

cache = Cache(config={'CACHE_TYPE': 'simple'})

cache.init_app(app)

# Django中的缓存配置

CACHES = {

'default': {

'BACKEND': 'django.core.cache.backends.memcached.MemcachedCache',

'LOCATION': '***.*.*.*:11211',

}

}

```

#### 部署策略

部署策略可以包括单体部署、微服务架构、容器化部署等。例如,Flask应用可以通过uWSGI+nginx部署,而Django应用则通常推荐使用Gunicorn+nginx的组合。

```python

# 使用Gunicorn部署Django应用

gunicorn myproject.wsgi --bind *.*.*.*:8000

```

在实际应用中,选择合适的部署策略和优化方案能够显著提升Web应用的性能和稳定性。

# 4. Python常见库性能优化与实践

## 4.1 性能分析工具与方法

性能分析对于提升Python程序运行效率至关重要。它可以帮助开发者识别程序中的性能瓶颈,并针对这些瓶颈制定优化策略。性能分析的工具多种多样,每种工具都有其特定的使用场景和优势。

### 4.1.1 分析工具介绍和使用

在Python中,常用的性能分析工具有`cProfile`、`line_profiler`、`memory_profiler`等。

- **cProfile**:Python内置的性能分析工具,可以通过命令行直接使用,也可以在程序代码中作为模块调用。它提供了函数级别的性能分析,记录了每个函数的调用次数和总运行时间。

```python

import cProfile

def example_function():

# 示例函数,进行一些计算或操作

pass

if __name__ == "__main__":

cProfile.run('example_function()')

```

上述代码将分析`example_function`函数的性能。分析结果会展示每个函数的调用次数、总时间、最大单次运行时间等信息。

- **line_profiler**:针对特定函数提供逐行性能分析的工具。通过装饰器的方式,可以对函数的每一行代码进行精确的性能监控。

- **memory_profiler**:关注于内存使用情况的性能分析工具,能够帮助开发者了解程序的内存消耗情况,并提供内存消耗随时间变化的详细报告。

### 4.1.2 性能瓶颈定位和优化策略

性能瓶颈定位的常用策略包括:

- **时间瓶颈定位**:利用性能分析工具找到程序运行最慢的函数或模块,并对其进行优化。常用的优化手段包括算法优化、数据结构优化、减少不必要的计算等。

- **空间瓶颈定位**:分析程序的内存消耗,找出内存占用高的对象或数据结构,并进行优化。优化手段包括优化数据结构的内存占用、减少全局变量的使用、利用缓存减少重复计算等。

对于定位出的性能瓶颈,可以采取以下优化策略:

- **使用局部变量**:局部变量访问速度比全局变量快,并且局部变量的生命周期短,有助于垃圾回收。

- **循环优化**:减少循环中的计算量,例如使用更高效的算法替换低效算法,或者通过提前计算和缓存结果来避免重复计算。

- **列表推导式和生成器表达式**:对于一些简单的循环操作,使用列表推导式或生成器表达式通常比传统的循环更高效。

## 4.2 代码优化技术

### 4.2.1 编码规范与风格

良好的编码规范和风格能够提高代码的可读性和可维护性,间接提升程序性能。PEP8是Python社区推荐的编码规范,以下是部分编码规范:

- 缩进:使用4个空格来表示缩进,而不是制表符。

- 变量命名:使用有意义的变量名,并在变量名中使用小写字母和下划线。

- 行长度:限制所有行的长度在79个字符以内。

遵循编码规范不仅有助于团队协作,而且能够避免一些潜在的错误。

### 4.2.2 内存管理和优化技巧

Python中常见的内存管理优化技巧包括:

- **对象引用**:尽量避免全局变量的使用,使用局部变量代替。

- **数据结构优化**:根据应用场景选择合适的数据结构,例如使用`set`代替`list`来提高查找效率。

- **内存泄漏的预防**:注意及时关闭或释放不再使用的资源,如文件、网络连接等。

- **垃圾回收机制的利用**:合理利用Python的垃圾回收机制,减少内存泄漏的风险。

## 4.3 高级应用实践案例

### 4.3.1 大数据处理与分析

大数据处理与分析是Python性能优化的一个重要应用场景。通过使用如`NumPy`、`Pandas`和`Dask`等库,可以有效处理和分析大规模数据集。

- **使用`NumPy`**:`NumPy`库提供了强大的N维数组对象和相关操作,针对数组运算进行了高度优化,可以大幅度提高计算效率。

- **使用`Pandas`**:`Pandas`库提供了高效的数据结构和数据分析工具,特别是其`DataFrame`对象,对于处理结构化数据非常方便。

- **使用`Dask`**:`Dask`是一个灵活的并行计算库,适用于并行数据处理,能够扩展到单机多核或者集群计算。

### 4.3.2 云计算平台的应用集成

在云计算环境中,Python库的性能优化对于提升应用程序的服务能力和成本效率至关重要。例如,在AWS、Azure、Google Cloud Platform等平台上,可以通过如下方式优化应用:

- **利用云平台提供的工具和服务**:比如AWS的Elastic Beanstalk、EC2 autoscaling,以及Azure的App Service等,这些服务可以帮助应用程序根据负载自动扩展资源。

- **优化存储和计算资源的使用**:合理利用云平台中的数据库服务、缓存服务等,可以有效减少应用的响应时间和成本。

- **性能监控和自动扩缩容**:利用云平台提供的监控工具,如AWS CloudWatch或Azure Monitor,对应用进行持续监控,并根据性能数据自动调整资源分配。

通过上述内容的深入探讨,我们可以看到Python性能优化不仅仅是一个技术问题,它还涉及到对工具的熟悉、对场景的理解以及对最佳实践的应用。只有全面掌握了这些知识,开发者才能在实践中游刃有余地解决实际问题,提高应用程序的性能。

# 5. Python库的未来发展与安全

随着Python在数据科学、机器学习、网络开发等领域的不断扩展,越来越多的新库不断涌现,它们不仅提升了开发效率,也为程序员提供了更丰富的工具选择。同时,安全性问题也日益成为开发者必须面对的挑战。这一章节将探讨Python库的未来发展和安全最佳实践。

## 5.1 新兴库的探索与应用

### 5.1.1 深度学习的新库概览

深度学习领域一直在快速发展,Python作为这个领域的主要语言,诞生了许多新库。例如,PyTorch和MXNet是近年来广受欢迎的深度学习框架,它们有着易用的API和高效的性能。以下是对这些新兴库的简要介绍:

- **PyTorch**: 由Facebook开发,非常适合研究人员开发新的算法,因为它提供了强大的动态计算图。PyTorch的灵活性在处理非标准操作和模型时特别有用。

- **MXNet**: 是一个高效且灵活的深度学习框架,支持多种编程语言,并且在分布式训练方面表现出色。MXNet能够自动并行化操作,减少用户的负担。

### 5.1.2 云计算和大数据相关库

随着云计算和大数据技术的广泛应用,Python也涌现出一系列专门应对这些挑战的库。例如:

- **Apache Arrow**: 用于在内存中存储和处理大数据的开源项目,通过提供跨语言的列式存储,极大提升了大数据处理的效率。

- **Ploomber**: 一个用于数据科学和机器学习的Python库,旨在简化数据管道的创建和部署,让数据处理流程更加清晰和可维护。

## 5.2 安全性分析与最佳实践

### 5.2.1 安全漏洞分析与防范

在应用Python库时,安全漏洞的分析和防范至关重要。例如,使用第三方库可能会引入不安全的代码,导致应用程序面临风险。为了防范这些风险,可以采取以下措施:

- **漏洞扫描**: 定期使用工具如`bandit`对项目进行扫描,识别并修复已知的安全漏洞。

- **依赖审计**: 使用`pip-audit`工具可以审计Python项目的所有依赖,确保它们都是安全的。

### 5.2.2 安全编码标准和安全库的使用

编写安全代码不仅要遵守安全编码标准,还要明智地选择和使用安全库。例如:

- **OWASP安全编码规范**: 遵循OWASP的十大安全编码标准,可以有效避免常见的安全问题。

- **Cryptography库**: 在需要进行加密解密操作时,应优先选择如`cryptography`这样经过广泛审查的库,而不是自己实现加密算法。

通过这一章节的探讨,我们了解到Python社区正在积极发展和拥抱新库,同时也不能忽视安全性问题。这要求开发者既要勇于探索新技术,也要有意识地维护代码的安全性,保证项目能够稳健运行。

0

0