掌握数据分布:机器学习中的先决条件,专家解读秘籍

发布时间: 2024-11-24 08:07:46 阅读量: 20 订阅数: 44

移动机器人与头戴式摄像头RGB-D多人实时检测和跟踪系统

# 1. 数据分布在机器学习中的作用

数据分布是机器学习中的基础概念,它描述了数据在特征空间中的分布方式,是理解数据特性的关键。在机器学习模型的训练过程中,对数据分布的理解可以帮助我们更好地选择合适的算法、预处理数据、以及评估模型的泛化能力。

理解数据分布可以帮助我们掌握数据集的内在结构,例如识别异常值、了解数据特征的趋势和波动,以及揭示不同特征之间的关系。这对于提高数据处理的效率和模型的准确度至关重要。

在下一章中,我们将深入探讨数据分布的理论基础,包括概率分布的种类、数据集的统计描述,以及如何通过视觉化方法理解数据分布。只有深入掌握这些基础知识,我们才能更好地利用数据分布来提升机器学习项目的成功率。

# 2. 理解数据分布的理论基础

数据分布是统计学和机器学习中的核心概念,它是数据特性、特征和模型表现之间关系的桥梁。在这一章节中,我们将深入了解数据分布的基础理论,包括数据分布的概念和类型、数据集的统计描述以及如何通过视觉化手段来理解和分析数据分布。

## 2.1 数据分布的概念和类型

数据分布描述了数据在各个取值上的概率分布情况,是我们理解数据内在结构的关键。了解不同类型的分布对于后续进行数据建模和分析至关重要。

### 2.1.1 概率分布简介

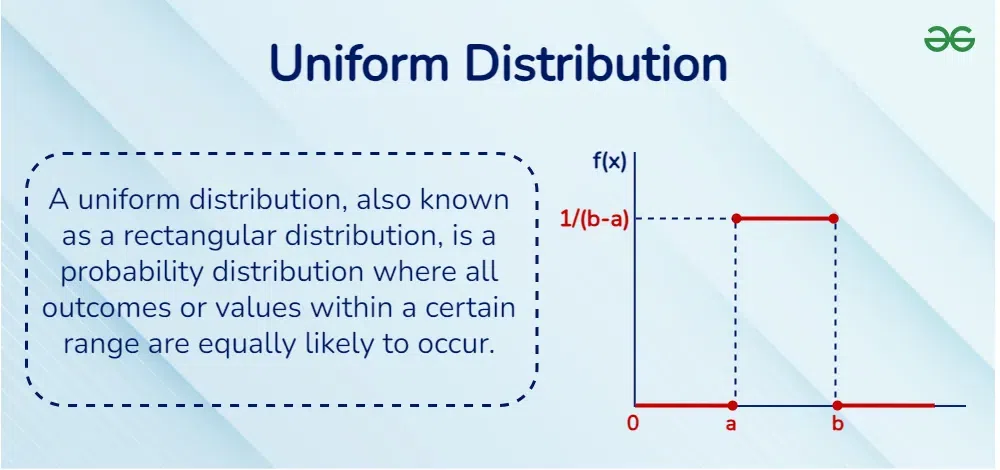

概率分布是描述随机变量取值及其概率的数学函数。它为随机变量可能出现的每一个值指定了概率值,这个值位于0到1之间,并且所有可能值的概率之和为1。根据随机变量的类型,概率分布可以分为离散型和连续型。

- 离散型概率分布:例如二项分布、泊松分布等,通常用于计数数据。

- 连续型概率分布:例如正态分布、指数分布等,适用于度量数据。

### 2.1.2 常见的概率分布模型

在本小节中,我们将探讨几个常见的概率分布模型,并了解它们在数据分析中的应用。

#### 正态分布(高斯分布)

正态分布是连续型随机变量中最为常见的一种分布,它具有对称的钟型曲线形状。许多自然现象和社会现象中的数据都呈现出正态分布的特征。在机器学习中,正态分布假设常用于算法的设计和结果的解释。

正态分布的概率密度函数(PDF)表示如下:

```python

import numpy as np

import matplotlib.pyplot as plt

from scipy.stats import norm

# 设置正态分布参数

mu = 0 # 均值

sigma = 1 # 标准差

# 生成一个正态分布的数据集

x = np.linspace(mu - 4*sigma, mu + 4*sigma, 100)

p = norm.pdf(x, mu, sigma)

# 绘制概率密度函数图

plt.figure(figsize=(10, 5))

plt.plot(x, p, 'b-', label=f'Normal distribution (mu={mu}, sigma={sigma})')

plt.title('Probability Density Function of a Normal Distribution')

plt.xlabel('Data value')

plt.ylabel('Probability Density')

plt.legend()

plt.grid(True)

plt.show()

```

#### 二项分布

二项分布是离散型概率分布的一种,它描述了在固定次数的独立实验中,成功次数的概率分布。每项实验只有两种可能的结果,通常是成功或失败。二项分布广泛应用于质量控制、金融分析等领域。

二项分布的公式如下:

```python

def binomial_distribution(n, p):

"""计算二项分布的概率质量函数(PMF)"""

from math import comb

pmf = [comb(n, k) * p**k * (1-p)**(n-k) for k in range(n+1)]

return pmf

# 设置二项分布参数

n = 10 # 试验次数

p = 0.5 # 成功概率

# 绘制二项分布的概率质量函数(PMF)

plt.figure(figsize=(10, 5))

plt.bar(range(n+1), binomial_distribution(n, p), color='green', alpha=0.7)

plt.title('Probability Mass Function of a Binomial Distribution')

plt.xlabel('Number of Successes')

plt.ylabel('Probability')

plt.grid(True)

plt.show()

```

## 2.2 数据集的统计描述

统计描述是数据集分析的基础,它涉及数据的中心趋势、离散程度和分布形状的度量。

### 2.2.1 中心趋势度量

中心趋势是数据集中趋势的一种度量,它反映了数据集中的“中心”位置。常见的中心趋势度量包括均值、中位数和众数。

- 均值:所有数据点的总和除以数据点的数量。

- 中位数:位于数据集中间位置的数值,当数据量为偶数时,则取中间两个数的平均值。

- 众数:数据集中出现次数最多的值。

### 2.2.2 离散程度度量

离散程度用于衡量数据点之间的差异大小。常见的离散程度度量包括方差、标准差和四分位数范围。

- 方差:各数据点与均值差的平方的平均数。

- 标准差:方差的平方根,与原始数据具有相同的单位。

- 四分位数范围:第三四分位数与第一四分位数之间的差值。

### 2.2.3 形状描述:偏度和峰度

偏度描述了数据分布的对称性,而峰度则描述了数据分布的“尖峭”或“平缓”程度。

- 偏度(Skewness):如果偏度大于0,表示分布右偏;如果偏度小于0,表示分布左偏;如果偏度接近0,表示分布近似对称。

- 峰度(Kurtosis):描述了分布的尖峭程度。如果峰度大于0,表示数据分布比正态分布更加集中;如果峰度小于0,表示数据分布比正态分布更加平坦。

## 2.3 数据分布的视觉化

视觉化是分析数据分布的直观方式,它有助于我们快速识别数据的形状、异常值和模式。

### 2.3.1 绘制直方图和核密度估计图

直方图和核密度估计(KDE)图都是显示数据分布情况的图形工具,它们能帮助我们理解数据的分布形态。

- 直方图:通过将数据值的范围分成多个区间(箱子),并统计每个区间内数据点的数量来展示数据的分布。

- 核密度估计图:使用平滑的曲线来估计数据的概率密度函数,提供了比直方图更平滑的分布形态。

下面的代码展示了如何使用Python绘制直方图和核密度估计图:

```python

import numpy as np

import seaborn as sns

import matplotlib.pyplot as plt

# 生成一组随机数据

data = np.random.randn(1000)

# 绘制直方图

plt.figure(figsize=(10, 5))

plt.hist(data, bins=30, alpha=0.7, label='Histogram')

plt.title('Histogram of Data')

plt.xlabel('Data value')

plt.ylabel('Frequency')

plt.legend()

plt.show()

# 绘制核密度估计图

plt.figure(figsize=(10, 5))

sns.kdeplot(data, label='KDE', shade=True)

plt.title('Kernel Density Estimate of Data')

plt.xlabel('Data value')

plt.ylabel('Density')

plt.legend()

plt.show()

```

### 2.3.2 利用箱线图识别异常值

箱线图是识别数据中异常值的有力工具。它通过显示数据的“四分位数”来展现数据的分布,此外,它还会标注出可能的离群点。

- 四分位数范围(IQR):第三四分位数(Q3)与第一四分位数(Q1)之差。

- 离群点:通常定义为小于Q1 - 1.5 * IQR或大于Q3 + 1.5 * IQR的值。

下面是使用Python创建箱线图的示例代码:

```python

plt.figure(figsize=(10, 5))

sns.boxplot(data=data, color="cyan")

plt.title('Boxplot of Data')

plt.ylabel('Data value')

plt.show()

```

通过本章节的介绍,您应该对数据分布的理论基础有了一个全面的理解。从概率分布的概念,到数据集的统计描述,再到数据分布的视觉化方法,这些都是您在未来进行数据分析和机器学习建模时不可或缺的工具和知识。接下来的章节我们将深入探讨数据分布在机器学习中的重要性及其对模型选择和性能的影响。

# 3. 数据分布对机器学习的影响

## 3.1 数据分布与模型选择

在机器学习领域,选择一个合适的模型对于预测结果的准确性和模型的可靠性至关重要。数据分布的特点是影响模型选择的关键因素之一,下面将深入探讨不同数据分布对模型选择的影响。

### 3.1.1 不同模型对数据分布的假设

机器学习模型基于不同的数学假设和理论框架构建。以线性回归为例,它通常假设输入变量和输出变量之间存在线性关系,并且预测误差是独立且同分布的。然而,如果数据实际上遵循非线性关系或误差项存在自相关性,线性回归模型可能就不再适用。

另一方面,决策树模型不需要数据满足线性假设,它可以处理非线性关系和复杂的决策边界。但是,它对数据分布的假设是数据特征之间有显著的区分度,否则容易过拟合。

深度学习模型,如卷积神经网络(CNN)和循环神经网络(RNN),对数据分布的假设通常是数据量足够大,能够捕捉到足够的特征和模式。并且,数据分布的平稳性对于这些模型的训练也是很重要的,因为模型的权重更新依赖于数据分布的统计特性保持一致。

### 3.1.2 选择合适模型的策略

面对实际问题时,选择合适模型的第一步是理解数据的分布。以下是选择模型时可以遵循的几个策略:

- 利用散点图、箱线图等可视化工具初步判断数据分布特性。

- 应用统计测试,例如 Kolmogorov-Smirnov 测试,来验证数据是否符合某些分布(如正态分布)。

- 根据问题的性质(回归、分类、聚类等)和数据的规模,筛选出可能适用的模型家族。

- 采用交叉验证的方法,通过比较不同模型在验证集上的性能,选择表现最好的模型。

例如,在数据集中存在多个类别且类别之间分布不均匀的情况下,可能需要选择能够处理不平衡数据集的算法,比如加权逻辑回归或者使用过采样技术的决策树。

## 3.2 数据分布与模型性能

数据分布不仅影响模型的选择,还直接影响模型的性能。模型训练过程中对数据分布的假设如果被实际数据所违背,可能会导致模型表现不佳。

### 3.2.1 数据分布的不平衡对分类的影响

不平衡的数据分布是指某些类别在数据集中出现的频率远高于其他类别。在分类任务中,如果数据集中正负样本数量差异很大,那么简单的分类模型可能会偏向于预测出现频率更高的类别。这种情况被称为“类别不平衡”问题。

例如,对于一个欺诈检测模型,假设只有1%的交易是欺诈的,那么如果模型总是预测非欺诈,它的准确率将会很高(99%)。但实际上,这样的模型几乎没有任何价值。

为了解决这个问题,可以通过以下策略进行操作:

- 采用数据层面的策略,例如过采样少数类或欠采样多数类。

- 在模型训练过程中对不同的类别赋予不同的权重。

- 使用专门设计的评估指标,如F1分数、ROC AUC,来更准确地衡量模型性能。

### 3.2.2 数据分布的不准确性对预测的影响

当训练数据的分布与目标分布不一致时,会产生所谓的“分布偏移”问题。这种情况下,模型在训练集上可能表现出色,但在实际应用中却大打折扣。这常见于时间序列预测或跨域学习场景中。

要缓解这个问题,可以考虑以下几个方案:

- 使用领域适应技术来调整模型以适应新的数据分布。

- 采用正则化技术或在线学习方法,使模型更适应数据分布的变化。

- 在模型评估阶段,使用与实际应用场景相似的数据进行测试。

## 3.3 数据预处理与分布调整

在机器学习流程中,数据预处理是一个不可或缺的步骤。适当的预处理能提高模型的准确性和鲁棒性。

### 3.3.1 数据标准化与归一化

数据标准化和归一化是减少数据中噪声和提高模型性能的常用方法。标准化是将数据按比例缩放,使其均值为0,标准差为1。归一化则是将数据按比例缩放,使其范围限定在一个较小的区间,如0到1。

对于基于距离的算法,如K-最近邻(KNN),标准化尤其重要,因为它会影响距离计算。而对于梯度下降算法,如神经网络,归一化可以帮助加快收敛速度。

### 3.3.2 数据转换技巧:离散化和分箱

数据转换是将原始数据转换为更适合建模的形式。离散化和分箱是数据转换中的重要技术。

离散化是将连续变量转换为有限数量的离散类别。例如,可以将顾客的收入水平划分到不同的收入区间,如低、中、高。分箱技术则是将连续变量的值范围划分为一系列连续的“箱子”或区间,并将每个值映射到相应的箱子中。

分箱可以通过减少异常值的影响和简化数据结构来改善模型性能。而且,分箱后的数据通常更容易解释和可视化。

```python

# 示例代码:数据离散化和分箱

import pandas as pd

import numpy as np

# 假设有一个包含顾客收入的DataFrame

data = pd.DataFrame({'Income': np.random.uniform(10000, 200000, 1000)})

# 利用pandas的cut函数进行分箱

bins = [10000, 30000, 60000, 100000, 200000]

labels = ['Low', 'Medium', 'High', 'Very High']

data['Income_Binned'] = pd.cut(data['Income'], bins=bins, labels=labels)

# 输出离散化后的数据

print(data.head())

```

在上述代码中,我们首先创建了一个包含1000个收入样本的DataFrame,然后通过`pd.cut`函数将收入数据分成了四个区间。每个区间的标签定义为"Low"、"Medium"、"High"和"Very High"。数据分箱后,我们可以更方便地进行进一步的分析和建模工作。

在机器学习中,离散化和分箱是减少模型复杂性、处理异常值和特征工程的重要手段。通过将连续特征转换为离散特征,不仅可以减少计算复杂性,还可以提高模型的泛化能力。而且,在很多情况下,通过分箱可以发现数据中不明显的模式和关联,从而引导我们进行更加深入的数据分析。

# 4. 数据分布实践分析技巧

## 4.1 数据探索性分析

### 4.1.1 数据分布的初步探索方法

在机器学习项目中,对数据进行初步的探索性分析是理解数据分布及其特性的第一步。这一步骤包括了解数据的基本结构、统计特征以及初步的数据可视化。

#### 统计描述

通常,开始探索性分析时,我们会计算数据的基本统计描述量,例如均值、中位数、众数、方差、标准差等。这些统计量可以帮助我们捕捉数据的中心趋势和分散程度。

```python

import pandas as pd

# 假设df是一个包含数据的pandas DataFrame

# 计算基本统计描述

description = df.describe()

print(description)

```

在上述Python代码中,我们使用了`describe()`函数,该函数返回一个包含数值列统计摘要的DataFrame,包括计数、均值、标准差、最小值、四分位数和最大值等信息。

#### 数据可视化

数据可视化是探索性分析中不可或缺的一部分。可视化工具如直方图、核密度估计图、箱线图等能够直观地展示数据分布情况。

```python

import matplotlib.pyplot as plt

import seaborn as sns

# 假设df['feature']是我们要分析的特征

# 绘制直方图

plt.figure(figsize=(10, 6))

sns.histplot(df['feature'], kde=True)

plt.title('Feature Distribution')

plt.xlabel('Feature Value')

plt.ylabel('Frequency')

plt.show()

# 绘制箱线图

plt.figure(figsize=(10, 6))

sns.boxplot(y=df['feature'])

plt.title('Feature Outlier Detection')

plt.ylabel('Feature Value')

plt.show()

```

以上代码使用了`matplotlib`和`seaborn`库来绘制直方图和箱线图。直方图显示了数据的频率分布,而箱线图则允许我们检测数据中的异常值。

### 4.1.2 异常值的检测与处理

异常值是指那些不符合数据总体分布或预期模式的观测值。在数据探索阶段,检测和处理异常值是非常关键的,因为异常值可能会对模型的性能产生负面影响。

#### 异常值的检测方法

异常值的检测方法有多种,包括Z分数、IQR(四分位距)等。

```python

# 计算Z分数

z_scores = (df['feature'] - df['feature'].mean()) / df['feature'].std()

outliers = df[(z_scores.abs() > 3)]

print(outliers)

# 使用IQR识别异常值

Q1 = df['feature'].quantile(0.25)

Q3 = df['feature'].quantile(0.75)

IQR = Q3 - Q1

outliers = df[(df['feature'] < Q1 - 1.5 * IQR) | (df['feature'] > Q3 + 1.5 * IQR)]

print(outliers)

```

在上述代码中,我们首先计算了Z分数来识别异常值,然后使用了IQR方法。如果一个观测值的Z分数绝对值大于3,或者位于四分位距的1.5倍范围之外,那么这个值被视为异常。

#### 异常值的处理策略

处理异常值的策略包括删除异常值、替换异常值以及数据变换。

```python

# 删除异常值

df_cleaned = df[(z_scores.abs() <= 3)]

# 替换异常值为中位数

median_value = df['feature'].median()

df['feature'].replace(to_replace=outliers['feature'], value=median_value, inplace=True)

# 对数据进行变换,如对数变换,以减少异常值的影响

df['feature_log'] = np.log(df['feature'] + 1)

```

在上述代码中,我们展示了删除和替换异常值的方法。同时,通过数据变换(如对数变换)也可以减少异常值的影响。

## 4.2 数据分布的模拟与检验

### 4.2.1 假设检验在数据分布分析中的应用

假设检验是统计学中用来评估关于总体参数或数据分布的假设是否合理的常用方法。在数据分布分析中,我们经常使用假设检验来判断样本是否来自特定的分布。

#### 常见的假设检验方法

t检验、卡方检验和Kolmogorov-Smirnov检验是在数据分布分析中常见的假设检验方法。

```python

from scipy.stats import ttest_1samp, chi2_contingency, kstest

# t检验示例

t_statistic, p_value = ttest_1samp(df['feature'], 0)

# 卡方检验示例

observed = pd.DataFrame([df['var1'].value_counts(), df['var2'].value_counts()])

chi2, p, dof, expected = chi2_contingency(observed)

# K-S检验示例

ks_statistic, p_value = kstest(df['feature'], 'norm', args=(df['feature'].mean(), df['feature'].std()))

```

在上述代码中,我们使用了`scipy.stats`库中的函数来进行三种不同的假设检验。

#### 假设检验的逻辑分析

每个假设检验都需要定义一个零假设(H0)和一个备择假设(H1)。例如,在t检验中,零假设可能是“样本均值等于总体均值”,而备择假设可能是“样本均值不等于总体均值”。通过计算检验统计量和相应的P值,我们可以决定是否拒绝零假设。

### 4.2.2 数据拟合优度的评估方法

数据拟合优度检验用于确定样本数据是否符合某种特定分布。常用的评估方法包括卡方拟合优度检验和Kolmogorov-Smirnov检验。

#### 卡方拟合优度检验

卡方拟合优度检验可以用来检验样本的分布是否与预期的理论分布一致。

```python

# 分组数据以进行卡方检验

bins = np.linspace(df['feature'].min(), df['feature'].max(), 10)

observed, bins = np.histogram(df['feature'], bins=bins)

# 假设理论分布是正态分布

expected = chi2.pdf(bins[:-1], df['feature'].mean(), df['feature'].std(), bins=bins.size-1)

# 计算卡方检验

chi2_statistic, p_value = chi2_contingency([observed], p=[expected])

```

在上述代码中,我们首先将数据分组,然后计算观察频率和期望频率,并执行卡方检验。

#### Kolmogorov-Smirnov检验

Kolmogorov-Smirnov检验是一种非参数检验,用来比较样本分布与特定分布的差异。

```python

ks_statistic, p_value = kstest(df['feature'], 'norm', args=(df['feature'].mean(), df['feature'].std()))

```

此代码块使用了`kstest`函数来检验样本是否服从正态分布。

## 4.3 多变量数据分布分析

### 4.3.1 多元数据的联合分布与边缘分布

当分析多个变量时,我们需要理解变量之间的关系。多元数据的联合分布描述了两个或更多随机变量同时发生的概率分布。而边缘分布是关注单一变量的概率分布,忽略其他变量的影响。

#### 联合分布的可视化

多元数据的联合分布可以通过散点图矩阵(scatter plot matrix)来可视化。

```python

import seaborn as sns

# 假设df是包含多个特征的DataFrame

sns.pairplot(df)

plt.show()

```

在上述代码中,`pairplot`函数生成了一个散点图矩阵,可以用来探索不同变量之间的关系。

#### 边缘分布的计算

边缘分布可以通过对联合分布进行积分(对连续变量)或求和(对离散变量)来得到。

```python

# 边缘分布的计算示例(这里使用理论上的积分方式来近似连续变量的边缘分布)

marginal_dist = df['feature1'].value_counts()

```

### 4.3.2 相关性分析与协方差矩阵

相关性分析是研究变量之间线性相关程度的方法,而协方差矩阵则描述了多个变量间的协方差。

#### 相关性分析

相关系数,尤其是皮尔逊相关系数,是衡量两个变量线性相关程度的常用指标。

```python

correlation_matrix = df.corr()

print(correlation_matrix)

```

上述代码利用`corr`方法计算并打印出变量间的相关系数矩阵。

#### 协方差矩阵

协方差矩阵用于描述多个变量之间的协方差,提供了一种衡量变量间线性关系的方式。

```python

covariance_matrix = df.cov()

print(covariance_matrix)

```

上述代码使用`cov`方法计算并打印出变量间的协方差矩阵。

通过理解多元数据的联合分布和边缘分布,以及进行相关性分析和协方差矩阵分析,我们可以更深入地了解多个变量间复杂的相互作用和数据结构。这些分析技巧对于构建更为准确和高效的机器学习模型至关重要。

# 5. 机器学习中的数据分布挑战

在机器学习的世界里,数据分布是影响模型性能和泛化能力的关键因素。随着机器学习应用的不断扩展,对数据分布的理解和应对挑战变得愈发重要。本章将深入探讨在实际机器学习项目中经常遇到的一些分布挑战,以及如何应对这些挑战。

## 5.1 非参数模型与分布自由方法

### 5.1.1 非参数统计方法的简介

非参数模型在机器学习中提供了对数据分布的灵活假设。与参数模型不同,非参数模型不需要预设数据分布的具体形式,能够更自由地适应数据的实际分布。非参数方法的一个显著优点是它们通常不受异常值的影响,并且可以更好地处理复杂的数据结构。

一个典型的非参数方法是核密度估计(Kernel Density Estimation, KDE),它通过滑动窗口平滑的方式来估计概率密度函数,无需设定数据的分布形式。另一个例子是K近邻算法(K-Nearest Neighbors, KNN),它不基于参数模型而是直接对数据进行分类或回归。

### 5.1.2 分布自由检验的应用

分布自由检验(Distribution-Free Tests),也称为非参数检验,是一种统计方法,用于检验样本数据是否来自某个特定的分布,而无需对这个分布做出任何假设。这类检验在数据分布未知或数据量不足以做出准确假设的情况下尤其有用。

例如,曼-惠特尼U检验(Mann-Whitney U test)可以用于比较两个独立样本的中位数是否相同,而不假定数据服从正态分布。Kruskal-Wallis H检验是ANOVA的非参数替代方法,用于检验三个或三个以上样本的中位数是否存在显著差异。

## 5.2 分布外样本与泛化能力

### 5.2.1 训练集与测试集分布差异的影响

在机器学习中,训练集和测试集分布的一致性是确保模型具有较好泛化能力的重要前提。当存在分布外样本(Out-Of-Distribution, OOD)时,模型性能可能会大幅下降。这种情况下,模型在训练数据上表现良好,但在未知或新的数据上表现不佳。

一个实际例子是在医学诊断中,模型可能会在训练集上高度准确,但当面对来自不同医院的新样本时,由于设备、人口统计学等因素的不同,模型性能可能急剧下降。

### 5.2.2 提升模型泛化能力的策略

为了提升模型的泛化能力,研究者们开发了多种策略。领域自适应(Domain Adaptation)是其中一种有效方法,其目的是减少训练集和测试集之间的分布差异。领域自适应可以通过特征变换来实现,使得训练数据的分布与测试数据的分布更加接近。

另一个策略是使用对抗性训练(Adversarial Training),它在训练过程中引入对抗性样本,迫使模型对分布外样本具有更强的鲁棒性。此外,集成学习方法如bagging和boosting,通过组合多个模型来减少过拟合,从而提升模型对新数据的泛化能力。

## 5.3 数据分布演进的监控

### 5.3.1 在线学习场景下的分布跟踪

在线学习(Online Learning)是一种学习模式,其中模型在接收到新数据时可以即时更新。与传统的批量学习(Batch Learning)不同,数据分布可能会随时间变化,因此模型需要能够适应这种变化。在在线学习场景下,监控数据分布的演进变得至关重要。

使用在线学习,可以实施递归算法,如滑动窗口平均(Sliding Window Averages)和指数加权移动平均(Exponentially Weighted Moving Averages)来跟踪数据分布的统计特性。此外,聚类分析和流式数据可视化技术也常用于实时监控数据分布。

### 5.3.2 模型更新与持续学习的必要性

为了应对数据分布的变化,模型需要定期更新或重新训练。这种方法称为持续学习(Continuous Learning)或终身学习(Lifelong Learning),它允许模型不断地适应新数据,并保持最新状态。

持续学习的一个实际应用是在金融市场的分析中,由于市场的动态变化,模型需要不断调整以预测未来的市场走势。一种常见的策略是周期性地重新训练模型,或者在检测到数据分布显著变化时触发模型更新过程。

综上所述,数据分布对机器学习的影响是深远的。了解并应对数据分布的挑战,能够提高模型的性能和可靠性。在本章中,我们探讨了非参数模型、分布自由检验、分布外样本处理、在线学习数据监控及持续学习等关键概念。为了在现实世界中实施这些概念,接下来的章节将提供更加深入的分析和实践案例。

# 6. 高级数据分布分析方法

## 6.1 概率图模型与贝叶斯推断

在机器学习中,概率图模型提供了一种强大的工具来表示变量之间的复杂关系,并利用贝叶斯推断来分析和预测数据分布。这一部分,我们将详细探讨概率图模型和贝叶斯推断的理论基础,以及它们在实际数据分析中的应用。

### 6.1.1 概率图模型的基本概念

概率图模型(Probabilistic Graphical Models,PGM)结合了概率论和图论,通过图的方式来表示变量间的概率关系。它通常由表示变量节点和边的图结构组成。在有向图模型(如贝叶斯网络)中,边表示条件依赖关系;而在无向图模型(如马尔可夫随机场)中,边表示变量间的联合分布。

概率图模型分为两大类:

- **有向无环图(DAG)模型**:贝叶斯网络是其典型代表,其特点是在图中不存在任何循环路径。

- **无向图模型**:马尔可夫随机场(MRF)和条件随机场(CRF)属于此类,常用于序列数据或图像数据的建模。

### 6.1.2 贝叶斯推断在数据分布分析中的应用

贝叶斯推断是一种统计方法,用于从已有数据中更新概率估计。它是基于贝叶斯定理,该定理将目标变量的先验概率与观测数据的似然性相结合,以推导出后验概率。在数据分布分析中,贝叶斯推断可以用于:

- **参数估计**:通过已有的观测数据来估计模型参数的分布。

- **模型选择**:利用模型的证据(Marginal likelihood)来评价模型的合理性。

- **预测与决策**:根据后验概率进行预测或制定决策。

以贝叶斯线性回归为例,我们能够通过先验知识和样本数据来估计回归参数的分布。例如:

```python

import numpy as np

import scipy.stats as stats

import matplotlib.pyplot as plt

# 假设我们有一组数据和对应的x值

data = np.array([1, 2, 2, 3, 4, 5, 6, 6, 7, 8])

x_values = np.array([1, 2, 3, 4, 5, 6, 7, 8, 9, 10])

# 设置参数的先验分布

mu_a = 0 # 均值为0

sigma_a = 1e6 # 方差非常大,表示先验信息几乎没有

mu_b = 0 # 斜率的均值为0

sigma_b = 1e6 # 斜率的方差非常大

# 设置观测误差的先验分布

sigma_y = 1

# 后验分布参数的计算(详细推导略去)

# ...(计算代码)

# 绘制贝叶斯线性回归的结果

x_vals = np.linspace(0, 11, 100)

plt.plot(x_vals, stats.norm.pdf(x_vals, mu_posterior_a, sigma_posterior_a), color='blue', label='Posterior a')

plt.plot(x_vals, stats.norm.pdf(x_vals, mu_posterior_b, sigma_posterior_b), color='red', label='Posterior b')

plt.scatter(x_values, data)

plt.legend()

plt.show()

```

通过上述代码,我们可以可视化参数的后验分布,并得出模型参数的合理推断。贝叶斯推断的这些应用对于深入理解数据分布提供了强有力的方法论支持。

## 6.2 数据分布的深度学习方法

随着深度学习的兴起,许多先进的技术和架构被应用于数据分布的估计与分析。深度学习模型特别擅长从大量数据中学习复杂的分布,这在传统方法中难以实现。

### 6.2.1 自动编码器用于密度估计

自动编码器(Autoencoders)是一种无监督学习算法,能够学习输入数据的有效表示。它通过一个编码过程将输入数据压缩成一个低维表示(即编码),然后再通过一个解码过程恢复到原始数据的高维空间。在密度估计任务中,我们可以使用变分自动编码器(Variational Autoencoders,VAE),通过优化重建误差和KL散度来学习数据的潜在分布。

VAE的编码器将数据映射到潜在空间的参数上,并假设这些参数遵循高斯分布,而解码器则从这些参数中生成数据样本。通过采样潜在空间并使用解码器,我们可以估计数据的分布并生成新数据点。

### 6.2.2 变分自编码器和生成对抗网络

变分自编码器(VAE)通过学习潜在空间的分布参数来生成新样本,而生成对抗网络(Generative Adversarial Networks,GAN)则通过两个模型的对抗训练过程来捕捉数据分布。GAN包含一个生成器(Generator)和一个判别器(Discriminator):

- **生成器**:学习生成与真实数据分布相匹配的数据样本。

- **判别器**:学习区分真实样本和由生成器生成的假样本。

通过不断的迭代训练,判别器和生成器相互提升,最终生成器能够生成高质量的样本。利用GAN的生成能力,我们可以进行数据增强、样本插值等任务,甚至分析数据的内在分布。

## 6.3 数据分布的未来趋势与研究方向

随着机器学习和统计学理论的不断进步,数据分布分析也正面临着新的挑战和机遇。这一部分,我们将探讨在大数据环境下,数据分布分析所面临的挑战以及未来可能的研究方向。

### 6.3.1 大数据环境下的分布分析挑战

大数据环境为数据分布分析带来了新的挑战:

- **异构性与复杂性**:大数据往往包含异构来源的数据,如何在保持数据特征的同时处理并分析这些数据是一个重要问题。

- **可扩展性与效率**:大规模数据的处理和分析需要高效的算法和系统支持,传统的分析方法可能无法有效应对。

- **隐私与安全**:在处理敏感数据时,确保数据隐私和安全是必须考虑的问题。

### 6.3.2 数据分布研究的前沿领域

在数据分布分析的研究前沿领域,以下方向值得关注:

- **分布式学习**:研究如何在分布式系统中进行数据分布的估计和学习,这对于大数据环境至关重要。

- **因果推断**:研究如何从数据分布中推断出变量间的因果关系,这对于理解数据背后的根本原因至关重要。

- **不确定性量化**:量化模型输出中的不确定性,并在决策过程中合理使用这一信息。

在未来,数据分布分析将紧密结合前沿技术如量子计算、边缘计算等,为数据驱动的决策提供更加精确和高效的支持。

0

0