医疗人工智能算法的透明度:可解释性研究

发布时间: 2024-09-01 22:20:23 阅读量: 145 订阅数: 51

人工智能算法优化与可解释性.pptx

# 1. 医疗人工智能算法概述

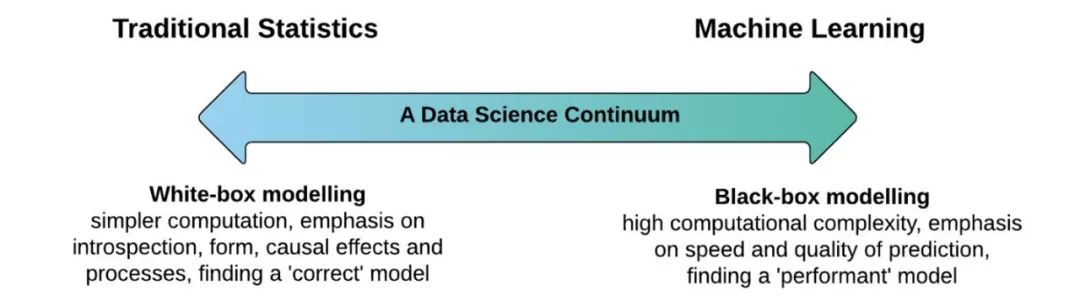

随着技术的快速发展,人工智能(AI)在医疗领域的应用已成为提高诊断准确性和治疗效率的重要途径。医疗人工智能算法是指运用机器学习、深度学习等技术处理医疗数据,实现疾病预测、影像分析、个性化治疗等功能的一系列算法。这些算法在处理复杂数据集和模式识别方面的能力已经超越了传统统计方法,展现了巨大的应用潜力和价值。

然而,医疗AI的成功应用不仅仅是关于算法精度的提升,它还涉及到了数据安全、算法透明度、结果可解释性等多重挑战。特别是在医疗领域,算法的决策透明度不仅关系到患者的健康利益,还与医疗伦理和法律责任紧密相连。因此,我们将在后续章节深入探讨透明度在医疗AI中的重要性、面临的挑战以及提高透明度的可行策略。

在本章中,我们将概览医疗AI算法的主要类型及其应用领域,为进一步探讨其透明度和可解释性奠定基础。接下来,我们将详细解析透明度在医疗人工智能算法中的角色,并对其在现实世界中的实际意义进行讨论。

# 2. 人工智能算法的透明度理论基础

人工智能技术在医疗领域的应用日益广泛,其算法透明度成为医疗人工智能发展的核心议题之一。透明度不仅关乎医疗决策的准确性,还牵涉到伦理、法律以及患者的信任等多重层面。

## 2.1 透明度与医疗人工智能的关系

### 2.1.1 透明度在医疗领域的必要性

透明度在医疗领域的必要性是显而易见的。首先,透明度能够使医疗人工智能系统的决策过程更加开放和可理解,有助于医疗工作者理解和信任人工智能的决策依据。其次,透明度有助于患者了解自身的治疗方案,增强医患之间的沟通,提升医疗服务的质量和效率。最后,透明度对于医疗AI的监管和持续改进同样至关重要,为政策制定者提供决策依据,推动行业标准的建立和完善。

### 2.1.2 透明度与医疗AI的责任归属

在医疗人工智能算法中,透明度与责任归属紧密相连。当AI系统的决策出现错误时,透明度可以帮助追溯问题的根源,明确责任归属,从而有效地进行风险控制和责任追究。例如,如果某AI诊断系统错误地识别了疾病,透明度可以帮助医疗团队了解错误发生的具体环节,无论是算法设计的缺陷、数据集的偏差还是操作过程中的失误。这直接关联到医疗责任保险、患者赔偿以及医疗纠纷的解决。

## 2.2 算法可解释性的定义与重要性

### 2.2.1 可解释性的概念框架

可解释性是指AI系统的输出决策可以被人类用户所理解的程度。在医疗领域,算法的可解释性是指医生和患者能够理解AI系统推荐的治疗方案背后的逻辑和依据。可解释性可以通过算法的可视化、内部参数的解释以及决策过程的描述等方式实现。一个高度可解释的医疗AI系统能够提供清晰的决策支持,确保治疗方案的合理性和有效性。

### 2.2.2 提高医疗AI透明度的实际意义

提高医疗AI透明度的实际意义在于确保系统的可靠性和可预测性。在实际操作中,当医疗AI系统能够清晰展示决策逻辑,医生和患者能够更容易接受并遵循AI的建议。这不仅增加了医疗干预的准确度,还降低了潜在的医疗风险。进一步地,透明度促进了医疗机构内部的交流与合作,有助于形成更加科学和系统的治疗策略。

## 2.3 透明度在医疗AI中的挑战与对策

### 2.3.1 当前挑战分析

尽管透明度的重要性不言而喻,但实现医疗人工智能的高透明度仍面临诸多挑战。首先是技术挑战,许多先进的机器学习算法,尤其是深度学习模型,往往是黑箱操作,难以直观理解其内部机制。其次是数据隐私和安全问题,医疗数据高度敏感,合理使用的同时保护患者隐私成为一大难题。此外,如何在医疗实践中兼顾透明度和效率也是一个重要议题。

### 2.3.2 应对策略与案例研究

为了应对上述挑战,医疗AI行业采取了多种策略。一种策略是开发新的算法,旨在提高可解释性,如引入注意力机制或采用图神经网络等。另外,实施数据保护措施如差分隐私技术,可以在保护数据隐私的同时利用数据。在实践中,一些机构通过建立算法审计小组,定期检查AI系统的决策过程和结果,以确保其透明度和可靠性。

```python

# 示例代码展示医疗AI中算法可解释性的一个小的方面:特征重要性评分

from sklearn.ensemble import RandomForestClassifier

import pandas as pd

import numpy as np

# 假设df是一个包含医疗特征和目标标签的Pandas DataFrame

# X为特征数据,y为目标标签

X = df.drop('target', axis=1)

y = df['target']

# 使用随机森林分类器作为示例

clf = RandomForestClassifier()

clf.fit(X, y)

# 获取特征重要性评分

importances = clf.feature_importances_

# 将重要性评分和特征名称映射到一个DataFrame中,便于分析和可视化

feature_importances = pd.DataFrame({'feature': X.columns, 'importance': importances})

# 根据重要性评分进行排序

feature_importances = feature_importances.sort_values('importance', ascending=False)

# 打印结果

print(feature_importances)

# 通过特征重要性分析,我们可以直观地看到哪些特征在AI决策中起到关键作用

```

在上述代码中,我们使用了随机森林分类器来评估医疗特征的重要性。这种分析有助于医生理解哪些因素在AI决策中起到了关键作用,增加了模型的可解释性。不过,需要注意的是,由于数据的隐私性,这个案例是高度抽象化的,并不涉及真实的医疗数据。

通过本章节的介绍,我们可以看到医疗人工智能算法透明度的重要性、可解释性的定义及重要性、以及面对透明度挑战时的对策和实际案例研究。这为下一章探讨如何在实践中提高医疗人工智能算法的可解释性奠定了理论基础。

# 3. 提高医疗人工智能算法可解释性的实践方法

在追求医疗人工智能算法的精准决策与高效处理能力的同时,算法的可解释性变得至关重要。由于医疗行业对决策过程的可追溯性和可理解性的要求较高,因此,提升医疗AI算法的可解释性能够帮助医生和患者更好地理解AI的决策逻辑,增强对其结果的信任。本章节将深入探讨实际提升医疗人工智能算法可解释性的方法,并对其实践进行详尽的分析。

## 3.1 模型解释性与可视化技术

### 3.1.1 可解释模型的类型

在提高算法透明度的过程中,可解释模型的选择至关重要。可解释模型大致可分为两类:基于规则的模型与模型内部特征的解释模型。

#### 基于规则的模型

基于规则的模型是一种模型的逻辑输出可直接转换为可理解的规则集合。例如,决策树模型,其决策过程可以通过一系列的条件判断来解释。由于决策树的结构清晰,易于理解,因此这类模型通常在需要高度可解释性的情况下被优先考虑。

#### 模型内部特征的解释模型

模型内部特征的解释模型主要通过解释模型内部参数的方式来提升透明度,比如线性回归模型,其中的权重系数可以直观地解释为各个特征对模型输出的贡献程度。此外,对于像深度学习这样的复杂模型,有研究者提出了一些方法来近似解释网络层内部的决策过程,如激活最大化和特征可视化等技术。

### 3.1.2 可视化工具与技术

可解释的算法在医疗AI中至关重要,可视化是提升可解释性的重要工具。下面介绍几种常见的可视化技术。

#### 可视化技术

可视化技术通过图形化手段,帮助医生和研究人员直观理解算法的决策逻辑和数据处理过程。典型的可视化工具有如下几种:

- **热图**:可以展示模型在数据上的注意力分布,帮助理解哪些区域对模型的预测结果影响最大。

- **特征重要性图**:通过图表显示不同特征对于预测结果的重要程度,便于理解模型的决策依据。

- **决策边界可视化**:在二维或三维空间中展示模型的决

0

0