近似算法在机器学习中的应用:从理论到实践,助你提升机器学习模型的性能

发布时间: 2024-08-25 01:34:34 阅读量: 46 订阅数: 30

# 1. 近似算法简介**

近似算法是一种计算问题的算法,它通过牺牲精确性来换取效率。与精确算法相比,近似算法在多项式时间内产生近似解,而精确算法通常需要指数时间。

近似算法的应用非常广泛,包括机器学习、运筹学和组合优化等领域。在机器学习中,近似算法可用于解决诸如支持向量机和决策树等复杂模型的训练问题。

# 2. 近似算法在机器学习中的应用

近似算法在机器学习中发挥着至关重要的作用,为解决复杂而高维的问题提供了高效且实用的解决方案。在本章节中,我们将深入探讨近似算法在监督学习和无监督学习中的应用,揭示其在机器学习实践中的价值。

### 2.1 监督学习中的近似算法

监督学习的目标是根据标记的数据学习模型,以便对新数据进行预测。近似算法在监督学习中广泛应用,主要用于解决大规模数据集和复杂模型带来的挑战。

#### 2.1.1 支持向量机(SVM)

SVM是一种二分类算法,其核心思想是找到一个超平面,将不同类别的样本点分隔开来。SVM使用核函数将低维数据映射到高维空间,从而实现非线性分类。

```python

from sklearn.svm import SVC

# 创建SVM模型

model = SVC(kernel='rbf')

# 训练模型

model.fit(X_train, y_train)

# 预测新数据

y_pred = model.predict(X_test)

```

**代码逻辑分析:**

* `SVC`类创建了一个支持向量机模型,其中`kernel`参数指定了核函数类型(在本例中为径向基核函数)。

* `fit`方法使用训练数据训练模型,确定超平面参数。

* `predict`方法使用训练好的模型对新数据进行预测,返回预测的类别标签。

#### 2.1.2 决策树

决策树是一种非参数分类和回归算法,其结构类似于一棵树,其中每个节点代表一个特征,每个分支代表特征的不同取值。决策树通过递归地将数据分割成更小的子集来构建。

```python

from sklearn.tree import DecisionTreeClassifier

# 创建决策树模型

model = DecisionTreeClassifier()

# 训练模型

model.fit(X_train, y_train)

# 预测新数据

y_pred = model.predict(X_test)

```

**代码逻辑分析:**

* `DecisionTreeClassifier`类创建了一个决策树模型。

* `fit`方法使用训练数据训练模型,构建决策树结构。

* `predict`方法使用训练好的模型对新数据进行预测,返回预测的类别标签。

### 2.2 无监督学习中的近似算法

无监督学习的目标是发现未标记数据的内在结构和模式。近似算法在无监督学习中用于处理大规模数据集和高维数据,从而提取有意义的信息。

#### 2.2.1 聚类算法

聚类算法将相似的数据点分组到不同的簇中。K-Means算法是一种流行的聚类算法,其目标是将数据点分配到K个簇中,使得簇内数据点之间的相似度最大化,而簇间数据点之间的相似度最小化。

```python

from sklearn.cluster import KMeans

# 创建K-Means模型

model = KMeans(n_clusters=3)

# 训练模型

model.fit(X_train)

# 获取聚类结果

labels = model.labels_

```

**代码逻辑分析:**

* `KMeans`类创建了一个K-Means模型,其中`n_clusters`参数指定了簇的数量。

* `fit`方法使用训练数据训练模型,确定簇的中心点。

* `labels_`属性返回每个数据点的簇标签。

#### 2.2.2 降维算法

降维算法将高维数据投影到低维空间,同时保留原始数据的重要特征。主成分分析(PCA)是一种广泛使用的降维算法,其目标是找到一组正交基向量,使得投影到这些基向量上的数据方差最大化。

```python

from sklearn.decomposition import PCA

# 创建PCA模型

model = PCA(n_components=2)

# 训练模型

model.fit(X_train)

# 降维

X_reduced = model.transform(X_train)

```

**代码逻辑分析:**

* `PCA`类创建了一个PCA模型,其中`n_components`参数指定了降维后的维度。

* `fit`方法使用训练数据训练模型,计算主成分。

* `transform`方法将数据投影到主成分上,得到降维后的数据。

# 3. 近似算法的理论基础

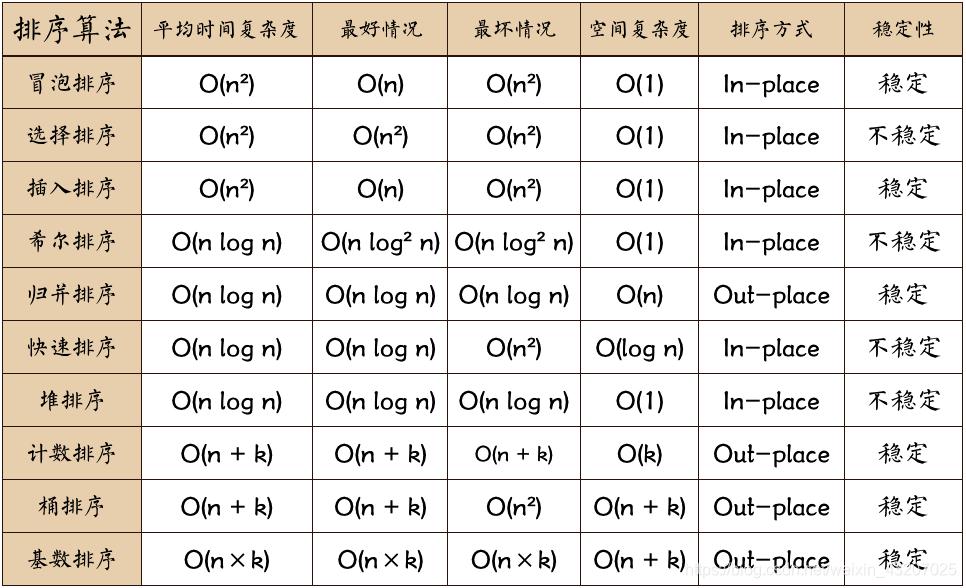

### 3.1 近似算法的复杂性分析

#### 3.1.1 时间复杂度

时间复杂度衡量算法执行所需的时间。近似算法的时间复杂度通常取决于输入大小 `n` 和近似误差 `ε`。对于给定的 `n` 和 `ε`,近似算法的时间复杂度可以表示为 `O(f(n, ε))`。

例如,支持向量机 (SVM) 是一种近似算法,其时间复杂度为 `O(n^3)`,其中 `n` 是训练数据的大小。这意味着随着训练数据大小的增加,SVM 的训练时间将呈立方级增长。

#### 3.1.2 空间复杂度

空间复杂度衡量算法执行所需的内存量。近似算法的空间复杂度通常取决于输入大小 `n` 和近似误差 `ε`。对于给定的 `n` 和 `ε`,近似算法的空间复杂度可以表示为 `O(g(n, ε))`。

例如,决策树是一种近似算法,其空间复杂度为 `O(n log n)`,其中 `n` 是训练数据的大小。这意味着随着训练数据大小的增加,决策树所需的内存量将以对数级增长。

### 3.2 近似算法的性能评估

#### 3.2.1 误差度量

误差度量衡量近似算法的输出与实际最优解之间的差异。常见的误差度量包括:

- **平均绝对误差 (MAE)**:平均绝对误差是近似解与实际最优解之间的平均绝对差值。

- **均方误差 (MSE)**:均方误差是近似解与实际最优解之间的平均平方差值。

- **相对误差**:相对误差是近似解与实际最优解之差与实际最优解之比。

#### 3.2.2 鲁棒性

鲁棒性衡量近似算法对输入扰动的敏感性。鲁棒的近似算法在输入数据发生轻微扰动时仍然能够产生接近最优的解。

鲁棒性可以通过以下方法评估:

- **敏感性分析**:敏感性分析通过改变输入数据并观察近似解的变化来评估近似算法的鲁棒性。

- **交叉验证**:交叉验证将数据集划分为多个子集,并使用其中一个子集作为测试集,其余子集作为训练集。通过多次重复此过程,可以评估近似算法对不同训练数据的鲁棒性。

# 4. 近似算法的实践应用**

近似算法在机器学习中的应用不仅仅局限于理论研究,在实际应用中也发挥着至关重要的作用。本章将重点介绍近似算法在机器学习模型优化和处理大规模数据集方面的实践应用。

### 4.1 机器学习模型的优化

#### 4.1.1 超参数调优

机器学习模型的性能往往受到超参数的影响,而超参数调优是一个耗时的过程。近似算法可以通过对超参数空间进行采样或探索,快速找到接近最优的超参数组合。

**代码块:**

```python

import numpy as np

from sklearn.model_selection import RandomizedSearchCV

# 定义超参数空间

param_grid = {'C': np.logspace(-3, 3, 10), 'gamma': np.logspace(-3, 3, 10)}

# 使用随机搜索进行超参数调优

random_search = RandomizedSearchCV(estimator=SVC(), param_distributions=param_grid, n_iter=100)

random_search.fit(X_train, y_train)

# 获取最优超参数组合

best_params = random_search.best_params_

```

**逻辑分析:**

这段代码使用随机搜索算法对支持向量机(SVC)模型进行超参数调优。`param_grid`定义了超参数空间,`n_iter`指定了搜索迭代次数。随机搜索算法会随机采样超参数组合,并评估每个组合的性能。最终,它会返回具有最佳性能的超参数组合。

#### 4.1.2 特征选择

特征选择是识别和选择对机器学习模型性能至关重要的特征的过程。近似算法可以帮助解决高维数据集中的特征选择问题,通过快速筛选出具有高相关性或高信息增益的特征。

**代码块:**

```python

import pandas as pd

from sklearn.feature_selection import SelectKBest, chi2

# 加载数据集

df = pd.read_csv('data.csv')

# 使用卡方检验进行特征选择

selector = SelectKBest(chi2, k=10)

selector.fit(df.drop('target', axis=1), df['target'])

# 获取选择的特征

selected_features = df.drop('target', axis=1).columns[selector.get_support()]

```

**逻辑分析:**

这段代码使用卡方检验进行特征选择。`SelectKBest`类选择具有最高卡方统计量的`k`个特征。卡方检验衡量了特征与目标变量之间的相关性,因此选择具有最高卡方统计量的特征可以提高模型的性能。

### 4.2 大规模数据集的处理

#### 4.2.1 采样技术

对于大规模数据集,直接处理整个数据集可能不切实际。近似算法可以通过对数据集进行采样,在较小的样本集上训练模型,从而降低计算成本。

**表格:采样技术**

| 采样类型 | 描述 | 优点 | 缺点 |

|---|---|---|---|

| 随机采样 | 从数据集随机选择样本 | 简单高效 | 可能无法代表整个数据集 |

| 分层采样 | 根据特征对数据集进行分层,然后从每个层中随机选择样本 | 保证样本在不同层中具有代表性 | 可能需要对特征进行分组 |

| 系统采样 | 从数据集的开头随机选择一个样本,然后以固定的间隔选择后续样本 | 确保样本均匀分布 | 可能无法完全代表数据集 |

#### 4.2.2 分布式计算

对于超大规模数据集,单台机器可能无法处理。近似算法可以通过将计算任务分布到多台机器上,并行处理数据,从而解决这一问题。

**Mermaid流程图:分布式计算**

```mermaid

graph LR

subgraph 数据加载

A[加载数据] --> B[拆分数据]

end

subgraph 模型训练

C[训练模型1]

D[训练模型2]

E[训练模型3]

end

subgraph 结果汇总

F[汇总结果]

end

A --> B --> C

A --> B --> D

A --> B --> E

C --> F

D --> F

E --> F

```

**流程图分析:**

该流程图展示了分布式计算的流程。数据首先被加载并拆分成多个子集。然后,每个子集在不同的机器上并行训练一个模型。最后,训练结果被汇总以得到最终模型。

# 5. 近似算法的未来发展

### 5.1 新型近似算法的探索

**5.1.1 神经网络近似算法**

神经网络是一种强大的机器学习模型,具有强大的非线性逼近能力。近年来,神经网络近似算法的研究取得了显著进展。神经网络近似算法将神经网络与近似算法相结合,利用神经网络的非线性逼近能力来解决复杂问题。

```python

import tensorflow as tf

# 定义神经网络模型

model = tf.keras.Sequential([

tf.keras.layers.Dense(128, activation='relu'),

tf.keras.layers.Dense(128, activation='relu'),

tf.keras.layers.Dense(1)

])

# 定义损失函数

loss_fn = tf.keras.losses.MeanSquaredError()

# 定义优化器

optimizer = tf.keras.optimizers.Adam()

# 训练模型

model.compile(optimizer=optimizer, loss=loss_fn)

model.fit(X_train, y_train, epochs=10)

```

**5.1.2 量子近似算法**

量子计算是一种新兴技术,具有解决传统计算机难以解决的问题的潜力。量子近似算法利用量子计算的叠加和纠缠特性来加速近似算法的计算。

```mermaid

graph LR

subgraph 量子近似算法

A[量子态] --> B[近似解]

end

subgraph 传统近似算法

C[初始解] --> D[近似解]

end

```

0

0