PyTorch自动微分工具详解与应用

发布时间: 2024-05-01 16:07:48 阅读量: 87 订阅数: 54

深度学习-PyTorch-自动微分机制练习(完整代码)

# 1. PyTorch自动微分的基础**

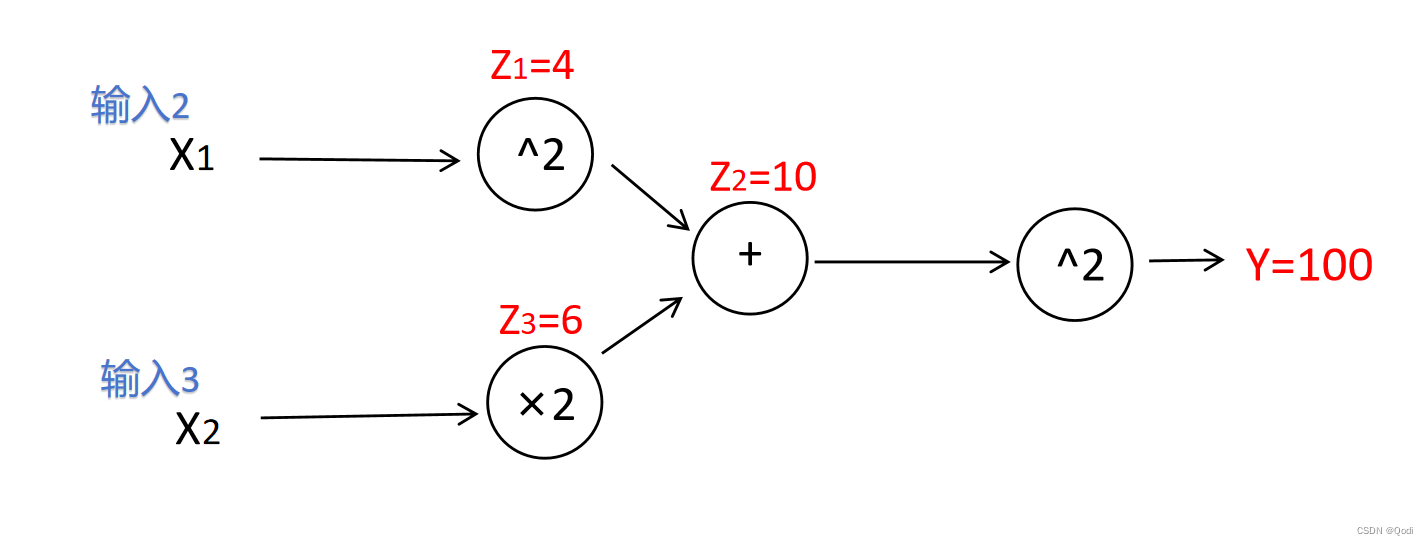

自动微分是PyTorch中一项强大的工具,它允许计算函数的梯度,而无需手动求导。这对于机器学习和深度学习至关重要,因为梯度用于优化模型的参数。

PyTorch使用反向传播算法进行自动微分。反向传播通过计算每个操作的梯度并将其传播到计算图中,从输出到输入,从而计算函数的梯度。

反向传播算法的效率取决于计算图的大小。较大的计算图需要更多的计算和内存,从而降低性能。为了优化性能,可以采用诸如检查点和梯度累积等技术来减少计算图的大小。

# 2. PyTorch自动微分的应用

PyTorch自动微分是一个强大的工具,它可以自动计算神经网络中梯度和雅可比矩阵,从而简化了机器学习模型的训练和优化。本章将介绍PyTorch自动微分在各种应用中的用法,包括梯度计算、反向传播、优化算法和超参数优化。

### 2.1 梯度计算和反向传播

梯度计算是机器学习中的一项基本任务,它用于确定模型参数相对于损失函数的变化率。PyTorch自动微分提供了计算梯度的有效方法,使用反向传播算法。

**反向传播算法**

反向传播算法是一种通过计算神经网络中每个节点的局部梯度来计算梯度的算法。算法从输出层开始,逐层向后传播,计算每个节点的梯度,并使用链式法则将梯度传递给前面的层。

**PyTorch中的反向传播**

在PyTorch中,反向传播可以通过`backward()`方法触发。该方法计算给定损失函数相对于模型参数的梯度。以下是使用PyTorch计算梯度的示例代码:

```python

import torch

# 定义损失函数

loss_fn = torch.nn.MSELoss()

# 定义模型

model = torch.nn.Linear(10, 1)

# 随机初始化模型参数

model.weight = torch.nn.Parameter(torch.randn(10, 1))

model.bias = torch.nn.Parameter(torch.randn(1))

# 前向传播

input = torch.randn(1, 10)

output = model(input)

# 计算损失

loss = loss_fn(output, torch.randn(1, 1))

# 反向传播

loss.backward()

# 获取梯度

grad_weight = model.weight.grad

grad_bias = model.bias.grad

```

**逻辑分析**

* `loss_fn`是均方误差损失函数,用于计算模型输出和目标值之间的误差。

* `model`是一个线性模型,它将输入数据转换为输出。

* `backward()`方法触发反向传播算法,计算损失函数相对于模型参数的梯度。

* `grad_weight`和`grad_bias`分别存储模型权重和偏置的梯度。

### 2.2 优化算法

优化算法用于更新模型参数以最小化损失函数。PyTorch提供了多种优化算法,包括随机梯度下降(SGD)、动量法和Adam。

**随机梯度下降(SGD)**

SGD是一种简单但有效的优化算法,它通过沿梯度方向更新参数来最小化损失函数。

**PyTorch中的SGD**

在PyTorch中,SGD可以通过`torch.optim.SGD`类实现。以下是使用SGD优化模型的示例代码:

```python

import torch

from torch.optim import SGD

# 定义损失函数

loss_fn = torch.nn.MSELoss()

# 定义模型

model = torch.nn.Linear(10, 1)

# 随机初始化模型参数

model.weight = torch.nn.Parameter(torch.randn(10, 1))

model.bias = torch.nn.Parameter(torch.randn(1))

# 定义优化器

optimizer = SGD(model.parameters(), lr=0.01)

# 训练模型

for epoch in range(100):

# 前向传播

input = torch.randn(1, 10)

output = model(input)

# 计算损失

loss = loss_fn(output, torch.randn(1, 1))

# 反向传播

loss.backward()

# 更新参数

optimizer.step()

# 清除梯度

optimizer.zero_grad()

```

**逻辑分析**

* `optimizer`是SGD优化器,它用于更新模型参数。

* `lr`是学习率,它控制参数更新的步长。

* 训练循环重复执行前向传播、反向传播和参数更新步骤。

* `zero_grad()`方法在每次迭代后将梯度清零,以防止梯度累积。

### 2.3 超参数优化

超参数优化是调整模型超参数(如学习率和正则化参数)的过程,以提高模型性能。PyTorch提供了超参数优化工具,如`torch.optim.lr_scheduler`。

**学习率调度器**

学习率调度器用于动态调整学习率,以提高模型训练的效率。PyTorch提供了多种学习率调度器,包括指数衰减和余弦退火。

**PyTorch中的学习率调度器**

在PyTorch中,学习率调度器可以通过`torch.optim.lr_scheduler`类实现。以下是使用余弦退火学习率调度器的示例代码:

```python

import torch

from torch.optim.lr_scheduler import CosineAnnealingLR

# 定义损失函数

loss_fn = torch.nn.MSELoss()

# 定义模型

```

0

0