PyTorch模型优化技巧与工具介绍

发布时间: 2024-05-01 16:00:09 阅读量: 70 订阅数: 54

高效PyTorch变压器:用于针对低资源环境实现量化PyTorch模型的工具

# 1. PyTorch模型优化概述**

PyTorch模型优化旨在通过各种技术来提高模型的性能和效率,使其在资源受限的环境中也能有效运行。模型优化对于以下场景至关重要:

* **部署到移动设备或嵌入式系统:**这些设备通常具有有限的计算能力和内存,需要优化模型以满足其限制。

* **云端推理:**优化模型可以减少推理时间和成本,尤其是在处理大量数据时。

* **提高训练效率:**优化模型可以减少训练时间,从而加快模型开发和迭代。

# 2. 模型压缩技巧

### 2.1 量化

量化是将高精度浮点权重和激活值转换为低精度表示的过程,从而减少模型的大小和计算成本。

#### 2.1.1 整数量化

整数量化将浮点值转换为整数,通常使用 8 位或 16 位表示。这可以显著减少模型的大小和计算成本,但可能会降低模型精度。

```python

import torch

import torch.nn.quantized as nnq

# 创建一个浮点模型

model = nn.Linear(10, 10)

# 将模型转换为整数量化模型

quantized_model = nnq.quantize_dynamic(model, {nn.Linear: nnq.QuantStub()})

# 使用量化模型进行推理

input = torch.randn(10, 10)

output = quantized_model(input)

```

#### 2.1.2 浮点数量化

浮点数量化将浮点值转换为低精度浮点表示,例如半精度 (FP16) 或八分之一精度 (FP8)。这比整数量化提供了更高的精度,但计算成本也更高。

```python

import torch

import torch.cuda.amp as amp

# 创建一个浮点模型

model = nn.Linear(10, 10)

# 将模型转换为浮点数量化模型

model = amp.autocast(model)

# 使用量化模型进行推理

input = torch.randn(10, 10)

with amp.autocast():

output = model(input)

```

### 2.2 剪枝

剪枝是移除模型中不重要的权重和激活值的过程,从而减少模型的大小和计算成本。

#### 2.2.1 权重剪枝

权重剪枝移除模型中接近零的权重,从而减少模型的大小。

```python

import torch

import torch.nn.utils.prune as prune

# 创建一个模型

model = nn.Linear(10, 10)

# 移除接近零的权重

prune.l1_unstructured(model, name="weight", amount=0.1)

# 使用剪枝模型进行推理

input = torch.randn(10, 10)

output = model(input)

```

#### 2.2.2 通道剪枝

通道剪枝移除模型中不重要的通道,从而减少模型的大小。

```python

import torch

import torch.nn.utils.prune as prune

# 创建一个卷积模型

model = nn.Conv2d(10, 10, 3)

# 移除不重要的通道

prune.channel_unstructured(model, name="weight", amount=0.1)

# 使用剪枝模型进行推理

input = torch.randn(10, 10, 3, 3)

output = model(input)

```

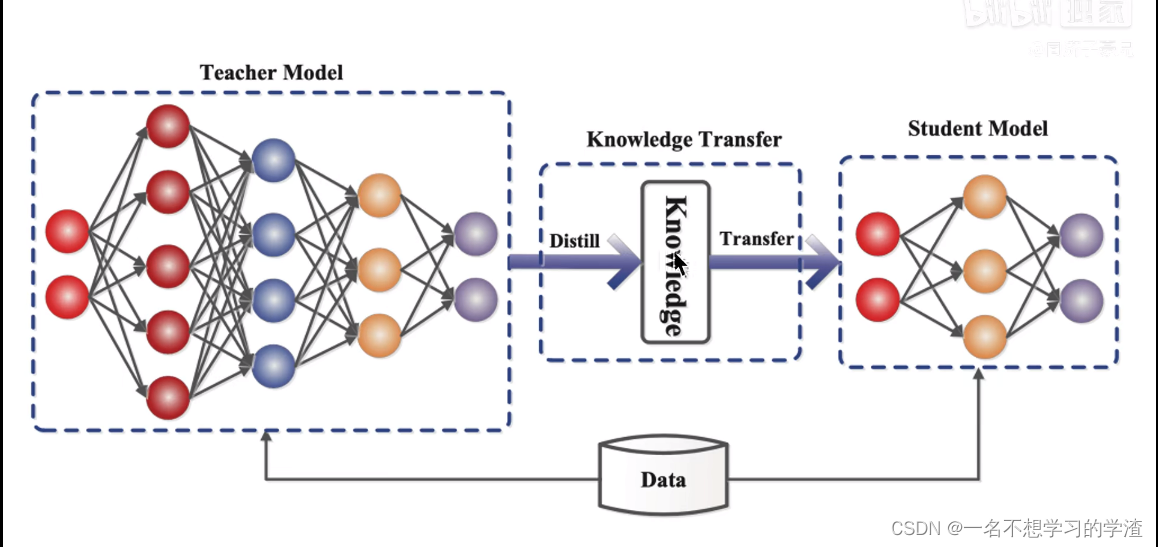

### 2.3 蒸馏

蒸馏是将一个大型模型 (教师模型) 的知识转移到一个较小模型 (学生模型) 的过程,从而减少学生模型的大小和计算成本。

#### 2.3.1 知识蒸馏

知识蒸馏通过最小化教师模型和学生模型的输出之间的差异来转移知识。

```python

import torch

import torch.nn as nn

# 创建一个教师模型

teacher_model = nn.Linear(10, 10)

# 创建一个学生模型

student_model = nn.Linear(10, 10)

# 定义知识蒸馏损失函数

loss_fn = nn.MSELoss()

# 训练学生模型

optimizer = torch.optim.Adam(student_model.parameters())

for epoch in range(10):

# 前向传播

teacher_output = teacher_model(input)

student_output = student_model(input)

# 计算知识蒸馏损失

loss = loss_fn(student_output, teacher_output)

# 反向传播

optimizer.zero_grad()

loss.backward()

# 更新学生模型

optimizer.step()

```

#### 2.3.2 特征蒸馏

特征蒸馏通过最小化教师模型和学生模型中间层的特征之间的差异来转移知识。

```python

import torch

import torch.nn as nn

# 创建一个教师模型

teacher_model = nn.Sequential(

nn.Linear(10, 10),

nn.ReLU(),

nn.Linear(10, 10)

)

# 创建一个学生模型

student_model = nn.Sequential(

nn.Linear(10, 10),

nn.ReLU(),

nn.Linear(10, 10)

)

# 定义特征蒸馏损失函数

loss_fn = nn.MSELoss()

# 训练学生模型

optimizer = torch.optim.Adam(student_model.parameters())

for epoch in range(10):

# 前向传播

teacher_features = teacher_model(input)

student_features = student_model(input)

# 计算特征蒸馏损失

loss = loss_fn(student_features, teacher_features)

# 反向传播

optimizer.zero_grad()

loss.backward()

# 更新学生模型

optimizer.step()

```

# 3. 模型加速技巧

### 3.1 并行化

并行化是一种将计算任务分解为多个较小任务并在多个处理单元上同时执行的技术,从而提高模型训练和推理的效率。PyTorch支持两种主要类型的并行化:数据并行和模型并行。

#### 3.1.1 数据并行

数据并行是一种将数据样本分配到多个GPU或CPU上进行处理的并行化技术。每个处理单元处理不同批次的数据,并将其梯度返回给主进程进行模型更新。数据并行适用于具有大量训练数据的模型,因为可以有效地利用多个处理单元来加速训练过程。

**代码示例:**

```python

import torch

import torch.nn as nn

import torch.nn.parallel

# 创建一个数据并行模型

model = nn.DataParallel(model)

# 将数据分配到多个GPU

device_ids = [0, 1, 2, 3]

model = model.to(device_ids)

# 训练模型

optimizer = torch.optim.SGD(model.parameters(), lr=0.01)

for epoch in range(10):

for batch in train_data:

# 将数据分配到GPU

inputs, labels = batch[0].to(device_ids), batch[1].to(device_ids)

# 前向传播

outputs = model(inputs)

# 计算损失

loss = nn.CrossEntropyLoss()(outputs, labels)

# 反向传播

loss.backward()

# 更新模型参数

optimizer.step()

```

**逻辑分析:**

* `nn.DataParallel`包装器将模型复制到指定设备列表中。

* 数据在设备之间分配,每个设备处理一个批次的数据。

* 梯度在设备之间同步,用于更新主模型参数。

#### 3.1.2 模型并行

模型并行是一种将模型分解为多个较小部分并在不同的处理单元上执行的并行化技术。每个处理单元负责模型的不同部分,并与其他处理单元通信以交换信息。模型并行适用于具有大量参数或复杂架构的模型,因为可以有效地利用多个处理单元来加速训练过程。

**代码示例:**

```python

import torch

import torch.distributed as dist

import torch.nn as nn

# 初始化分布式环境

dist.init_process_group(backend='nccl')

# 创建一个模型并行模型

model = nn.parallel.DistributedDataParallel(model)

# 训练模型

optimizer = torch.optim.SGD(model.parameters(), lr=0.01)

for epoch in range(10):

for batch in train_data:

# 将数据分配到GPU

inputs, labels = batch[0].to(device), b

```

0

0