PyTorch模型评估与指标选择原则

发布时间: 2024-05-01 16:06:07 阅读量: 89 订阅数: 51

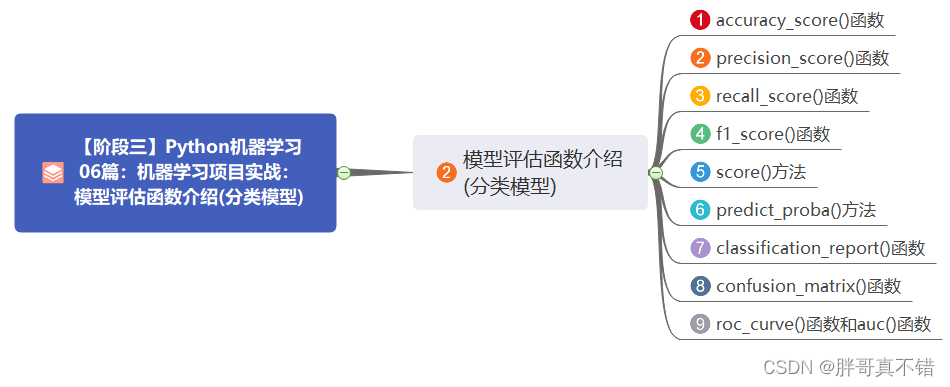

# 2.1 分类模型评估指标

### 2.1.1 准确率

准确率(Accuracy)是分类模型最常用的评估指标,它衡量模型正确预测样本数量与总样本数量的比例。对于二分类问题,准确率的计算公式为:

```python

accuracy = (TP + TN) / (TP + TN + FP + FN)

```

其中:

- TP:真阳性(预测为正且实际为正)

- TN:真阴性(预测为负且实际为负)

- FP:假阳性(预测为正但实际为负)

- FN:假阴性(预测为负但实际为正)

准确率直观易懂,但当数据集不平衡(即正负样本数量相差较大)时,准确率可能具有误导性。例如,如果数据集中有 99% 的负样本,即使模型总是预测所有样本为负,也可以获得 99% 的准确率。

# 2. 模型评估指标选择原则

### 2.1 分类模型评估指标

对于分类模型,评估指标的选择取决于具体任务和数据集的特性。常用的分类模型评估指标包括准确率、精确率、召回率和 F1 得分。

#### 2.1.1 准确率

准确率是模型预测正确的样本数占总样本数的比例。它衡量了模型对整体数据集的分类能力。然而,当数据集不平衡时,准确率可能会受到影响,因为模型可能倾向于预测占多数的类别。

#### 2.1.2 精确率和召回率

精确率是模型预测为正例的样本中真正正例的比例。它衡量了模型预测正例的准确性。召回率是模型预测为正例的真正正例占所有正例的比例。它衡量了模型识别所有正例的能力。

#### 2.1.3 F1 得分

F1 得分是精确率和召回率的加权调和平均值。它考虑了精确率和召回率的平衡,适用于数据集不平衡的情况。

### 2.2 回归模型评估指标

对于回归模型,评估指标的选择取决于预测任务的性质。常用的回归模型评估指标包括均方根误差、平均绝对误差和 R2 得分。

#### 2.2.1 均方根误差

均方根误差 (MSE) 是预测值与真实值之间的平方差的平均值。它衡量了模型预测误差的幅度。MSE 值越小,模型的预测越准确。

#### 2.2.2 平均绝对误差

平均绝对误差 (MAE) 是预测值与真实值之间的绝对差的平均值。它衡量了模型预测误差的平均大小。与 MSE 相比,MAE 对异常值不那么敏感。

#### 2.2.3 R2 得分

R2 得分是模型预测值与真实值之间协方差与真实值方差之比。它衡量了模型预测值与真实值之间的相关性。R2 得分的值在 0 到 1 之间,其中 1 表示完美拟合,0 表示无相关性。

### 评估指标选择原则

在选择模型评估指标时,需要考虑以下原则:

* **任务类型:**不同的任务类型需要不同的评估指标。例如,分类任务使用准确率、精确率和召回率,而回归任务使用 MSE、MAE 和 R2 得分。

* **数据集特性:**数据集的平衡性、大小和噪声水平会影响评估指标的选择。例如,不平衡的数据集可能需要使用 F1 得分而不是准确率。

* **模型复杂度:**模型的复杂度会影响评估指标的解释。例如,对于复杂模型,R2 得分可能比 MSE 更能反映模型的预测能力。

* **业务目标:**评估指标的选择应与业务目标保持一致。例如,对于医疗诊断模型,召回率可能比精确率更重要。

# 3.1 训练集和验证集划分

在机器学习中,数据集通常被划分为训练集和验证集。训练集用于训练模型,而验证集用于评估模型的性能。训练集和验证集的划分对于模型评估至关重要,因为它可以帮助我们避免过拟合并选择最佳的模型超参数。

**训练集**包含用于训练模型的数据。训练集的大小和质量对模型的性能有很大影响。训练集越大,模型就越能学习数据的模式和规律。然而,训练集过大也会导致过拟合,即模型在训练集上表现良好,但在新数据上表现不佳。

**验证集**包含用于评估模型性能的数据。验证集通常比训练集小,因为它不需要用于训练模型。验证集的主要目的是评估模型在训练过程中的泛化能力,并帮助我们选择最佳的模型超参数。

训练集和验证集的划分比例通常为 80/20 或 70/30。这意味着 80% 或 70% 的数据用于训练,而 20% 或 30% 的数据用于验证。

**代码示例:**

```python

import torch

from sklearn.model_selection import train_test_split

# 加载数据集

dataset = torch.load('dataset.pt')

# 划分训练集和验证集

train_set, val_set = train_test_split(dataset, test_size=0.2, random_state=42)

```

**逻辑分析:**

这段代码使用 `sklearn.model_selection.train_test_split` 函数将数据集划分为训练集和验证集。`test_size` 参数指定验证集的大小,在本例中为 20%。`random_state` 参数指定随机种子,以确保每次运行代码时训练集和验证集的划分都是相同的。

### 3.2 模型评估流程

模型评估流程通常包括以下步骤:

1. **定义评估指标:**选择合适的评估指标来衡量模型的性能。

2. **计算评估指标:**使用评估指标计算模型在验证集上的得分。

3. **分析评估结果:**分析评估结果,确定模型的优缺点。

4. **优化模型:**根据评估结果,优化模型的超参数或结构,以提高模型的性能。

**代码示例:**

```python

import torch

from sklearn.metrics import accuracy_score

# 加载模型

model = torch.load('model.pt')

# 加载验证集

val_set = torch.load('val_set.pt')

# 计算准确率

accuracy = accuracy_score(val_set.labels, model.predict(val_set.features))

# 打印准确率

print('准确率:', accuracy)

```

**逻辑分析:**

这段代码使用 `sklearn.metrics.accuracy_score` 函数计算模型在验证集上的准确率。`accuracy_score` 函数将模型的预测结果与验证集的真实标签进行比较,并返回准确率。

### 3.3 模型评估结果分析

0

0