提升透明度:特征选择与模型解释性

发布时间: 2024-09-07 18:58:22 阅读量: 148 订阅数: 40

# 1. 特征选择与模型透明度概述

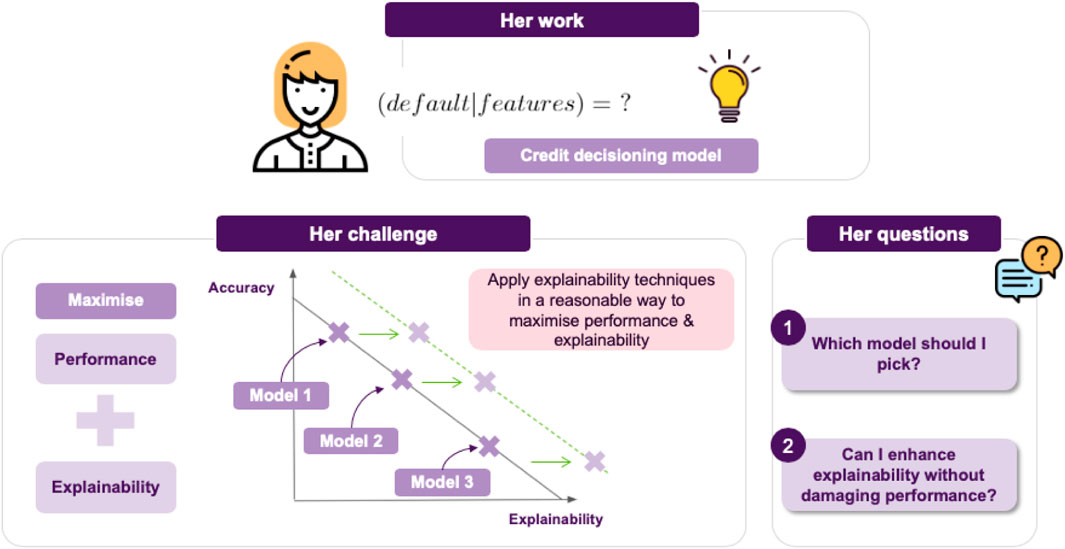

在当今数据驱动的世界里,特征选择与模型透明度的重要性不言而喻。特征选择,作为机器学习和数据分析的重要预处理步骤,关乎模型的效率与性能,以及最终输出结果的可靠性与准确性。通过有效的特征选择,我们可以减少模型的复杂性,提高运行效率,同时也有助于降低过拟合的风险,提升模型在未知数据上的泛化能力。

模型透明度,尤其是对于决策支持系统和重要领域的应用来说,是一个不可或缺的考量因素。透明的模型不仅可以为用户提供清晰的决策逻辑,还能够增强用户对模型的信任。透明度的提高,通常意味着模型的可解释性增强,这对于遵守法律、道德规范以及满足业务需求至关重要。

此外,特征选择与模型透明度之间的关系密不可分。良好的特征选择能够简化模型,使其更易于解释和理解,进而提高整体的模型透明度。而在实际应用中,这种关系可以表现为在构建可解释模型的过程中,对特征进行有选择性地保留或排除,以达到优化解释性的目的。在接下来的章节中,我们将详细探讨特征选择的理论基础、模型解释性的理论框架,以及如何将这些概念应用到实践中去。

# 2. 特征选择的理论基础

## 2.1 特征选择的重要性

### 2.1.1 理解数据维度与模型复杂性

在机器学习中,数据维度与模型复杂性密切相关。数据维度指的是数据集中特征的数量,而模型复杂性则取决于模型对这些特征的利用程度。增加维度可能会导致模型变得过于复杂,这不仅增加了模型训练的时间和计算成本,还有可能引起过拟合现象,即模型在训练数据上表现出色,但在新的、未见过的数据上表现不佳。

高维数据通常包含噪声和不相关的特征,这些特征对模型的预测能力贡献不大,甚至可能导致模型对数据中的偶然变化过于敏感。通过特征选择减少特征的数量,可以简化模型,减少计算量,提高模型的泛化能力。理解数据维度与模型复杂性之间的关系是进行特征选择的第一步。

### 2.1.2 特征选择对模型性能的影响

特征选择对模型性能的影响主要体现在三个方面:准确度、效率和可解释性。

- **准确度**:去除不相关和冗余特征有助于提高模型的预测准确度,因为这些特征可能会引入噪声,误导模型学习到错误的模式。

- **效率**:特征选择减少了模型训练所需处理的数据量,从而提升了训练效率,使得模型训练可以更快完成,特别是在有限的计算资源下更为重要。

- **可解释性**:减少特征数量通常能增加模型的可解释性。简单的模型往往更容易被人们理解,当模型结果需要向非技术利益相关者解释时,这一点尤为重要。

## 2.2 特征选择方法论

### 2.2.1 过滤法(Filter Methods)

过滤法是一种基于数据本身特性的特征选择方法,不涉及模型训练。它们通常包括对每个特征独立地应用统计测试,然后根据这些测试的结果选择特征。

例如,可以使用卡方检验来选择与目标变量有显著统计关联的特征,或者使用相关系数来选择与目标变量相关性最高的特征。过滤法的优点是简单快速,计算成本低。但它的缺点是不考虑特征间的相关性,可能会忽略重要的特征交互。

```python

from sklearn.feature_selection import SelectKBest, chi2

# 假设 X_train 是训练数据集,y_train 是目标变量

selector = SelectKBest(chi2, k=10) # k 指定要选择的特征数量

X_train_new = selector.fit_transform(X_train, y_train)

selected_feature_indices = selector.get_support(indices=True)

print(f"Selected Feature Indices: {selected_feature_indices}")

```

在上述代码示例中,我们使用卡方检验选择了与目标变量有较强关联的10个特征。`selected_feature_indices`数组包含了这些特征的索引。

### 2.2.2 包裹法(Wrapper Methods)

包裹法涉及到使用学习算法的性能来评估特征子集。常见的包裹法包括递归特征消除(RFE)和顺序特征选择(SFS)。在RFE中,算法从初始特征集开始,递归地移除最不重要的特征,直到达到所需的特征数量。而SFS则是递归地添加或删除特征,直到找到最佳的特征组合。

包裹法的主要优点是能够考虑到特征之间的相互作用,因此经常能产生更好的模型性能。但是,由于它涉及到模型的反复训练和评估,计算成本相对较高。

```python

from sklearn.feature_selection import RFE

from sklearn.ensemble import RandomForestClassifier

# 假设 X_train 是训练数据集,y_train 是目标变量

estimator = RandomForestClassifier()

selector = RFE(estimator, n_features_to_select=10, step=1)

selector = selector.fit(X_train, y_train)

selected_features = X_train.columns[selector.support_]

print(f"Selected Features: {selected_features}")

```

上述代码使用随机森林分类器作为特征选择的评估器,并设置了需要选择的特征数量为10个。`selected_features`变量包含了最终被选择的特征列。

### 2.2.3 嵌入法(Embedded Methods)

嵌入法是将特征选择直接集成到模型训练过程中,因此它结合了过滤法和包裹法的特点。常见的嵌入法有Lasso回归、岭回归(Ridge Regression)等,它们通过在损失函数中引入正则化项来实现特征选择。

例如,Lasso回归通过L1正则化自动将一些系数压缩为零,这相当于自动选择特征。而岭回归虽然不会去除特征,但可以减小一些特征的系数,从而降低它们的影响。

```python

from sklearn.linear_model import LassoCV

# 假设 X_train 是训练数据集,y_train 是目标变量

lasso = LassoCV(cv=5, random_state=0)

lasso.fit(X_train, y_train)

print(f"Non-zero coefficients: {lasso.coef_[lasso.coef_ != 0]}")

```

在这个例子中,LassoCV使用交叉验证来找到最佳的正则化参数。输出的`non-zero coefficients`表示了被选择的特征。

## 2.3 特征选择技术对比分析

### 2.3.1 各类方法的优缺点

特征选择方法各有优缺点,以下是每种方法的简要对比:

| 特征选择方法 | 优点 | 缺点 |

|--------------|------|------|

| 过滤法 | - 计算快速 <br> - 不依赖于模型 | - 不能发现特征间的关系 <br> - 可能会忽略重要的交互效应 |

| 包裹法 | - 考虑特征间的关系 | - 计算成本高 <br> - 可能过度拟合数据 |

| 嵌入法 | - 结合模型训练,效果通常较好 <br> - 无需额外的模型训练过程 | - 可解释性相对较差(除了Lasso) |

### 2.3.2 实际应用场景对比

在实际应用中选择特征选择方法时,需要考虑以下几个因素:

- **数据集大小和维度**:对于大规模数据集,过滤法可能是更合理的选择,因为它计算成本较低。对于小规模数据集,包裹法和嵌入法可能提供更好的模型性能。

- **模型复杂度**:如果对模型解释性要求不高,可以选择嵌入法中的Lasso回归。如果模型解释性很重要,过滤法可能是更合适的选择。

- **计算资源**:如果计算资源有限,过滤法通常是最节省成本的选择。如果资源足够,可以考虑使用包裹法或嵌入法。

- **问题的性质**:如果数据中的特征相关性很强,可

0

0