时间序列分析的特征选择策略:精确定位

发布时间: 2024-09-07 19:09:20 阅读量: 107 订阅数: 34

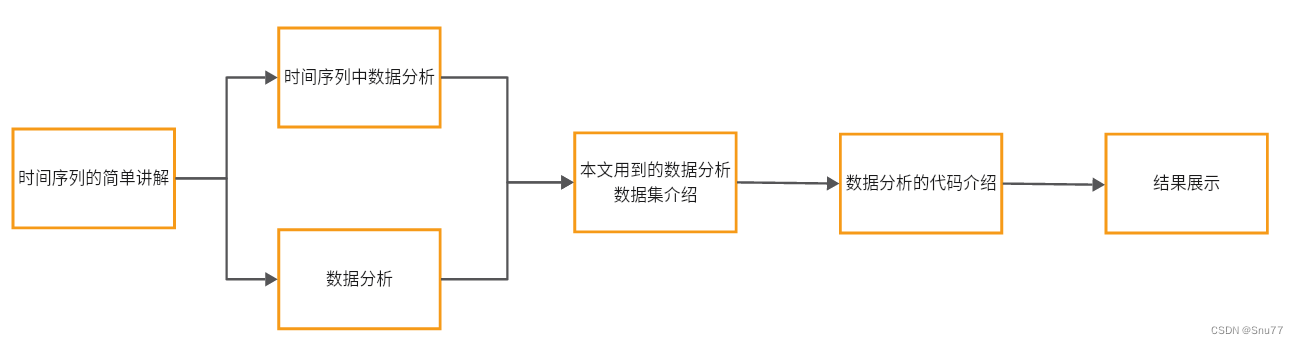

# 1. 时间序列分析简介

时间序列分析是统计学中分析一系列数据点按时间顺序排列的强有力工具。在众多应用领域,比如金融分析、气象预测、库存管理等,时间序列分析都发挥着至关重要的作用。它不仅帮助我们理解数据随时间变化的趋势、周期性和季节性,还能通过预测未来值来做出更为明智的决策。本章将从基础概念入手,逐步深入到时间序列分析的核心思想与方法,为读者提供一个坚实的理论基础和实践指南。

接下来,我们将继续探讨时间序列分析中的特征选择问题,这是提高预测模型精确度和解释性的重要步骤。

# 2. 特征选择的理论基础

## 2.1 特征选择的重要性

### 2.1.1 特征选择在时间序列中的作用

在时间序列分析中,特征选择扮演着至关重要的角色。它不仅有助于提高模型的预测性能,还可以增强模型的可解释性。时间序列数据往往包含噪声和冗余信息,通过有效的特征选择,我们可以滤除这些干扰,保留对预测目标有实际意义的特征。比如,在股票市场分析中,除了价格本身,我们可能会关注交易量、市场情绪指数等其他变量。这些变量中有的可能对预测未来股价走势非常重要,而有的可能只是噪声。特征选择的作用在于帮助我们识别和保留那些真正有预测价值的变量,从而提升模型的整体性能。

### 2.1.2 特征选择对模型性能的影响

特征选择直接影响模型的性能,包括模型的准确度、训练时间和预测速度等多个方面。通过减少特征数量,可以降低模型复杂度,减少过拟合的风险,同时缩短训练时间。此外,在进行特征选择时,也可能引入新的特征关系和模式,从而提高模型的泛化能力。在高维数据中,特征选择尤为重要,因为它有助于减轻所谓的“维度的诅咒”,在有限的数据量下提高模型的效能。

## 2.2 特征选择的方法论

### 2.2.1 过滤方法

过滤方法通过评估特征与目标变量之间的统计相关性来进行特征选择。常见的统计测试有卡方检验、ANOVA F-test、互信息等。这些方法通常独立于模型,计算成本较低。过滤方法可以快速地剔除不相关的特征,但是可能会忽略掉特征之间的相互关系。

```python

from sklearn.feature_selection import SelectKBest, chi2

# 假设X是特征数据集,y是目标变量

X_new = SelectKBest(chi2, k=5).fit_transform(X, y)

```

在上面的代码示例中,我们使用了`SelectKBest`类和卡方检验来选择最重要的5个特征。`chi2`参数是卡方检验函数,`k`参数指定了选择特征的数量。

### 2.2.2 包裹方法

包裹方法考虑特征子集与模型之间的相互作用,基于模型性能来选择特征。常见的方法有递归特征消除(RFE),它通过递归地构建模型并选择最重要的特征来工作。这种方法可以提供与模型高度相关的特征子集,但计算成本相对较高。

```python

from sklearn.feature_selection import RFE

from sklearn.ensemble import RandomForestClassifier

# 假设X是特征数据集,y是目标变量

estimator = RandomForestClassifier(n_estimators=10)

selector = RFE(estimator, n_features_to_select=5, step=1)

X_new = selector.fit_transform(X, y)

```

在上述代码中,我们使用了`RFE`类和`RandomForestClassifier`来选择最重要的5个特征。`n_features_to_select`参数指定了最终选择的特征数量,`step`参数表示每一步中特征的数量减少量。

### 2.2.3 嵌入方法

嵌入方法结合了过滤方法和包裹方法的特点,它在模型训练过程中进行特征选择。例如,基于惩罚项的模型(如LASSO和岭回归)可以在优化目标函数时将一些系数缩减至零,从而实现特征选择。这种方法考虑了特征与模型之间的关系,同时保持较低的计算成本。

```python

from sklearn.linear_model import Lasso

# 假设X是特征数据集,y是目标变量

lasso = Lasso(alpha=0.1)

lasso.fit(X, y)

# 输出被选中的特征

selected_features = [X.columns[i] for i in range(len(X.columns)) if lasso.coef_[i] != 0]

```

在代码示例中,我们使用了`Lasso`来执行特征选择。`alpha`参数控制着正则化强度,影响着特征的稀疏性。`coef_`属性帮助我们识别哪些特征的系数不为零,这些特征即被选择。

## 2.3 特征选择的评价指标

### 2.3.1 信息量指标

信息量指标主要通过评估特征包含的信息量来进行特征选择。常用的信息量指标包括熵、互信息(MI)等。熵是衡量数据不确定性的一个度量,而互信息可以用来衡量特征和目标之间的相关性。

```python

from sklearn.feature_selection import mutual_info_classif

# 假设X是特征数据集,y是目标变量

mi_scores = mutual_info_classif(X, y)

# 选择信息量大的特征

high_info_features = [X.columns[i] for i in range(len(X.columns)) if mi_scores[i] > threshold]

```

在上述代码示例中,我们使用了`mutual_info_classif`函数计算了特征和目标之间的互信息。`threshold`是一个阈值参数,我们可以通过它来设定一个互信息的最低标准。

### 2.3.2 统计测试指标

统计测试指标依据统计假设检验来评估特征与目标变量之间的关联度。常见的统计测试包括t-test、ANOVA F-test等。这些测试可以用来识别那些对目标变量有统计显著性的特征。

```python

from scipy.stats import f_oneway

# 假设有一个特征和目标变量

group1 = X[:, 0]

group2 = X[:, 1]

# 使用ANOVA F-test测试两个特征和目标之间的关系

f_statistic, p_value = f_oneway(group1, group2)

```

在上述代码中,我们使用了`f_oneway`函数来进行ANOVA F-test测试。测试结果中的`p_value`参数用于判断特征是否与目标变量有显著关系。

### 2.3.3 相关性分析指标

相关性分析指标通过计算特征之间的线性或非线性关系来评估特征的重要性。相关系数(如皮尔逊、斯皮尔曼)可以用来衡量特征间的线性相关性,而距离度量(如欧氏距离)可以用来衡量特征的非线性相关性。

```python

from scipy.stats import pearsonr

# 假设feature1和feature2是两个特征,target是目标变量

correlation, _ = pearsonr(feature1, feature2)

# 根据相关系数的大小选择特征

if abs(correlation) > correlation_threshold:

selected_features.append(feature1.name)

else:

selected_features.append(feature2.name)

```

在上面的代码示例中,我们使用了`pearsonr`函数来计算两个特征之间的皮尔逊相关系数。`correlation_threshold`是一个预先设定的相关系数阈值,用于决定是否将特征选入模型。

| 方法 | 优点 | 缺点 |

| ------------ | ---------------------------------------------- | ------------------------------------------------------------ |

| 过滤方法 | 计算成本低,能够快速筛选出特征 | 可能忽略特征之间的相互作

0

0